Giochi, teoria dei

Giochi, teoria dei

Ogni essere vivente, quando deve prendere delle decisioni, lo fa sempre in modo interattivo: il risultato delle sue scelte, e quindi la sua soddisfazione, dipendono anche dal comportamento di altri. È esattamente quanto succede nella gran parte dei giochi, nei quali le scelte di un giocatore non possono non tenere conto di quelle degli altri. Sebbene il problema sia stato spesso affrontato nella storia del pensiero, l'approccio matematico è stato impiegato relativamente tardi. La teoria dei giochi, che è la parte della matematica che si occupa di analizzare il comportamento di più individui che interagiscono fra loro ‒ e che per questo più propriamente oggi viene chiamata teoria delle decisioni interattive ‒ è disciplina davvero recente: il suo primo risultato risale al 1913 e la cosiddetta teoria classica è giunta a maturazione solo nei primi anni Settanta. Il primo congresso internazionale si tenne a Gerusalemme nel 1965, con la partecipazione di 16 persone; oggi un tale convegno sarebbe impensabile viste le moltissime ramificazioni che tale disciplina ha prodotto. è quindi praticamente impossibile descrivere con accuratezza tutti gli aspetti sviluppati dalla teoria: possiamo tuttavia, senza pretese di completezza, dare un'idea del suo sviluppo e delle sue idee guida.

Un gioco può essere, anzitutto, descritto a parole: ogni gioco ha le sue regole. Quindi devono essere specificati uno stato iniziale, le regole di evoluzione, i possibili esiti finali e le preferenze che i giocatori hanno su tali esiti.

Matematicamente, ciò si traduce nella descrizione del gioco in forma estesa, attraverso il cosiddetto albero del gioco.

Per un'analisi sistematica delle possibili evoluzioni di una partita, è poi necessario specificare cosa ogni giocatore fa ogni qual volta potrebbe essere chiamato a prendere una decisione (a fare una mossa). Per esempio, se due individui devono votare in sequenza e a voto palese a favore o contro un certo provvedimento di legge, il primo a fare la sua dichiarazione dovrà limitarsi a decidere come votare, mentre il secondo dovrà analizzare a priori che cosa fare in funzione del voto dell'altro.

Specificare ciò significa stabilire una strategia possibile per quel giocatore. Una lista di strategie (una per ogni giocatore) determina necessariamente un esito finale. In realtà, alcune informazioni possono essere ridondanti, ovvero strategie diverse per un giocatore possono portare agli stessi esiti, qualunque siano le strategie utilizzate dagli altri.

D'altra parte, la lista delle possibili strategie dei giocatori e le loro preferenze sugli esiti finali, permettono una seconda descrizione possibile: quella in forma strategica (o normale). Queste due rappresentazioni non sono equivalenti, in quanto la forma strategica riassume i dati della forma estesa: si perde in ricchezza di descrizione, ma si può guadagnare nella sintesi del problema.

Una prima distinzione possibile è tra giochi a somma zero (o strettamente competitivi) e a somma non nulla. Nei primi, i giocatori hanno interessi sempre contrapposti: ipotizzando un gioco a due giocatori, A e B, se un esito x è preferibile per A rispetto a un altro esito y, allora B ha necessariamente la preferenza opposta. Nei secondi invece, vi sono situazioni, rispetto ad altre, in cui i giocatori possono stare entrambi meglio. Il caso a somma zero, pur essendo una situazione non comune nelle applicazioni, serve in genere come battistrada per la comprensione del caso generale.

Un'ulteriore distinzione è fra giochi non cooperativi e cooperativi: la differenza sostanziale non sta in un atteggiamento psicologico dei giocatori o in un'ipotesi aprioristica della teoria, ma nelle condizioni esogene in cui il gioco viene giocato. Nei giochi cooperativi si possano fare accordi, che si assume a priori essere vincolanti: da dove nascano questi vincoli alla teoria non interessa.

Un'ulteriore classificazione distingue tra giochi a informazione completa e a informazione incompleta (o asimmetrica): nei secondi, vi sono alcune informazioni non note a tutti i giocatori ‒ tipicamente si assume che i giocatori non conoscano esattamente le preferenze degli altri.

Importantissima categoria è infine quella dei giochi ripetuti: sebbene la loro analisi non sia necessariamente fatta con strumenti molto diversi da quelli utilizzati per i giochi giocati una volta sola, il modello cambia in modo radicale e di conseguenza possono cambiare completamente i comportamenti razionali delle persone, a seconda che un gioco sia giocato una volta sola, oppure ripetuto.

Ipotesi di base della teoria

La teoria dei giochi intende analizzare il comportamento di decisori razionali (che interagiscono) ed egoisti. Non è troppo difficile definire, almeno a parole, che cosa significhi essere egoisti: l'interesse del giocatore sta nell'ottenere il massimo per sé. Egli tiene ovviamente in considerazione le preferenze degli altri, ma solo per eventualmente prevederne il comportamento, a suo vantaggio. Non gli interessa se il risultato finale sarà deludente per gli altri, purché sia soddisfacente per sé stesso.

Molto più difficile invece è dare un significato al termine razionalità. Anzi, tutta la teoria potrebbe essere letta come un tentativo di rispondere al quesito di cosa significhi tenere un comportamento razionale. In alcuni casi, la definizione di razionalità appare trasparente. Prendiamo per esempio il gioco del tris, in cui i due giocatori, a turno, mettono un loro simbolo su una scacchiera fatta da nove quadrati. Chi riesce a metterne tre in fila, in orizzontale, in verticale o in obliquo, vince. Ebbene, per i giocatori idealizzati della teoria dei giochi, l'esito di ogni partita è totalmente prevedibile. Due giocatori razionali sanno, ancora prima di cominciare, che ogni partita fra loro termina con il pareggio. In altre parole, un primo aspetto della razionalità consiste nel fatto che i giocatori sono abili a fare l'analisi strategica del gioco, non commettono errori di distrazione e così via. D'altra parte, basta un'ipotesi molto debole di razionalità a creare situazioni imbarazzanti: in certe situazioni due persone, pur avendo la possibilità di ottenere dieci a testa, scelgono (razionalmente) di avere uno a testa. In ogni caso, esistono circostanze in cui definire che cosa sia il comportamento razionale non risulta ambiguo. Però è anche chiaro che vi sono giochi per i quali, a differenza del tris, l'esito di una singola partita non è prevedibile nemmeno per giocatori perfettamente razionali: basta pensare al gioco del pari e del dispari, in cui A e B dicono contemporaneamente un numero compreso fra 1 e 5 e se la somma viene pari vince A, altrimenti B. Per giochi come questo un concetto di risultato razionale deve essere più sofisticato del semplice predire l'esito di ogni singola partita.

Quanto all'ipotesi di egoismo, sulla quale convinzioni ideologiche potrebbero indurre a pregiudizi, porre come assioma di comportamento delle persone che ciò che conta sono le preferenze personali e che quelle degli altri sono solo informazione per ottenere il meglio per sé, non significa negare che possano essere osservati, in questo mondo descritto dalla teoria, comportamenti che siamo soliti definire altruisti. Il problema cruciale, in situazioni complesse, è quello di ordinare le preferenze delle persone sugli esiti di un gioco. Il meccanismo che spinge un dittatore sanguinario o una persona che dedica la sua vita agli altri è, secondo la teoria, lo stesso. Questo è accettabile e verosimile, ed è completamente indipendente dall'eventuale giudizio morale che ognuno potrebbe dare sull'uno e sull'altro; tale giudizio riguarda infatti le loro funzioni di utilità, non ipotesi sui meccanismi del loro ragionamento.

I primi risultati

Ovviamente stabilire quale sia il primo risultato significativo di una teoria è fatto convenzionale ed esercizio più curioso che utile; tuttavia anche in teoria dei giochi ci sono alcuni risultati che sono in genere riconosciuti come l'inizio ufficiale (o uno degli inizi) dello sviluppo della teoria. Nel nostro ambito, questo primato va sicuramente assegnato al cosiddetto teorema di Zermelo, pubblicato nel 1913, che asserisce che il gioco degli scacchi è strettamente determinato.

Questo significa che, per la teoria, ogni singola partita giocata dai due giocatori perfettamente razionali idealizzati nelle ipotesi finisce inevitabilmente con lo stesso risultato, proprio come nel tris: si dice appunto che il gioco è strettamente determinato. Le proprietà essenziali del gioco degli scacchi, che rendono applicabile il ragionamento di Zermelo, sono due: che il gioco sia finito, ovvero che consista in un numero finito di mosse possibili, che debba sfociare in un numero finito di passi in un esito finale e che sia a informazione perfetta. Quest'ultima espressione significa che i giocatori conoscono tutte le informazioni rilevanti relative al gioco: in particolare, nello svolgimento di ogni possibile partita i giocatori possono ricostruirne la storia passata e le possibili evoluzioni future.

Come ci si può facilmente immaginare, la dimostrazione di tale teorema è totalmente non costruttiva: certamente non viene fornita una strategia vincente per uno dei due giocatori. Naturalmente, ci sono altri giochi che hanno le stesse caratteristiche e per capire la portata del teorema su un esempio forse ancora più stringente basta considerare giochi a informazione perfetta e finiti, come per esempio l'Hex (inventato da John Forbes Nash Jr.), in cui non è possibile il pareggio. In tal caso, il teorema dice che ogni partita giocata da giocatori razionali finisce sempre con la vittoria dello stesso.

Per l'Hex, un'applicazione diretta del teorema di Zermelo implica, con un facile ragionamento per contraddizione, che è il primo che vince. Tuttavia non fornisce un modo per costruire la strategia vincente del giocatore (a parte per particolari scacchiere) ed è quindi abbastanza chiaro il motivo per cui un teorema del genere possa essere considerato controverso; infatti non tutti i matematici lo accettano, come nel caso dei logici intuizionisti. La tecnica con cui si dimostra il teorema di Zermelo, e che si applica ai giochi a un numero finito di giocatori, finiti e a informazione perfetta, è chiamata di induzione a ritroso perché l'analisi viene fatta a partire dalla fine del gioco stesso, per risalire poi passo dopo passo verso il suo inizio. Per fare questo, l'idea è quella di rappresentare il gioco nella sua forma estesa.

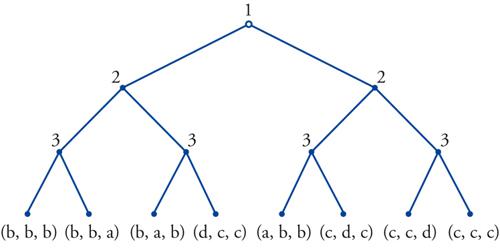

Si tratta di costruire un grafo orientato caratterizzato da una radice che rappresenta la situazione iniziale del gioco, da cui si dipartono alcuni rami che rappresentano le mosse possibili del primo giocatore. Questi poi portano a dei nodi, etichettati con il nome di un giocatore, da cui si dipartono altri rami, e così via, fino ad arrivare ai cosiddetti nodi finali, che rappresentano un esito possibile della partita. A questi sono associati delle ennuple di numeri, uno per giocatore, che rappresentano il gradimento del giocatore stesso per il risultato raggiunto in quel nodo. Nel caso semplice degli scacchi, si può convenzionalmente associare 1 al giocatore che vince, 0 a entrambi in caso di pareggio, −1 a chi perde. Vediamo un esempio molto semplice di gioco descritto in questa forma, in cui viene rappresentata una situazione non molto rara: tre politici devono votare in sequenza, a voto palese, l'approvazione di una certa legge, che passa se ottiene almeno due voti a favore. Sarebbero favorevoli all'approvazione, ma il gioco è reso interessante dal fatto che preferiscono votare diversamente per mandare un messaggio di un certo tipo ai loro elettori. Ecco come risulta l'albero del gioco, avendo denotato con a>b>c>d le utilità dei giocatori nelle 4 situazioni possibili (a se passa la legge avendo votato contro [...] d se la legge non passa avendo votato a favore)

Il ramo di sinistra corrisponde, per tutti e tre, alla scelta di votare a favore, mentre quello a destra rappresenta il voto contro. L'analisi, come già detto, viene condotta a ritroso: in questo caso andando a vedere il comportamento del terzo giocatore in tutti i possibili casi in cui potrebbe trovarsi (che sono diversi a seconda del voto degli altri due, perché il voto è palese): per esempio, qualora si trovi nel nodo a sinistra, nota che andando a destra guadagna a, a sinistra b, quindi a tal nodo sceglierebbe di andare a destra (gli altri hanno già votato a favore della legge, a lui conviene votare contro). Egli compie la stessa analisi negli altri tre nodi di competenza e la sua scelta viene così definita in ogni nodo che porta a una situazione finale.

A questo punto il giocatore 2 sa che cosa gli conviene fare, ai nodi in cui deve decidere, potendo prevedere il comportamento successivo del terzo e così via, fino ad arrivare alla radice. Nell'esempio semplice di sopra, la conclusione è che, potendo scegliere, è preferibile essere il primo giocatore, che vota contro la legge e obbliga gli altri a votare a favore.

Questo procedimento è applicabile a ogni albero del gioco dello stesso tipo, partendo appunto dai nodi che portano a situazioni finali, che individuano dei sottogiochi (banali, in quanto c'è un solo decisore). Questo permette di portare l'analisi strategica a un livello superiore: trovate le soluzioni dei giochi di lunghezza uno, si possono risolvere quelli di lunghezza due (cioè quelli che finiscono al massimo dopo due mosse), e così via. Il processo induttivo porta dunque al risultato. Sono due le caratteristiche del gioco che permettono all'induzione di funzionare: il fatto che, rimuovendo un nodo e i rami che da esso si dipartono quel che rimane è un certo numero di (sotto)giochi della stessa natura e il fatto che esistano delle situazioni finali, ossia che l'induzione possa partire al primo passo e che si possa passare dal passo n al passo n+1. Esattamente quanto succede in giochi come gli scacchi.

Un aspetto interessante legato al teorema di Zermelo è che cosa può succedere nel caso di un gioco di lunghezza infinita. Chiaramente in questo caso il processo induttivo non può cominciare. Il celebre esempio che mostra come le conclusioni del teorema di Zermelo non valgano più in questo caso è il seguente. Due giocatori muovono alternativamente e le loro mosse consistono nel dire un intero compreso fra 0 e 9. Il risultato finale è una sequenza infinita di interi, che si considera come la parte decimale di un numero compreso fra 0 e 1. Viene assegnato ai giocatori un insieme A⊂[0,1], e lo scopo del primo giocatore consiste nel fare sì che il numero ottenuto cada nell'insieme A, mentre il secondo deve impedire che questo accada. Si dimostra che esistono insiemi A per cui questo gioco non ha equilibrio: in altre parole, qualunque strategia usi il primo giocatore, ne esiste una per il secondo tale che il risultato finale sia fuori A, e qualunque sia la strategia del secondo ne esiste una del primo tale che il risultato finale appartenga ad A. L'esistenza di tale insieme è dimostrabile attraverso l'uso dell'assioma di scelta e ha quindi relazioni interessanti con la teoria assiomatica degli insiemi. Si può inoltre dimostrare che nel caso in cui la struttura topologica dell'insieme A sia semplice (per es., aperto, oppure chiuso) il gioco è determinato.

È evidente però che non tutti i giochi sono a informazione perfetta. Per esempio, questa manca se il gioco prevede mosse contemporanee per i giocatori. Tuttavia non sembra ragionevole che un giocatore razionale si rassegni a giocare tali giochi in maniera casuale. In altre parole, la domanda da porsi è se esistano modi più o meno razionali di giocare giochi non determinati. La risposta sta in un'altra delle pietre miliari della teoria, il teorema del minimax dimostrato alla fine degli anni Venti del secolo scorso da John von Neumann.

Il teorema del minimax

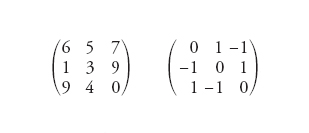

I giochi a somma zero, o strettamente competitivi, sono il primo banco di prova per cercare di esplorare la teoria nelle sue varie ramificazioni e generalizzazioni. Dal momento che ogni forma di collaborazione è preclusa, perché gli interessi dei giocatori sono opposti, il primo concetto da tenere in considerazione è quello di livello di sicurezza del giocatore. Vediamo che cosa significa questo. Limitiamoci ai giochi a due persone, che abbiano un numero finito di mosse a disposizione. In questo caso, il gioco si rappresenta efficacemente con una matrice. Ecco due esempi:

[1] formula

Per convenzione, si chiama primo giocatore quello che sceglie una riga, secondo quello che sceglie una colonna e il risultato è una casella in cui sta scritto un coefficiente, che rappresenta quanto il secondo paga (in senso algebrico) al primo. La matrice di destra dell'esempio precedente allora è una forma strategica della familiare morra cinese, in cui i giocatori devono scegliere tra tirare sasso, forbici oppure carta.

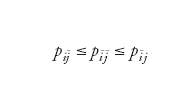

Se indichiamo con pij il generico elemento della matrice, allora la quantità maximinjpij rappresenta il livello di sicurezza del primo giocatore, in quanto è la quantità che si può garantire, a prescindere da quello che il secondo decida di fare. Dualmente, minjmaxipij rappresenta il livello di sicurezza del secondo giocatore. Se (e solo se) questi due valori coincidono, il gioco ha equilibrio. In altre parole, è determinato: ogni partita giocata dai giocatori razionali della teoria finisce allo stesso modo. Inoltre, ogni coppia (i_,j_) tale che

[2] formula

per ogni i e per ogni j, garantisce a entrambi i giocatori di ottenere i loro livelli di sicurezza e quindi rappresenta un profilo di strategie di equilibrio. Coppie come quella appena descritta viene talvolta chiamata punto sella del gioco. Nella prima matrice in [1], è facile verificare che l'esito del gioco è il pagamento di 5 da parte del secondo al primo, ottenuto con le strategie prima riga, seconda colonna (i_=1,j_=2).

Nel caso in cui i livelli di sicurezza dei due giocatori non coincidano e quindi quello del primo è minore di quello del secondo, come per esempio nella matrice di destra, che cosa conviene fare? Ovviamente non è possibile prevedere l'esito di una singola partita. Ma si può capire come affrontare il problema immaginando di giocare più volte contro lo stesso giocatore. Consideriamo per esempio la morra cinese. Se uno dei due decidesse di non giocare mai sasso, allora dopo un po' l'altro giocatore se ne accorgerebbe e comincerebbe a giocare sempre forbici, con indubbio guadagno.

Dunque esistono modi più o meno razionali di giocare un tale gioco. Come individuarli? L'idea consiste nel randomizzare fra le strategie a disposizione. In altri termini, si assegna a priori una certa probabilità con cui le varie strategie verranno giocate, e poi si gioca in accordo con i risultati di un esperimento casuale che rispetti le probabiltà stabilite. La funzione di utilità dei giocatori ha adesso il significato di valore atteso: guadagnare 100 o 0 con il 50% di probabilità equivale a guadagnare 50 con certezza. Naturalmente non sempre le persone, anche intelligenti, si comportano secondo questa ipotesi, che comunque è perfettamente accettabile nel mondo razionale idealizzato dalla teoria.

Si parla in questo caso di strategie miste per i giocatori, e lo spazio delle strategie dei giocatori diventa un simplesso di dimensioni opportune. Questa procedura aumenta (in senso atteso) i valori conservativi del primo e diminuisce quello del secondo. Un esito razionale del gioco diventa allora un punto di sella della funzione di utilità (attesa). Il teorema di von Neumann, enunciato nel 1928, asserisce che ogni gioco finito a somma zero ammette equilibrio in strategie miste.

Nei giochi simmetrici, come il pari e dispari o la morra cinese, il livello di sicurezza di entrambi è zero, come è logico aspettarsi. Nella morra cinese, i giocatori tirano un dado, avendo assegnato due facce a ognuna delle tre alternative. Poi, giocano secondo il responso del dado. In questo modo, si garantiscono un guadagno atteso nullo.

Il calcolo delle strategie miste di equilibrio diventa rapidamente molto complicato all'aumentare del numero delle strategie pure a disposizione dei giocatori. La cosa interessante però è che il problema di trovare una strategia ottimale del primo giocatore si può tradurre in maniera equivalente in un problema di programmazione lineare, il cui duale rappresenta il problema di trovare una strategia ottimale per il secondo. Tutto l'apparato sviluppato per risolvere problemi di programmazione lineare può dunque essere utilizzato per trovare le soluzioni di questi giochi. Storicamente, sembra assodato che sia stato von Neumann stesso a suggerire a George Dantzig di sviluppare il metodo del simplesso, proprio stimolato anche dal desiderio di avere uno strumento potente per trovare la soluzione di questi giochi.

Il teorema del minimax di von Neumann, che si basa su tecniche di convessità, ha avuto applicazioni notevoli in altre discipline, non direttamente collegate alla teo-ria dei giochi (per es., teoria statistica delle decisioni edesign di sistemi di calcolo distribuiti).

Per concludere, il concetto di razionalità con il contributo di von Neumann si è evoluto, indicando come affrontare una categoria di giochi il cui esito non è necessariamente scontato, per ogni singola partita, nemmeno nel mondo dei giocatori idealizzati dalla teoria.

I contributi di Nash

Il modello non cooperativo

I giochi strettamente competitivi godono di proprietà molto particolari. Un giocatore può trovare le sue strategie di equilibrio senza bisogno di conoscere che cosa faccia l'altro giocatore. Non c'è bisogno di coordinamento per arrivare a una situazione di equilibrio: ciascuno per conto suo risolve un problema di programmazione lineare, che non necessariamente ha un'unica soluzione. Tuttavia, anche senza unicità, ogni coppia di soluzioni rappresenta un equilibrio. È intuibile che questo non succeda se il gioco non è strettamente competitivo.

Per superare queste apparenti difficoltà von Neumann e Oskar Morgenstern introducono l'idea di gioco cooperativo, concetto che sarà illustrato nel paragrafo successivo. Qui anticipiamo un po' i tempi per illustrare brevemente il modello non cooperativo sviluppato da Nash jr. nella sua tesi di dottorato e poi pubblicato nel 1950. Questo perché il suo modello si riallaccia con più naturalezza a quello visto sui giochi a somma nulla. Ne approfittiamo anche per illustrare brevemente un altro risultato molto interessante di Nash, il suo modello di contrattazione.

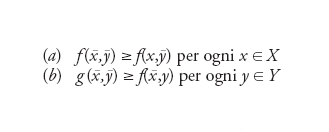

Si definisce gioco non cooperativo, in forma strategica, a due giocatori un'assegnazione (X,Y,f: X×Y→ℝ, g: X×Y→ℝ), dove X e Y rappresentano gli spazi di strategie rispettivamente del primo e del secondo giocatore, mentre f e g le loro funzioni di utilità. La specificazione di una coppia (detta anche profilo) di strategie (x,y) porta a una coppia di numeri reali, f(x,y) e g(x,y), che rappresentano le utilità dei due giocatori quando le due strategie sono utilizzate. Un equilibrio è allora definito come una coppia (x_,y_)∈X×Y tale che:

Il significato della definizione di equilibrio è chiaro: nessuno dei due giocatori ha interesse a deviare dalla strategia di sua competenza, ammesso che anche l'altro non compia deviazioni. Chiaramente, la definizione qui riportata per due giocatori può essere estesa a un numero finito qualunque, senza nessuna complicazione se non nelle notazioni. Nash dimostra poi che ogni gioco finito ammette equilibrio in strategie miste.

L'idea di equilibrio non era del tutto nuova, come del resto dice chiaramente Nash stesso: l'aveva già utilizzata Antoine Augustin Cournot. Tuttavia è senza dubbio il lavoro di Nash che porta all'attenzione degli esperti l'idea di gioco in forma strategica e quella associata di equilibrio. Nel 1994 a Nash, unitamente a John C. Harsanyi e Reinhard Selten, è stato assegnato il premio Nobel per l'economia e la motivazione richiama lo straordinario numero di applicazioni che questa idea ha avuto. Naturalmente, è facile dimostrare che l'equilibrio ottenuto con il processo di induzione a ritroso per i giochi finiti e a informazione perfetta è un equilibrio di Nash, così come è un equilibrio ogni coppia di strategie di punto sella per i giochi a somma zero. Inoltre, il teorema di von Neumann diventa un corollario di quello di Nash, che può essere dimostrato in modi differenti ma che si richiamano sostanzialmente a teoremi di punto fisso, o per funzioni o per multifunzioni.

Il concetto di equilibrio ha avuto sviluppi e generalizzazioni successive. Per esempio, una generalizzazione molto interessante è stata proposta da Robert J. Aumann, che ha introdotto la definizione di equilibrio correlato. Si tratta di una distribuzione di probabilità sul prodotto degli spazi delle strategie dei giocatori tale che, se un arbitro comunica privatamente a ogni giocatore la strategia pura da giocare, in accordo all'esito dell'esperimento aleatorio condotto secondo la distribuzione proposta nessun giocatore, aggiornate bayesianamente le proprie credenze, ha interesse a deviare su una strategia diversa. L'insieme degli equilibri correlati è un compatto convesso non vuoto, che si caratterizza con un sistema di disequazioni lineari. Su questo politopo poi i giocatori potrebbero accordarsi di massimizzare una qualche funzione obbiettivo, come per esempio la somma delle utilità.

Un modello di contrattazione

Nel periodo trascorso a Princeton come studente di dottorato, Nash ha scritto anche un lavoro fondamentale sul problema della contrattazione. Il suo approccio al problema, detto assiomatico, è stato utilizzato nello stesso periodo da Lloyd S. Shapley per la definizione dell'indice di potere che porta il suo nome e da Kenneth Arrow per il suo celeberrimo teorema di impossibilità. Vedremo in seguito come questo tipo di approccio sia stato largamente usato per la definizione e/o caratterizzazione di vari concetti di soluzione di giochi cooperativi, e quali siano i suoi vantaggi.

Un problema di contrattazione, secondo Nash, può essere descritto da un insieme compatto convesso C del piano, e da un punto d dell'insieme stesso. Un elemento x=(x1,x2)∈C rappresenta una distribuzione di utilità possibili fra i due giocatori (x1 al primo, x2 al secondo) come risultato del processo di contrattazione, mentre d rappresenta le utilità in caso di disaccordo. Una soluzione del problema della contrattazione è una funzione f che a ogni possibile problema di contrattazione (C,d) associa un (solo) punto di C, che rappresenta l'esito della contrattazione stessa. Nash propone che detta soluzione f soddisfi un certo numero di proprietà, tra le quali l'efficienza (la soluzione non può essere una distribuzione di utilità tale che ce ne sia un'altra che soddisfi maggiormente entrambi i giocatori) e la simmetria (se i giocatori hanno le stesse opportunità, devono avere anche lo stesso risultato). Infine, dimostra il teorema che esiste un'unica funzione f che soddisfa le proprietà richieste: si tratta del punto che massimizza la funzione g(u,v)=(u−d1)(v−d2) in C∩{(u,v): u≥d1, v≥d2}. A parole, e con un po' di imprecisione, i giocatori devono massimizzare il prodotto delle loro utilità.

È chiaro che questo risultato è piuttosto astratto e ottenuto in ipotesi molto restrittive. In particolare, come dice Nash stesso, si assume che le utilità dei giocatori sui possibili esiti della contrattazione siano conoscenza comune. Ovviamente, nella pratica succede proprio il contrario: l'abilità e il senso del contrattare sta nel nascondere, almeno parzialmente, all'altro le proprie preferenze. Tuttavia la soluzione da lui proposta ha delle proprietà interessanti. Per esempio, è sensitiva all'avversione al rischio. Nel caso semplice della spartizione di una somma di denaro un giocatore più avverso al rischio rispetto a un altro ottiene una somma minore: questo sicuramente rispecchia un fenomeno che accade nella realtà. L'approccio assiomatico di Nash al problema della contrattazione è stato seguito da altri: sostituire una proprietà con un'altra può infatti individuare una soluzione differente.

Una delle più note è quella di Kalai-Smorodinski, che propone come distribuzione di utilità il punto della frontiera efficiente dell'insieme C che intercetta il segmento congiungente il punto di disaccordo con il punto utopia U, ossia il punto U del piano che ha come coordinate il massimo delle utilità che i due giocatori possono ottenere nella contrattazione (in formula: U=(U1,U2) con U1=max{u: (u,v)∈C}, U2=max{v: (u,v)∈C}). Esistono anche altri approcci al problema della contrattazione, tra i quali in particolare va ricordato il modello proposto da Ariel Rubinstein.

Giochi cooperativi

L'idea di gioco cooperativo è stata introdotta da von Neumann e Morgenstern nel volume Theory of games and economic behavior, che molti indicano come l'atto di nascita ufficiale della teoria dei giochi. Il contributo di questo libro è fondamentale soprattutto per aver reso lo studio dei giochi una disciplina sistematica, e per aver proposto un cambiamento importante nel modo di studiare i problemi dell'economia, delle scienze politiche e di quelle sociali.

Il metodo da loro proposto consiste nel tradurre i problemi in giochi opportuni, di trovarne le soluzioni con le tecniche ad hoc sviluppate da questa teoria e di ritradurre le soluzioni trovate in termini di comportamenti economici ottimali. L'idea di gioco cooperativo nasce, come già accennato in precedenza, dall'esigenza di analizzare il comportamento razionale di agenti che interagiscono in situazioni non (necessariamente) strettamente competitive. In tal caso è ragionevole pensare che i giocatori possano fare alleanze, formare coalizioni e così via. Ogni coalizione sarà in grado poi di garantire una certa distribuzione di utilità all'interno dei suoi membri. Che cosa distingue il gioco cooperativo da quello non cooperativo? Secondo la definizione di Harsanyi, un gioco è definito cooperativo se accordi, promesse, minacce ecc. sono vincolanti. In caso contrario, il gioco è definito non cooperativo.

A rigor di termini, la teoria cooperativa potrebbe essere inclusa in quella non cooperativa, includendo le negoziazioni tra i giocatori nella forma estesa del gioco. Questo avrebbe senso in particolare nello studio dei processi di votazione, ove le regole che li governano hanno un ruolo cruciale sull'esito delle stesse. Tale approccio però rende in genere molto complicata la descrizione del gioco e impone un'analisi molto dettagliata che può far perdere la visione d'insieme, analogamente a quanto succede con la forma strategica e quella estesa di un gioco non cooperativo: l'approccio strategico non include tutti i dettagli della descrizione in forma estesa, ma permette un'analisi d'insieme a volte più efficace. La descrizione dei giochi cooperativi all'interno della teoria non cooperativa viene definita programma di Nash, contiene risultati interessanti, ma non fa parte di una teoria sistematica. Pertanto l'approccio cooperativo ha altrettanta importanza di quello non cooperativo. All'interno dei giochi cooperativi è possibile distinguere quelli a utilità trasferibile (TU) e quelli a utilità non trasferibile (NTU). Esaminiamo dapprima la definizione di giochi NTU, che è più generale, quindi quella di giochi TU, che ne sono una sottoclasse molto importante. Un gioco cooperativo è costituito dall'insieme N={1,…,n} dei giocatori, e dall'assegnazione, per ogni A⊂N, di un insieme V(A) di A-ple di vettori le cui componenti sono numeri reali. Intuitivamente, questi vettori rappresentano le utilità che i membri della coalizione A possono garantirsi alleandosi fra loro. In un'economia di puro scambio, per esempio, V(A) è l'insieme delle utilità che i giocatori di A possono ottenere facendo scambi tra loro, senza coinvolgimento degli agenti che non appartengono alla coalizione A. Osserviamo che in tal senso, se i giocatori sono due, il problema della contrattazione di Nash descritto sopra può essere visto come gioco cooperativo (in genere NTU), con V(N)=C, mentre V({i})=di.

Un concetto di soluzione nell'ambito dei giochi cooperativi è una funzione che a ogni gioco assegna un esito, o un insieme di esiti. Un esito può essere identificato con una ennupla (chiamata profilo) di numeri reali, che rappresenta l'utilità assegnata nel gioco a ciascun giocatore.

Supponiamo ora che sia data una funzione v: 2N→ℝ tale che v(→)=0, dove 2N denota l'insieme dei sottoinsiemi di N. La condizione v(→)=0 è una sorta di condizione di normalizzazione. Si può allora definire un gioco cooperativo ponendo, per ogni A⊂N, V(A)={x=(xi)i∈A: ∑i∈Axi≤v(A)}. Fissato N, l'insieme S delle funzioni v: 2N→ℝ tale che v(→)=0 rappresenta l'insieme dei giochi cooperativi TU. S è isomorfo allo spazio Euclideo di dimensione 2n−1. Vediamo un paio di esempi semplici di gioco cooperativo. Supponiamo ci siano due potenziali compratori di un bene che è in possesso di una terza persona. Questi, per convenzione il giocatore 1, valuta il bene a, mentre gli altri due, rispettivamente, b e c. Supponiamo inoltre a〈b≤c (che il venditore valuti il bene meno dei due potenziali compratori rende il gioco effettivamente a tre persone).

In tal caso si ha v({1})=a, v({2})=v({3})=v({2,3})=0, v({1,2})=b, v({1,3})=v({N})=c. Nel caso invece di un compratore (giocatore 1) e due venditori dello stesso bene, la situazione può essere modellizzata con v(A)=1 se A={1,2}, {1,3}, {1,2,3}, zero altrimenti. In questo caso, quando la funzione caratteristica v assume solo valori zero e uno, il gioco si chiama semplice e v assume più il significato di indice di forza della coalizione (A è coalizione vincente se e solo se v(A)=1).

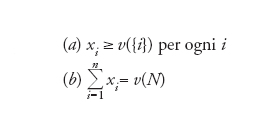

Esistono molti concetti di soluzione di gioco cooperativo: per analizzarli con una certa accuratezza ci vorrebbe un volume intero. Ci limitiamo qui a introdurre alcuni fra i più importanti, e per giochi TU. Prima di tutto, una soluzione deve essere un'imputazione, cioè un vettore (x1,…,xn) tale che:

Si richiede cioè a ogni soluzione di godere delle proprietà di razionalità individuale e di efficienza collettiva: ogni giocatore deve avere almeno quel che è in grado di garantirsi da solo (altrimenti esce dal gioco) e tutto l'utile disponibile va distribuito. Anche se non si assume esplicitamente, l'ipotesi che v(N)≥v(A) per ogni A⊂N è verificata in quasi tutti i giochi interessanti. Anzi, spesso i giochi verificano l'ipotesi detta di superadditività, cioè v(A∪B)≥v(A)+v(B) se A∩B=→, che stabilisce che l'unione fa la forza.

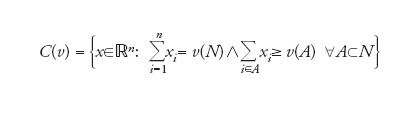

Questa richiesta è quindi da ritenere minimale. In realtà, visto che le coalizioni sono possibili, sembra naturale richiedere che esse stesse accettino una distribuzione di utilità, altrimenti una parte dei giocatori potrebbe ritirarsi. Si arriva così a uno dei concetti fondamentali di soluzione: il nucleo del gioco v, in simboli C(v), è l'insieme

[3] formula.

In questo modo, nessuna coalizione ha interesse a rifiutare la spartizione proposta. È chiaro che tale concetto di soluzione può essere, mutatis mutandis, ritradotto parola per parola anche nel caso NTU. In questo caso, una coalizione A rifiuta un profilo (x1,…,xn) se può ottenere di più da sola, cioè se esiste y∈V(A) tale che yi>xi per ogni i∈A.

Nel gioco dei due compratori, la soluzione proposta dal nucleo è che il primo vende l'oggetto al terzo (che lo valuta di più rispetto al secondo), a un prezzo che può variare fra b e c. Nel gioco invece in cui ci sono un compratore e due venditori dello stesso bene, il nucleo consiste nell'unico vettore (1,0,0), il che significa che i venditori cedono il bene per nulla. È interessante notare che, nel primo esempio, il ruolo del secondo giocatore, che pure alla fine non fa nulla, è messo in evidenza dal fatto che il prezzo di vendita è influenzato dalla sua presenza.

Può essere però un po' deludente il fatto che l'idea di nucleo non dia in questo caso un'informazione più precisa (per es. proponendo il prezzo preciso di vendita). Nel secondo caso ciò che indica il nucleo è un fatto ben noto in economia, anche se qui espresso in maniera brutale: l'eccesso di offerta mette i venditori in balia del compratore. Vedremo che altre soluzioni, in particolare l'indice di Shapley, propongono una soluzione diversa, che tiene conto del fatto che in qualche modo i due venditori potrebbero accordarsi per ottenere qualcosa dal primo giocatore.

Un esempio ancora più interessante di come il nucleo possa proporre soluzione bizzarre è il famoso gioco dei guanti: una versione che ne mette bene in luce la stranezza è quando si hanno quattro giocatori, il primo e il secondo possiedono uno e due guanti sinistri rispettivamente, mentre il terzo e quarto un destro ciascuno. In questo caso il nucleo è costituito dal solo vettore (0,0,1,1), il che significa che i possessori di un guanto sinistro (guanti che sono in eccedenza) devono privarsene per nulla. Ancora più bizzarro se si pensa che il giocatore due potrebbe cambiare la situazione semplicemente distruggendo un suo guanto in suo possesso.

A dispetto del fatto che a volte le soluzioni proposte dal nucleo sembrino controintuitive, esso rappresenta un concetto di soluzione molto importante, soprattutto in applicazioni economiche. Però il nucleo presenta ancora un altro problema: è facile verificare che in molti casi può essere vuoto. L'esempio più semplice è quando siamo in presenza di tre giocatori che si devono spartire a maggioranza un'utilità fissata (poniamola convenzionalmente uguale a 1). In tal caso le coalizioni di due giocatori risultano vincenti (v(A)=1 se il numero dei componenti la coalizione A è almeno due, 0 altrimenti, ancora un gioco semplice) e un calcolo immediato mostra che il nucleo è vuoto. Nei giochi semplici, è facile verificare che il nucleo è non vuoto se e solo se esiste almeno un veto player, cioè un giocatore i tale che v(A)=0 se i∉A. Quando ci sono giocatori di veto il nucleo contiene ogni imputazione che spartisce fra essi in modo arbitrario la quantità 1.

Il che rende indispensabile la definizione di altre soluzioni, che possano suggerire possibili spartizioni anche nel caso in cui almeno una coalizione non sia soddisfatta della spartizione proposta. Prima di passare alla definizione di altri concetti di soluzione, vale la pena accennare che, nel caso TU, l'appartenenza di un vettore al nucleo si esprime con un numero finito di disuguaglianze lineari e quindi la non vacuità dello stesso può essere studiata tramite la programmazione lineare, in particolare utilizzando la teoria della dualità.

Il grado di insoddisfazione della coalizione A per la distribuzione dell'imputazione x può essere misurato dalla quantità e(A,x)=v(A)−∑i∈Axi. L'imputazione x sta nel nucleo, per esempio, se e solo se e(A,x)≤0 per ogni A.

Data un'imputazione x, denotiamo con θ(x) il vettore, che ha 2n−1 componenti, tale che θ1(x)≥θ2(x)≥… e θi(x)=e(A,x), per una coalizione A⊂N. In altre parole, θ(x) ordina in maniera decrescente l'insoddisfazione delle coalizioni rispetto all'imputazione x. Il nucleolo del gioco v è l'insieme delle imputazioni x tali che θ(x)≤Lθ(y), per ogni y imputazione di v.

In parole imprecise, il nucleolo considera le imputazioni che minimizzano il primo lamento, tra queste quelle che minimizzano il secondo fra i massimi lamenti, e così via. Si dimostra che a ogni gioco v il nucleolo associa un'unica imputazione.

Da questo punto di vista è una proprietà molto interessante. Esso può anche essere caratterizzato come soluzione di un certo problema di programmazione lineare, e quindi venir calcolato con software opportuni. Va però osservato che il calcolo del nucleolo di un gioco diventa rapidamente complicato, all'aumentare del numero dei giocatori.

Nel gioco precedente dei compratori, il prezzo di vendita è (b+c)/2, ossia il prezzo intermedio fra quello minimo e quello massimo proposti dal nucleo; nel gioco di maggioranza a tre giocatori, propone l'imputazione (1/3,1/3,1/3). Risultati non sorprendenti, dal momento che il nucleolo è soluzione che gode di forti proprietà di simmetria. È anche facile dimostrare che il nucleolo appartiene al nucleo, purché naturalmente questo non sia vuoto. Il che tra l'altro mostra che nel gioco dei due venditori e un compratore anche il nucleolo assegna tutto al compratore.

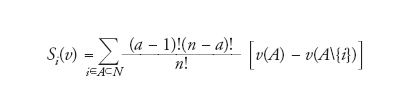

Passiamo al terzo concetto di soluzione che qui consideriamo: l'indice di Shapley. Indicato con S: S→ℝn,risulta così definito:

[4] formula

dove a indica il numero di giocatori della coalizione A.

L'indice di Shapley associa al giocatore i contributi marginali che esso porta a ogni coalizione, pesati secondo un certo coefficiente. Il quale ha un'interpretazione probabilistica interessante. Supponendo che i giocatori decidano di trovarsi per giocare, in un certo luogo e a una data ora, il coefficiente [(a−1)!(n−a)!]/n! rappresenta la probabilità che i al suo arrivo trovi gli altri giocatori della coalizione A, e solo loro.

Shapley ha caratterizzato l'indice che oggi prende il suo nome col metodo assiomatico, cui abbiamo già fatto un cenno. Egli assume che una soluzione di un gioco cooperativo debba essere efficiente, avere una certa proprietà di simmetria, non dare nulla ai giocatori che non contribuiscono mai al benessere di una coalizione, e che sia additiva. Quest'ultima proprietà appare un po' arbitraria dal punto di vista del modello, il che giustifica tentativi successivi di proporre altri assiomi caratterizzanti l'indice di Shapley.

Nel gioco di maggioranza semplice fra tre giocatori, l'indice di Shapley propone (1/3,1/3,1/3), come appare chiaro dalla simmetria dei tre giocatori. Nel gioco dei guanti invece la soluzione è (1/4,7/12,7/12,7/12). Certamente questa soluzione presenta caratteristiche interessanti: tiene conto del fatto che c'è un eccesso di offerta di guanti sinistri, il che rende un po' più debole degli altri il giocatore uno. Il secondo non ne risente, perché da una parte potrebbe riportare la situazione simmetrica, buttando via un guanto, dall'altra può sfruttare il fatto di poter soddisfare da solo la domanda dei giocatori col guanto destro. Questo mostra che il valore tiene conto di altri aspetti, ignorati dal nucleo.

L'indice di Shapley ha applicazioni importanti anche nei giochi semplici. Come esempio, si può pensare all'analisi della composizione di un'assemblea parlamentare, come il Parlamento europeo o il Congresso negli Stati Uniti. Il problema fondamentale in questi casi è come ripartire i seggi fra i vari stati. È un merito della teoria dei giochi aver chiarito una volta per sempre che non esiste un metodo equo, corretto e praticabile in tutte le situazioni possibili.

Pertanto diventa prezioso cercare di stabilire che forza abbia un giocatore (uno stato), assegnandogli un certo numero di seggi a priori. Chiaramente, non è possibile dare un indicatore certo e definitivo della forza di un singolo giocatore, ma avere un indice ragionevole può essere estremamente utile. Quello di Shapley è forse il più noto e il più utilizzato, ma ne esistono altri (di Banzhaf, di Banzhaf-Coleman, di Owen). L'indice di Shapley è stato utilizzato in moltissime applicazioni, per citarne qualcuna per calcolare le tariffe di atterraggio in un aeroporto, per suddividere i costi telefonici fra i vari gruppi in un'università o i costi di un acquedotto alle varie municipalità che lo utilizzano, per tentare di identificare quali geni possano essere responsabili dell'insorgenza di una malattia tumorale.

Esistono molti altri concetti di soluzione, che qui nominiamo appena. Innanzitutto, l'idea di insieme stabile, che è quella originale sviluppata da von Neumann-Morgenstern nel loro libro citato. Poi quelle di bargaining set, prekernel e kernel nonché, per il caso dei giochi NTU, i valori Shapley e Harsanyi.

Probabilmente può lasciare perplessi questa proliferazione di concetti di soluzione. Tuttavia va rimarcato che sta proprio nella complessità delle situazioni che si vogliono descrivere il fatto che un'idea unica di soluzione non ha senso. Come più volte sostenuto da Aumann, una soluzione di un gioco cooperativo non è necessariamente una predizione del comportamento di giocatori, o una prescrizione di razionalità, quanto piuttosto un indicatore. L'indice di Shapley per il gioco del venditore e dei due compratori è ((2a+b+3c)/6,(b−a)/6,(3c−a−2b)/6). Se letto come distribuzione di utilità sembra un risultato assurdo, se interpretato come indice di potere mostra quanto meno che il secondo giocatore, pur non facendo nulla nel gioco, ha un ruolo attivo nel risultato: la sua presenza cambia l'andamento del gioco stesso e questo in qualche modo viene segnalato dall'indice.

Abbiamo più volte accennato al fatto che esistono svariate caratterizzazioni assiomatiche delle soluzioni dei giochi cooperativi. Spesso, alcune di queste hanno diverse caratterizzazioni. Ma perché l'approccio assiomatico è così importante? Prima di tutto, perché mette in luce le proprietà che una data soluzione possiede. Ma l'importanza maggiore risiede nel fatto che la caratterizza, in genere, con poche, spesso molto ragionevoli, proprietà. Il fatto che cambiare per esempio una di queste proprietà, con un'altra di eguale forza persuasiva, caratterizzi una soluzione diversa è a un tempo la dimostrazione che un unico concetto di soluzione sembra davvero una richiesta senza senso nell'ambito della teoria, e il segnale che ogni soluzione può produrre risultati apparentemente poco accettabili in specifici esempi. La conclusione che sembra poter essere tirata è che la ricchezza del numero di soluzioni in letteratura riflette il fatto che la teoria cooperativa ha aspetti estremamente sfaccettati, che non possono essere colti da una sola idea di esito del gioco. Soluzioni differenti hanno il pregio di mettere in luce aspetti differenti del problema. Il prezzo inevitabile da pagare è che, su singoli esempi, alcune di esse possano produrre risultati bizzarri.

Un gioco molto famoso

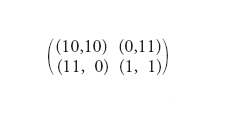

Quello che può essere considerato il gioco più famoso di tutta la teoria dei giochi è probabilmente il dilemma del prigioniero e si può descrivere così. Un giudice convoca due persone sospettate di essere complici di un grave crimine e fa loro un discorso di questo tenore: se uno dei due confessa e l'altro no, chi confessa sarà libero per aver assicurato un irriducibile alla giustizia; l'altro sarà condannato a 10 anni di galera. Se entrambi confessassero, la pena sarebbe pari a 7 anni di galera. Se nessuno confessasse, le prove sarebbero insufficienti per provare la colpevolezza di entrambi riguardo al crimine, ma il giudice troverà il modo di condannarli a una pena detentiva di un anno per un reato più lieve. Per descrivere un gioco come questo, è utile ricordare che giochi finiti a due persone a somma zero sono efficacemente descritti da matrici. Qui, non essendo il gioco strettamente competitivo, dobbiamo specificare per ogni esito finale non un numero ma una coppia di numeri, che rappresentano i pagamenti, o le utilità, dei due giocatori. Si parla in questo caso di bimatrice.

Una bimatrice che potrebbe descrivere il gioco precedente è la seguente:

[5] formula.

Può essere associata facilmente al gioco, equivalente al dilemma del prigioniero, di due giocatori cui viene chiesto se preferiscono che sia dato loro un euro oppure dieci all'altro.

L'equilibrio di Nash, l'unico equilibrio, porta al risultato di (1,1). Il che vuol dire che entrambi diranno che preferiscono ricevere un euro. Atteggiamento che può essere definito rude, egoista, non cooperativo, in opposizione a quello amichevole, cooperativo, altruista di chi propone di dare all'altro una somma più consistente. È evidente il fatto che questa soluzione appare molto deludente dal punto di vista dell'efficienza. Infatti, i due potrebbero dividersi equamente 20 euro e decidono invece di optare per la divisione di 2. È talmente deludente che sul dilemma del prigioniero è stato detto moltissimo, anche a sproposito. Per esempio, che i giocatori non devono poter comunicare, altrimenti potrebbero accordarsi sul non confessare. Nulla di più falso. Possono essere lasciati comunicare, anche da soli, senza la presenza del giudice. Ogni loro eventuale accordo non è vincolante: entrambi hanno interesse a violarlo. È stato detto che rappresenta la critica più efficace all'idea di equilibrio di Nash. Anche questo non è vero. Non è necessario appellarsi all'idea di equilibrio per individuarne il risultato. Basta, molto semplicemente, eliminare le strategie dominate, cioè quelle strategie che portano a un risultato peggiore di altre qualunque sia la strategia usata dagli altri giocatori. Un'altra, pericolosa, obiezione è che un giocatore abbia interesse a giocare in maniera cooperativa per indurre un effetto virtuoso nell'altro: un modo per negare che ha perfettamente senso che giocatori razionali possano avere vantaggio personale a non collaborare, sia pure per ottenere un risultato che è socialmente disastroso. Al contrario, più in fretta si capisce che il comportamento egoista ma razionale può portare a effetti negativi per i giocatori, prima le istituzioni potranno studiare meccanismi che incentivino la cooperazione. Una obiezione più seria è che esperimenti mostrano come persone ritenute generalmente razionali spesso violino le previsioni della teoria. In tal senso, viene spesso citato un famoso esperimento ideato da Robert Axelrod, in cui esperti di varie università furono chiamati a scrivere programmi per giocare ripetutamente il dilemma del prigioniero contro tutti gli altri programmi, in un torneo round robin. Il programma vincitore della prima sfida, semplice in modo sbalorditivo, fu il celebre Tit for Tat di Anatol Rapoport, che al primo passo gioca amichevolmente e al passo n+1 fa quello che l'altro ha fatto al passo n. L'esperimento è ripetuto successivamente, dopo la pubblicazione dei risultati, con un numero molto maggiore di partecipanti ma con lo stesso risultato. Programmi creati ad hoc erano in grado di battere il TfT, salvo poi scontrarsi fra loro.

Sul dilemma del prigioniero si continuerà a scrivere, e se ne parlerà ancora. Gli economisti possono inventarsi mille esempi in cui agenti devono risolvere un dilemma come quello, per esempio, dei due bar che devono decidere il prezzo del cappuccino e si trovano di fronte a un dilemma dello stesso tipo. Ma non solo l'economia apprezza tale esempio. Gli psicologi dicono che è una delle maniere più semplici ed eleganti per descrivere conflitti fra persone, per esempio c'è chi sostiene che spesso la crisi di una coppia si basi su meccanismi psicologici descrivibili come il dilemma del prigioniero. Gruppi di animali della stessa specie, secondo famosi esperimenti, fronteggiano in certe situazioni un problema del tipo dilemma del prigioniero. La matematica dà varie risposte a questo dilemma, tutte molto interessanti. Certamente, quando giocato una volta sola, sembra difficile sfuggire alla sua logica di dilemma. Ma esistono risposte diverse, non è detto che ci si debba rassegnare a una risposta che prevede un atteggiamento aggressivo. Anche se, tutti i giorni, possiamo osservare che la nostra vita sociale è condizionata dallo stesso dilemma: l'uomo si dà delle regole di convivenza civile nella convinzione che queste migliorino le condizioni della collettività, e quindi di tutti, ma chi le viola ne ha spesso un vantaggio immediato.

Ulteriori sviluppi

Nei paragrafi precedenti sono stati presentati in estrema sintesi i risultati della teoria classica dei giochi, la quale come già detto ha avuto molti e profondi sviluppi successivi, che sono impossibili da trattare con una certa sistematicità. Vediamo allora in questo paragrafo una carrellata rapida di alcune delle direzioni di ricerca più importanti nella teoria più recente.

Giochi stocastici

Sono quelli in cui sono previsti più stadi. A ogni stadio, i giocatori giocano un gioco strategico secondo la definizione tradizionale. Il profilo di strategie dei giocatori determina il payoff degli stessi a ogni stadio e il gioco che sarà giocato allo stadio successivo (o una distribuzione di probabilità su questi). La strada ai risultati in questo ambito è stata aperta da Shapley, nel caso strettamente competitivo, che ha mostrato l'esistenza del valore e di strategie ottimali nel caso di payoff futuri scontati con un fattore di sconto fissato. Inoltre, i giocatori hanno strategie ottimali di tipo stazionario, il che significa che dipendono solo dal gioco che viene giocato al momento e non dalla storia passata o dal momento in cui il gioco viene giocato. Questi risultati sono stati anche successivamente generalizzati al caso non strettamente competitivo.

Giochi ripetuti

Sta in questo tipo di giochi la risposta, o per lo meno una risposta, al problema della cooperazione osservabile in giochi tipo dilemma del prigioniero. Non è difficile capire che se due giocatori sanno di dover giocare il dilemma del prigioniero un numero prefissato e noto di volte, l'unico atteggiamento razionale è quello aggressivo. Infatti, all'ultimo stadio è chiaro che non conviene collaborare, in quanto si applica esattamente lo stesso ragionamento che nel gioco a uno stadio solo. Ma essendo questo noto a entrambi, dall'ultimo stadio l'analisi passa al penultimo, che per l'analisi precedente diventa l'ultimo in cui c'è una decisione da prendere. Dunque anche a questo stadio non conviene collaborare; uno schema di ragionamento che ricorda quello dell'induzione a ritroso. La situazione cambia radicalmente se il gioco viene immaginato a infinite ripetizioni, oppure a ripetizioni finite ma in numero ignoto, o varianti, del tipo che a ogni stadio c'è una probabilità positiva che il gioco si arresti. Il più celebre risultato in questo ambito è il cosiddetto Folk theorem. Si chiami ammissibile un profilo di payoff raggiungibile dai giocatori quando si ammettano strategie correlate. Si considerino, fra i profili ammissibili, quelli individualmente razionali, cioè quelli in cui a ogni giocatore viene assegnato almeno il suo livello di sicurezza. Il teorema allora afferma che gli equilibri del gioco ripetuto infinite volte coincidono esattamente con i profili ammissibili e individualmente razionali. Ecco come l'atteggiamento collaborativo può essere osservato in pieno accordo con la teoria classica.

Giochi a informazione incompleta

Robert Duncan Luce e Howard Raiffa, nel loro libro Games and decisions che ha avuto un'enorme influenza nello sviluppo successivo della disciplina, osservano che l'ipotesi di fondo della teoria dei giochi è che ogni giocatore conosce non solo le regole del gioco, ma anche le utilità degli altri giocatori, e che questa ipotesi è una restrizione forte, raramente verificata in situazioni reali. Per ovviare a questo inconveniente, Harsanyi ha sviluppato la teoria dei giochi a informazione incompleta. Egli postula che ogni giocatore abbia conoscenza delle strategie degli altri, ma che non ne conosca le funzioni di utilità, che ciascun giocatore possa essere uno fra un certo numero di tipi differenti e che il tipo determini per ogni giocatore la sua funzione di utilità e la distribuzione di probabilità sui tipi degli altri giocatori. Il dato dei giocatori, delle loro strategie, dei tipi e delle distribuzioni di probabilità dei giocatoricostituisce un cosiddetto I-game; un equilibrio in unI-game consiste in una strategia per ogni tipo di giocatore, che massimizza l'utilità attesa, fissata quella proposta agli altri. Un gioco è consistente se le distribuzioni di probabilità di tutti i tipi sono ottenibili come distribuzioni a posteriori di una singola distribuzione a priori sull'ennupla dei tipi. La consistenza permette di rendere un I-game molto simile a un gioco ordinario in forma strategica; in particolare gli equilibri diventano gli equilibri di Nash del gioco strategico associato, dove la natura sceglie a caso, in accordo con la probabilità a priori, quale ennupla di tipi gioca effettivamente il gioco. Naturalmente il modello di Harsanyi è stato esteso ai giochi ripetuti.

Razionalità limitata

La teoria dei giochi si fonda sull'assioma di razionalità (perfetta) dei giocatori. Basta pensare al primo suo risultato rilevante, il teorema degli scacchi. Ovviamente questa è un'ipotesi assolutamente restrittiva. Il dilemma del prigioniero ripetuto un centinaio di volte ha all'incirca 22100 strategie pure. Non ha senso pensare che i giocatori siano consci di avere a disposizione questa vasta gamma di strategie. D'altra parte, una limitazione nel numero delle strategie disponibili nel gioco rischia di cambiare drasticamente l'esito del gioco. Ci sono alcuni lavori che si occupano di questo problema. Si può pensare di definire come possibile per un giocatore solo una strategia programmabile da un automa di grandezza prefissata in maniera esogena. E ancora una volta il risultato sul dilemma del prigioniero fa da spartiacque. Abbiamo infatti dedotto che se il gioco è ripetuto un numero finito e noto di volte, solo l'atteggiamento aggressivo porta a un equilibrio. Ma ipotizzando che i giocatori nel calcolo delle loro strategie dispongano di automi finiti (per es., di grandezza polinomiale rispetto al numero di ripetizioni) allora la strategia collaborativa diventa anch'essa di equilibrio. D'altra parte, ipotesi differenti sulla natura dell'automa possono portare a risultati molto diversi.

Applicazioni alla biologia

Molti indizi e molti esperimenti portano a credere che il comportamento animale sia in genere più razionale di quello umano. John Maynard Smith ha sviluppato l'idea di strategia evolutivamente stabile, una variante del concetto di equilibrio di Nash, nell'applicazione della teoria allo studio del comportamento animale. L'interpretazione evoluzionista dell'equilibrio è che strategie pure e miste non rappresentano scelte consce dei giocatori, ma un equilibrio raggiunto da una popolazione alle prese con il problema di ottimizzare i comportamenti per la propria sopravvivenza.

Raffinamenti del concetto di equilibrio

Le definizioni di gioco in forma strategica, e di equilibrio a essa associata, hanno il problema di ignorare ciò che accade nella forma estesa del gioco stesso. La ragione risiede nel fatto che l'equilibrio non è sensibile ai cambiamenti al di fuori del cammino di equilibrio. In particolare, può prescrivere comportamenti non ottimali in certi nodi (ovviamente non raggiunti dall'implementazione della strategia di equilibrio). Per questo sono stati successivamente proposti vari raffinamenti del concetto di equilibrio, a cominciare dal famoso equilibrio trembling hand definito da Reinhard Selten.

Pur essendo impossibile spiegare in poche parole che cosa propongano i vari concetti di equilibrio, si può dire, in accordo con Aumann, che tutti hanno alla radice l'idea che un potenziale comportamento irrazionale da parte dei giocatori deve essere tenuto nel dovuto conto. Questo fa sì che i giocatori considerino la possibilità che gli altri possano sbagliare, con una certa probabiltà (piccola), e ciò permette di selezionare alcuni equilibri piuttosto che altri.

Mechanism design

Un ultimo aspetto che merita almeno menzione è quello del mechanism design. Partendo dal fatto che gli agenti sono persone razionali, si può analizzare l'evoluzione di un gioco e il suo esito a partire dalle regole del gioco stesso.

Un tipico esempio è il meccanismo d'asta. Questo tipo di applicazione è estremamente importante. Supponiamo che un ente (governo, istituzione) voglia ottenere determinati risultati da un'asta pubblica, che non sono soltanto la massimizzazione dei profitti ma, per esempio, il tentativo di evitare concentrazioni oligopolistiche. Si può allora pensare a meccanismi che ottengano risultati migliori rispetto a quelli tradizionali. Un campo in cui i governi si sono sbizzarriti in questo senso è quello della vendita delle bande per i telefoni satellitari: a volte con risultati spettacolari, a volte con risultati disastrosi. Ma non è questo l'unico campo in cui merita attenzione come le regole influenzano i risultati. Tenendo conto che spesso sono gli agenti stessi che devono rivelare le loro preferenze sugli esiti di un gioco, e che in situazioni complesse queste non sono evidenti, il meccanismo proposto deve invogliare i partecipanti a rivelare le loro vere preferenze: in altre parole, non ci deve essere incentivo a mentire. Recentemente, sono stati fatti modelli basati sulla teoria dei giochi, per lo scambio di reni fra pazienti con donatori incompatibili, ma compatibili nello scambio. È assolutamente ovvia l'importanza non solo di implementare meccanismi efficienti, ma anche che non inducano a mentire. Gli esempi potrebbero continuare: il legislatore potrebbe occuparsi dei meccanismi che regolano la contrattazione fra parti, in modo, per esempio, di difendere la parte più debole. Non deve allora stupire che la teoria dei giochi sia stata applicata anche allo studio delle leggi.

Conclusioni

La teoria dei giochi ha la maggior parte delle sue applicazioni in scienze che riguardano l'uomo: l'economia, le scienze sociali, la psicologia, la filosofia.

Come tale, è chiaro che non può fornire risultati indiscutibili come altre discipline, quali la fisica o la chimica. Inoltre, siccome rappresenta il primo tentativo approfondito di descrivere il comportamento umano in situazioni interattive, appare abbastanza evidente che i suoi risultati sono destinati a creare problemi di interpretazione e a proporre risposte paradossali alle più svariate questioni. Si basa anche su assunti del comportamento degli individui, che sono evidentemente più delicati che non un'assiomatica della geometria o della fisica. Infatti, a prima vista l'ipotesi del giocatore perfettamente razionale e intelligente appare perlomeno molto restrittiva. E, non a caso, già il primo risultato della disciplina, il teorema sugli scacchi, appare paradossale nella sua formulazione: i giocatori idealizzati dalla teoria lo ritengono un gioco poco interessante dal momento che è strettamente determinato.

Dalla parte opposta, ci sono le critiche di coloro che vedono questa teoria come uno strumento pericoloso, quasi come una tecnologia i cui usi e abusi possono arrecare più danni che vantaggi. Tanto per citare un esempio, alcune associazioni hanno protestato quando i meccanismi d'asta prima ricordati hanno permesso ai governi di trarre grandi profitti dalla vendita delle bande per i cellulari, sostenendo poi che gli alti prezzi pagati dai vincitori dell'asta sarebbero stati inevitabilmente riversati sui consumatori.

A questo tipo di critiche è facile obbiettare che aiutare a capire meglio i meccanismi del comportamento umano può naturalmente essere usato in positivo o in negativo; il problema non sta nella teoria, ma nell'eventuale uso che se ne fa. Più interessante è la discussione su quanto il decisore descritto dalla teoria sia davvero una buona approssimazione dell'essere umano.

Questione delicata e profonda, che coinvolge non solo i teorici dei giochi, ma anche coloro che sono interessati alle loro applicazioni come gli studiosi di scienze sociali, nonché i filosofi della scienza e gli psicologi. Qui val la pena osservare solo che accanto alla teoria fiorisce la cosiddetta game practice, che affianca a studi teorici esperimenti studiati per mettere in evidenza il comportamento reale delle persone chiamate a interagire in determinate situazioni. Non solo, discipline molto nuove, come la behavioral economics, affiancano e arricchiscono la teoria dei giochi con nuovi spunti e nuovi esperimenti. Infine, i giochi sono stati recentemente utilizzati per esperimenti condotti con la risonanza magnetica nucleare funzionale, per osservare le reazioni di parti del cervello degli esseri umani in situazioni interattive semplici. Dunque, se da una parte la teoria, che comincia a farsi adulta, allenta anche le sue ipotesi di razionalità e interagisce con altre discipline per una migliore descrizione del comportamento umano, dall'altra, con il suo decisore super razionale, rappresenta una specie di modello ideale ma precisamente definito la cui descrizione serve come paradigma per osservare quanto il comportamento umano si discosti in molte situazioni da quello previsto. C'è di più. Nata per descrivere il comportamento umano, la teoria dei giochi viene oggi applicata allo studio del comportamento animale e studi recentissimi affrontano, grazie alle sue tecniche, problematiche legate a macchine intelligenti e interagenti.

Bibliografia

Aumann 1974: Aumann, Robert J., Subjectivity and correlation in randomized strategies, "Journal of mathematical economics", 1, 1974, pp. 67-96.

Aumann 1987: Aumann, Robert J., Game theory, in: The new Palgrave: a dictionary of economics, edited by John Eatwell, Murray Milgate, Peter Newmann, London, MacMillan, 1987, pp. 460-482.

Baird 1994: Baird, Douglas - Gertner, Robert-Picker, Randal, Game theory and the law, Cambridge (Mass.), Harvard University Press, 1994.

Harsanyi 1967: Harsanyi, John C., Games with incomplete information played by "Bayesian" players. I-III, "Management science", 14, 1967, pp. 159-182.

Luce, Raiffa 1957: Luce, Robert D. - Raiffa, Howard, Games and decisions, New York, Wiley, 1957.

Maynard Smith 1982: Maynard Smith, John, Evolution and the theory of games, Cambridge, Cambridge University Press, 1982.

Nash 1951: Nash, John F. jr, Non-cooperative games, "Annals of mathematics", 54, 1951, pp. 289-295.

Nash 1950: Nash, John F. jr, The bargaining problem, "Econometrica", 18, 1950, pp. 155-162.

Neyman 1985: Neyman, Abraham, Bounded complexity justifies cooperation in the finitely repeated prisoner's dilemma, "Economics letters", 19, 1985, pp. 227-230.

Rubinstein 1982: Rubinstein, Ariel, A perfect equilibrium in a bargaining model, "Econometrica", 50, 1982, pp. 97-109.

Rubinstein 1986: Rubinstein, Ariel, Finite automata play the repeated prisoner's dilemma, "Journal of economic theory", 39, 1986, pp. 83-96.

Schmeidler 1969: Schmeidler, David, The nucleolus of a characteristic function game, "SIAM journal of applied mathematics", 17, 1969, pp. 1163-1170.

Shapley 1953: Shapley, Lloyd, Stocastic games, "Proceedings of the National Academy of Sciences USA", 39, 1953, pp. 1095-1100.

Shapley 1953: Shapley, Lloyd, A value for n-person games, in: Contributions to the theory of games, edited by W. Harold Kuhn, Albert W. Tucker, Princeton, Princeton University Press, 1953, pp. 307-317.

Von Neumann 1928: von Neumann, John, Zur Theorie der Gesellschaftsspiele, "Mathematische Annalen", 100, 1928, pp. 295-320.

Von Neumann, Morgenstern 1944: von Neumann, John - Morgenstern, Oskar, Theory of games and economic behavior, Princeton, Princeton University Press, 1944.

Zermelo 1913: Zermelo, Ernst, Über eine Anwendung der Mengenlehre auf die Theorie des Schachspiels, "Proceedings of the Fifth International Congress of Mathematicians", 2, 1913, pp. 501-504.