Misure ad altissima precisione

Misure ad altissima precisione

Caratteristica fondante della scienza moderna è il metodo sperimentale che affronta l'indagine dei fenomeni naturali mediante misure. Misurare significa confrontare una grandezza fisica con un'altra analoga di entità nota. Elementi essenziali della misura sono il campione di unità di misura, che rappresenta la grandezza di entità nota, e lo strumento di misura con cui viene effettuato il confronto. Assieme alle condizioni sperimentali nelle quali la misura ha luogo, essi ne determinano la precisione e l'accuratezza, nel senso che chiariremo più avanti.

Essendo il processo di misura ineluttabilmente imperfetto, il risultato viene espresso da due quantità numeriche, rispettivamente il valore e l'incertezza associata a tale valore. La valutazione dell'incertezza è un elemento imprescindibile di ogni misura fisica, a cui viene attribuita un'importanza pari, talvolta anche superiore, a quella del valore misurato.

Il risultato di una misura si deve per esempio esprimere nella forma (1,235±0,050) U oppure 1,235(50) U, dove U indica una generica unità di misura, 1,253 il valore più probabile, 0,050 l'incertezza associata a tale valore. L'intervallo [1,253−0,050, 1,253+0,050] è detto invece intervallo di confidenza. Talvolta l'intervallo di confidenza è asimmetrico e occorre indicare separatamente le incertezze nella forma (1,253−0,045) U: in questi casi il valore più probabile non coincide con il valore medio dell'intervallo di confidenza. A ogni intervallo di confidenza è associato un livello di confidenza, ovvero la probabilità stimata che il valore vero della grandezza misurata ricada nell'intervallo. Il rapporto tra incertezza e valore più probabile della misura è detto incertezza relativa. L'incertezza relativa è pertanto la quantità che definisce la precisione di una misura.

La valutazione dell'incertezza deve conformarsi a criteri stabiliti da organismi internazionali e condivisi dalla comunità scientifica ed essere adeguatamente descritta. La corretta valutazione dell'incertezza e la descrizione di tale valutazione sono i pilastri su cui riposano due dei capisaldi del metodo sperimentale, ovvero la ripetibilità e la riproducibilità della misura. La ripetibilità di una misura indica la vicinanza tra risultati successivi di una misura condotta nelle medesime condizioni sperimentali. La riproducibilità invece indica la vicinanza tra risultati di una stessa grandezza misurati in differenti condizioni sperimentali. Per misure di estrema complessità, la riproduzione può risultare talmente onerosa da non trovare realizzazione pratica. Se invece una misura si rivela irriproducibile, ovvero impossibile da confermare per mezzo di altri esperimenti, o peggio irripetibile, ovvero impossibile da confermare per mezzo del medesimo esperimento, la sua validità è da rigettare.

Impropriamente, secondo una terminologia ormai superata, permane l'uso del termine errore quale sinonimo di incertezza. L'errore di una misura rappresenta quanto il valore ottenuto si discosta dal valore vero. L'entità dell'incertezza non implica quella dell'errore: si possono avere misure con una grande incertezza e piccolo errore e viceversa. Le une sono di scarsa utilità, poiché aggiungono poco alla conoscenza della grandezza misurata, le altre sono sbagliate. Anzi si può affermare che uno dei metodi per ridurre la possibilità di errore è proprio estendere l'intervallo di confidenza, ovvero aumentare l'incertezza.

In questo senso, incertezza ed errore determinano rispettivamente precisione e accuratezza della misura. La precisione di una misura è inversamente proporzionale all'incertezza relativa, l'accuratezza invece riflette l'assenza di errori, ovvero la vicinanza al valore vero.

Occorre qui sottolineare che il concetto di valore vero è utile a patto di comprendere che si tratta di un'astrazione. Asserendo l'esistenza di un valore vero, si suppone cioè che la grandezza in esame abbia un valore esatto ma ignoto. In realtà, ogni grandezza fisica è soggetta a fluttuazioni ineliminabili a livello fondamentale, a volte causate dallo stesso processo di misura. La definizione stessa di valore vero risulta quindi problematica. Anche quando la definizione è possibile, rimane aperta la questione epistemologica sulla conoscibilità di tale valore.

Operativamente, il valore vero di una grandezza viene identificato con il valore accettato, frutto consolidato di differenti misure considerate simultaneamente mediante opportuni metodi statistici.

Incertezze di tipo A e di tipo B

Secondo la pratica moderna, si distinguono due tipi di incertezze associate alle misure: incertezze di tipo A e di tipo B. Questa distinzione, benché corretta, è spesso oscurata dalla tradizionale distinzione tra incertezze statistiche (o aleatorie) e sistematiche, più largamente utilizzata. La classificazione tra incertezze di tipo A e di tipo B è ancora una volta di carattere operativo: essa riposa sul modo in cui l'incertezza viene stimata piuttosto che su una presunta natura dell'incertezza. Un medesimo effetto può originare un'incertezza ora di tipo A, ora di tipo B, in misure della stessa grandezza. In generale, l'incertezza di una misura si compone di diversi contributi, alcuni dei quali di tipo A e altri di tipo B. Il tipo di incertezza associato a ciascun contributo non è noto a priori ma determinato a posteriori, una volta portata a termine la misura.

Si definiscono incertezze statistiche quelle che vengono stimate con metodi statistici attraverso la ripetizione della misura. In generale, a causa di perturbazioni sulla grandezza in esame, sullo strumento o sul campione di unità di misura, misure ripetute forniscono risultati diversi. La contraddizione con l'esperienza quotidiana è solo apparente: la lunghezza di una matita è sempre la stessa se misurata con un righello millimetrato ma fluttua se misurata con un calibro.

Generalizzando, occorre uno strumento sufficientemente sensibile per poter apprezzare le variazioni casuali inerenti il processo di misura. Tali fluttuazioni si verificano a causa di variazioni della grandezza in esame (la matita si dilata o si contrae), dello strumento di misura o delle condizioni sperimentali (il calibro stringe la matita in punti diversi). Per misure di altissima precisione, si possono infine evidenziare anche fluttuazioni intrinseche al campione di unità di misura utilizzato.

Illustriamo il concetto con un esempio: un elettrone è una particella dotata di momento angolare intrinseco (spin), ovvero ruota su se stesso come una trottola. In determinati stati, misurando la rotazione dell'elettrone, si osserva talvolta una rotazione in senso orario, talaltra in senso antiorario. Grazie alla meccanica quantistica, possiamo conoscere la probabilità che si osservi l'uno o l'altro senso di rotazione. Lo stesso accade per la posizione dell'elettrone: non possiamo sapere esattamente dove lo troveremo, ma possiamo conoscere la probabilità di localizzarlo in un qualsiasi volume dello spazio. In questo senso, in ultima analisi ogni misura è un processo aleatorio.

Nell'esperienza quotidiana e nel mondo macroscopico, non si percepisce la natura probabilistica della meccanica quantistica perché le fluttuazioni quantistiche sono estremamente piccole. Per esempio, l'indeterminazione quantistica sulla posizione di un granello di sabbia a temperatura ambiente è dell'ordine di 10−21 m ed è ancora minore per oggetti di massa crescente. Nel mondo microscopico degli atomi e delle particelle elementari l'indeterminazione quantistica assume ben altra rilevanza. Essa rappresenta il limite ultimo cui tende la precisione delle misure. Nella fisica moderna misure al limite quantistico sono alla base del funzionamento degli orologi atomici e di esperimenti che mirano a rivelare fenomeni di entità piccolissima come le onde gravitazionali.

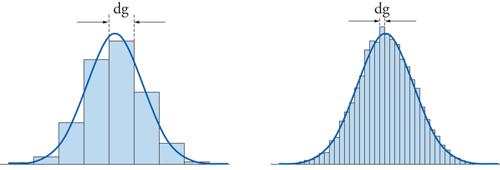

Per definizione, le incertezze di tipo A si valutano mediante misure ripetute della stessa grandezza come risultato della dispersione dei valori misurati. Indichiamo con Ĝ la grandezza fisica da misurare, per esempio la massa di un oggetto, e con g1,g2,…,gn gli esiti di un grande numero n di misure ripetute. Dopo aver diviso lo spazio dei valori possibili in intervalli discreti, si costruisce un istogramma come in fig. 1 in cui ciascuna barra ha un'altezza pari alla frequenza con cui i valori misurati cadono nell'intervallo divisa per l'estensione dell'intervallo.

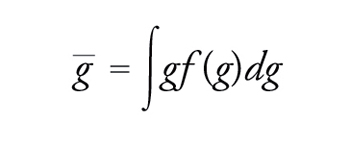

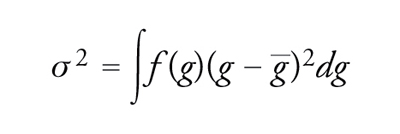

Si dice distribuzione di probabilità f(g) la curva a cui tende l'istogramma al diminuire dell'intervallo. Indicando con ḡ il valore medio della distribuzione di probabilità, la larghezza è data dalla varianza σ2:

[1] formula

[2] formula.

La radice della varianza si dice deviazione standard σ ed è la quantità che viene usata, salvo diversa indicazione, come incertezza standard.

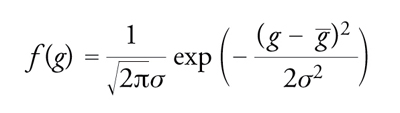

Di particolare rilievo è la distribuzione di probabilità gaussiana (detta anche normale):

[3] formula.

Poiché la funzione gaussiana è simmetrica intorno al suo valore massimo, quest'ultimo coincide con il valore medio ḡ. La deviazione standard della distribuzione gaussiana definisce un intervallo di confidenza [ḡ−σ,ḡ+σ] con un livello di confidenza del 68,27%. L'uso di incertezze pari a multipli interi k della deviazione standard accresce il livello di confidenza: in questo caso si parla di incertezza estesa. Nel caso di distribuzione di probabilità normale, il livello di confidenza sale al 95,45% e 99,73% rispettivamente per k=2 e k=3.

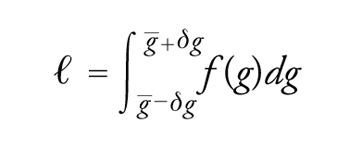

La distribuzione di probabilità dei risultati permette di precisare meglio il significato dell'incertezza statistica. Definito un livello di confidenza ℓ, ovvero la probabilità che il risultato ricada nell'intervallo di confidenza, è immediato stabilire quali siano i limiti ḡ−δg, ḡ+δg di tale intervallo:

[4] formula.

In genere, i limiti dell'intervallo di confidenza sono multipli interi della deviazione standard σ; è immediato calcolare che per δg={σ,2σ,3σ,…} risulta ℓ={0,683;0,954;0,997;…}, ovvero il livello di confidenza è rispettivamente del 68,3%, 95,5%, 99,7% e così via.

La funzione di distribuzione gaussiana è spesso usata assumendone implicitamente la validità anche in assenza di riscontri in tal senso. Sebbene ciò possa sembrare arbitrario, vi sono almeno due buone ragioni che giustificano questa pratica. Innanzitutto, si prova che quando un valore è il risultato di una misura indiretta, ovvero è ricavato come funzione di differenti grandezze fisiche misurate indipendentemente, la sua distribuzione di probabilità si approssima a una gaussiana al crescere del numero delle grandezze misurate (teorema del limite centrale). In secondo luogo, anche laddove la forma della distribuzione è differente, la gaussiana rappresenta in molti casi un'approssimazione soddisfacente, giacché il livello di confidenza non cambia apprezzabilmente rispetto alla distribuzione corretta, oltreché conveniente.

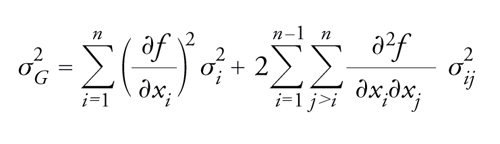

La distribuzione di probabilità inoltre permette di sommare le incertezze. Accade spesso che l'incertezza di una misura derivi da molteplici sorgenti, il cui effetto combinato dà luogo alle fluttuazioni sulla grandezza in esame. Consideriamo per esempio una grandezza che dipende da un numero n di altre grandezze attraverso una funzione matematica, Ĝ=f (ĝ1,…, ĝn). Per misurare Ĝ si misurano tutte le grandezze primarie ĝ1,…, ĝn, ottenendo come esito l'insieme di valori (xi±σi), i=1,…,n. Il risultato della misura di Ĝ è evidentemente X=f(x1,…,xn), mentre meno ovvio è il calcolo dell'incertezza:

[5] formula

dove σij indica la covarianza associata ai risultati xi e xj, ovvero una misura di quanto le determinazioni delle grandezze ĝ e ĝj siano interdipendenti.

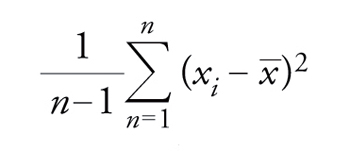

Come caso particolare dell'applicazione di questa regola si consideri la valutazione dell'incertezza per un insieme {xi} di n misure ripetute della stessa grandezza. Ogni misura assume come incertezza u la deviazione standard stimata

[6] formula,

oppure un multiplo, a seconda del livello di confidenza desiderato. Al risultato finale x_, essendo ottenuto dalla media aritmetica dei risultati delle singole misure, si associa, al medesimo livello di confidenza, un'incertezza pari a u/√n, in diretta applicazione della regola di composizione delle incertezze espressa dall'equazione [5].

Le incertezze di tipo B sono definite ad excludendum rispetto a quelle di tipo A: sono incertezze di tipo B tutte quelle valutate mediante metodi non statistici, come quelle derivanti da risultati di misure precedenti, dalle specifiche tecniche degli strumenti utilizzati e dal comportamento noto di materiali e strumenti. Per esempio, nelle misure eseguite con il calibro, occorre tener conto della dilatazione termica del calibro stesso. Se nel corso delle misure la temperatura varia in modo incognito entro un intervallo di 2 °C, poiché il coefficiente di dilatazione termica dell'acciaio con cui è fabbricato il calibro vale 16 μm/(m °C), lo sperimentatore attribuisce al risultato una componente di incertezza relativa pari a 3,2∙10−5. Questo tipo di valutazione dell'incertezza è di tipo B.

Se la misura fosse stata ripetuta con valori diversi di temperatura, le medesime fluttuazioni dovute alla dilatazione avrebbero dato luogo a un'incertezza di tipo A. È chiaro pertanto che la distinzione tra incertezze di tipo A e di tipo B non costituisce un mero cambiamento di terminologia rispetto alla distinzione tra incertezze statistiche e sistematiche.

Per le incertezze di tipo B il livello di confidenza è stimato indirettamente, si basa cioè su dati noti e su giudizi di merito formulati dallo sperimentatore. La distribuzione di probabilità, su cui si fondano la stima del livello di confidenza e le regole di composizione delle incertezze, viene raramente stimata. In genere l'informazione rilevante viene condensata nell'entità dell'incertezza al livello di confidenza richiesto.

Misure ad altissima precisione

Le qualifiche di alta e altissima precisione sono necessariamente relative e inevitabilmente mutevoli: i livelli corrispondenti dipendono dal confronto con altre misure della stessa grandezza. In primo luogo, il progresso scientifico e tecnologico banalmente muta il nostro giudizio sul grado di precisione di una misura. In secondo luogo, per ragioni tecniche fondamentali, alcune grandezze fisiche si misurano con precisione maggiore di altre. Tra le grandezze fondamentali definite nel Sistema internazionale (SI), le misure di tempo e frequenza sono in assoluto le più precise. Lo stesso vale per le misure delle costanti fondamentali: allo stato attuale, un'incertezza relativa dell'ordine di una parte per milione (ppm) rappresenta una precisione modesta se associata alla frequenza della transizione Lyman α dell'atomo di idrogeno, essendo tale frequenza nota entro 2 parti su 1014, alta se associata alla costante di gravitazione universale, nota entro una parte su 105.

Vedremo ora due esempi notevoli e recenti di misure ad altissima precisione: la misura del fattore giromagnetico dell'elettrone e della transizione 1s−2s dell'atomo di idrogeno. Entrambe queste misure sono il risultato di anni di lavoro, che hanno visto lo sviluppo di nuovi dispositivi e di nuove tecniche di misura, lunghe acquisizioni di dati e meticolose analisi, in un processo che spesso avviene iterativamente, per raffinazioni successive.

Misura dell'anomalia giromagnetica dell'elettrone

La misura dell'anomalia giromagnetica dell'elettrone rappresenta un esempio formidabile di misura ad altissima precisione, frutto di una serie di esperimenti, compiuti da Hans G. Dehmelt e collaboratori all'Università di Washington, nell'arco di vent'anni a partire dai primi anni Settanta, culminata con il conferimento del premio Nobel allo stesso Dehemelt nel 1989.

L'elettrone è una particella elementare, ovvero priva di struttura interna, dotata di momento angolare intrinseco detto spin S=ℏℏ/2 (ℏ=h/2π, h costante di Planck), e di carica elettrica negativa. Poiché cariche elettriche in movimento generano campi magnetici, lo spin dell'elettrone origina un momento magnetico μe il cui rapporto g rispetto al magnetone di Bohr μB=eℏ/(2me) è detto rapporto giromagnetico. La teoria quantistica relativistica di Paul Dirac prevede che g sia uguale a 2, ma a causa di fluttuazioni quantistiche del campo elettromagnetico con cui interagisce, g si discosta leggermente da 2 di una quantità denominata anomalia giromagnetica a=(g−2)/2. La misura dell'anomalia magnetica dell'elettrone permette di testare direttamente le fluttuazioni quantistiche del campo elettromagnetico, le quali possono essere calcolate.

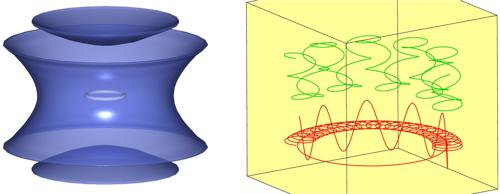

Grazie all'elevata precisione raggiunta, l'elettrone fu confinato in una trappola ottenuta mediante la sovrapposizione di campi magnetici ed elettrici statici, detta trappola di Penning (fig. 2) dal nome dell'inventore.

In presenza di un campo magnetico uniforme, l'elettrone segue una traiettoria circolare nel piano ortogonale al campo magnetico. Questo moto, detto di ciclotrone, si modifica in presenza di un campo elettrostatico.

Nella trappola di Penning dell'esperimento di Dehmelt e collaboratori, a un campo magnetico orientato lungo l'asse verticale pari a 5 T, era sovrapposto un campo elettrostatico quadrupolare generato imponendo una differenza di potenziale di 10 V tra elettrodi in guisa di iperboloidi di rivoluzione. A causa del campo elettrostatico, il centro della rotazione di ciclotrone percorre a sua volta un'orbita circolare (rotazione di magnetrone), giacente sul medesimo piano, il cui centro coincide con quello del campo elettrostatico. A questo moto si sovrappone un'oscillazione assiale lungo la direzione del campo magnetico. Le frequenze delle oscillazioni di ciclotrone νc, dell'oscillazione assiale νz e dell'oscillazione di magnetrone νm avevano valori diversi tra loro di circa 3 ordini di grandezza: νc=141 GHz, νz=60 MHz, νm=13 kHz.

Secondo una descrizione non quantistica, l'energia dell'elettrone intrappolato dipende dall'ampiezza delle varie oscillazioni. In realtà, poiché l'esperimento veniva eseguito a 4 K, la descrizione del moto richiede l'uso della meccanica quantistica. Le tre oscillazioni sono descritte come oscillatori armonici quantizzati, che contribuiscono all'energia totale con multipli interi del quanto di energia hν.

Il momento magnetico dell'elettrone si allinea al campo magnetico lungo la direzione verticale. L'energia complessiva dell'elettrone aumenta quando lo spin dell'elettrone si presenta parallelo al campo magnetico e diminuisce quando lo spin è antiparallelo, con una differenza tra le due configurazioni pari a hνs, con νs=(geB)/(4πm).

Per misurare l'anomalia magnetica dell'elettrone, Dehmelt e collaboratori misurarono la differenza tra la frequenza di ciclotrone νc e la frequenza νs.

Deformando leggermente il campo magnetico nei pressi del piano equatoriale della trappola, sia il moto di ciclotrone sia l'orientamento dello spin modificavano leggermente la frequenza di oscillazione assiale. In questo modo, rivelando solamente la frequenza assiale a 60 MHz con un radioricevitore estremamente sensibile, è stato possibile osservare le eccitazioni quantistiche di ciclotrone e le transizioni tra spin parallelo e spin antiparallelo. Come è noto dalla meccanica quantistica, le eccitazioni di ciclotrone e le transizioni di spin possono essere indotte mediante campi elettromagnetici oscillanti rispettivamente a frequenza νc e νs. Dehmelt e collaboratori hanno determinato i valori di frequenza dei campi elettromagnetici che inducevano il numero maggiore di eccitazioni di ciclotrone e di transizioni di spin, ottenendo in questo modo le frequenze νc e νs e dunque il rapporto giromagnetico g=νs/νc e l'anomalia giromagnetica dell'elettrone. L'incertezza finale sull'anomalia dell'elettrone (e del positrone) era di 4∙10−9.

Quest'esperimento rappresenta un prototipo di misura ad altissima precisione e come tale presenta aspetti che ne hanno determinato il successo, la cui valenza di carattere generale merita di essere esaminata.

Innanzitutto il sistema presentava ottime proprietà di stabilità. L'elettrone, e in seguito anche il positrone, venivano intrappolati e investigati per mesi consecutivamente. In termini generali, la precisione di una misura migliora allungandone la durata.

Generalmente l'incertezza relativa di una misura decresce proporzionalmente alla radice quadrata della durata fino a un certo limite, che dipende dalla stabilità del sistema in esame. A ben vedere si tratta dello stesso meccanismo secondo cui l'incertezza relativa di una serie di N misure ripetute diminuisce come 1/√N. Infatti, una misura protratta per una durata NΔt equivale a N misure di durata Δt.

In secondo luogo, tutte le grandezze misurate erano frequenze e l'anomalia giromagnetica veniva ricavata come rapporto tra frequenze.

Infine, l'accuratezza della misura del rapporto giromagnetico riposa su un'adeguata modelizzazione del sistema sottoposto a indagine. La corrispondenza tra le misure di frequenza effettuate e il rapporto giromagnetico è garantita dalla comprensione quantitativa degli spostamenti in frequenza osservati nelle oscillazioni dell'elettrone intrappolato. Anche quest'aspetto ha un'importanza che trascende la specifica misura. La modelizzazione teorica degli effetti osservati sperimentalmente è fondamentale; laddove è inadeguata, presumibilmente si introducono errori di carattere sistematico.

Misura della transizione 1s−2s dell'atomo di idrogeno

L'atomo di idrogeno è formato da un elettrone e un protone legati dall'attrazione elettrica. Sebbene assente nell'atmosfera terrestre, l'idrogeno costituisce circa il 75% della materia dell'Universo. L'importanza dell'atomo di idrogeno è difficilmente sovrastimata. Da un punto di visto storico, la descrizione dell'atomo di idrogeno e la spiegazione della sua struttura energetica hanno portato alla nascita della meccanica quantistica. Non sorprende dunque che la spettroscopia dell'idrogeno abbia accompagnato e motivato lo sviluppo della fisica quantistica sin dalle sue origini. Nel 1949 Willis E. Lamb misurò una separazione tra i livelli energetici 2p1/2 e 2s1/2 pari a ΔE=h×1024 MHz, in contrasto con la teoria quantistica relativistica di Dirac che prevede un risultato nullo. Questa separazione, ora nota come Lamb shift, mise in evidenza il ruolo delle fluttuazioni del campo elettromagnetico del vuoto, dando l'avvio alla elettrodinamica quantistica.

All'inizio degli anni Settanta, Theodor W. Hänsch e Arthur L. Schawlow all'Università di Stanford misero a punto la tecnica di spettroscopia di saturazione sulla transizione 2s−3s dell'idrogeno, detta Balmer-α. Questa tecnica, combinata con l'avvento dei laser negli anni Sessanta, si è rivelata un formidabile strumento di indagine che ha permesso di aumentare la risoluzione e la precisione delle misure di diversi ordini di grandezza. In seguito, ancora alla ricerca di un ulteriore margine di miglioramento sull'accuratezza delle misure spettroscopiche dell'idrogeno, Hänsch e collaboratori hanno sviluppato un sistema di generazione di frequenze laser su tutto lo spettro visibile e vicino infrarosso, direttamente riferite allo standard primario di frequenza, l'orologio al cesio. Questo sistema, detto pettine di frequenze, ha permesso di rivoluzionare le misure dirette di frequenze ottiche e figura tra le motivazioni del premio Nobel per la fisica del 2005 conferito allo stesso Hänsch e a John L. Hall.

La transizione tra lo stato fondamentale, 1s, dell'atomo di idrogeno e il primo eccitato, 2s, avviene per assorbimento di due fotoni a lunghezza d'onda ultravioletta λ=243 nm. Lo stato 2s appartiene a quella categoria di stati eccitati che si dicono metastabili, poiché impiega un tempo lungo sulla scala atomica (vita media pari a 0,12 s) prima di decadere nello stato fondamentale.

Per il principio di indeterminazione di Heinsenberg, l'energia dello stato 2s ha un'indeterminazione inversamente proporzionale alla vita media. Nel caso della transizione 1s−2s questa indeterminazione si traduce in un allargamento naturale della risonanza atomica, pari a 1,3 Hz in frequenza. Questo allargamento costituisce l'ordine di grandezza per la precisione cui mirare nella misura della frequenza di transizione.

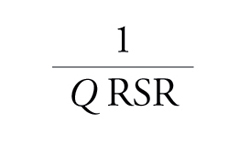

Vale qui la pena notare che siamo di fronte a una caratteristica ricorrente per le misure di tempo e frequenza, eseguite mediante oscillatori (meccanici, elettrici, atomici...): la precisione aumenta con la stabilità della frequenza - o equivalentemente del periodo - dell'oscillazione. Nel caso di un oscillatore a frequenza ν0 e di larghezza Δν, si definisce fattore di merito il rapporto Q=ν0/Δν. La precisione relativa con cui si può misurare la frequenza ν0 è data da

[7] formula

dove RSR indica il rapporto tra segnale oscillante osservato e rumore.

Nella pratica sperimentale, per trarre vantaggio dell'alto fattore di merito delle risonanze atomiche, occorre disporre di laser con larghezze di riga altrettanto strette. Attualmente, le tecniche di stabilizzazione in frequenza dei laser permettono di raggiungere larghezze di riga inferiori a 1 Hz.

La transizione 1s−2s dell'atomo di idrogeno avviene in una camera da vuoto, in cui gli atomi si muovono in un fascio, dopo essere stati prodotti per dissociazione dell'idrogeno molecolare e raffreddati per collisione con una parete a 6 K. Due fasci laser a 243 nm propagano lungo la direzione di volo degli atomi, uno con verso concorde, l'altro con verso opposto. La transizione 1s−2s avviene durante il volo degli atomi, per assorbimento di un fotone da un fascio laser e di un fotone dall'altro fascio laser. Seguitando nel loro volo, gli atomi raggiungono la regione di rivelazione, in cui il livello metastabile 2s viene convertito, almeno parzialmente, nello stato 2p che decade in 1,6 ns emettendo un singolo fotone a 121,6 nm, rivelato con alta efficienza da un fotomoltiplicatore. Il numero di atomi nello stato 2s viene monitorato al variare della frequenza del laser eccitante, ottenendo una curva di risonanza che picca intorno alla frequenza di transizione.

In questa misura la principale limitazione all'incertezza sperimentale relativa di 1,8∙10−14 origina dalle caratteristiche dell'interazione tra atomi e laser di eccitazione. Anzitutto, come in tutte le misure di spettroscopia, occorre tener presente il moto degli atomi. La teoria della relatività di Einstein prescrive che, nel sistema di riferimento di un atomo in moto con velocità v rispetto al laboratorio, la frequenza f0 della radiazione elettromagnetica, e quindi anche della luce laser, sia proporzionale ma diversa dalla frequenza della medesima radiazione nel sistema di riferimento del laboratorio fL: f0=fL(1−βcosθ)/(1−β2), dove β=v/c, c è la velocità della luce e θ indica l'angolo sotteso dalle direzioni di moto dell'atomo e la direzione di propagazione della radiazione elettromagnetica. Lo spostamento di frequenza (effetto Doppler), nella spettroscopia a due fotoni si cancella all'ordine più basso, ovvero nei termini lineari in β di entità uguale e opposta per i due fotoni assorbiti da direzioni opposte. L'effetto Doppler residuo causa comunque uno spostamento della frequenza misurata dell'ordine del kHz, che viene ulteriormente ridotto selezionando gli atomi più lenti e, in ultima analisi, corretto mediante una modellizzazione della forma di riga. Tra le rimanenti cause di incertezza sistematica, vi è lo spostamento dei livelli causati da un campo elettrico e dalle collisioni con il gas residuo nella camera da vuoto.

Indubbiamente, l'aspetto più difficile è la misura della frequenza del laser, a 1,2 PHz (1PHz=1015Hz), da confrontare con quella del campione al cesio a 9,2 GHz, ovvero oltre 100.000 volte inferiore. Prima del 1999, tale misura richiedeva una catena di frequenze dedicata, comprendente oltre dieci laser a frequenze diverse, di cui occorreva controllare costantemente la fase relativa di oscillazione. Le catene di frequenze richiedevano impegno tecnologico e costi tali da restringere le misure dirette di frequenza, riferite allo standard primario, a un esiguo numero di laboratori. Inoltre, ogni catena si adattava alla misura di una sola frequenza ottica. Il pettine di frequenze, misurando con un unico laser e con maggior accuratezza qualsiasi frequenza nello spettro visibile e infrarosso, ha allargato enormemente l'accesso alle misure dirette di frequenza. I contorni dell'impatto sulla metrologia e sulla fisica, sia applicata sia fondamentale, sono ancora incerti ma prefigurano possibilità finora impensabili.

Bibliografia

Brandt 1998: Brandt, Siegmund, Data analysis: statistical and computational methods for scientists and engineers, 3. ed., Springer, Berlin, 1998.

Mohr, Taylor 2005: Mohr, Peter J. - Taylor, Barry N., CODATA recommended values of the fundamental physical constants: 2002, "Review of modern physics", 77, 2005, pp. 1-107.

Taylor, Kuyatt 1994: Taylor, Barry N. - Kuyatt, Chris E., Guidelines for evaluating and expressing the uncertainty of NIST measurements results, "NIST technical note 1297", 1994.