Telecomunicazioni

Telecomunicazioni

(App. II, ii, p. 952; III, ii, p. 907; IV, iii, p. 589; V, v, p. 411)

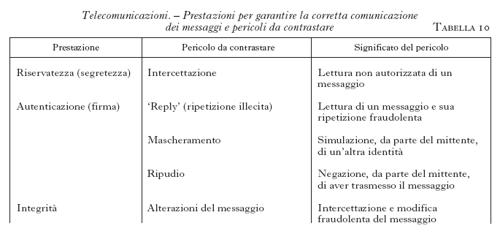

Il campo delle t. è caratterizzato da fasi di ampio sviluppo e di profondo rinnovamento. L'esigenza di realizzare sistemi di trasmissione multicanale, con tecnica di multiplazione analogica, ha reso dominante, negli anni Quaranta e Cinquanta, la ricerca nel settore dei mezzi e dei sistemi trasmissivi a larga banda (cavi coassiali, guide d'onda, ponti radio), anche se, già a quell'epoca, erano progettati, e realizzati in via sperimentale, i primi sistemi di trasmissione numerica con modulazione a codice di impulsi, PCM (Pulse Code Modulation). Tuttavia, solo a partire dagli anni Sessanta, con lo sviluppo dell'elettronica integrata e dei satelliti per t., le tecniche numeriche si sono via via affermate, dando luogo a un profondo rinnovamento in tutto il settore e alla nascita di nuove infrastrutture e servizi. All'inizio degli anni Ottanta, accanto a tecniche di trasmissione analogica ben consolidate (in linea aerea, in cavo coassiale, in ponte radio o via satellite), venivano sviluppati sistemi numerici innovativi e tecnologicamente evoluti. Molto promettenti erano considerati la tecnologia delle trasmissioni in fibra ottica, allora non del tutto matura, e il servizio di videotelefono, pensato come sistema in grado di rivoluzionare la telefonia commerciale. È noto che, in seguito, solo la prima previsione si è pienamente avverata. Nei primi anni Novanta sono stati sviluppati sistemi in grado di convogliare grandi quantità di informazioni numeriche integrate (fonia, dati, immagini) su canali trasmissivi a larghissima banda, utilizzando come supporti i collegamenti in fibra ottica, in ponte radio e via satellite. Sulla base di tali premesse, alla fine del millennio, si è assistito all'esplodere di un vasto insieme di servizi di grande impatto sull'utenza, sostenuti da tecnologie e sistemi che verranno trattati in questa voce. Accanto ai collegamenti fissi sono ormai largamente diffusi i vari tipi di sistemi radiomobili (telefonia cellulare), che hanno rivoluzionato le t. personali e creato nuove possibilità di accesso alla rete; la trasmissione a larghissima banda è supportata da una consolidata tecnologia in fibra ottica per trasmissioni a breve, media, lunga e lunghissima distanza, e (specialmente per le comunicazioni con mezzi mobili e la diffusione diretta all'utente) da satelliti artificiali singoli o in costellazioni. L'elevata capacità trasmissiva delle fibre ottiche e dei satelliti per t. rende possibile un'ampia gamma di nuove applicazioni e servizi. L'evoluzione delle tecniche di codifica ha reso attuale l'integrazione di informazioni di natura diversa, specialmente mediante i sistemi di gestione integrata di ipertesti (accessibili all'utente mediante la rete Internet), spesso di natura multimediale, grazie anche all'evoluzione delle tecniche numeriche di elaborazione e compressione dei testi, dei suoni, delle immagini e delle loro sequenze. Per ultimo, le tecniche di crittografia appaiono ancora più cruciali al fine di garantire la riservatezza, l'autenticazione e l'integrità delle informazioni trasmesse che richiedono sempre più spesso, con il diffondersi del commercio elettronico, condizioni di sicurezza per l'utente. *

Sviluppo e tendenza delle telecomunicazioni

di Gaspare Galati, Maurizio Naldi

L'inizio del nuovo millennio vede un notevole sviluppo delle t., accompagnato da importanti riflessi economici e politico-sociali. Ricorre frequentemente il concetto di società dell'informazione globale, come risultato dell'integrazione di infrastrutture di t. (reti), sistemi di elaborazione dati (calcolatori), sorgenti di informazione (editoria, cinema, pubblicità). Altrettanto frequenti sono le parole chiave multimedialità (integrazione di testi, suoni, immagini, dati); digitalizzazione (rappresentazione ed elaborazione dei segnali in forma numerica); liberalizzazione (dell'offerta dei servizi di t.) e conseguente competizione; autostrade dell'informazione (sistemi a elevatissima capacità di trasporto dell'informazione con diffusione capillare); globalizzazione (dei mercati e del lavoro). Il settore industriale relativo, derivante dalla fusione dei comparti informatico e delle t., viene denominato Information and communications technology e vale globalmente più di 1400 miliardi di dollari (60.000 miliardi di lire per l'Italia). Oltre la metà di questo mercato è legata allo sviluppo di servizi e apparati di t., con una domanda sempre più spinta dal mercato. Per il 2000 il mercato mondiale delle t. è stimato superiore ai 1000 miliardi di dollari, dei quali il 20% per gli apparati e l'80% per i servizi. I servizi possono essere distinti in servizi utente-utente (che comprendono tra gli altri la telefonia, la videoconferenza, la posta elettronica) e servizi utente-server (in cui rientrano il video-on-demand, cioè l'invio di un filmato richiesto dall'utente mediante consultazione di un catalogo, e la navigazione su Internet, per cui si rimanda alla voce rete: Reti telematiche, in questa Appendice).

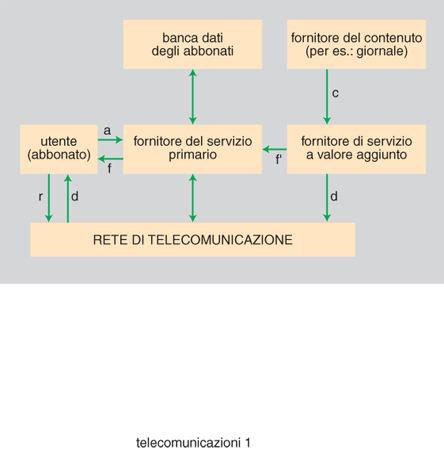

Si assiste alla nascita di nuovi servizi erogati attraverso la rete di t. secondo un modello che evolve verso lo schema di fig. 1, nel quale è mostrato a titolo di esempio il caso di un utente interessato a particolari classi di notizie comparse sulla stampa quotidiana, che vengono selezionate da un'apposita agenzia (il 'fornitore di servizi a valore aggiunto') ed erogate da un 'fornitore del servizio primario' che emette un'unica fattura verso l'utente e, a sua volta, utilizza la rete di t. pagando il corrispettivo al gestore della rete. Tale modello costituisce l'evoluzione dei modelli attuali nei quali il fornitore del servizio e il gestore della rete spesso coincidono.

Dal punto di vista tecnologico sono in atto due processi convergenti: da un lato, i progressi compiuti negli algoritmi di codifica del segnale (in particolare di quello video) hanno fortemente ridotto la necessità di risorse trasmissive a parità di quantità di informazioni trasmesse; dall'altro, la capacità dei sistemi trasmissivi (banda) è stata notevolmente incrementata sia nella tratta di accesso alla rete di t. sia sulle lunghe distanze (mediante satelliti e cavi sottomarini). Si suole indicare come canali a banda stretta quelli con capacità trasmissiva non superiore a qualche centinaio di kbit/s e come canali a banda larga quelli con capacità superiore a 2 Mbit/s.

Un'altra tendenza fondamentale è quella della mobilità dell'utente, il quale può comunicare con altri utenti o accedere a banche dati spostandosi al contempo su aree vaste anche come continenti. Si distingue, al riguardo, tra mobilità di accesso, mobilità del terminale, mobilità personale. Nella mobilità di accesso l'utente ha una limitata capacità di movimento nelle vicinanze di un punto di accesso alla rete di t.; la mobilità del terminale consente invece di accedere a una rete di t. mentre si è in movimento anche su aree vaste. Infine, per mobilità personale si intende la possibilità di accedere ai servizi di t. mediante un terminale diverso dal proprio, il quale viene personalizzato anche per brevi periodi mediante un identificatore personale.

Sistemi di distribuzione su cavo

Il collegamento finale di lunghezza fino a uno-due chilometri tra la rete di t. e l'utente, detto ultimo miglio, costituisce ancora la parte preponderante degli investimenti nelle infrastrutture di t.; su di esso le fibre ottiche sono tuttora scarsamente impiegate, a causa dell'elevato costo di installazione. Le tecniche trasmissive tradizionali, impieganti la coppia di fili, o doppino (twisted pair), in rame, non permettono però il raggiungimento di velocità trasmissive adeguate per la fornitura di servizi a banda larga (sia dati sia video). Per poter sfruttare ancora l'enorme investimento costituito dalla capillare rete di distribuzione in rame (la previsione per il 2000 è di 900 milioni di linee di accesso in rame nel mondo) sono state messe a punto tecniche che permettono di elevare la velocità fino a parecchi milioni di bit al secondo (Mbit/s). Le più diffuse sono la tecnica ADSL (Asymmetric Digital Subscriber Line, "linea numerica d'utente a velocità asimmetrica") e quella VDSL (Very high rate Digital Subscriber Line, "linea numerica d'utente a velocità molto elevata"). I moderni mo-demodulatori (modem) consentono, sulle attuali linee in rame, di trasmettere con velocità fino a 56 kbit/s (standard ITU V. 90).

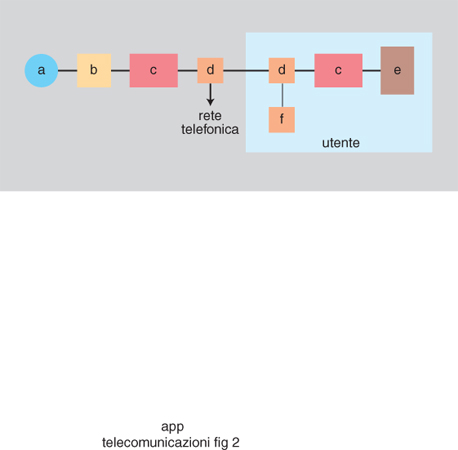

A partire dall'ultima centrale di commutazione, la distribuzione del segnale verso l'utente avviene mediante un primo tratto di fibra ottica, che connette la centrale con un sistema di distribuzione intermedio denominato ONU (Optical Network Unit), e un tratto finale in rame (fig. 2). In corrispondenza alla ONU il segnale ottico viene trasformato in elettrico e trasmesso mediante il sistema ADSL o VDSL. Sul tratto in rame (doppino di utente) il segnale telefonico viene trasportato assieme a segnali di altra natura (per es., audio e video), dai quali viene separato mediante un opportuno dispositivo.

Il punto di demarcazione fra il tratto in fibra ottica e quello in rame può essere posizionato più o meno vicino all'utente finale. Si distingue tra FTTH (Fiber To The Home), se il collegamento verso l'utente è realizzato interamente in fibra ottica, FTTB (Fiber To The Building), se la fibra ottica arriva fino allo scantinato dell'abitazione, FTTC (Fiber To The Curb), se l'armadio di distribuzione da cui parte il tratto in rame è posizionato sul marciapiede.

La tecnica ADSL deve il suo nome all'asimmetria delle velocità massime raggiungibili nei due versi (utente-rete e rete-utente). Per i nuovi servizi di t. (Internet, distribuzione di video) la quantità di informazioni che l'utente preleva dalla rete è in genere anche molto maggiore di quella che egli stesso invia. Su distanze brevi (inferiori a 2,5 km) la ADSL permette una velocità massima di 9 Mbit/s nella direzione dalla rete verso l'utente (downstream), e di 1 Mbit/s nella direzione opposta (upstream). La velocità massima diminuisce rapidamente con la distanza riducendosi a 1,5 Mbit/s nella direzione downstream su distanze di 5,5 km.

La separazione del segnale telefonico dagli altri segnali è resa possibile dall'impiego della multiplazione a divisione di frequenza. Infatti la gamma di frequenze impiegata, che va da 0 a 1,1 MHz, è divisa in due gamme: la gamma bassa (0÷4 kHz) è utilizzata per il segnale telefonico; la gamma alta (24 kHz÷1,1 MHz) è destinata agli altri segnali. L'interposizione di una fascia di 20 kHz tra le due gamme permette di ridurre notevolmente i fenomeni di interferenza. La gamma alta è suddivisa a sua volta in 249 canali di 4 kHz ciascuno; la capacità massima di ogni canale è di 30 kbit/s ed è variata in ciascun canale in modo automatico secondo l'effettiva qualità del mezzo trasmissivo. Nella gamma alta vengono trasmessi sia il segnale verso l'utente sia quello di ritorno. Più precisamente, i primi 34 canali (occupanti complessivamente una banda di 136 kHz) possono essere condivisi dai due segnali oppure dedicati al solo segnale di ritorno. I rimanenti 215 canali sono invece sempre dedicati al segnale verso l'utente.

In Italia la tecnica ADSL è stata introdotta in via sperimentale e non tutte le linee di utente sono compatibili con essa; negli Stati Uniti si è stimata intorno al 70% la percentuale di linee residenziali compatibili; per semplificare la tecnologia ADSL, per incrementare il numero di abitazioni che possono essere connesse e permettere anche una distribuzione all'interno dell'abitazione sfruttandone il cablaggio, è stata proposta nel 1998 una variante con minore capacità, dell'ordine di 500 kbit/s. L'esistenza di tecnologie alternative e la grande variabilità della qualità del doppino di utente (local loop) rendono difficili le previsioni sul futuro sviluppo commerciale della tecnologia ADSL.

La tecnica VDSL, di impiego analogo alla ADSL, è ancora più avanzata. Per separare il segnale telefonico dal resto viene ancora utilizzata la tecnica a multiplazione di frequenza, riservando al primo la banda da 0 a 4 kHz. Il segnale dall'utente verso la rete dovrebbe occupare la banda da 300 a 700 kHz, mentre quello verso l'utente dovrebbe essere sopra i 1000 kHz. Nella direzione verso l'utente la massima velocità consentita supererà di poco i 50 Mbit/s; nella direzione opposta il limite raggiunto alla fine degli anni Novanta è di 2,3 Mbit/s (è prevista però la possibilità di raggiungere le stesse velocità della direzione verso l'utente).

Sistemi radiomobili

Le t. mediante terminali mobili (detti telefoni cellulari o telefonini) hanno avuto negli anni Novanta un notevole sviluppo. Il numero di abbonati a servizi di t. mobili ha raggiunto, all'inizio del 1999, i 22,5 milioni in Italia, 280 milioni nel mondo, di cui 82 milioni nell'Unione Europea. In Europa la penetrazione è salita a oltre 30 linee mobili per 100 abitanti, con un tasso di crescita annua del 55%, e oltre 60 operatori. Nel 1999 in Italia erano presenti quattro operatori: TIM, Omnitel, WIND e Blutel.

Si distingue tra sistemi cordless (o CT, Cordless Telephony), in cui la mobilità è limitata all'ambito domestico o al più urbano, chiamati anche sistemi a bassa mobilità, e sistemi cellulari su larga scala, che consentono spostamenti sull'intero territorio nazionale o anche all'estero. In entrambi i casi il territorio coperto dal sistema è suddiviso in aree di servizio elementari dette celle.

Le celle satellitari per aree prive di infrastrutture a terra hanno diametri di dimensioni tipiche da 500 a 1000 km; le macrocelle con raggio fino a circa 35 km servono tipicamente aree rurali; le celle dell'ordine delle centinaia di metri per aree urbane ad alta densità sono dette microcelle; quelle dell'ordine delle decine di metri, usate all'interno di edifici industriali e commerciali, sono dette picocelle.

Nel caso più semplice del sistema cordless domestico la cella è costituita dalla propria abitazione e la mobilità dell'utente al di fuori di essa non è possibile. Negli altri casi la mobilità da una cella a un'altra adiacente è invece possibile, e il trasferimento tra le due celle viene denominato handover. Se è possibile continuare a usufruire del servizio anche quando ci si sposta all'interno di reti gestite da operatori diversi da quello con cui si è sottoscritto l'abbonamento, si parla di roaming.

La standardizzazione dei sistemi radiomobili è proceduta secondo varie strade, fino alla realizzazione di più sistemi, spesso diffusi solo su base nazionale e non compatibili tra di loro. La tendenza è ora quella dello sviluppo di standard diffusi su base almeno continentale e di terminali capaci di operare con più sistemi, per es. con due (terminali dual-standard o dual-band). Sono in fase di sviluppo terminali capaci di operare su più bande e in più modalità (v. oltre), basati su un hardware di base controllato da software (software radio).

I primi esempi di servizio radiomobile terrestre commerciale si sono avuti negli USA subito dopo la Seconda guerra mondiale con sistemi operanti nelle gamme delle onde corte e ultracorte (sotto i 300 MHz) con attivazione manuale della connessione. A questi sono seguiti negli anni Sessanta i primi sistemi automatici, operanti sopra i 300 MHz e caratterizzati da un numero di canali limitato a 20÷40, dall'assenza di handover e da aree di servizio di grandi dimensioni (20÷30 km di raggio); in questi sistemi era comunque ancora necessario conoscere la posizione dell'utente chiamato. Con l'introduzione della copertura cellulare si sono imposti nella seconda metà degli anni Settanta i sistemi di seconda generazione, caratterizzati da un numero elevato di canali radio (circa 200 a 450 MHz e 1000 a 900 MHz), dalla possibilità di handover e dall'aggiornamento automatico della localizzazione d'utente. Il primo di questi sistemi è stato il NMT (Nordic Mobile Telephone), introdotto commercialmente nel 1981 e largamente diffuso nei paesi del Nord Europa. Altri sistemi molto noti sono il TACS (Total Access Communication System), diffuso in Europa, e l'AMPS (Advanced Mobile Phone Service), operante negli USA. La copertura di questi sistemi è nazionale.

In Italia il primo sistema radiomobile cellulare è stato il RTMS (Radio Telephone Mobile Service), introdotto nel 1985; nello stesso anno è stato introdotto il TACS, che ha raggiunto i 4 milioni di utenti alla fine del 1996 ed era ancora in uso all'inizio del 2000. Lo sviluppo dei sistemi numerici ha portato all'adozione del GSM (Global System for Mobile communications), del DECT (Digital Enhanced Cordless Telecommunications) e del GSM-1800 (v. oltre).

Nei sistemi cordless il collegamento tra l'utente e la rete fissa è garantito da una stazione base di ridotte dimensioni. Le frequenze di questi sistemi sono in genere nelle gamme dei 900 MHz e dei 1800 MHz.

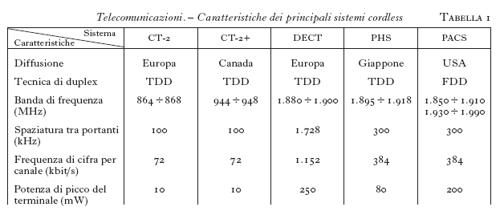

Il trasferimento del segnale tra l'utente e la stazione radio base può avvenire con due tecniche, basate rispettivamente sulla divisione di tempo (TDD, Time Division Duplexing, adottata nella maggior parte dei sistemi) o sulla divisione di frequenza (FDD, Frequency Division Duplexing). Nella tecnica TDD la trasmissione nei due sensi (da utente a stazione radio base e viceversa) avviene in maniera alternata sullo stesso canale radio. Nella tecnica FDD la trasmissione avviene invece simultaneamente nei due sensi, ma su canali radio diversi. Le caratteristiche principali dei sistemi cordless sono riassunte in tab. 1.

In ambito domestico è diffuso il sistema CT-1, con una mobilità limitata ad alcune decine di metri. Nel sistema CT-2, diffuso nel Regno Unito e poi in Europa, la mobilità è estesa fino a coprire l'area cittadina mediante una serie di ripetitori. Non è permesso l'handover.

Tra i sistemi cordless il DECT riscuote i maggiori consensi. Lo standard DECT definisce le modalità di connessione via radio tra due punti, senza includere funzionalità di rete quali commutazione e segnalazione; esso non consente, da solo, la realizzazione di un sistema autonomo e completo, ma può essere impiegato per servizi e applicazioni quali: cordless domestico; centralina privata (PABX, Private Automatic Branch Exchange) senza fili; servizi: per gruppi chiusi di utente, di mobilità al pubblico, supplementari al servizio telefonico; wireless local loop: collegamento radio dell'utente in alternativa al doppino telefonico.

Lo standard DECT prevede l'uso di 10 frequenze portanti nella gamma 1880÷1900 MHz con 12 canali bidirezionali per ogni frequenza, ottenuti mediante accesso multiplo a divisione di tempo; il terminale può quindi accedere a 120 canali e quando è richiesto un collegamento viene scelto il canale che in quel momento e in quel luogo presenta la migliore qualità. La voce è codificata con tecnica ADPCM (Adaptive Differential Pulse Code Modulation) a 32 kbit/s. Nato per l'utilizzo nell'ambito dell'abitazione, il DECT è stato successivamente sviluppato in modo da permetterne l'impiego nell'ambito dell'intero territorio urbano, con una velocità limitata a circa 40 km/h, con possibilità di handover e di roaming. Le celle hanno un diametro variabile da 50 a 600 m (tipicamente tra 100 e 200 m). Oltre che per comunicazioni vocali può essere impiegato anche per la trasmissione dati, con una velocità massima di 256 kbit/s. Nel 1995 è stato realizzato un terminale bimodale DECT/GSM. In Italia il servizio DECT è stato introdotto all'inizio del 1998 da Telecom Italia.

Nel 1982 è cominciata la standardizzazione del sistema radiomobile su larga scala europeo GSM, che permette il roaming internazionale e inoltre, con l'utilizzo di una scheda denominata SIM (Subscriber Identity Module), la personalizzazione del terminale; il suo lancio in Europa è avvenuto dieci anni dopo. Alla fine del 1998 erano attive 320 reti GSM in 118 nazioni, per un totale di 135 milioni di utenti.

La struttura di una rete GSM è illustrata in fig. 3. Essa può essere schematicamente suddivisa in tre blocchi: la rete NSS (Network Sub-System), il sistema radio BSS (Base Station Sub-system) e il sistema di supporto e supervisione OSS (Operation and Support Sub-system). Il collegamento tra la rete fissa e l'utente mobile è garantito da una stazione radio base BTS (Base Transceiver Station), operante nella gamma dei 900 MHz. L'intero territorio è diviso in areole, ognuna delle quali è coperta da una di queste stazioni. Ogni stazione radio base fa capo a un sistema di controllo BSC (Base Station Controller), che si occupa della supervisione e del controllo delle risorse radio e costituisce l'interfaccia verso la centrale di commutazione. Un singolo controllore BSC può gestire diverse stazioni BTS. La tecnica di utilizzo della banda è di tipo duplex: le frequenze di trasmissione e di ricezione dell'utente mobile sono cioè diverse, e precisamente separate di 45 MHz. Per la trasmissione, l'utente mobile opera nella gamma 890÷915 MHz; per la ricezione usa invece la gamma 935÷960 MHz. Ognuna di queste due gamme è a sua volta divisa in 124 canali spaziati di 200 kHz; l'utente mobile occupa di volta in volta uno di questi canali. La voce può essere codificata sia a 13 kbit/s (full-rate) sia a una velocità dimezzata (half-rate). Nel sottosistema di rete la centrale di commutazione MSC (Mobile Switching Centre) si occupa appunto della commutazione telefonica e della gestione delle chiamate, svolgendo le funzioni di interfaccia sia verso il sistema radio sia verso altre centrali di commutazione appartenenti ad altre reti (mobili o fisse). Per la localizzazione e la gestione dell'utente il MSC utilizza il Registro di residenza HLR (Home Location Register) e il Registro ospiti VLR (Visitor Location Register), che contengono i dati che caratterizzano gli abbonati. Più precisamente, HLR contiene i dati relativi agli abbonati della zona di competenza del MSC; VLR contiene i dati degli utenti temporaneamente registrati presso il MSC, ottenuti grazie a un segnale emesso continuamente dal terminale mobile. Per ogni utente sono in particolare registrati la sua identità internazionale IMSI (International Mobile Subscriber Identity), la sua identità temporanea TMSI (Temporary Mobile Subscriber Identity), il suo numero telefonico, le condizioni di abbonamento e l'indirizzo del VLR che lo ospita momentaneamente.

Per verificare la correttezza del comportamento dell'utente sono presenti il sistema di autenticazione AUC (Authentication Centre), che ha il compito di verificare la validità dei diritti di accesso alla rete, e la banca dati dei terminali EIR (Equipment Identity Register), che contiene le matricole dei terminali, uniche a livello mondiale.

Infine, il sottosistema di gestione OSS effettua tutte le funzioni di esercizio e manutenzione tipiche degli impianti di telecomunicazione.

Oltre che per il servizio telefonico, la rete GSM può essere impiegata per l'invio di dati e fax. In particolare è disponibile un servizio Short Message Service che permette lo scambio di messaggi alfanumerici con lunghezza massima di 160 caratteri. Sarà inoltre disponibile il servizio GPRS (General Packet Radio Service), che consentirà la trasmissione di dati alla velocità di 114 kbit/s. Un'evoluzione del GSM (inizialmente denominata DCS-1800) opera nello stesso modo del GSM ma su frequenze più elevate, intorno a 1800 MHz, il che comporta celle di minori dimensioni (raggio massimo dell'ordine di 10 km) più adatte all'uso urbano. Questo consiglia l'uso di terminali dual-band (900 e 1800 MHz) nelle zone ad alta densità di utenti. Il servizio a 1800 MHz, attivato a fine 1997 in quattro paesi europei, è stato introdotto in Italia nel marzo 1999 dalla società WIND. Negli USA e in Canada, il sistema di telefonia mobile numerica, analogo al GSM, è basato sull'Interim Standard IS-136 della TIA (Telecommunication Industry Association) e opera a 800 e a 1900 MHz.

La futura messa in servizio di sistemi per comunicare 'con tutti, sempre, ovunque, in tutte le forme' comporta un notevole sforzo per la definizione di norme internazionali; l'ETSI (European Telecommunications Standards Institute) coordina un programma di ricerca in Europa per lo sviluppo di UMTS (Universal Mobile Telecommunications System). I requisiti alla base di UMTS sono: accesso alle diverse reti in diversi ambienti (edifici, città, aree extraurbane) su tutto il globo mediante un terminale palmare, adattabile e riprogrammabile; elevata capacità di trasmissione dati: 144 kbit/s su veicoli in movimento veloce; 384 kbit/s con movimento lento (pedoni); 2 Mbit/s in ambienti chiusi.

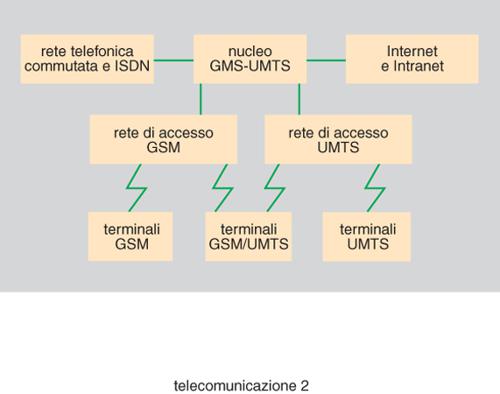

Tali requisiti sono orientati alla fornitura di nuovi servizi multimediali attraverso interconnessione, oltre che con la rete telefonica, con reti a commutazione di pacchetto e con reti Internet/Intranet, come mostrato nella fig. 4; ciò è in linea con il rapidissimo sviluppo di Internet e dei servizi attraverso reti di t., secondo lo schema di fig. 1, al quale i servizi UMTS saranno conformi; nella fig. 4 è mostrato come l'uso di terminali dual-band (GSM e UMTS) consentirà la graduale transizione tra la seconda e la terza generazione di sistemi radiomobili. I primi servizi UMTS sono previsti in Europa nel 2002, con sviluppo su vasta scala dal 2005. Nello stesso quadro la ITU (International Telecommunications Union) ha promosso lo sviluppo di una famiglia di standard per il FPLMTS (Future Personal and Land Mobile Telephone System), poi denominato IMT-2000 (International Mobile Telephone-2000), di cui UMTS fa parte.

Nel 1992 l'Assemblea della ITU, denominata WARC 92 (World Administrative Radio Conference) ha allocato una porzione di spettro attorno ai 2 GHz (da 1920 a 1980 MHz e da 2110 a 2170 MHz) per IMT-2000/UMTS in Europa e Asia.

Riguardo alle modalità di accesso, i principali sforzi di ricerca in ambito IMT-2000 sono orientati verso la tecnica a divisione di codice a banda larga (W-CDMA, Wideband-Code Division Multiple Access).

Con la tecnica CDMA i diversi utenti sono discriminati non mediante l'attribuzione di intervalli di frequenza (porzioni di spettro o 'canali') né di tempo, come avviene rispettivamente per le tecniche FDMA (Frequency Division Multiple Access) e TDMA (Time Division Multiple Access), bensì mediante l'assegnazione a ogni utente di un codice, cioè una chiave che gli permette di ricostruire l'informazione a lui indirizzata; le tecniche CDMA - di origine militare - operano un allargamento spettrale del segnale trasmesso o con variazione pseudocasuale della frequenza portante (Frequency Hopping, FH-CDMA con un gran numero di 'salti' al secondo) oppure mediante moltiplicazione con un codice pseudocasuale (Direct Sequence, DS-CDMA). In entrambi i casi l'ascoltatore non destinatario del messaggio lo percepisce come rumore di fondo (si parla di spread spectrum o di segnali con prodotto larghezza di banda-durata elevato, per es. 100 o 1000, contro il valore circa unitario dei segnali TDMA). Nella tecnica DS-CDMA, utilizzata tra gli altri nello standard statunitense IS-95 di sistemi cellulari, la larghezza spettrale disponibile è utilizzata allargando lo spettro di frequenza del segnale trasmesso mediante moltiplicazione con una sequenza pseudocasuale a banda molto più larga del segnale stesso (tipicamente, di 100÷1000 volte); si assegnano agli utenti dei codici ortogonali o quasi-ortogonali, cioè sequenze aventi mutue correlazioni nulle o quasi. A spese di una maggiore complessità elaborativa, si ottiene un intrinseco controllo di accesso ai soli utenti autorizzati e, cosa importante nei sistemi satellitari, si evita la necessità di sincronizzare le stazioni base.

Wireless local loop

Le tecniche di accesso radio sono utilizzate anche per risolvere il problema dell'ultimo miglio, poiché consentono installazioni rapide senza opere civili. Nel 1998 risultavano installate nel mondo circa 1,8 milioni di linee (su circa 80 milioni di linee totali) con tale tecnologia, e secondo alcune previsioni circa metà delle linee installate nel 2005 potrà essere del tipo WLL (Wireless Local Loop) con un numero di addetti nel settore comparabile con quello dell'industria della telefonia cellulare nel 1998. Tuttavia lo sviluppo della tecnica WLL è ostacolato dalla carenza di allocazioni di frequenza e in generale da carenze normative. Sono utilizzate diverse tecnologie; alcune di esse sono modifiche di tecnologie cellulari, come IS-95 e DECT, altre sono originali. Le attuali tecniche WLL sono 'a banda stretta', fornendo flussi tipici di 32 kbit/s e fino a 128 kbit/s; sono state proposte tecnologie WLL 'a banda larga' con capacità fino a 25 Mbit/s per utente. Un sistema sviluppato in Europa e commercializzato dal 1996 nel Regno Unito utilizza un ponte radio a microonde (nella gamma dei 3,5 GHz) per collegare gli utenti, dotati di una piccola antenna direttiva esterna, con la stazione radio base rispetto alla quale essi distano fino a circa 40 km. Una stazione radio base, grazie alla diversità di frequenza (54 canali) e di tempo, può servire oltre 600 utenti, che salgono a oltre 2000 se viene utilizzata un'antenna a 3 settori. L'utente ha a disposizione un canale vocale a 32 kbit/s e un canale dati a 64 kbit/s, PCM.

Collegamenti in fibra ottica

Nei collegamenti punto-punto e nella rete dorsale la trasmissione in fibra ottica è una scelta naturale. In particolare, oltre che nella rete terrestre, l'utilizzo delle fibre ottiche ha avuto un notevole impulso nei sistemi sottomarini, non solo per i collegamenti intercontinentali (in cui costituisce una valida alternativa ai satelliti) ma anche per quelli su brevi o medie distanze (tra terraferma e isole), laddove l'equivalente collegamento terrestre sia molto più lungo e quindi meno conveniente (per es. tra Italia e Spagna).

Lo sviluppo dei sistemi di trasmissione ottica è dovuto a progressi sia nelle tecnologie costruttive delle fibre ottiche e degli amplificatori sia nelle tecniche trasmissive. Le fibre ottiche oggi impiegate sono del tipo monomodale, operanti in genere a lunghezze d'onda intorno a 1310 e 1550 nm (dette rispettivamente seconda e terza finestra). I due fenomeni che limitano la distanza che può essere coperta con un collegamento in fibra ottica sono l'attenuazione e la dispersione.

L'attenuazione dell'impulso ottico risulta minima intorno a 1550 nm, dove ha valori compresi tra 0,22 e 0,24 dB/km; a 1310 nm il valore è invece circa 0,35 dB/km.

Il fenomeno della dispersione consiste invece nell'allargamento dell'impulso ottico durante l'attraversamento della fibra. In presenza di velocità di cifra elevate questo allargamento può comportare una sovrapposizione degli impulsi adiacenti e una maggiore probabilità di errore nel recupero dell'informazione trasmessa. Si distingue tra due tipi di dispersione, dovuti a cause diverse: dispersione cromatica e dispersione di polarizzazione. La prima è dovuta alla dipendenza del tempo di propagazione lungo la fibra dalla lunghezza d'onda: l'impulso ottico emesso è infatti costituito da più lunghezze d'onda, e poiché lunghezze d'onda diverse hanno tempi di propagazione diversi, le varie componenti dell'impulso arrivano in tempi diversi al termine della fibra. Pertanto la dispersione cromatica è legata alla larghezza spettrale dell'impulso trasmesso (espressa in nanometri) e alla lunghezza del collegamento. La larghezza temporale dell'impulso ricevuto è proporzionale al prodotto della larghezza spettrale dell'impulso trasmesso per la lunghezza del tratto di fibra. Il coefficiente di proporzionalità, detto coefficiente di dispersione cromatica, ha valori generalmente compresi tra 1 e 20 ps/nm/km (il valore più basso corrisponde alle cosiddette fibre a bassa dispersione operanti in terza finestra).

L'allargamento dovuto alla dispersione di polarizzazione (fenomeno più complesso della dispersione cromatica) cresce invece con la radice quadrata della distanza; il coefficiente di proporzionalità varia tipicamente da 0,1 a 0,5 ps/km¹/². La dispersione di polarizzazione ha acquisito un'importanza sempre maggiore per il progressivo aumento della velocità di trasmissione numerica; essa è infatti rilevante per velocità superiori a 2,5 Gbit/s e su distanze superiori a 100 km. Una differenza importante tra le due dispersioni è che, mentre la dispersione cromatica è un fenomeno deterministico e può essere compensata, la dispersione di polarizzazione è un fenomeno aleatorio di difficile rimedio.

Un altro motivo di progresso nei sistemi di comunicazione ottica è l'inserimento degli amplificatori ottici. Il collegamento ottico prevedeva in passato l'inserimento, a cadenze regolari, di rigeneratori, che provvedevano a convertire l'impulso ottico in elettrico, ricostruire la forma d'onda eliminando l'effetto del rumore, e riemettere un impulso ottico non affetto da distorsioni. Recentemente i rigeneratori sono stati sostituiti da amplificatori che operano direttamente sul segnale ottico, senza necessità della conversione ottico-elettrica e viceversa. Questi amplificatori fanno uso di spezzoni di fibra drogati con erbio e sono quindi denominati amplificatori a fibra attiva drogata con erbio (EDFA, Erbium-Doped Fibre Amplifier) e, contrariamente ai rigeneratori, permettono l'amplificazione di tutti i flussi ottici collocati all'interno della loro banda passante, qualunque sia la velocità e il formato di modulazione. La loro introduzione ha permesso di aumentare il passo di ripetizione, diminuendo il numero di apparati inseriti lungo un determinato collegamento, con aumento dell'affidabilità complessiva.

La potenza d'uscita di un EDFA è tipicamente compresa tra 10 e 50 mW. La sua larghezza di banda, in lunghezze d'onda, è compresa tra 30 e 50 nm, a cui corrisponde una banda passante da 3 a 6 THz, che ne rende ottimale l'impiego in sistemi multicanale.

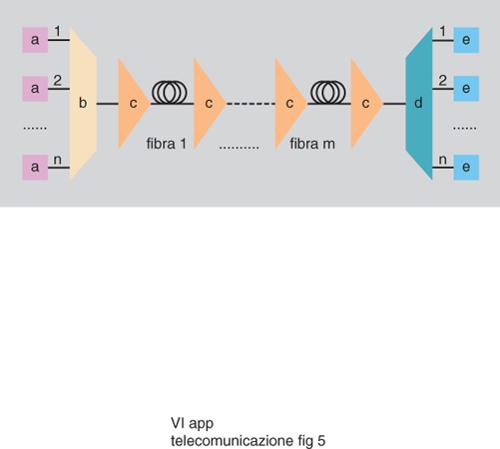

Tra le tecniche di trasmissione su fibra ottica, alla multiplazione a divisione di tempo (TDM, Time Division Multiplexing; v. telecomunicazioni, App. V) si è aggiunta una nuova tecnica denominata multiplazione a divisione di lunghezza d'onda (WDM, Wavelength Division Multiplexing). Tale tecnica permette di trasmettere sulla stessa fibra ottica un insieme di canali caratterizzati da lunghezze d'onda portanti diverse; essa è l'analogo in campo ottico della multiplazione a divisione di frequenza (FDM, Frequency Division Multiplexing). Lo schema di principio di un sistema WDM è riportato in fig. 5: i diversi tributari ottici operanti su lunghezze d'onda diverse vengono multiplati su una fibra ottica interrotta periodicamente dall'inserimento di amplificatori ottici (EDFA); all'arrivo i tributari ottici vengono separati con un apparato di demultiplazione. La spaziatura minima tra due canali in un sistema WDM è di circa 100 GHz (che corrispondono, alla lunghezza d'onda di 1550 nm, a un intervallo di 0,8 nm). Il numero massimo di canali allocabili su una fibra ottica è attualmente circa 40.

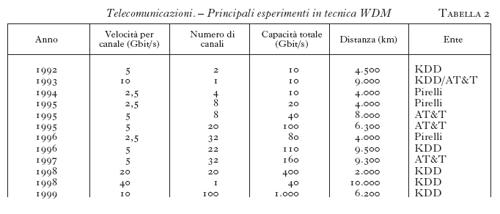

La tecnica WDM è già stata oggetto di numerosi esperimenti, che ne hanno confermato i notevoli vantaggi (tab. 2).

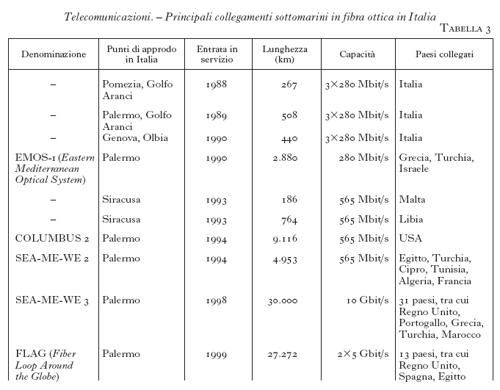

Per quanto riguarda i sistemi in funzione, i più avanzati operano in tecnica TDM alle velocità di cifra di 2,5 e 5 Gbit/s; tra gli esempi più importanti figurano il sistema TAT-13 (Trans-Atlantic Trunk) e il sistema TPC-5 (Trans-Pacific Cable). I più importanti sistemi a cui è collegata l'Italia sono riportati in tab. 3. Dal 1999 sono operativi i primi sistemi WDM. Nell'agosto 1999 è iniziato il servizio commerciale sul sistema sottomarino SEA-ME-WE-3 (South East Asia-Middle East-Western Europe), che utilizza 4 canali (per una capacità totale di 10 Gbit/s, incrementabile fino a 20 Gbit/s) per collegare il Regno Unito all'Indonesia attraverso Mediterraneo, Mar Rosso e Oceano Indiano. Il primo collegamento sottomarino al mondo in tecnica WDM è stato però realizzato in campo nazionale tra Roma e Palermo con capacità totale di 5 Gbit/s, ottenuta mediante la multiplazione di due canali a 2,5 Gbit/s.

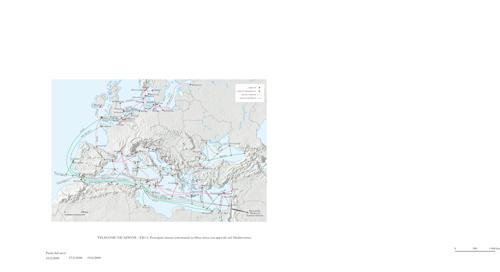

In fig. 6 sono riportati i percorsi dei principali sistemi sottomarini con approdi nel Mediterraneo.

Telecomunicazioni via satellite

Pur nel grande sviluppo della trasmissione ad altissima capacità e grande/media distanza su fibra ottica, della trasmissione ad alta capacità per breve/brevissima distanza su doppino telefonico e infine dei sistemi cellulari terrestri, lo sviluppo delle t. satellitari, anch'esso collegato allo sviluppo della rete pubblica in una rete numerica, universale, multiuso, globale, integrata, è di crescente importanza per: i collegamenti con mezzi mobili, specie nelle aree desertiche e oceaniche (per es. aeromobili su rotte oceaniche e navi in mare aperto); la diffusione televisiva e radiofonica di alta e altissima qualità; le regioni in via di sviluppo e le aree a bassa densità di popolazione; i collegamenti a breve durata e la diffusione a un gruppo chiuso di utenti.

In tali domini i satelliti consentono (non solo per le grandi distanze intercontinentali ma anche su scala continentale o regionale) una rapida attivazione dei servizi, e la possibilità di servire molti terminali terrestri e distribuire il traffico in maniera flessibile.

Le stime indicano che nel primo decennio del nuovo millennio potranno essere in orbita 2000 satelliti per t., di cui circa 1000, principalmente in orbita bassa o media, per il servizio mobile (per il quale sono state proposte ben 14 costellazioni).

Una spinta a tale sviluppo è anche la crescita di Internet (100 milioni di utenti alla fine del 1998, con raddoppio ogni 12÷15 mesi), i cui servizi (World Wide Web, Telnet, videoconferenze/telefonia ecc.) possono trarre beneficio dalla trasmissione satellitare, con capacità maggiore del normale canale telefonico (v. rete, e anche multimedialità, in questa Appendice).

Una recente applicazione che nasce dalla diffusione diretta da satellite è l'accesso veloce a Internet: con un costo modesto l'utente Internet, già da fine 1996, può attrezzarsi con un kit costituito da un'antenna parabolica da 50 cm con ricevitore, una scheda da inserire nel proprio PC e il relativo software; la richiesta di accesso alle informazioni (suoni o immagini di elevata qualità sotto forma di file di grandi dimensioni) è inoltrata 'a bassa velocità' (decine di kbit/s) sui canali usuali (via rete telefonica mediante modem oppure ISDN, Integrated Services Digital Network) dall'utente verso il fornitore dei servizi, mentre le informazioni richieste pervengono via satellite all'utente con velocità assai maggiore (400 kbit/s). Il servizio è fornito mediante satelliti in banda Ku (v. oltre).

L'evoluzione tecnologica delle t. satellitari si basa su quasi 40 anni di ricerca e sviluppo con progressi in aree quali i metodi di modulazione ed elaborazione a bordo, l'analisi delle interferenze e dei problemi propagativi, e relative contromisure, il progetto e la valutazione delle costellazioni, le tecniche di antenne multifascio e di commutazione dei fasci (v. anche satelliti artificiali: Satelliti per telecomunicazioni, App. V).

Il primo satellite attivo, il Telstar - che permise il primo collegamento televisivo sperimentale transoceanico -, fu posto in orbita ellittica nel 1962 e seguito dal Relay i e, nel 1963, dal Telstar ii e dai primi satelliti della serie Syncom, geosincrono il Syncom ii (1963) e geostazionario il Syncom iii (1964). In quegli anni furono attivati i primi collegamenti televisivi tra l'Europa e gli Stati Uniti e, nel 1965, i servizi commerciali transoceanici di telefonia fissa e di televisione, forniti dal luglio 1965 dal consorzio INTELSAT con il satellite Early Bird. La tecnica che rese possibili i primi collegamenti a distanze transoceaniche è quella in cui il satellite viene visto dal sistema di t. come un tubo piegato (bent pipe) che permette al segnale di superare gli ostacoli e la curvatura terrestre mediante transponders (ripetitori, trasponditori) detti trasparenti: il segnale trasmesso dalla stazione di terra al satellite viene captato dall'antenna ricevente, amplificato a basso livello con eventuale conversione a una frequenza intermedia, trasferito sulla banda della tratta in discesa, amplificato ad alto livello con un amplificatore a tubo (TWTA, Traveling Wave Tube Amplifier) o a transistor e trasmesso verso la stazione ricevente a terra; in tali satelliti, a parte le ovvie differenze di frequenza e di potenza, le caratteristiche dei segnali, in particolare la modulazione, restano le stesse nelle due tratte in salita e in discesa, per cui in linea di principio è possibile, da parte di più stazioni di terra, l'accesso multiplo nel campo delle frequenze (FDMA), del tempo (TDMA) o mediante codice (CDMA).

Le prime bande di frequenza utilizzate furono la banda C (4 GHz nominali in downlink - discesa dal satellite - e 6 GHz nominali in uplink - salita), praticamente insensibile ai fenomeni atmosferici, e la banda Ku (11 GHz nominali in discesa e 14 GHz nominali in salita). Esse sono tuttora le più usate insieme alla banda L (intorno a 1,6 GHz), impiegata per le comunicazioni con mezzi mobili: un esempio è il satellite italiano ITALSAT F2, lanciato nel 1996 e posizionato in orbita geostazionaria a 13,2° E, dotato di un transponder nella banda L (uplink: 1646,5÷1660,5 MHz; downlink: 1545,0÷1559,0 MHz) per il collegamento della stazione di terra del Lario con mezzi mobili, con copertura dell'Europa e del Nord Africa; sono possibili collegamenti in fonia e trasmissione fax e dati.

La necessità di una crescente larghezza di banda spinge all'uso di frequenze sempre maggiori, in particolare nelle gamme dei 20/30 GHz (banda Ka) e, in prospettiva, superiori (banda millimetrica dei 40/50 GHz, detta anche banda V), per le quali è assai rilevante, e oggetto di numerosi studi, l'attenuazione dovuta a fenomeni atmosferici quali la pioggia.

L'uso mediante satellite di porzioni di spettro nella banda V ha avuto negli ultimi anni sempre maggior rilievo, anche se è probabile che l'uso commerciale di questa banda vedrà la luce ben oltre la fine del 20° secolo. Sono noti gli esperimenti con i satelliti ETS ii e CS (giapponesi, tra la fine degli anni Settanta e l'inizio degli anni Ottanta), OLYMPUS (europeo, 1988), ITALSAT (italiano, 1991), ACTS (statunitense, 1993) e, più recentemente, con il satellite giapponese geostazionario COMETS (Communications and Broadcasting Engineering Test Satellite), lanciato nel 1997, che, durante il suo funzionamento, permetterà la sperimentazione di: a) diffusione di TV ad alta definizione (HDTV) con 2 fasci sulla frequenza di 20,7 GHz, potenza efficace irradiata (EIRP, Effective Isotropically Radiated Power) di 64 dBw; b) comunicazioni mobili con due fasci, alle frequenze di 30,8/21,0 GHz con EIRP di 58,4 dBw; c) comunicazioni mobili in gamma millimetrica con un fascio, alle frequenze di 46,9/43,8 GHz con EIRP di 61,4 dBw.

I satelliti in banda Ka sono ormai una realtà operativa, con 450 richieste di registrazione (statisticamente, a poco meno del 50% di esse segue il lancio del satellite) nel periodo 1983-96. Notevole è la costellazione di 12 satelliti geostazionari in banda Ka denominata Voicespan (proposta dalla Voicespan Digital Satellite Services della AT&T per fonia, fax, posta elettronica e comunicazioni tra PC), da lanciare tra il 2000 e il 2002.

La crescente richiesta di accesso veloce a Internet e di comunicazioni multimediali ha stimolato il progetto di diversi sistemi satellitari a ciò dedicati; tra quelli utilizzanti l'orbita geostazionaria, il sistema Spaceway della Hughes intende fornire accesso a reti (Internet, reti metropolitane e locali) con capacità di 16 kbit/s per la voce, 144 kbit/s per videoconferenza desktop, 384 kbit/s per l'accesso a Internet, e fino a 6 Mbit/s per il video di qualità televisiva. Spaceway utilizzerà, secondo il progetto attuale, 8 satelliti in orbita circolare intermedia (MEO) a 10.350 km di altezza. Ogni satellite, in banda Ka e dotato di Intersatellite Link, trasmette su 48 fasci d'antenna.

Un sistema alternativo, proposto dalla Lockheed Martin e denominato Astrolink, si basa su 9 satelliti geostazionari. Le capacità di Astrolink e di Spaceway sono simili, da 4,4 a 6 Gbit/s, e così l'ordine di grandezza dei costi stimati, da 4 a 6,4 miliardi di dollari.

Nel quadro dei satelliti geostazionari 'multimediali' va citato il programma EuroSkyWay, a cui partecipa l'industria nazionale.

Si prendono ora in esame i servizi di comunicazione satellitare con mezzi mobili, per i quali è nato nel 1982 il consorzio internazionale INMARSAT per offrire collegamenti con le navi in mare aperto e, dal 1990, con gli aeromobili. I satelliti geostazionari INMARSAT (delle successive generazioni INMARSAT-A, -B, -C e -M) a copertura globale (eccetto le calotte polari) si trovano sopra le zone oceaniche, precisamente: AOR-E (Atlantic Ocean Region-East), AOR-W (Atlantic Ocean Region-West), POR (Pacific Ocean Region), IOR (Indian Ocean Region).

Il segmento terreno del sistema INMARSAT è costituito dalle stazioni di terra GES (Ground Earth Station) che connettono i satelliti con le reti di t. internazionali, e dalle stazioni avioniche AES (Aircraft Earth Station) che permettono, via satellite, la connessione tra l'aereo e la GES; il cuore di una AES è l'unità dati satellitari (SDU, Satellite Data Unit) che gestisce il flusso dei dati, la trasmissione e ricezione e il puntamento delle antenne orientabili.

Le antenne INMARSAT avioniche sono: a guadagno di 0 dB (omnidirezionali, per trasmissione a bassa velocità, 600 o 1200 bit/s); a medio o alto guadagno, 6 o 12 dB, orientabili elettronicamente (in elevazione o in azimut ed elevazione) verso il satellite, per le maggiori capacità di trasmissione (fino a 10.500 bit/s).

I satelliti INMARSAT operano nella porzione della banda L allocata per le comunicazioni satellitari con i mezzi mobili, e precisamente: 1525÷1559 MHz downlink (verso il terminale mobile), 1626,5÷1660,5 MHz uplink (dal terminale mobile); al cosiddetto servizio mobile aeronautico sono riservate le sottobande 1545÷1555 MHz e 1646,5÷1656,5 MHz.

Sulla capacità di trasmissione dati bordo-terra e sulla navigazione satellitare (v. traffico aereo, App. V) si basa una nuova modalità di sorveglianza per controllo del traffico aereo, particolarmente utile quando l'aeromobile opera in aree prive di infrastrutture terrene, per es. in volo oceanico: essa è denominata Automatic Dependent Surveillance (ADS). Il dato di navigazione, disponibile a bordo, viene trasmesso a terra consentendo - per scopo di sorveglianza - una localizzazione automatica del velivolo (senza l'intervento del pilota) e, differentemente dalla sorveglianza radar, 'dipendente' dai dati di bordo. Il concetto di ADS, sviluppato dal gruppo di lavoro denominato FANS dell'ICAO (International Civil Aviation Organization), è stato sperimentato dalla fine degli anni Ottanta (sono state definite negli USA le specifiche ARINC 745-2, Aeronautical Radio Incorporated) e nel 1995 la FAA (Federal Aviation Administration) ha certificato il package ADS di bordo denominato FANS-1 per il Boeing 747-400, che utilizza il canale INMARSAT per la trasmissione. Successivamente si è passati a un limitato impiego operativo dell'ADS nel sud del Pacifico (con estensioni alla Siberia e all'Oceano Indiano) grazie a un accordo tra Australia, Canada, Giappone e USA.

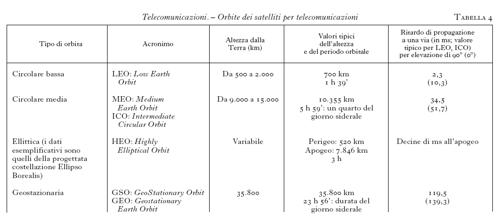

Un elemento innovativo nelle moderne t. satellitari è la scelta di costellazioni di satelliti in orbita bassa o media (tab. 4), di particolare interesse per i servizi mobili e personali.

Con essi si vuole fornire il servizio in aree scoperte, o poco coperte, dai sistemi cellulari o PCS (Personal Communication Systems) e in aree con differenti standard, tenendo presenti le esigenze dei viaggiatori con alta mobilità su scala internazionale, quali per es. i giornalisti. L'integrazione con i servizi forniti da strutture a terra è facilitata dai futuri terminali dual mode, terrestri e satellitari; un esempio è il terminale telefonico mobile che consentirà il collegamento sia alla rete terrestre GSM, sia a quella satellitare Globalstar. I Global Mobile PCS (GM-PCS) o PCS satellitari (S-PCS) si prevede possano diventare sistemi commerciali attorno all'anno 2000.

Le orbite media e bassa, rispetto alla tradizionale orbita geostazionaria o di Clarke, sono favorite dalla minore distanza media del satellite, che consente sia di mantenere modeste le dimensioni del terminale di utente con un favorevole 'bilancio del collegamento' (link budget) dal/al satellite (il miglioramento in termini di potenza arriva a due ordini di grandezza), sia di ridurre il ritardo di propagazione; la loro geometria permette, come di solito è richiesto, di fornire il servizio (con favorevoli angoli di elevazione del satellite) su scala globale, incluse le alte latitudini.

Peraltro un satellite in orbita geostazionaria permette la visibilità del 40% circa della superficie terrestre (cioè circa 3 volte la porzione della Terra visibile da un satellite in orbita bassa: pertanto la copertura di tutta la Terra, escluse le regioni polari, richiede tre soli satelliti geostazionari ma decine di satelliti in orbita bassa), e non crea né lo scorrimento Doppler che va compensato nei satelliti in orbita bassa né i problemi di handover (trasferimento) dovuti alle brevi durate (pochi minuti) dei loro periodi di visibilità.

Tra le orbite LEO e MEO esiste un intervallo di altezze, all'incirca da 2000 a 9000 km, poco utilizzato per il timore di danneggiamento delle celle solari dei componenti elettronici a causa delle radiazioni delle fasce di Van Allen.

Un'ulteriore distinzione è tra i Big-LEO, satelliti di massa intorno a 400÷800 kg per servizi di fonia, fax e dati, operanti tipicamente nelle bande L (intorno a 1,6 GHz) ed S (intorno a 2,5 GHz), e i Little-LEO, satelliti di massa intorno a un centinaio di kg per trasmissione dati a basso rate da terminali remoti e messaggistica, operanti tipicamente nella gamma VHF (140 MHz) e per questo poco utilizzati in Europa; tra questi ultimi sistemi da ricordare l'Orbcomm, con 24 satelliti su tre piani orbitali inclinati di 45° all'altezza di 775 km.

Di massa maggiore dei Big-LEO sono i satelliti in orbita intermedia (ICO o MEO), intorno a 10.000 km di altezza, alla quale corrisponde un periodo orbitale di 6 ore (con visibilità per un'ora circa da un punto a terra); tali orbite permettono la copertura del globo con 10 satelliti (o poco più) e comportano un ritardo di propagazione decisamente più basso (migliori interazioni nella conversazione) di quello dei satelliti in orbita geostazionaria.

Ai sistemi satellitari non geostazionari per comunicazioni mobili, denominati Non-GEO MSS (Mobile Satellite Systems) e agli analoghi sistemi per comunicazioni fisse, denominati Non-GEO FSS (Fixed Satellite Systems), sono state allocate porzioni dello spettro in Banda S (intorno ai 2 GHz e ai 2,5 GHz) nella World Administrative Radio Conference della ITU nel 1995 (WARC-95).

Dopo l'abbandono del sistema Odyssey, rimane un solo sistema basato su satelliti in orbita circolare intermedia che si prevede saranno lanciati all'inizio del 21° secolo: il sistema ICO.

Il sistema ICO è proposto dalla ICO Global Communications, società di diritto privato con capitale di 4 miliardi di dollari e 47 azionisti, costituita all'inizio del 1995 con l'obiettivo di fornire, a partire dal 2000, servizi di comunicazioni mobili e personali basati su satelliti in competizione con Iridium, Globalstar, Ellipso, Odyssey. Ognuno dei 10 satelliti ICO, di 2600 kg di massa, avrà la capacità di 4500 canali telefonici con accesso TDMA e funzionerà nella banda dei 2 GHz per la connessione con i terminali mobili e nella banda dei 5÷7 GHz per la connessione con le stazioni terrene (feederlink); queste bande sono allocate per il non-Geo MSS a partire dall'inizio del 2000.

I satelliti ICO sono collocati su due piani orbitali inclinati di 45°, 5 satelliti per piano, altezza 10.355 km: notevole il numero di fasci di antenna per satellite, ben 168. Il costo previsto è di 4,6 miliardi di dollari.

Scopi analoghi a quelli dei progetti con satelliti MEO sono perseguiti dal progetto Ellipso della holding Mobile Communications, con 14 satelliti (più 3 di riserva) in tre piani orbitali: si intende fornire, entro il 2000, servizi di telefonia mobile, fax, dati, inoltro di messaggi a prezzi confrontabili con i sistemi basati su infrastrutture terrene. La costellazione del progetto Ellipso è costituita da due subcostellazioni: la Ellipso Borealis, con orbite ellittiche su due piani inclinati di 116,5°, 4 satelliti più uno di riserva per piano, orbite eliosincrone per garantire maggiore capacità nelle ore di punta; la Ellipso Concordia, con orbite quasi-circolari a 8040 km per la copertura delle regioni equatoriali e temperate dell'emisfero Sud. Le aree di servizio delle subcostellazioni sono separate, all'incirca, dal tropico del Cancro; ciò si basa sulla distribuzione geografica della popolazione, con densità molto scarsa sotto i 40° S di latitudine ed elevata intorno ai 15÷45° N. Un vantaggio delle orbite ellittiche è l'angolo di elevazione del satellite, quasi mai inferiore a 30° e, per la maggior parte della popolazione, tra 40° e 60°. I satelliti Ellipso, dotati di antenne a 61 fasci, trasmetteranno in CDMA con larghezza di banda di 2,5 MHz (terminali palmari) e 5 MHz (terminali fissi con maggiore capacità) nelle gamme degli 1,6 e 2,5 GHz.

Una costellazione mista, con orbite equatoriali circolari e orbite inclinate, è utilizzata anche nel sistema Aries/ECCO proposto dalla Constellation Communications Inc., per scopi di telefonia rurale (a 2,4 kbit/s) e di fax (a 4,8 kbit/s). La parte del sistema chiamata ECCO (Equatorial Constellation Communications) comprende 11 satelliti in orbite circolari equatoriali a 2000 km; il sistema si completa con 7 orbite inclinate di 5 satelliti ciascuna, per un totale di 46 satelliti.

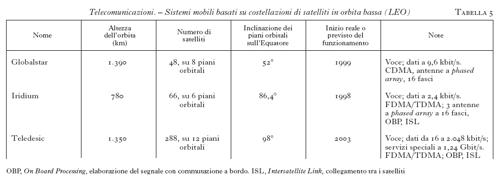

Le caratteristiche di sistemi mobili basati su satelliti LEO sono illustrate nella tab. 5. Tra di essi quello in fase più avanzata di sfruttamento commerciale, almeno secondo le previsioni iniziali di progetto (v. oltre), è il sistema per comunicazioni personali Iridium della Motorola, caratterizzato da 66 satelliti in orbite circolari quasi-polari; ogni satellite, di massa 690 kg circa, ha tre antenne nella banda degli 1,6 GHz del tipo a phased array attivo costituito da un centinaio di moduli MMIC (Monolithic-Microwave Integrated Circuits) ed elementi radianti a patch. Grazie ai 16 fasci sagomati di ciascuna antenna, ogni satellite genera 48 celle, per un totale di 3186 celle mobili sulla superficie della Terra; le 2150 celle simultaneamente attive realizzano la copertura globale.

Il progetto delle antenne deriva dalla tecnologia di un sofisticato radar su satellite chiamato SBR (Space-Based Radar) progettato negli USA per la difesa del continente e della flotta da attacchi sovietici, e mai realizzato.

L'utente ha un terminale portatile, simile ai telefoni cellulari, che lo connette (attraverso i canali bidirezionali in banda L: da 1616 a 1626,5 MHz) a uno dei satelliti; da lì il segnale è trasmesso ad altri satelliti della costellazione nella gamma dei 23 GHz per poi essere indirizzato al destinatario o da uno dei satelliti Iridium (se il destinatario, dotato di terminale Iridium, è in vista dello stesso satellite, ovviamente l'inoltro è diretto) oppure tramite la rete terrestre. Il feederlink è in banda Ka (intorno a 20 GHz in downlink e a 30 GHz in uplink). Il satellite, piuttosto complesso se confrontato con quelli di analoghi sistemi non-Geo, ha quindi anche le funzioni di elaborazione del segnale e commutazione.

Il costo di sviluppo e messa in opera dell'intero sistema Iridium (segmento spaziale e stazioni terrene, software incluso) è dell'ordine di oltre 5000 miliardi di lire. L'inusuale nome deriva dal precedente progetto di una costellazione con un numero di 77 satelliti, che è il numero atomico dell'iridio, metallo bianco splendente il cui nome, derivato dal greco iris, arcobaleno, è stato evidentemente giudicato più adatto del nome del 66° elemento del sistema periodico, il disprosio.

Il sistema Iridium ha iniziato il servizio commerciale nel novembre 1998; al momento del lancio del servizio, 110 Stati sui 235 del pianeta hanno reso disponibili le frequenze, per cui la copertura iniziale non è realmente globale. Il terminale, raggiungibile con il prefisso 008816, è 4÷5 volte più pesante dei normali telefoni cellulari e costa un ordine di grandezza in più; la conversazione è possibile solo all'aperto (ma un avviso di chiamata in arrivo è ricevibile anche al chiuso). Queste limitazioni, insieme all'alto costo, hanno frenato lo sviluppo commerciale di Iridium, tanto da decidere la sospensione del servizio nel marzo del 2000. La Motorola ha comunque allo studio il successore di Iridium, denominato Iridium Next, nel quale i collegamenti radio tra i satelliti dovrebbero essere sostituiti da collegamenti ottici e la capacità trasmissiva verso l'utente dovrebbe raggiungere 256 kbit/s.

Globalstar, sistema per collegamenti mobili a basso costo per telefonia, fax, dati e localizzazione, è basato su satelliti più semplici e leggeri di quelli Iridium (la massa di un satellite Globalstar è di 450 kg), con potenza in continua di 1000 W e vita di progetto di 7,5 anni. La semplificazione principale è l'assenza dell'ISL e di commutazione a bordo, con accesso a divisione di codice (CDMA) e con tutta la 'intelligenza' posta nelle infrastrutture a terra. Questa scelta comporta, però, che le stazioni terrene sono ben 112, contro le 11 di Iridium. Inoltre, sono usate frequenze relativamente basse (la gamma intorno a 2,5 GHz per la trasmissione dal satellite al terminale mobile, quella intorno a 1,6 GHz nel senso opposto, quella dei 4/6 GHz per il feederlink). Il satellite è caratterizzato dalle due antenne ad array nelle bande L ed S nei collegamenti da/per il terminale mobile; esse sono di produzione italiana.

Il lancio del primo gruppo di 4 satelliti Globalstar è avvenuto il 14 febbraio 1998 con un razzo Delta-2. Dopo il fallimento del lancio di 12 satelliti nel settembre 1998, la costellazione di 48 satelliti più 4 di riserva è stata completata nel novembre 1999. Il servizio commerciale con una costellazione parziale è iniziato l'11 ottobre 1999 e il servizio con la costellazione completa a fine 1999.

Notevole è l'esperienza dell'industria nazionale che, responsabile di assiemaggio finale, integrazione e prove dei 56 satelliti, da produrre in soli 18 mesi, ha realizzato un moderno centro (composto da 8 isole funzionali, alle quali se ne aggiungono altrettante per le antenne, prodotte in loco) a Roma. Inoltre, l'industria nazionale produce dei terminali dual mode Global-Star-GSM.

Infine, il progetto Teledesic, il cui scopo è fornire collegamenti video e dati ad alta velocità, in particolare per l'accesso a Internet, prevede ben 288 satelliti in banda Ka con capacità di circa 10 Gbit/s, collocati su orbite LEO. Per realizzare una così numerosa costellazione, sarà necessaria una capacità produttiva dell'ordine di un satellite ogni due giorni, il doppio dei più piccoli satelliti Iridium. Al progetto Teledesic ha aderito, divenendone principale azionista, la Motorola, abbandonando il proprio sistema competitivo denominato Celestri, progetto basato su 63 satelliti in orbita bassa più 9 satelliti geostazionari. L'unico rivale diretto di Teledesic come 'Big-LEO' è il sistema Sky Bridge di Alcatel e Loran, basato su 80 satelliti LEO in banda Ku, dal costo stimato di 4,2 miliardi di dollari (poco meno della metà di Teledesic), che dovrebbe entrare in funzione nel 2001, due anni prima di Teledesic. Sky Bridge intende fornire capacità fino a 20 Mbit/s verso utenti residenziali e multipli di tale valore verso utenti affari.

Tecniche di codifica

L'evoluzione dei sistemi di trattamento dell'informazione e di t. rende possibile l'integrazione di informazioni di natura diversa (testi, suoni, dati, immagini fisse, sequenze di immagini, segnali televisivi) negli hypermedia, derivanti dal concetto di ipertesto, parola coniata nel 1965 per descrivere la possibilità dell'utente di interagire con, e gestire, i dati sotto forma di oggetti ad alto livello, piuttosto che di mere sequenze di simboli. Recentemente gli ipertesti si sono evoluti negli attuali ipertesti multimediali (come nel World Wide Web), costituiti da nodi (un nodo può essere testo, audio, video, animazione o loro combinazione) e da collegamenti logici o rami (fig. 9); oltre alla scansione sequenziale, tipica della lettura tradizionale, è pertanto possibile un'infinità di scansioni non sequenziali.

Elemento critico degli hypermedia come sorgenti informative è il modello dei dati, che determina la capacità del sistema stesso di definire i suoi elementi e le interazioni tra di essi e con essi (per definire la corrispondenza tra i domini di ciascun medium e il modello dei dati si integrano tecniche statistiche di elaborazione del segnale e tecniche semantiche che seguono la concettualizzazione del ragionamento umano); per i sistemi di t. è rilevante un livello più basso, quello della rappresentazione del modello dei dati, che definisce in che modo gli elementi sono codificati (per es., elementi costituiti da linee curve possono essere codificati mediante i coefficienti del polinomio interpolante, i coefficienti di Fourier, la sequenza di coppie di coordinate cartesiane ecc., a loro volta rappresentabili come numeri razionali, numeri interi scalati, o al limite come elementi di testo).

Lo standard ISO/IEC JTC1/SC29 della International Standards Organization e della International Electrotechnical Commission definisce tre formati di scambio per i sistemi multimediali: i primi due si riferiscono alla codifica dell'informazione e sono denominati JPEG (Joint Photographics Expert Group) per le immagini fisse e MPEG (Moving Pictures Expert Group) per le immagini in movimento, mentre il terzo, denominato MHEG (Multimedia/Hypertext Expert Group), definisce, con approccio 'orientato agli oggetti', le relazioni tra le parti di una presentazione multimediale.

La codifica JPEG è applicabile a immagini con un numero di righe variabile da 1 a 64 k (si ricorda che in informatica 1 k=1024) essendo ogni riga costituita da un numero di elementi d'immagine (un elemento d'immagine è chiamato pixel, picture element) da 1 a 64 k e ogni pixel da 1 a 256 componenti (per es. le tre componenti cromatiche RGB, Red-Green-Blue, oppure le componenti di luminanza e di crominanza del segnale televisivo).

La codifica JPEG è del tipo DCT-VLC (Discrete Cosine Transform- Variable Length Code): ciascuna componente, per es. la componente rossa di un'immagine RGB, è suddivisa in blocchi di 8×8 pixel ai quali è applicata la trasformata coseno discreta (DCT) generando una tabella di altrettanti (64) coefficienti di Fourier, dei quali il primo rappresenta il livello medio del blocco prelevato dall'immagine e gli altri 63 rappresentano il contenuto di frequenze spaziali via via crescenti, quindi sempre meno importanti in quanto dipendenti da dettagli sempre più minuti dell'immagine originale. È quindi opportuno quantizzare i 63 coefficienti con un numero di bit via via decrescente; la successiva codifica entropica (alla Huffman o anche aritmetica) permette infine di ridurre il numero di dati da trasmettere.

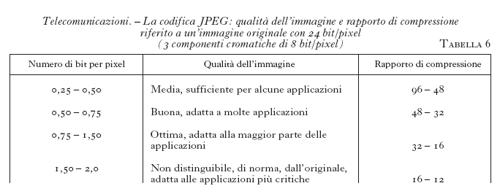

La codifica JPEG è in generale a perdita di informazione, cioè il simmetrico processo di decodifica non permette di riottenere esattamente l'immagine di partenza, e la causa principale è la quantizzazione dei coefficienti di Fourier. Si può scegliere tra diversi livelli di qualità dell'immagine codificata e relativo numero di bit/pixel (tab. 6); il rapporto tra il numero di bit dell'immagine originaria e quello dell'immagine codificata o compressa è chiamato rapporto di compressione. È possibile una codifica senza perdita d'informazione con rapporto di compressione sensibilmente maggiore dell'unità, ottenuto grazie all'impiego di tecniche predittive.

Il vantaggio di trasmettere immagini codificate è evidente se si considera che su una linea con la velocità di trasmissione di 64 kbit/s un'immagine a colori di 512×480 pixel è trasmessa in 1,5 minuti, mentre codificandola in modalità JPEG di 'ottima' qualità (1 bit/pixel) il tempo scende a 3,8 secondi.

La capacità di produzione e memorizzazione di immagini ad alta risoluzione sta rapidamente crescendo: moderne fotocamere digitali forniscono immagini di 3072×2048 pixel, 36 bit/pixel per i tre colori con possibilità di compressione JPEG a diversi livelli di qualità.

Lo sviluppo di standard per la compressione delle immagini in movimento risale agli anni Ottanta con lo standard ITU/ISO H.261 per la trasmissione del segnale video su ISDN e per applicazioni quali videoconferenze e videocitofoni, seguita dalla raccomandazione H.263 Codifica video per comunicazioni a basso flusso binario, novembre 1995. Da H.261 derivano gli standard MPEG, con una codifica 'intraquadro' simile a quella di JPEG e una codifica 'interquadro' basata sulla compensazione del moto a blocchi, con calcolo delle differenze da quadro a quadro, trasformazione DCT e successiva quantizzazione dei coefficienti. Lo standard MPEG-1 è orientato alla memorizzazione del video e dell'audio su supporti come i noti CD-ROM e i nastri DAT (Digital Audio Tape) e alla trasmissione con velocità fino a circa 1,5 Mbit/s.

Le tecniche di codifica numerica video e audio sono ormai mature e impiegate in vari servizi, quali il Video on Demand, la diffusione televisiva numerica e ad alta definizione, i servizi di data-base sonori/vocali.

Lo standard MPEG-1 ha dato luogo a molte applicazioni audio/video; nel settore audio è utilizzato per la memorizzazione su DCC (Digital Compact Cassette) e per la diffusione audio-numerica (in Europa). Sono già in uso algoritmi, e relativi software, per la compressione di brani musicali; pagando un modesto corrispettivo, l'utente potrà prelevare da Internet, o anche da appositi terminali, dei brani compressi, evitando di recarsi in un negozio per acquistarli su supporti tradizionali (Compact Disc o audio-cassetta); ne usufruirà mediante lettori di cassette con capacità di decodifica, o anche mediante PC di tipo multimediale dotati dell'opportuno software.

La codifica MPEG-2, descritta di seguito, è la base dei recenti e futuri sistemi TV numerici, inclusa l'alta definizione. Essa costituisce ormai uno standard, codificato nella raccomandazione ISO H.262 Generic coding of moving pictures and associated audio: Video, ISO-IEC 13818-2, maggio 1994, compatibile verso il basso con MPEG-1, e progettato per fornire una qualità non inferiore ai sistemi analogici PAL e NTSC.

Le funzionalità di MPEG-2 sono suddivise in 5 'profili', da 'semplice' ad 'alto', e per ogni profilo sono previsti 4 'livelli', dal 'livello basso' (352 campioni/linea, 288 linee/quadro) fino al 'livello alto' (1920 campioni/linea, 1152 linee/quadro).

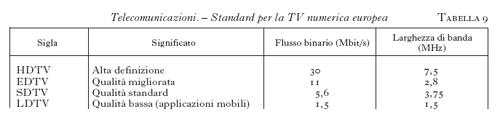

In particolare, MPEG-2 permette di trasmettere il video a definizione normale (standard CCIR 601, Comité Consultatif International des Radiocommunications, raccomandazione ITU per la codifica del segnale televisivo numerico, con 750×576 pixel attivi, 625 linee, sottocampionamento di un fattore 2 per le due componenti di crominanza che hanno così 360 pixel per linea) a velocità tra 5 e 10 Mbit/s e il video ad alta definizione HDTV (1920×1152/1080 pixel, numero di campioni da 4 a 5,5 volte e bit rate da 8 a 11 volte il video CCIR 601) a velocità tra 20 e 40 Mbit/s, con compressioni tipiche da 25:1 a 50:1.

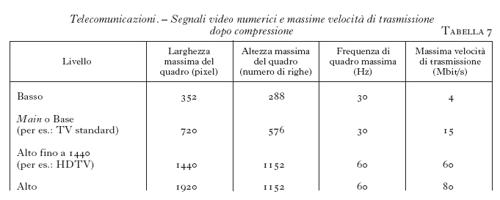

La tab. 7 mostra i quattro 'livelli' del segnale video e i relativi bit rate (velocità di trasmissione binaria).

La codifica MPEG è resa economicamente conveniente - anche nelle applicazioni consumer - dallo sviluppo di circuiti dedicati.

È in avanzata fase di sviluppo lo standard MPEG-4, la cui pubblicazione come standard ISO è avvenuta a inizio 1999 per la versione 1 e alla quale seguirà la versione 2, che include nuove versioni: esso è candidato a essere lo standard internazionale per un vasto insieme di applicazioni, inclusi i multimedia; compatibile verso il basso con MPEG-1 e -2, esso offrirà una più estesa gamma di rapporti di compressione, variabili da quelli necessari all'alta fedeltà a quelli per l'accesso da terminale mobile multimediale. MPEG-4 è basato sul concetto di 'oggetto audio-visuale' (AV object, AVO) reale o sintetico: sono oggetti a) una persona in una scena, b) il suo parlato, c) la parte fissa dello sfondo, d) una parte mobile dello sfondo, e) il rumore di fondo ecc.; viene resa possibile l'interazione con l'utente nella presentazione del materiale audiovisivo (composizione) e l'integrazione di applicazioni memorizzate.

La compressione del video consente velocità variabili da soli 5 kbit/s (per accesso a reti telefoniche mobili o fisse) fino a ben 15 Mbit/s, per TV e film; nella sua ampia gamma di applicazioni (tra quelle su Internet e quelle su sistemi radiomobili: DECT, GSM, UMTS) MPEG-4 non intende però sostituire lo standard MPEG-2 per la TV digitale.

Il trasporto di suoni e immagini è basato sul formato di file chiamato QuickTime, proposto alla ISO da un gruppo di ditte tra cui Apple, IBM, Netscape, Oracle, Silicon Graphics, SUN Microsystems, e accettato come standard a inizio 1998.

È allo studio lo standard MPEG-7 Multimedia Content Description Interface, che si riferisce alla descrizione unificata dei vari tipi di informazione multimediale, e quindi al modello dei dati piuttosto che alla codifica.

I servizi video

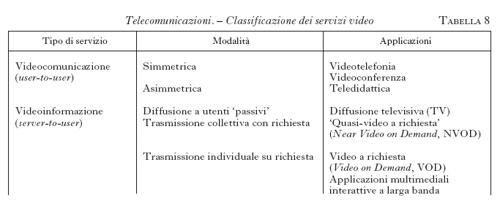

I servizi video possono essere classificati in videocomunicazione tra due o più utenti e videoinformazione trasmessa agli utenti da un fornitore di servizi (server), come mostrato in tab. 8. I servizi di videocomunicazione rispondono all'esigenza di 'simulare' la presenza delle persone e dei mezzi audiovisivi (tabelle, lavagne luminose ecc.) evitandone lo spostamento fisico; a riguardo vanno ricordate alcune brillanti esperienze di teledidattica universitaria in Italia.

Grande è lo sviluppo dei servizi di videoinformazione/intrattenimento (a volte indicati con il neologismo infotainment); mentre le prime quattro applicazioni della tab. 8 sono ben note e abbastanza consolidate (anche se le relative tecnologie evolvono rapidamente), più recenti sono le ultime tre applicazioni, che costituiscono un'evoluzione della pay TV (con pagamento di un canone mensile o annuo per ricevere un insieme di programmi, o palinsesto, fisso) e della televisione pay per view (con pagamento per vedere particolari programmi, per es. avvenimenti sportivi).

Il termine Near Video on Demand (NVOD) indica l'uso di gruppi di più canali (di tipo satellitare, oppure su fibra ottica, su cavo, o anche con le emergenti tecnologie ADSL); i canali (per es. in numero di 10) di ciascun gruppo trasmettono lo stesso spettacolo (un film, un'opera teatrale o lirica) con un ritardo fisso (per es. 10 minuti) tra un canale e il successivo. In tal modo l'utente, selezionando quel gruppo di canali e attendendo un tempo statisticamente variabile (in media 5 minuti, al massimo 10 minuti nell'esempio fatto), assiste allo spettacolo come se gli fosse stato trasmesso a richiesta.

Il Video on Demand (VOD) permette di fornire in tempo reale il particolare spettacolo che l'utente richiede, dopo averlo scelto in un menu elettronico; pertanto, oltre al canale 'a banda larga' verso l'utente (una larghezza di banda praticamente illimitata si può ottenere con la fibra ottica, il cui inoltro fino all'interno dell'abitazione - sistema FTTH - è stato peraltro rimandato da molti gestori telefonici in vista dell'uso di tecnologie alternative), è necessario il canale 'a banda stretta' dall'utente al fornitore dei servizi per la trasmissione dei comandi.

La bidirezionalità e l'elevata larghezza di banda aprono la porta ad altre recenti o future applicazioni - con prevedibili sviluppi non sempre tranquillizzanti - denominate genericamente multimediali interattive, per es. il teleshopping, nel quale l'utente/consumatore fa acquisti, 'navigando' mediante il proprio terminale, in un 'negozio virtuale'.

Commercialmente la rilevanza maggiore è tuttora quella della diffusione televisiva, che può avvenire in varie modalità: TV terrestre, con antenna ricevente fissa (sul tetto dell'edificio), portatile, mobile (veicolare); TV via cavo (Cable-TV, o Commuting Antenna TV, CATV); TV satellitare (tramite Direct Broadcasting Satellite, DBS) con diffusione diretta nella gamma Ku (in Europa, da 10,95 a 12,75 GHz); moderni sistemi di distribuzione su fibra ottica con superamento dell'ultimo miglio mediante uso del doppino d'utente con tecnologia ADSL/VDSL.

Si stanno sviluppando anche, per la diffusione a gruppi di abitazioni, sistemi misti a tecnologia avanzata, quale il MVDS (Microwave Video Distribution System), funzionante nella gamma 40,5÷42,5 GHz con architettura cellulare e celle di 3÷5 km.

Gli standard dell'attuale diffusione televisiva di massa risalgono all'introduzione del colore; le loro limitazioni sono principalmente dovute alla necessità di mantenere la compatibilità con i ricevitori b/n e di inserire - con tecniche analogiche alquanto sofisticate - le componenti cromatiche del video (segnali di crominanza, U e V) nella stessa banda occupata dalla componente b/n (segnale di luminanza, Y), il che comporta un certo livello di interferenze reciproche e una ridotta definizione nei dettagli dei colori.

La TV a colori è diffusa nelle gamme VHF e UHF con i noti sistemi PAL (usato in tutta l'Europa occidentale, esclusi Francia, Monaco e Lussemburgo; in Romania, Argentina, Brasile, Paraguay, Uruguay, Cina e in numerosi Stati dell'Estremo Oriente; in Italia si usa il G-PAL con spaziatura dei canali di 8 MHz e larghezza di banda del segnale video di 5 MHz), SECAM (usato in Francia, Monaco e Lussemburgo, negli Stati dell'ex URSS e nell'Europa orientale, in numerosi Stati africani) e NTSC (usato negli Stati Uniti, in Canada, Giappone, Bolivia, Chile, Colombia, Messico, Perù, Venezuela e molti Stati centroamericani).

Si è quindi manifestata già dall'inizio degli anni Ottanta, allo scopo di favorire nuovi consumi, la tendenza a costruire nuovi standard per migliorare la qualità del segnale televisivo, specie per quanto riguarda il rapporto tra le dimensioni orizzontale e verticale dell'immagine (l'attuale rapporto 4:3 risulta meno gradito al pubblico del rapporto 16:9, prossimo a quello cinematografico), la risoluzione, che si vorrebbe confrontabile a quella ottenibile con la pellicola da 35 mm, la fedeltà cromatica e infine il sonoro (è auspicabile un suono stereofonico di qualità tipo CD).

In Europa è stato sviluppato, e applicato alla diffusione diretta da satellite, lo standard MAC (Multiplexed Analogue Components), nel quale le tre componenti (Y, U, V) del video sono compresse numericamente nel tempo - in modo da occupare, senza interferire, i periodi attivi delle 625 linee - e trasmesse in divisione di tempo con modulazione analogica (allo scopo di limitare l'occupazione spettrale entro i 27 MHz dei canali satellitari della diffusione diretta nella gamma intorno a 12 GHz); di esso esistono varie versioni, per scopi DBS e per la distribuzione su reti in cavo.

Il MAC (anche nella più recente versione D2MAC) non fornisce né l'alta definizione né l'immagine 16:9. Già dagli anni Ottanta si sono perciò sviluppate le tecniche di TV ad alta definizione, brevemente HDTV, basate su elaborazione numerica e su modulazione analogica del segnale video; nel 1986 è iniziato il progetto europeo Eureka EU 95, con obiettivo lo sviluppo di un sistema HDTV denominato HD-MAC compatibile con i ricevitori esistenti, con 1250 linee (il doppio del PAL), 1920 punti (pixel) per linea, 50 quadri/s, scansione sequenziale; tuttavia tale progetto non ha portato a nessuno sviluppo commerciale (e lo stesso MAC, che rappresenta invero un passo assai significativo sia verso il superamento delle differenze tra gli standard europei PAL e SECAM sia verso le tecniche numeriche, non ha raggiunto la diffusione sperata: è attualmente diffuso su pochi canali satellitari in Europa) malgrado la spesa di circa 2000 miliardi di lire: lo sviluppo degli standard è stato troppo lento rispetto all'evoluzione della tecnologia, particolarmente di quella numerica, a causa della scarsa flessibilità delle associazioni degli industriali del settore e dei funzionari della Comunità Europea.

La diffusione TV da satellite si è ugualmente sviluppata in Europa 'aggirando' la Direttiva 86/529/CEE, la quale stabiliva per la diffusione televisiva diretta da satellite l'obbligo dello standard MAC pianificando il servizio regolare dal 1995. Dato che la Direttiva definì come diffusione diretta solo quella nella gamma da 11,7 a 12,5 GHz, assegnata nel 1977 dalla ITU, alcuni operatori (Astra della lussemburghese Société européenne des satellites, i cui canali TV hanno raggiunto nel 1995 ben 56 milioni di abitazioni, per diffusione diretta o via cavo, e la European Telecommunications Satellite Organization, EUTELSAT, con sede a Parigi) iniziarono a fornire il servizio su altre frequenze mantenendo lo standard PAL: all'utente è necessaria una piccola antenna parabolica (diametro, a seconda del livello del segnale: da 50 a 120 cm, anche maggiore per aree geografiche ai bordi dell'area di copertura del satellite) con amplificatore a basso rumore e un convertitore dalla frequenza satellitare a quella del ricevitore TV.

La TV digitale e il DAB, Digital Audio Broadcasting

Anche i servizi di videoinformazione si adeguano alla moderna tendenza dell'uso delle reti numeriche con capacità flessibile di trasmettere, oltre al tradizionale segnale telefonico (POTS, Plain Old Telephone Service), segnali video e dati.

I vantaggi della trasmissione numerica sono: immunità al rumore e alle interferenze e mantenimento di tale immunità, fino a una soglia; qualità elevata; flessibilità nella combinazione di diversi servizi; facilità di cifratura per proteggere le informazioni e per controllare l'accesso; migliore sfruttamento dello spettro di frequenza tramite l'eliminazione delle ridondanze.

Dall'inizio degli anni Novanta fu chiaro che la TV del futuro avrebbe utilizzato la modulazione numerica, e un gruppo di operatori europei del settore (produttori di programmi, fornitori di servizi di trasmissione e diffusione, costruttori di apparecchi) evidenziò l'urgenza della creazione di standard. La prima riunione del gruppo DVB (Digital Video Broadcasting) di Bonn, nel 1993, costituì l'avvio del progetto di produrre rapidamente, sulla base del consenso, specifiche tecniche sulla cui base gli organismi europei riconosciuti potessero definire gli standard non solo per la più urgente diffusione televisiva da satellite (Direct to Home, DTH) e per lo HDTV, ma per tutti i mezzi e tutti i servizi, in particolare per la diffusione terrestre, considerata competitiva con il cavo e il satellite. Nel 1997 hanno partecipato al gruppo DVB ben 200 organismi di oltre 25 nazioni.

Le proposte preparate dal DVB comprendono tre tipi di standard basati sulla codifica MPEG-2 - che permette di comprimere il segnale HDTV trasmettendolo con 30 Mbit/s o meno - con le tre diverse modulazioni: