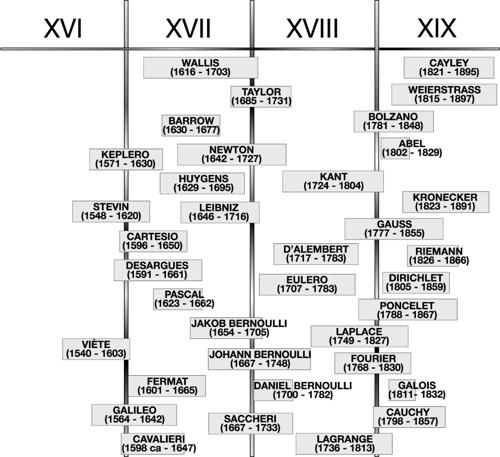

STORIA DELLA MATEMATICA

STORIA DELLA MATEMATICA

STORIA DELLA MATEMATICA

Il tempo della scienza senza tempo

La matematica è la più antica e la più immutabile delle discipline. Si può dire che la matematica di base, quella insegnata oggi nella scuola primaria, è pressoché identica in tutte le scuole del mondo, da New York ai villaggi africani, e non è molto diversa da quella che insegnavano gli scribi babilonesi o egiziani.

La matematica è nata in Oriente e persino il linguaggio matematico rivela le influenze islamiche (algebra e algoritmo sono, per esempio, termini di origine araba); di origine indiana è anche la moderna notazione numerica. Tutta l’area dall’India al Mediterraneo è stata per millenni percorsa da vie commerciali e interessata da scambi culturali, influenze religiose e massicce migrazioni di popoli.

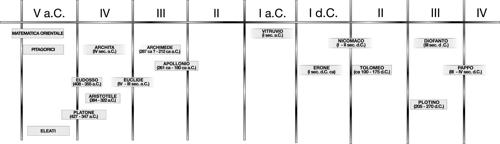

La scienza e la matematica moderna sono nate nel Seicento e da allora si sono sviluppate in maniera costante, plasmando il mondo così come lo conosciamo. Usualmente se ne pongono le basi nella matematica greca del periodo aureo, fiorita nei secc. iv e iii a.C. tra l’Accademia platonica di Atene e il Museo e la Biblioteca di Alessandria d’Egitto. Nei quasi duemila anni che separano queste due fasi storiche molti dei testi originali sono andati distrutti o perduti. I codici più antichi degli Elementi di Euclide sono di oltre mille anni successivi all’originale, un millennio di copie e traduzioni da cui il testo non è rimasto indenne. Anche peggiore la sorte toccata alle opere di Archimede e Apollonio. Scomparsi i testi, chiuse scuole e istituzioni culturali, svanita ogni testimonianza e memoria, nel medioevo si dissolve la continuità della tradizione matematica, al punto che oggi è problematico ricostruire il senso stesso dei termini antichi. Può venire addirittura il sospetto che la scienza moderna sia in realtà erede degli artigiani fiorentini e degli scolastici parigini più che dei matematici greci di Alessandria.

Oggi la matematica presenta un quadro unitario a livello internazionale ed è priva di differenze geografiche, ma nel passato sono esistite tradizioni matematiche autonome: la matematica cinese, per esempio, è cresciuta autonomamente per duemila anni, ed è giunta a livelli fino a cinque secoli fa paragonabili se non superiori a quelli della coeva matematica europea. Nel confronto, appaiono peculiarità distinte, che riflettono i caratteri profondi delle due culture, ma si notano anche indubbie somiglianze: i numeri sono sostanzialmente gli stessi e solo la notazione appare diversa; le operazioni su di essi sono affini, le figure geometriche fondamentali sono le stesse, e i calcoli pure.

Gli Elementi di Euclide sono il più importante libro scientifico di tutti i tempi e fino a quattro secoli fa erano ancora la base di tutto il sapere scientifico e il paradigma dell’idea stessa di razionalità. Ancora oggi potrebbero essere usati come libro di testo nelle scuole superiori quasi senza modifiche. Così, la matematica sembra avere uno sviluppo lineare, sembra crescere su sé stessa, senza mai rinnegare il suo passato, senza rivoluzioni, senza tempo. Di qui l’idea diffusa che la matematica sia solo la scoperta progressiva di un «mondo di idee», un regno immateriale ma tuttavia reale quanto quello fisico che ci circonda. Secondo tale diffusa idea la storia della matematica si configura come la storia della scoperta progressiva di questo mondo.

In tempi più recenti si è considerata la matematica come il linguaggio di una scienza essenzialmente empirica. In tale visione, la matematica è solo uno strumento linguistico. Conseguentemente, la sua storia appare lineare, in un certo senso dipendente dalle storie delle altre scienze (della fisica, della tecnica, della filosofia) in quanto storia di uno strumento che si adegua alle esigenze di altre discipline, anziché un settore di studi dal cui interno scaturiscono teorie e concetti autonomi. E ancora una volta, così intesa, la matematica risulta uno strumento monotono nella sua prevedibilità, appare ovvia, logica, “naturale”, e forse anche un po’ noiosa. In ogni caso finisce con l’essere la parte più prettamente formale di una storia della scienza che nel secolo scorso è stata vista come “storia delle idee”.

In verità, la storia della matematica è segnata da svolte radicali, da fratture capaci di fondare una nuova concezione del mondo. Fratture che anche oggi uno studente avverte quando passa per esempio dallo studio dell’aritmetica e della geometria a una matematica intessuta di simboli algebrici e concetti più astratti quale per esempio quello di funzione. Le idee matematiche si mostrano talvolta come creazioni inaudite basate su apparenti assurdità. Per i greci lo zero non esisteva e l’uno non era un numero. Fino al medioevo il concetto di numero reale era sconosciuto; lo intuirono gli arabi, e infine nel Seicento esso fu introdotto, pur tra le difficoltà concettuali che esso comportava soprattutto in relazione alla sua rappresentazione decimale infinita e alla definizione di continuità a esso correlata. I numeri reali furono infine accettati divenendo strumenti di lavoro indispensabili, tanto da apparire ben presto quasi una ovvietà, ma dovettero trascorrere ancora due secoli perché ricevessero una formulazione scientifica con G. Cantor e R. Dedekind, che elaborarono una rigorosa costruzione dell’insieme R dei numeri reali a partire dall’insieme Q dei numeri razionali.

La storia della matematica è dunque una storia del tutto anarchica e irrazionale, costellata di percezioni geniali e di intuizioni improvvise? Oppure al di sotto delle idee logiche e razionali alternate ai concetti più astrusi si possono intuire i tratti di un’unica storia cognitiva, complessa e sfaccettata?

Certamente, la matematica parla dei caratteri fondamentali della realtà a un livello che sembra trascendere la storia e la geografia antropiche. Ma nel contempo essa permea l’insediamento umano nel mondo, rispecchiando le manifestazioni antropologiche e culturali delle diverse civiltà, dalla religione all’arte, dalla musica al linguaggio. Ma soprattutto rivela i caratteri più profondi e nascosti del rapporto cognitivo tra l’uomo e ciò che lo circonda.

La matematica antica

La matematica viene dall’Oriente e fino a quasi tutto il medioevo è sempre stata un prodotto orientale: la Grecia antica si può considerare la periferia dell’Oriente. Archimede di Siracusa (287?-212 a.C.) è il più “occidentale” matematico antico, ma i suoi riferimenti culturali erano tutti orientali. Si può considerare Leonardo da Pisa, detto Fibonacci, vissuto nella prima metà del xiii secolo, il primo matematico “occidentale”.

Prima dei greci la matematica era patrimonio degli scribi, sacerdoti del tempio e del palazzo che avevano il monopolio della cultura, della scrittura e della matematica. Quest’ultima, pur presente negli antichi miti e rituali, aveva un ruolo essenzialmente pratico: calcoli relativi ad aree, a quantità di beni, a problemi amministrativi. Harpenodaptai (tenditori di corde) erano detti gli scribi egizi che dopo ogni inondazione del Nilo rimisuravano con corde e paletti i campi per ridisegnarne i confini.

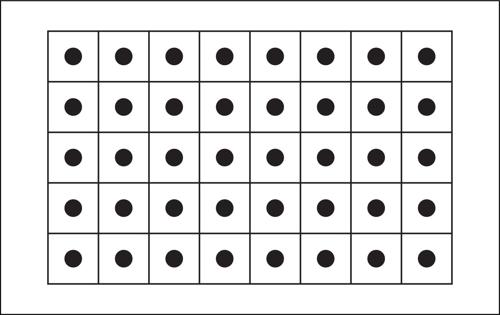

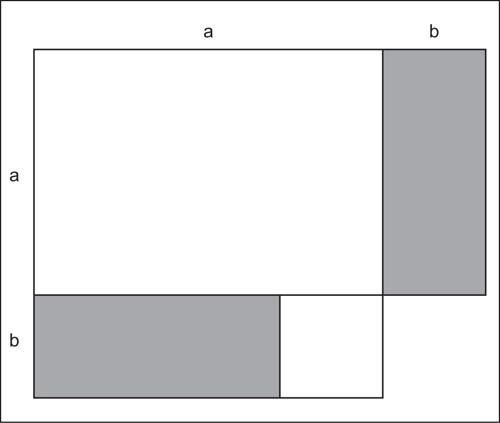

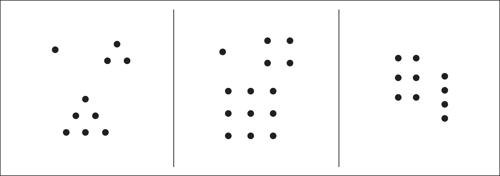

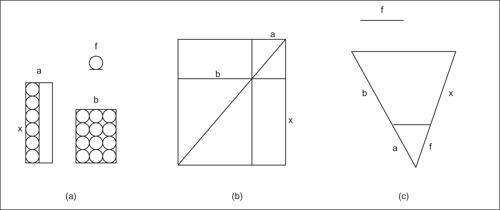

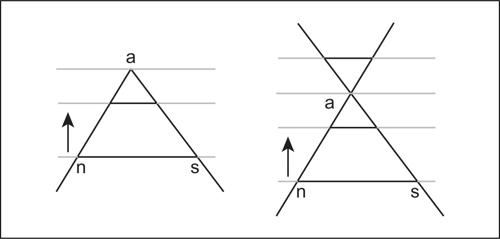

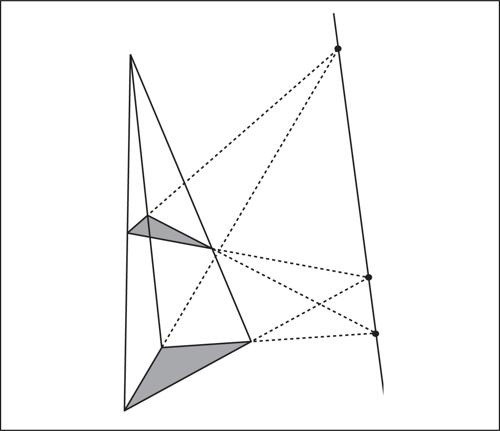

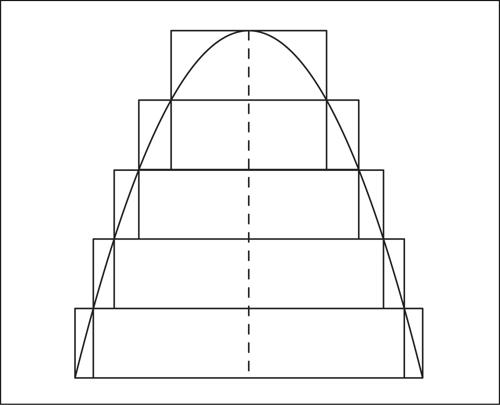

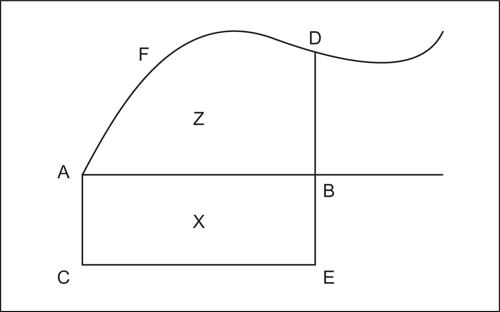

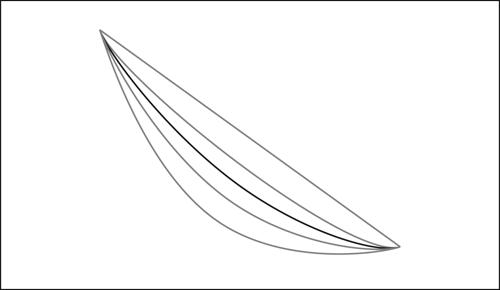

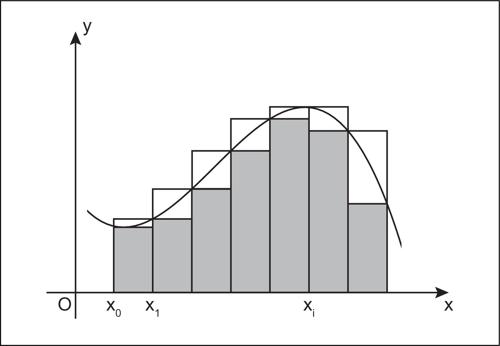

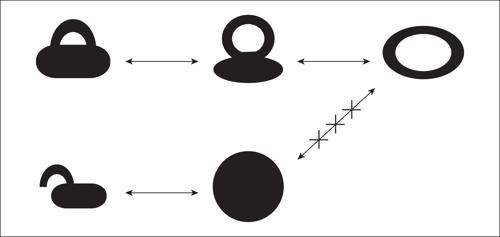

Probabilmente la matematica si svolgeva soprattutto sull’abaco, che all’origine era solo una superficie piana coperta di sabbia sulla quale si potevano tracciare linee e poggiare sassolini (calculi, in latino). Era l’antenato del moderno pallottoliere, ma serviva probabilmente anche a realizzare costruzioni geometriche e calcolare le aree delle figure (la fig. 1 mostra come si poteva scoprire sull’abaco la regola per il calcolo dell’area del rettangolo).

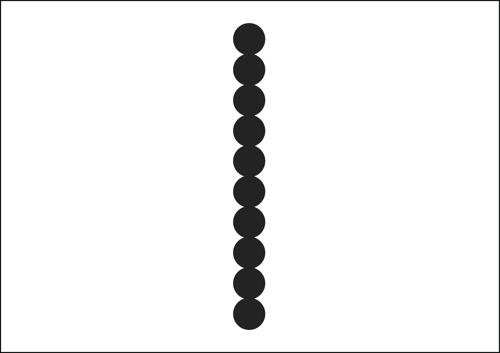

Del resto, è noto l’aneddoto plutarchiano in cui si narra che lo stesso Archimede fu ucciso sulla spiaggia mentre era impegnato in una dimostrazione geometrica tracciata sulla sabbia. I sassolini finivano con l’essere nel contempo punti, quadratini unitari e unità, antenati di quelle che i greci chiameranno monadi, così che tanto un intervallo di lunghezza n quanto il numero intero n saranno da essi considerati una sequenza lineare di n unità (fig. 2).

Nella matematica antica, legata a problemi concreti (di agrimensura, di registrazione dei beni ecc.), non si trova traccia di dimostrazioni, ma questa assenza non deve indurre a ritenere la matematica antica una scienza poco elaborata. Per esempio, gli egizi possedevano un algoritmo per la moltiplicazione tra interi, che usava non le tabelline ma la scrittura binaria dei numeri, e che così si può descrivere: si supponga, per esempio, di voler moltiplicare 27 per 13. Si raddoppi il numero 27 e si ripeta la moltiplicazione per 2 fino a ottenere il multiplo di 27 secondo il fattore 2n (cioè 2n ⋅ 27), la massima tra le potenze di 2 minore di 13 (e quindi n = 3, perché 23 = 8 < 13, mentre 24 = 16 > 13), e si scriva 13 come somma di multipli di 2 fino a tale massima potenza di 2: si ottiene 13 = 8 + 4 + 1. Si contrassegnino ora con una × soltanto i multipli di 2 che compaiono in tale somma e, nella terza riga della seguente tabella, si considerino i multipli di 27 secondo i corrispondenti fattori che compaiono nella seconda riga (che possono essere semplicemente ottenuti, a partire da 27, per raddoppiamenti successivi: 27, 54, 108 ecc.):

Infine, si sommino i multipli contrassegnati dalla × che compaiono nella terza riga; si ottiene: 216 + 108 + 27 = 351, che è il risultato cercato, cui si è giunti senza far ricorso a tabelline.

La tradizione pratica

La matematica pregreca, per il suo carattere pratico, si configurava essenzialmente come un insieme di tecniche di calcolo. Pur derivando da questa matematica pratica, la geometria teorica greca se ne distaccherà nettamente, al punto che dal v sec. a.C. fino al xvi sec. d.C. si possono riconoscere nella matematica due tradizioni nettamente distinte, una pratica e una teorica.

La tradizione pratica, che resterà viva fino al rinascimento, può essere definita una matematica dell’abaco, meno ricca di implicazioni teoriche rispetto alla grande geometria greca classica, ma tuttavia diffusa in tutto il Mediterraneo e nel Medio Oriente. È la tradizione sviluppatasi sin dal iii millennio a.C. in Mesopotamia, presente nella matematica egiziana, indiana ed ellenistica, fino a Erone e Diofanto. Era la matematica del contingente, delle applicazioni, delle professioni (amministratori e agrimensori, architetti e tecnici, artigiani e mercanti). Si tramandava soprattutto oralmente e per apprendistato (la scrittura era usata solo per elenchi di problemi e tavole numeriche), e, diversamente dalla tradizione teorica, era attenta al dato numerico empirico e alla misurazione. Il radicamento nelle applicazioni pratiche le permise di sopravvivere anche al crollo dell’impero romano d’Occidente, e di rifiorire nel medioevo tanto nel mondo islamico quanto in Europa.

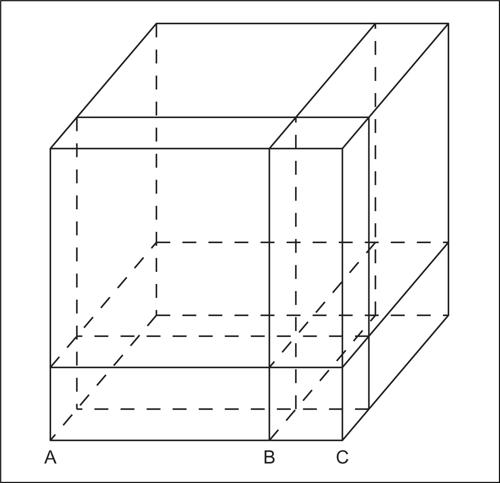

Una tale matematica impermeabile alle questioni della geometria teorica, allo stile assiomatico-deduttivo e alla distinzione discreto/continuo, nella quale le tecniche erano esplicitamente aritmetiche, la geometria era sempre e solo metrica e descrittiva e non vi era una differenziazione tra unità e punto (se non nel fatto che il punto “aveva una posizione”), era in termini cognitivi una aritmogeometria. In questa tradizione la dimostrazione delle proprietà era lasciata alla evidenza visuale o a esempi generalizzabili, e non svolgeva alcun ruolo il principio di omogeneità, secondo il quale tutti i termini di una “somma” di grandezze devono avere la stessa dimensione (tutti i numeri sono segmenti, i prodotti di due numeri sono rettangoli e i prodotti di tre numeri sono parallelepipedi). Così, sia i babilonesi sia Erone potevano tranquillamente sommare aree e perimetri.

La geometria dell’abaco

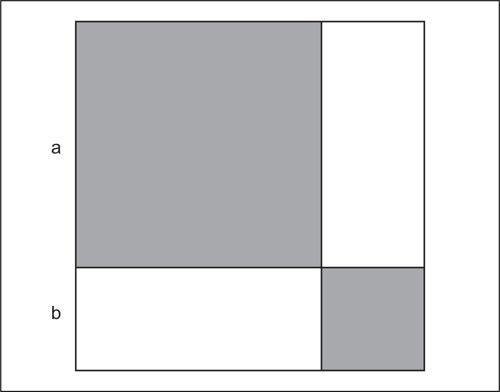

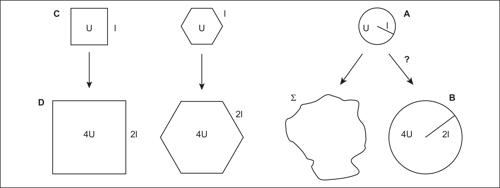

La geometria dell’abaco, che fu probabilmente la base dell’algebra geometrica, a noi pervenuta attraverso il ii libro degli Elementi di Euclide (secc. iv-iii a.C.), era probabilmente già in qualche misura nota ai babilonesi. Tramite essa si potevano mostrare proprietà che noi chiamiamo algebriche, come per esempio nelle figure 3 e 4 le formule: (a + b)2 = a2 + 2ab + b2 e (a + b)(a − b) = a2 − b2 (si utilizza qui per comodità il linguaggio algebrico codificato nel xvii secolo: un anacronismo che verrà usato anche in seguito).

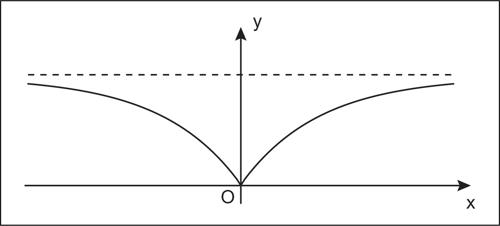

La figura 3 era anche la base della procedura pratica per calcolare la √(A) (il lato del quadrato A). Se infatti a è una buona prima approssimazione di √(A), allora √(A) = a + b, con b molto minore di a, e di conseguenza nel quadrato A il quadratino di lato b si può trascurare, ottenendo A ≅ a2 + 2ab (corrispondente a una figura a forma di L, detta gnomone, differenza tra un quadrato e un quadratino in esso contenuto come in figura). Così la seconda approssimazione si ottiene aggiungendo ad a il valore approssimato b ≅ (A − a2)/2a. A tale approssimazione si può applicare di nuovo la stessa procedura per trovare una terza approssimazione, e così via.

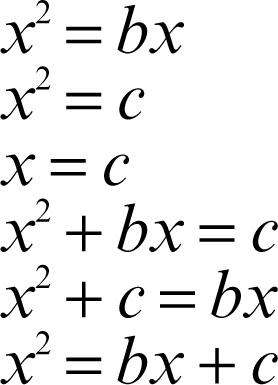

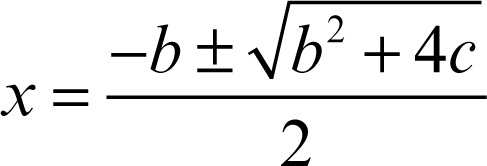

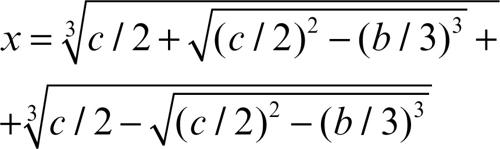

Fino al Cinquecento l’algebra sarà intesa come tecnica pratica di risoluzione di problemi numerici, in cui le quantità erano intese geometricamente e trattate aritmeticamente, così che erano di fatto inconcepibili le equazioni di grado superiore a tre o i numeri negativi. Ciò era dovuto anche al fatto che non si era ancora sviluppato un linguaggio algebrico-simbolico che permettesse un calcolo agevole, linguaggio che verrà elaborato più tardi, nel Seicento, da Cartesio, Viète, Recorde e altri.

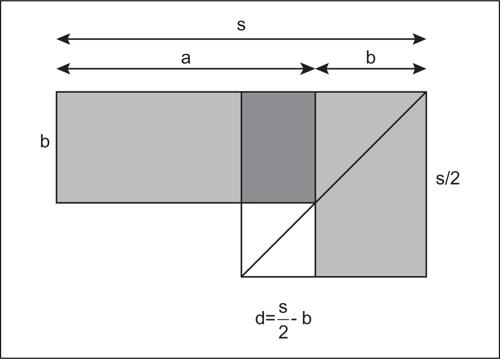

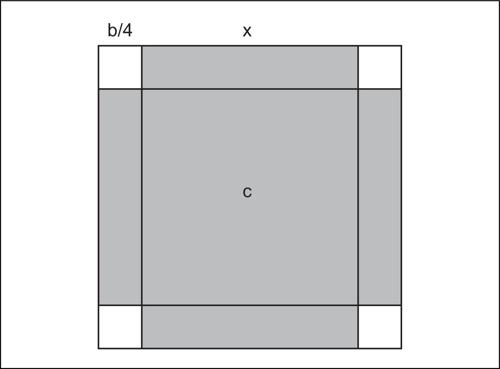

Un esempio complesso era la risoluzione della equazione di secondo grado in forma normale (nella forma, cioè, di una somma e un prodotto di due grandezze da determinare), della cui risoluzione si trova una plausibile traccia negli Elementi (teoremi ii.5 e ii.6, fig. 5).

In realtà, queste sono le uniche tracce di un approccio cognitivo geometrico, poiché sulle tavolette babilonesi si incontrano solo esempi di soluzione numerica. Ma poiché l’insegnamento nella tarda antichità era solo orale, ipotizzare un fondamento geometrico della procedura appare necessario per spiegarne, in assenza di formule, sia la descrizione che la memorizzazione. È infatti immediato ricavare la soluzione dell’equazione seguendo le indicazioni della fig. 5. Siano dati a + b = s, e ab = p. Ponendo d = |a − b|/2, a e b sono uguali a s/2 + d e s/2 − d. Lo gnomone di lati s/2 e d ha area p e quindi il quadratino bianco di lato s/2 − b ha area (s/2)2 − p (che è nota). Da qui è facile calcolare b e poi a.

È da sottolineare come sia la concezione aritmogeometrica dell’abaco più che la stessa praticità a caratterizzare l’origine cognitiva e la collocazione sociale di questa tradizione. Compaiono infatti in essa anche problemi non pratici, puramente ricreativi, e in Diofanto hanno un ruolo centrale i problemi indeterminati (poco interessanti sul piano pratico), in cui le soluzioni possono assumere infiniti valori, vincolati per esempio dall’essere numeri quadrati.

La tradizione teorica

Di fronte alla tradizione pratica, nel v secolo a.C. se ne delinea una teorica, basata sulla geometria. Essa fiorisce per circa due-tre secoli, da Archita ed Eudosso sino ai grandi della matematica ellenistico-alessandrina − Euclide, Archimede, Apollonio − ai quali fanno seguito rari epigoni come Pappo. In tale tradizione la geometria non aveva alcun carattere metrico, essendo puramente teorica e centrata sulle proporzioni e sui concetti di uguaglianza e similitudine. Appariva netta in essa, contrariamente alla tradizione pratica, l’opposizione tra numeri e grandezze, tra aritmetica e geometria che durerà fino al rinascimento. E proprio tale opposizione spiega l’assoluta centralità della teoria dei rapporti e delle proporzioni nella matematica premoderna, come unico linguaggio per estendere alla geometria teorica concetti di natura aritmetica. Mentre l’aritmetica restava all’interno della tradizione pratica, la geometria teorica rompeva i ponti con la geometria dell’abaco: essa era assolutamente non metrica, giacché non esistevano in essa né lunghezze, né aree, né volumi, concetti che in qualche modo si rifacevano ad “approssimative” operazioni di misura. Oggi si dice (e qualcosa di simile dicevano i babilonesi) «l’area del cerchio è πr 2». Il matematico greco diceva invece «il rapporto fra due cerchi è il doppio rapporto dei diametri» (bisogna ricordare che i rapporti non erano numeri e doppio significava solo «composto con sé stesso», l’equivalente cioè di «elevato al quadrato», nella nostra terminologia).

Alle radici di questa geometria teorica vi erano le idee di uguaglianza e similitudine, che saranno il denominatore comune tra matematica e filosofia greca: nella prima, daranno origine alla teoria delle proporzioni e al sistema assiomatico euclideo, nella seconda alla dottrina delle idee/forme.

I rapporti erano relazioni tra quantità omogenee (impensabile quindi la velocità come rapporto tra spazio e tempo) e non erano numeri; anche le figure non avevano misure: non si sommavano le loro aree, bensì si univano le figure. Tra di esse si potevano fare confronti (una figura è “uguale” a un’altra se tramite opportune trasformazioni la si può trasformare in una figura sovrapponibile a essa, la prima è invece maggiore della seconda se, dopo le trasformazioni, la contiene). Le «trasformazioni equivalenti» erano le operazioni di dissezione e riassemblaggio e le equivalenze geometriche erano basate sugli assiomi dell’uguaglianza: nell’esempio in fig. 6 sono uguali i due rettangoli tratteggiati e i tre triangoli costruiti sulla stessa base. Esiste in Euclide un doppio criterio di uguaglianza: in primo luogo quello arcaico della sovrapponibilità, in secondo luogo la trasformabilità nel rispetto degli assiomi dell’uguaglianza.

I greci riuscirono a risolvere in generale il problema del confronto per le figure rettilinee, ma non per le figure curvilinee; era questo il problema della quadratura del cerchio: non si trattava di calcolare il π (per la cui approssimazione bisognerà attendere Archimede), ma di ricercare una sequenza di trasformazioni sulle figure che rendessero equivalenti un cerchio e un quadrato.

La tradizione teorica si tramandava attraverso la scrittura e la scuola, che nelle città greche andava assumendo caratteri moderni: relativamente di massa, spesso pubblica e fondata ai livelli elementari sul leggere, scrivere, far di conto: cioè manipolare segni.

Certo, ci furono nel mondo greco matematici in cui coesistevano entrambe le tradizioni: il “teorico” Archimede fu anche grande ingegnere e il “pratico” Erone (i sec. a.C. - i-ii sec. d.C.) fu anche ottimo geometra: non a caso a Erone si attribuisce la formula per il calcolo dell’area del triangolo a partire dalle lunghezze dei suoi lati, una regola che per il suo carattere metrico sarebbe stata impensabile per Euclide. Tuttavia la distinzione tra queste due tradizioni era molto più netta di quella attuale tra matematica pura e applicata, le quali condividono sostanzialmente metodi, concetti, linguaggi e istituzioni formative.

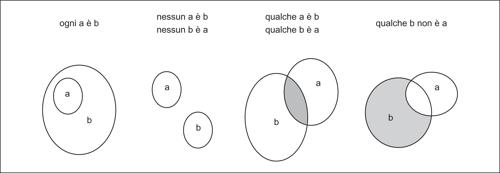

Aristotele e la strutturazione deduttiva

L’aspetto centrale della tradizione teorica era la ricerca di una strutturazione deduttiva della matematica, intuita già dai pitagorici. Tale sviluppo fu portato a compimento nel iv secolo dai matematici, soprattutto nell’ambiente dell’Accademia di Platone (427-347 a.C.), e fu teorizzato da Aristotele (384-322 a.C.), il più brillante degli allievi. Nei suoi libri Analitici prendevano forma la logica e la dottrina della scienza, a partire dalla dialettica platonica, dal lavoro dei matematici e dagli sviluppi della filosofia naturale. Alla base vi era un sistema di principi formali: il principio del terzo escluso («di un oggetto una qualsiasi determinazione deve essere o affermata oppure negata»), il principio di non contraddizione («non è possibile affermare e al tempo stesso negare qualcosa di un oggetto») e la verità per corrispondenza («è vero dire che è ciò che è e che non è ciò che non è, è falso dire che è ciò che non è e che non è ciò che è»).

Questo sistema di principi era valido solo al prezzo di frantumare il campo unitario platonico del sapere in un arcipelago di scienze “regionali”, all’interno di ciascuna delle quali i principi avevano piena validità. Il mondo aristotelico era fatto di sostanze individuali cui potevano essere associati attributi, soprattutto qualità e quantità. Ogni scienza si riferiva a un genere di sostanze ben determinato, sulla base di un sistema di assiomi (proposizioni note e universalmente accettate) e di definizioni di attributi appropriati per quel genere: la dimostrazione permetteva allora di costruire le verità di tale scienza. Le scienze non comunicavano tra loro, a meno che una scienza non fosse subordinata a un’altra (come la musica all’aritmetica o l’astronomia alla geometria).

Il ragionamento scientifico assunse la struttura del sillogismo, una forma di argomentazione in cui da due premesse con un termine in comune si ricavava una conclusione, che resterà per duemila anni la base della logica. Una forma semplice di sillogismo era: dalle due premesse «tutti gli ateniesi sono greci» e «tutti i greci sono mortali», si concludeva che «tutti gli ateniesi sono mortali». Premesse e conclusione potevano essere universali o particolari, affermative o negative; inoltre il termine comune poteva trovarsi in ruoli diversi nelle premesse. Aristotele studiò tutte le combinazioni possibili di sillogismo e individuò quelle che effettivamente erano valide. È facile infatti notare che certe coppie di premesse non permettono di ricavare alcuna conclusione: per esempio nulla si può dedurre sull’altezza degli ateniesi a partire dalle due premesse «qualche ateniese è biondo» e «qualche biondo è alto».

La logica rispecchiava perfettamente la fisica: la proposizione era descritta come soggetto + predicato, riflesso di un mondo fatto di sostanze con annessi attributi, e il sillogismo doveva in realtà riprodurre le relazioni causali, dove la parola causa aveva soltanto un senso esplicativo dei fenomeni (era la risposta alla questione «perché?»).

Tale dottrina della scienza restò pressoché invariata fino al rinascimento, anche se alla sua ombra sopravvivevano i sottili paradossi formali della logica, il più importante dei quali era il paradosso del mentitore: «io sto mentendo». Se questo enunciato è vero vuol dire che è falso, ma se è falso allora è vero. Un paradosso destinato a sopravvivere fino ai giorni nostri, legato alla compresenza nella stessa proposizione della negazione, dell’essere, della verità.

Matematica e filosofia

La matematica e la filosofia erano discipline “sorelle”. Entrambe concernevano la verità necessaria, l’essere e il discorso razionale, trovando le loro radici nel fatto che vedere, conoscere ed essere per i greci erano verbi profondamente connessi («idea» e «vedo» hanno un’origine comune e, per Aristotele, «non si può pensare senza immagini»); visuale era anche l’origine dei verbi di conoscenza come noéo, theoréo), la stessa «verità» (alétheia) era originariamente la negazione dell’oblio e del nascondere; gli enti matematici erano immanenti e immediatamente percepibili e nel contempo aspetti di conoscenza razionale.

Così, sul materiale ereditato dalla matematica pregreca, i pitagorici e successivamente Platone avevano eretto una filosofia complessa che da un lato accettava l’aspetto pratico della matematica (economico e sociale), e dall’altro concepiva il numero e la figura geometrica come parte integrante dell’ontologia in quanto mediatori di una realtà ideale ed elementi essenziali della stessa descrizione del cosmo: i pitagorici vedevano nel numero il costituente base della realtà, mentre per Platone gli enti matematici erano un ponte tra il «mondo delle idee» è la realtà naturale, così che Platone nel Timeo descriveva il cosmo con misure prive di ogni valore empirico ma tratte dai rapporti armonici musicali, ma al tempo stesso esortava Eudosso a «salvare i fenomeni» astronomici, trovandone una descrizione matematica. Su questa base tutta la tradizione pitagorica e platonica per millenni coltiverà una numerologia filosofica e teologica, ma anche una geometria descrittiva e l’idea di una presenza dei numeri nella realtà.

Diversa la collocazione della matematica nel sistema aristotelico delle scienze: da un lato essa riguardava l’essere reale nei suoi aspetti puramente logici in quanto scienza della struttura esplicativa del reale, scienza delle cause, della spiegazione dei fenomeni e quindi modello deduttivo per tutte le scienze, dall’altro il suo essere astrazione (rispetto alla materia e al divenire) ne faceva una sorta di impoverimento del reale: la matematica era un frammento del linguaggio naturale che forniva la spiegazione razionale dei fenomeni, ma la sua stessa certezza era un limite, segno di una “purezza” che finiva per configurarsi come “povertà” rispetto alla realtà naturale. Ne derivava un ruolo prevalentemente epistemologico e metodologico ben diverso dal ruolo ontologico che essa aveva in Platone.

La dimostrazione e l’incommensurabilità

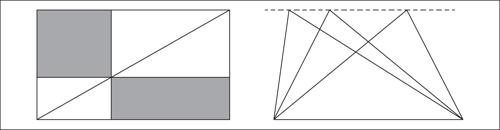

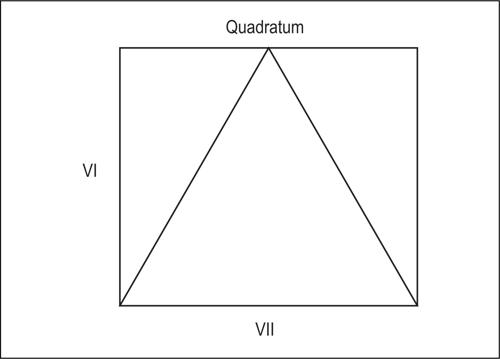

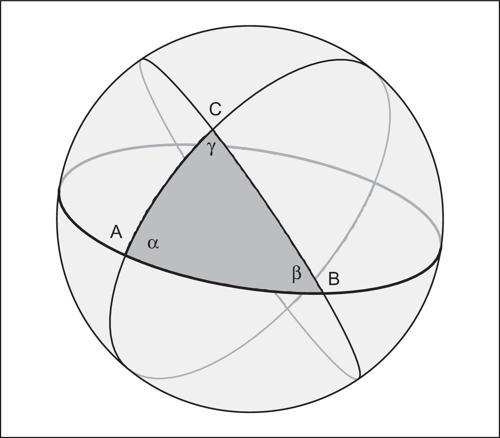

Nella tradizione teorica non vi era spazio per l’algebra: tutto era percepito geometricamente, numeri inclusi. I soli enti utilizzati erano le figure geometriche e l’unica argomentazione era la dimostrazione. Le radici di questa tradizione si possono riconoscere nei pitagorici, i quali avevano verosimilmente rielaborato un’idea, importata dall’Oriente, di costruzione geometrica, cui veniva riconosciuto il ruolo di dimostrazione a partire da elementi, proposizioni e costruzioni più semplici. Infatti i babilonesi, pur non avendoci lasciato vere dimostrazioni geometriche o aritmetiche, conoscevano bene proprietà geometriche come il teorema di Pitagora: non solo qualche terna pitagorica, come (3, 4, 5) oppure (5, 12, 13), ma la proprietà generale, che probabilmente riconoscevano come costruzione geometrica evidente. La fig. 7 è una possibile costruzione geometrica per dimostrare il teorema. Non la si trova nei testi mesopotamici, ma appare nei più antichi testi cinesi e indiani.

Il ruolo della costruzione nella matematica greca è anche testimoniato dal rilievo che sin dall’inizio vi ebbero alcune costruzioni particolari, quali la quadratura del cerchio, la duplicazione del cubo, la trisezione dell’angolo.

Il passaggio dalla costruzione alla dimostrazione geometrica è uno degli episodi più affascinanti della storia della matematica. La dimostrazione all’inizio era probabilmente solo la descrizione per iscritto della costruzione di una figura, eseguita precedentemente per via orale e visuale: in greco diagramma significava «dimostrazione» oltre che «figura», e negli Elementi ogni dimostrazione era associata a una e una sola figura, talora di una banalità sconcertante. La semplice trascrizione sembra una novità irrilevante, ma i geometri greci si accorsero che così si evitava di scoprire erroneamente proprietà non generali ma valide solo per una particolare figura. Inoltre introdussero un nuovo tipo di dimostrazione, quella per assurdo, che non corrispondeva a nessuna costruzione effettiva, ma solo a una costruzione “impossibile”.

In effetti l’assurdo aveva già fatto la sua comparsa nella filosofia greca, per esempio nei paradossi di Zenone, ma solo come confutazione, come una sorta di espediente retorico per polemizzare con l’avversario. Nell’uso retorico delle contraddizioni erano maestri i sofisti, e la storia della logica antica è fondata sullo sforzo dei grandi filosofi vissuti tra la fine del v e il iv secolo, Socrate, Platone, Aristotele, di riportare le tecniche dell’argomentazione nel campo delle verità e della scienza. La semplice confutazione di un discorso avverso non è la dimostrazione della tesi contraria. Dimostrare che una tesi è assurda non significa dimostrare che la tesi opposta sia vera: a tal fine è necessario chiamare in causa il principio di non contraddizione e quello del terzo escluso, i principi formali della logica aristotelica.

Tra i risultati scoperti e dimostrati per assurdo appare uno dei teoremi più importanti di tutta la storia della matematica: l’incommensurabilità di lato e diagonale del quadrato, in termini moderni l’irrazionalita di √(2). Oggi se ne trova sui testi una dimostrazione per assurdo di tipo aritmetico: se diagonale e lato del quadrato fossero commensurabili, le loro lunghezze sarebbero nel rapporto m : n, con m e n interi e relativamente primi (se non lo fossero si potrebbero entrambi dividere per il fattore comune), in particolare non entrambi pari. Essendo 2 il rapporto dei quadrati costruiti su di essi (per il teorema di Pitagora), sarebbe m2 : n2 = 2. Da qui segue che m deve essere pari, poniamo m = 2k, e quindi sarebbe n2 : k 2 = 2. Quindi anche n sarebbe pari, contrariamente alla ipotesi secondo la quale m ed n sarebbero relativamente primi. Il che è assurdo. Ma in una tale dimostrazione il 2 appare come numero astratto, un sostantivo, mentre i numeri allora erano solo aggettivi. Tra il v e il iv secolo la dimostrazione doveva essere di tipo geometrico e prima ancora probabilmente fondata sulla teoria aritmetica della musica, la cosiddetta armonica. Infatti, la prima matematica greca originale, sviluppata dai pitagorici e non derivata semplicemente dall’Oriente, fu lo studio delle consonanze fra le note, misurate dai rapporti tra le lunghezze delle corde che davano tali consonanze: 1 : 2 (armonia di ottava), 2 : 3 (di quinta), 3 : 4 (di quarta).

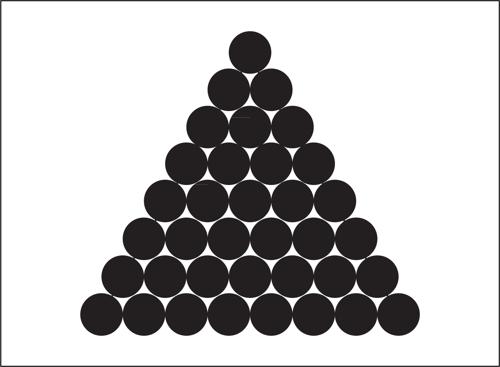

Pitagora (570-490 ca a.C.) era originario di Samo. Coinvolto come tanti greci dell’epoca negli scontri politici della sua pólis, fu costretto a emigrare verso l’Italia meridionale, la Magna Grecia. Queste migrazioni erano un fenomeno diffuso nelle città elleniche dell’epoca. Provocate da ragioni politiche ed economiche, trapiantavano in un terreno vergine frammenti di società greca, creando un ambiente sociale più destrutturato di quanto fosse la pólis, che già risultava molto meno gerarchizzata rispetto alle società orientali e con una religione meno professionalizzata di quella delle caste di scribi del tempio orientale. I pitagorici furono una setta politico-religiosa che trasmutò le conoscenze tecnico-matematiche importate dall’Oriente in una «educazione liberale», in un sapere generale laico e religioso, politico e sociale, per governare le città della Magna Grecia: Metaponto, Crotone, Sibari, Taranto. Così aspetti tecnici come l’uso dei sassolini sull’abaco per studiare le figure geometriche sono forse all’origine di ipotesi filosofiche quale quella di studiare tutti i numeri, e anche tutti gli oggetti reali, in base alla loro forma geometrica discreta (in fig. 8: triangolari, quadrati, rettangolari, lineari ecc.).

Anche la musica aveva un’importanza a fini politici: essa non era un semplice intrattenimento, ma l’autentica colonna sonora della vita religiosa e sociale della pólis greca, al punto che Platone ripeterà: «Credo che i modi musicali non possano essere cambiati senza cambiare le leggi fondamentali della pólis».

Per governare occorreva dominare i modi musicali e questo creava problemi aritmetici: per esempio, per dividere in due parti uguali l’ottava occorreva trovare un x tale che 1 : x = x : 2. Oggi diremmo che x vale √(2), un numero irrazionale, ma per i pitagorici i numeri erano solo interi; solo verso la fine del v secolo a.C. Archita (430 ca-360 ca a.C.), l’ultimo grande pitagorico, scoprì che non esistevano soluzioni intere (o razionali). È questa probabilmente l’origine della incommensurabilità.

La matematica nella cultura antica

La geometria

Al centro della tradizione teorica si collocava la geometria, poiché la scienza greca era incentrata sulla presentazione visuale dell’essere, impermeabile al divenire naturale.

Come già si è accennato, era una geometria assiomatizzata e non metrica, perpetuata negli Elementi di Euclide, per duemila anni autentico monumento dell’umana ragione e culmine di una sequenza di libri di «elementi» apparsi nel iv secolo soprattutto intorno all’Accademia platonica, e derivati dall’idea pitagorica di una connessione costruttiva necessaria tra le proposizioni geometriche, da quelle più ovvie a quelle più complesse. Proclo scrive nei suoi Commentari al I libro degli Elementi che rispetto ad antichi libri di «elementi» Euclide aveva reso più rigorose e più astratte le dimostrazioni, sviluppandole per assurdo, e aveva esteso anche l’uso della teoria delle proporzioni.

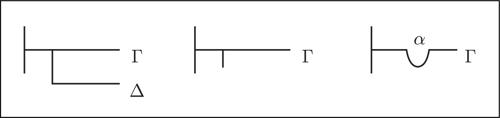

Oltre alle definizioni, all’inizio del libro sono elencati postulati e nozioni comuni (assiomi). I primi hanno un carattere più costruttivo, le seconde appaiono come proprietà logiche dell’uguaglianza, probabilmente necessarie per trasformare antiche dimostrazioni basate sulla evidenza visuale in dimostrazioni rigorose per assurdo.

Le proposizioni appartengono poi a due categorie ben distinte, i teoremi e i problemi: i primi riguardano proprietà delle figure, i secondi invece costruzioni di enti geometrici, fondamentali in un’idea di dimostrazione emersa dall’idea di costruzione geometrica.

Il metodo euclideo è detto assiomatico-deduttivo, un’espressione usata anche per la matematica moderna, ma con un diverso significato. In realtà l’uniformità è solo apparente. Nella geometria greca, come del resto ancora oggi nell’insegnamento fino alle scuole superiori, non si fa differenza tra dimostrabilità e verità. Eppure la differenza è evidente. Si consideri per esempio la proposizione «in ogni triangolo la somma degli angoli interni è due angoli retti»; la sua dimostrazione è una paginetta di proposizioni concluse dalla frase «come volevasi dimostrare», e dopo la quale non sussiste alcun dubbio sulla validità del teorema. Se volessimo stabilirne la verità dovremmo invece prendere «tutti» i triangoli (ritagliati sul cartoncino, costruiti tramite le punte dei campanili, delle montagne e anche usando stelle e galassie) e calcolare su di essi la somma degli angoli interni. Sono due procedure del tutto diverse: la prima è unica anche se generale (su un triangolo «qualsiasi») la seconda è infinitaria (su «tutti» i triangoli); la prima è assolutamente certa, la seconda è sempre approssimata. Questa è la differenza tra sintassi (la manipolazione delle proposizioni secondo regole puramente formali e quindi indipendenti dal significato dei termini) e semantica (assegnazione del significato ai singoli termini e conseguente significato globale della proposizione). Per i greci questa distinzione non esisteva: ciò che era dimostrabile era vero e ciò che era vero era dimostrabile, eccezion fatta per gli assiomi e i postulati, la cui verità doveva essere del tutto evidente.

Diverse erano le conseguenze di questa coincidenza tra sintassi e semantica. In primo luogo, i termini tecnici della geometria euclidea non ricevevano il loro significato dalle definizioni, ma lo possedevano già come termini del linguaggio naturale, che la definizione si limitava a precisare. In secondo luogo, da Aristotele a Proclo, si distingueva tra teoremi in cui la deduzione aveva un ruolo «causale» e teoremi in cui la deduzione era puramente «formale», come per esempio nel teorema precedente, nella cui dimostrazione appaiono gli angoli esterni al triangolo, i quali non possono avere alcun ruolo causale sul triangolo (la somma degli angoli interni sarebbe due angoli retti anche se gli angoli esterni non esistessero).

In realtà la logica aristotelica aveva diverse radici: la teoria del sillogismo derivava dalla filosofia naturale (col sillogismo a mimare la relazione causale), la dottrina della scienza dalla geometria, e infine il sistema dei principi dalla dialettica. Così che, più che di una derivazione diretta del sistema assiomatico-deduttivo euclideo dalla logica aristotelica, si deve piuttosto parlare di una profonda affinità.

La conseguenza più celebre di questa coincidenza tra sintassi e semantica è stata per duemila anni la questione del v postulato, relativo alle parallele. Esso afferma: «Se una retta incidente due rette crea angoli interni sullo stesso lato minori di due retti, le rette, qualora prolungate all’infinito, si incontreranno dal lato sul quale gli angoli sono minori di due retti» (era una sorta di postulato di costruzione del triangolo); oggi si esprime nella forma: «Dati una retta e un punto a essa esterno, per tale punto passa una e una sola retta parallela alla prima». Tale postulato era ritenuto vero perché legato a tante altre proposizioni vere (costruzione del quadrato, teorema di Pitagora ecc.), ma non sembrava evidente. Di conseguenza doveva essere dimostrabile ma, nonostante decine di tentativi autorevoli, nessuno era riuscito a darne una dimostrazione. Solo nel xix secolo l’emergere della distinzione tra sintassi e semantica rese concepibili geometrie in cui tale postulato non era soddisfatto.

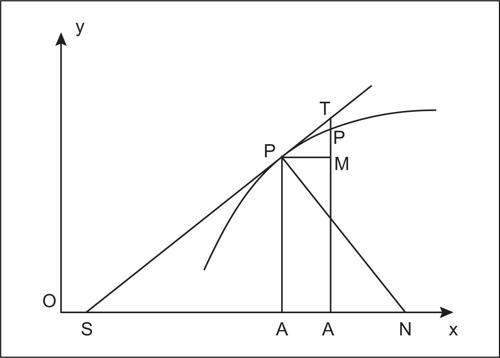

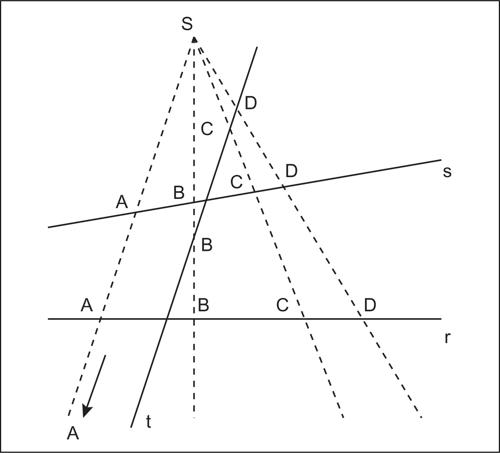

La dimostrazione procedeva da «cose più note» verso «cose meno note», dagli assiomi/postulati ai teoremi/problemi, una procedura nota anche come sintesi, che caratterizza lo stile di Euclide negli Elementi. Ma nella matematica greca appariva anche la procedura opposta, detta analisi, che partiva da «ciò che si cerca» per risalire a «ciò che già si sa». L’idea fondamentale era quella che invertendo le deduzioni di una delle due procedure si otteneva l’altra, ma in realtà A ⇒ B non implica B ⇒ A, così che per garantire la correttezza logica dei risultati l’analisi doveva sempre essere seguita dalla sintesi corrispondente.

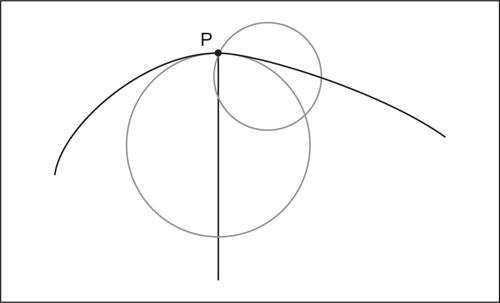

Maestro dell’analisi fu Apollonio (262 ca-180 ca a.C.). Per capirne la grandezza basta pensare che sviluppò la teoria delle coniche (le figure ottenute per sezioni di un cono tramite un piano al variare della sua inclinazione: cerchio, ellisse, parabola, iperbole), nata probabilmente da esperienze di misurazione astronomica (meridiana, astrolabio), in quanto le stelle si muovono rispetto a un osservatore terrestre su cerchi che col vertice nell’osservatore formano un cono, la cui sezione con un piano è una conica. Apollonio ottenne per via geometrica tradizionale gran parte di quello che oggi si studia sull’argomento usando il formalismo algebrico.

Aritmetica teorica e aritmetica pratica

Del tutto diversa era la struttura dell’altra disciplina fondamentale, l’aritmetica. Gli Elementi includevano anche tre libri aritmetici (vii, viii, ix), in cui l’aritmetica veniva trattata rappresentando i numeri come segmenti. Era un’aritmetica basata su postulati e dimostrazioni, e sui concetti di rapporto e di proporzione, in un certo qual modo adottata dalla geometria.

L’aritmetica pratica aveva però una struttura molto diversa: non usava dimostrazioni ma esempi, ed era anche legata al calcolo e alla misura. Inoltre appariva organicamente connessa alla filosofia e alla teologia, dominata da un clima pitagorico e platonico fino alla fine dell’antichità: il testo più importante dell’aritmetica greca fu quello di Nicomaco, vissuto ad Alessandria tra i e ii secolo d.C., il più noto di una serie di testi in cui l’aritmetica veniva descritta all’interno della tradizione neoplatonica, senza alcuna parentela con la grande tradizione dei geometri teorici e nella quale ogni numero era figurato ed entrava direttamente nella costituzione stessa della realtà.

La notazione numerica dei greci era poco funzionale. Niente di strano che al mercato usassero una notazione simile a quella degli antichi romani, con un asta per indicare l’uno e poi l’aggiunta di un’asta per il successore, e l’uso delle iniziali dei numeri in greco per indicare numeri particolari, cinque (Π, pente in greco), dieci (Δ, deka in greco) ecc. Sorprende che i grandi matematici greci usassero per i numeri le lettere dell’alfabeto: α per l’uno, β per il due, e così via. L’alfabeto greco ha 24 lettere, aggiungendo tre lettere arcaiche di origine fenicia si arrivava a 27 simboli con cui denotare le nove cifre, le nove decine, le nove centinaia. E poi, dopo 999? Bisognava usare apici. Ma con un simile sistema erano molto difficili anche le somme elementari. Come si spiega l’uso di questa notazione davvero poco funzionale? In primo luogo, esso era probabilmente una conseguenza del fatto che il linguaggio della matematica greca era un frammento del linguaggio greco comune. In secondo luogo occorre osservare come questa rappresentazione introducesse il carattere ordinale e non solo cardinale del numero (e Piaget ha descritto come nel bambino il numero astratto nasca dal coordinamento tra i suoi aspetti cardinali e ordinali). In altri termini, la difficoltà nel calcolo era il prezzo da pagare per fare dell’aritmetica un frammento autonomo del linguaggio e concepire il numero come un ente astratto e non solo come un aggettivo.

Non esistevano né i numeri reali né i numeri razionali (eccettuate le parti, cioè le frazioni unitarie quale 1/n, molto usate già in Egitto). Ovviamente, al mercato esistevano dei modi pratici per trattare le frazioni, ma questo non aveva nessuna eco nell’aritmetica greca.

L’architettura complessiva della matematica era quella del quadrivio, in cui alle due discipline di base, aritmetica e geometria, si aggiungevano altre discipline che il medioevo chiamerà miste: in primo luogo astronomia e musica per completare il quadrivio, e poi anche ottica e statica. Altre scienze miste verranno aggiunte nel medioevo.

Queste discipline erano dette miste perché apparivano “inquinate” dalla fisica. La matematica, in quanto scienza dell’essere, non poteva essere applicata alla fisica né ad alcuni suoi settori quali la meccanica, la biologia, la psicologia, perché la fisica trattava del divenire (phýsis era la natura vista nel suo continuo fluire, e anche l’anima era considerata un ente naturale). In altri settori della fisica il divenire tuttavia non appariva: nella statica, ma anche in ottica, che non considerava la luce come “in moto”, ma ne considerava solo gli aspetti geometrici; in musica, in cui le consonanze erano trattate come rapporti fissi; in astronomia, in cui si ignorava il concetto di traiettoria dei corpi celesti e si studiavano solo le proprietà geometriche delle grandi sfere rotanti, ma fisse, nelle quali i corpi celesti erano incastonati. L’astronomia greca chiarisce il senso della geometria greca. Mentre i babilonesi avevano dato vita a un’astronomia d’osservazione, caratterizzata da grandi quantità di dati e una notevole capacità di previsione dei fenomeni astronomici (come le eclissi lunari), ma priva di un modello dei cieli, i greci elaborarono un’astronomia senza dati osservativi e costituita solo da un modello dei cieli, il cosmo, basato su sfere rotanti e complicato da sfere rotanti incastonate in altre sfere rotanti. Solo più tardi, soprattutto con Claudio Tolomeo, questo modello geometrico si arricchì dei dati osservativi e costituiì il cosiddetto sistema tolemaico che resse fino a Copernico. L’Almagesto (nome arabo che significa «il più grande») è il capolavoro di Tolomeo; insieme agli Elementi costituisce la grande eredità della scienza greca, e, insieme alle opere di Nicomaco, Erone e Diofanto, segna l’epoca d’oro della tradizione pratica in Alessandria.

Il continuo e l’infinito

L’idea di continuo non aveva natura immediatamente matematica, ma proveniva dall’indagine filosofica sull’essere e il divenire (il moto), iniziata dagli eleati (Zenone ne aveva rivelato i paradossi) e sviluppata da Platone e Aristotele, il quale ne aveva dato una doppia caratterizzazione tuttora valida: l’(infinita) divisibilità (dalla quale deriva l’idea moderna di denso in sé) e la dicotomia in parti con elemento comune (dalla quale deriva l’idea di continuità costruita sulla base delle sezioni di Dedekind). Era un concetto fondamentalmente fisico, estraneo alla matematica: il termine continuo (synechés), come opposto di discreto, negli Elementi non appare mai.

Anche l’idea di infinito non apparteneva alla matematica ed era un concetto sostanzialmente fisico. In Euclide il termine infinito (ápeiron) appare in forma solo avverbiale, per affermare che la retta può essere prolungata illimitatamente: era l’infinito potenziale («si può sempre aggiungere qualcosa») che si ritrova soprattutto nella serie dei numeri interi, mentre l’infinito attuale («non si può aggiungere nulla») era precluso, in quanto fonte di dubbi e paradossi. Questi due infiniti erano l’uno il contrario dell’altro, e non il contrario del finito. Anche le sezioni coniche, prima di Apollonio, erano costruite su coni finiti. Quella euclidea era una geometria piana senza il piano, una geometria solida senza lo spazio, una geometria di figure e solidi finiti che non richiedono un ambiente infinito che li contenga.

Lo stesso Apollonio nel suo studio delle coniche introduce rette di riferimento sulle quali “proiettare” le posizioni di punti delle curve, individuando segmenti tra i quali riconoscere relazioni geometriche nella forma di rapporti caratteristici delle curve (chiamati sýmptoma). Molti storici hanno creduto di riconoscere in queste enunciazioni i prodromi della geometria analitica moderna (con gli assi x, y, z di un sistema di riferimento, le coordinate dei punti, le equazioni delle curve). C’è però un’importante differenza: i concetti di Apollonio erano intrinseci alla curva (assi, diametri, tangenti), mentre quelli moderni sono estrinseci a essa e relativi invece a uno spazio indipendente che contiene la curva.

Tale preclusione nei confronti dell’infinito attuale si associava poi a quella nei confronti dell’esistenza reale del punto. Il punto infatti, come sarà poi per il numero reale, richiede una suddivisione infinita attuale del segmento, poiché una suddivisione infinita potenziale produce solo intervalli. E risulta chiara anche l’impossibilità di considerare un segmento come costituito dai suoi punti: come potrebbe un ente di grandezza finita essere costituito dall’unione di infiniti enti privi di grandezza? E si può concepire il punto immediatamente successivo a un altro punto? Non è possibile, poiché se tale punto è distinto allora tra i due punti esiste un intervallo il cui punto medio si colloca fra di essi, e quindi il punto trovato non è quello immediatamente successivo.

Aporie erano già emerse in Democrito (460 ca-370 ca a.C.), che si era posto il problema di considerare un cono come unione delle sue sezioni parallele alla base: se tali sezioni erano uguali allora la loro unione era un cilindro, se invece erano disuguali allora la loro unione era un cono “a gradini”.

Platone considerò i punti solo finzioni geometriche, in realtà non esistenti. Aristotele li ritenne esistenti ma solo in potenza, così che tutti i punti di un intervallo esistono in potenza ma non possono costituirlo poiché avrebbero bisogno a tal fine di esistere in atto, creando le difficoltà sopra accennate. E del resto, quando un punto divide in due un segmento, il punto stesso si duplica come estremo di entrambi, e il duplicato così nascerebbe dal nulla, ma nihil ex nihilo. L’idea di base era che l’essere del punto si esaurisse nella sua individuazione come estremo o intersezione, senza avere altra forma autonoma di esistenza.

L’infinito quantitativo

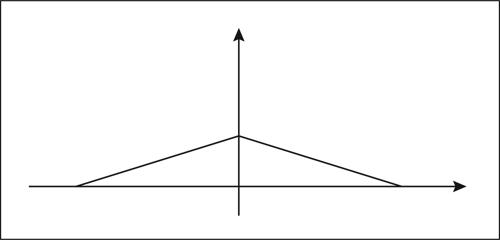

Ad Aristotele si deve l’inizio della teoria dell’infinito quantitativo, costruito sulla dicotomia della quantità in discreta e continua. Egli osserva come i numeri ammettano un minimo indivisibile (l’unità) ma non un massimo (l’infinito è solo potenziale), mentre le grandezze (geometriche), il cui paradigma era l’intervallo, non ammettano un minimo (sono potenzialmente divisibili all’infinito) ma abbiano un massimo (l’universo aristotelico era finito).

Le proprietà fisiche diverse da tempo e spazio (peso, velocità, calore ecc.) erano «qualitative». Quantità erano solo da un lato quelle geometriche e il tempo (continue), dall’altro i numeri e il linguaggio (discrete); per questo le velocità potevano essere confrontate solo come spazi percorsi in un tempo fisso o come tempi impiegati per percorrere una data distanza.

La misura era un concetto essenzialmente aritmetico: un numero “misurava” i suoi multipli, ne era cioè una parte. Al mercato si misurava il peso o la lunghezza, ma erano numeri accidentali. Mentre infatti l’unità di misura del gregge di pecore era intrinseca, sostanziale (la singola pecora), l’unità di misura della lunghezza era il braccio o il piede. Ma il braccio o il piede di chi? Era una misura puramente accidentale, e città diverse avevano unità di misura diverse. La geometria si doveva quindi strutturare senza una metrica. E anche queste misure accidentali erano sempre numeri interi, connesse tra di loro tramite fattori moltiplicativi accidentali e interi, come nelle misure inglesi: ci sono piedi e pollici, 12 pollici fanno un piede. Ma non è lo stesso che dire che 100 cm equivalgono a 1 m: infatti 12 è solo un rapporto accidentale tra unità autonome ed eterogenee, anche se convenzionalmente consolidato.

Per i greci, in realtà, irrazionali potevano essere i rapporti (relativi a grandezze incommensurabili), ma non i numeri. Per essi i numeri erano solo interi, cardinali e finiti, erano di fatto aggettivi (1, 2, 3, 4, 100, 1000, 10000 erano declinati in genere, numero e casi), erano molteplicità definite, attributi reali. Era anche difficile considerare l’insieme dei numeri, poiché questo significava ammettere l’infinito: così Euclide non dice «ci sono infiniti numeri primi», bensì «i numeri primi sono più di ogni molteplicità proposta di numeri primi», e nelle dimostrazioni non compare mai esplicitamente il principio di induzione completa, sempre sostituito da dimostrazioni (generalizzabili) per un numero finito, nonostante appaiano postulate proprietà sostanzialmente equivalenti, come «non è possibile una sequenza infinita decrescente di numeri interi».

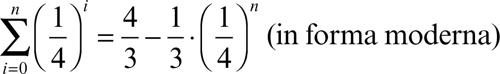

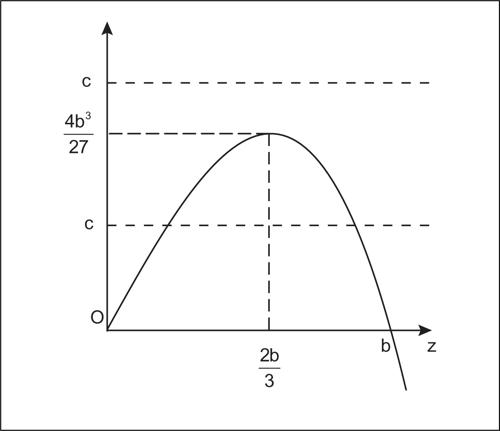

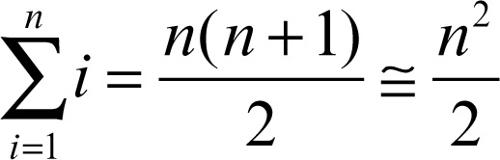

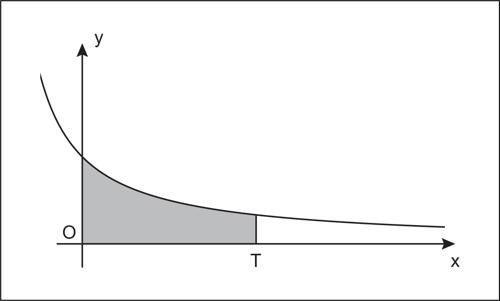

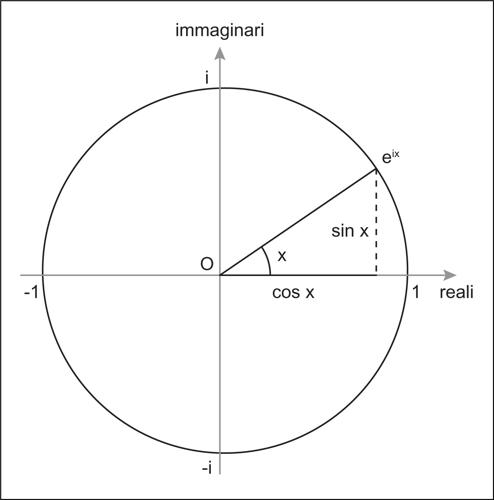

Persino Archimede, il più «infinitista» dei matematici greci, calcola la somma della generica progressione geometrica di ragione 1/4 e lunghezza n:

ma non riesce a intuire la somma della serie geometrica (per n → ∞).

Se si chiede oggi a uno studente di rappresentare con una immagine il sistema dei numeri, probabilmente egli disegnerà una retta, con un punto indicato con 0 e un altro indicato con 1. Traccerà cioè la retta numerica, con la quale si rappresenta oggi la corrispondenza biunivoca tra numeri reali e punti della retta, scrivendo un numero reale come due sequenze di cifre separate da una virgola, √(2) come 1,41421356…., π come 3,14159…, un numero reale generico come: … a3a2a1a0,a−1a−2a−3 … senza accorgersi del fatto che quella piccola virgola separa due universi radicalmente differenti in tutta la storia della matematica, che solo quattro secoli fa hanno trovato un punto di raccordo. La prima sequenza, a sinistra della virgola, appartiene al dominio dei numeri interi, alla numerazione, utilizzata per contare uomini e pecore, origine dei segni numerici. Al di là della virgola, la seconda sequenza appartiene a un mondo parallelo ma distinto: l’universo delle grandezze divisibili. Inoltre, mentre la prima sequenza è sempre finita anche se potenzialmente illimitata, la seconda può e deve essere attualmente infinita per denotare un generico numero reale.

Un greco avrebbe invece rappresentato il sistema dei numeri disegnando due semirette puntate verso il basso, come un lambda maiuscolo, Λ, tracciando quella che è appunto detta figura lambdoide. L’origine comune era indicata con 1, una delle due semirette segnata con i numeri interi 2, 3, 4, …, e l’altra con le frazioni 1/2, 1/3, 1/4, …, quelle che i greci chiamavano le parti.

L’uno non era un numero, ma il “seme” delle due sequenze, e lo zero non esisteva. Addirittura le definizioni euclidee erano date in modo da escludere anche l’angolo nullo o il rapporto nullo. La ragione di questa stranezza che durerà fino al rinascimento la si può leggere nel Sofista di Platone: «Poni che uno alla domanda “a che cosa può essere riferito questo predicato, il non essere”, osasse dare una risposta, ebbene, a quale oggetto e con quali determinazioni di quantità e qualità riferirebbe tale espressione? […] A ciò che noi indichiamo con l’espressione “ciò che è” non può riferirsi il non essere, neppure a ciò che indichiamo con l’espressione “qualche cosa” […] il singolare è segno di una cosa, […] il plurale di molte cose. E devi ammettere che chi non dice “qualche cosa” non dice niente in assoluto. Inoltre non possiamo ammettere che questo tale “usi una espressione”, ma non dica nulla; bisogna riconoscere che chi crede di dire ciò che non è, non usa espressione alcuna: non dice neppure […]». Il numero è sempre un numero di cose. Esistono quindi il singolare e il plurale, ma non esiste lo zero-ale. Esiste quindi l’uno, esiste il numero, ma non esiste lo zero. La matematica greca era un frammento della lingua greca.

Questo è un altro punto importante. La cultura occidentale, sin dal medioevo, è multilinguista: è consapevole dell’esistenza di molti linguaggi naturali (e delle relative traduzioni), e dell’esistenza di linguaggi formali artificiali (l’algebra, la logica, i linguaggi di programmazione ecc.). I greci erano rigorosamente monolinguisti, consideravano solo il greco. Certo, talora conoscevano altre lingue, ma erano solo “balbettii” (questo in origine il significato del termine «barbaro»). Anche le definizioni, come negli Elementi di Euclide, non servivano a introdurre nuovi termini nel linguaggio ma a delimitare e precisare in geometria l’uso tecnico di normali parole. Emblema di questa centralità teoretica del greco tra i greci è forse la parola lógos, che significava «parola», «discorso» ma anche «rapporto matematico», «ragione», «pensiero», «definizione».

I rapporti nel discreto e nel continuo

A Eudosso (408-355 a.C.) si devono alcuni dei risultati più importanti della storia della matematica. In primo luogo il modello geometrico dei cieli cui si è accennato nel paragrafo precedente. Un secondo contributo essenziale è la sua teoria delle proporzioni, una dottrina centrale per la matematica greca e medievale, essendo l’unico ponte tra discreto e continuo.

Il rapporto, il lógos, era inizialmete un concetto solo aritmetico, ma non un numero, bensì una relazione tra due numeri. Nell’antica aritmogeometria, ovviamente, questo concetto aritmetico poteva estendersi facilmente alla geometria: il rapporto tra base e altezza di un rettangolo nell’abaco era il rapporto tra il numero di unità su di esse. Ma la geometria teorica greca si era distaccata dalla matematica dell’abaco e l’incommensurabilità tra lato e diagonale del quadrato dimostrava che non si potevano ricondurre le figure geometriche a configurazioni di unità: per quanto si riducesse l’unità di misura non si riusciva a misurare contemporaneamente lato e diagonale del quadrato con un numero intero. Eudosso forse osservò come i rapporti tra segmenti incommensurabili, pur non essendo aritmeticamente definibili con esattezza, potevano essere aritmeticamente approssimati quanto si voleva. Già i babilonesi avevano trovato ottime approssimazioni numeriche per √(2). Le approssimazioni si potevano fare o per difetto o per eccesso. Per esempio un’approssimazione per difetto per √(2) è: 1 → 1,4 → 1,41 → 1,414 → 1,4142 →…, una per eccesso è: 2 → 1,5 → 1,42 → 1,415 → 1,4143 → … Qualunque numero razionale si prenda si può sempre dire se sia maggiore o minore di √(2).

Non potendosi esprimere con numeri un rapporto tra grandezze incommensurabili, la questione che Eudosso si pose fu se fosse possibile almeno dire se due rapporti a : b e c : d fossero uguali (l’uguaglianza e la similitudine erano i concetti base della geometria dell’epoca), ossia se valesse la proporzione a : b = c : d. In caso affermativo, le approssimazioni dei due rapporti dovevano essere comuni, e allora qualunque approssimazione m /n se era per eccesso per un rapporto lo era anche per l’altro, e quindi per ogni m e n si aveva che mb > na se e solo se md > nc. La notazione algebrica e aritmetica qui usata era inesistente a quei tempi, ma il ragionamento si poteva fare ugualmente nel linguaggio geometrico dell’epoca, e, considerando quella condizione non solo necessaria ma anche sufficiente, si otteneva la definizione eudossiana della uguaglianza tra rapporti: «Grandezze sono dette essere nello stesso rapporto, la prima con la seconda e la terza con la quarta, quando, per qualsiasi multiplo, gli equimultipli della prima e terza siano entrambi maggiori o uguali o minori dei corrispondenti equimultipli della seconda e della quarta». È nel libro v degli Elementi che viene delineata questa teoria delle proporzioni: i teoremi sono «teoremi generali», in quanto valgono per numeri e per grandezze geometriche, ma non configurarono mai una scienza generale e nel libro vengono riferiti alle grandezze semplicemente perché i greci non concepirono mai un genere comune a numeri e grandezze: la quantità era solo una categoria.

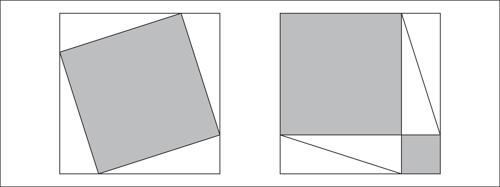

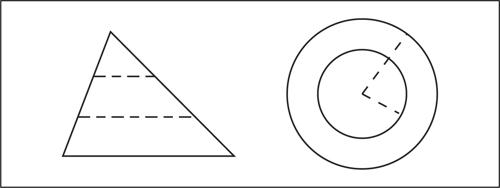

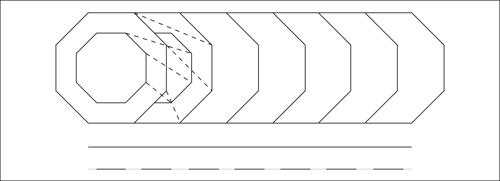

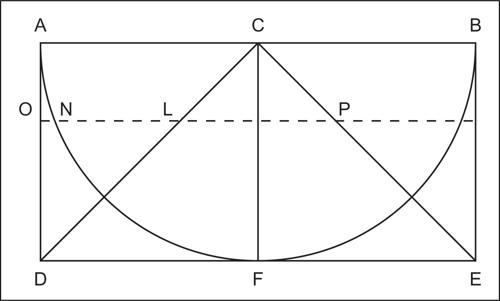

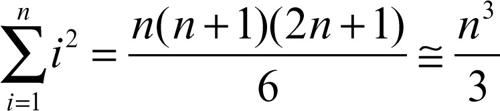

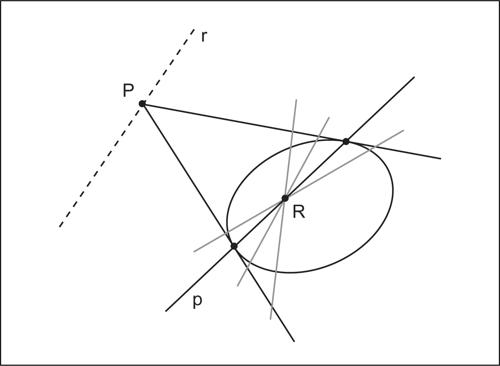

Due rettangoli le cui dimensioni avessero lo stesso rapporto erano simili, e avevano allora un rapporto che era il «doppio» (cioè il quadrato) del rapporto tra le dimensioni. Si dimostrava lo stesso risultato per i poligoni simili e si intuiva qualcosa di simile per i cerchi (fig. 9), considerando un cerchio come un poligono con moltissimi lati. Ma pensare a infiniti lati significava considerare un infinito attuale, qualcosa di inconcepibile.

Per affrontare questi problemi Eudosso ideò il metodo di esaustione.

Si supponga di voler dimostrare che il rapporto tra i cerchi è uguale al rapporto tra i quadrati con lati uguali ai rispettivi raggi (fig. 9). Lo si dimostra per assurdo: se si suppone che il rapporto tra i cerchi A : B sia minore del rapporto tra i quadrati C : D, allora il rapporto tra i quadrati sarà uguale al rapporto tra il cerchio A e una altra figura Σ > B. Si avrebbe allora A : Σ=C : D. Si circoscrivano al cerchio B poligoni regolari con un numero di lati crescente (e quindi con aree decrescenti): L1, L2, L3, …, fino a trovare un poligono Li, con tanti lati da rendere la sua differenza rispetto al cerchio B minore della differenza tra Σ e B. Questo poligono sarà così tale che Σ > Li > B. Si costruisca un poligono con altrettanti lati Mi circoscritto al cerchio A. Tra i poligoni regolari vale il teorema che il rapporto tra due poligoni simili è uguale al rapporto tra i quadrati costruiti sui lati che hanno lo stesso rapporto dei lati dei poligoni, e quindi Mi : Li = C : D. Ma A : Σ = C : D e quindi A : Σ = Mi : Li e allora A : Mi = Σ : Li. Ma il cerchio è minore del poligono a esso circoscritto e quindi Σ < Li. Ma Li era anche minore di Σ: il risultato è assurdo. Un analogo assurdo si verifica se si suppone che il rapporto tra i cerchi sia maggiore del rapporto tra i quadrati.

Nel ragionamento di Eudosso non appaiono né l’infinito né lo zero. Infatti il metodo di esaustione si basava sul teorema x.1 degli Elementi: «Fissate due grandezze disuguali, qualora dalla maggiore sia sottratta una grandezza maggiore della metà [in realtà questa condizione non è necessaria] e da quella restata fuori una maggiore della metà, e questo risulti in successione, sarà restata una certa grandezza che sarà minore della minore grandezza data». Poiché la minore delle due grandezze date può essere scelta a piacere il residuo può essere reso minore di ogni grandezza, ma senza mai ridursi a zero, poiché una grandezza non può diventare un non-essere e l’infinito non è un limite ma solo un luogo impraticabile.

In questo ragionamento le approssimazioni non sono più numeriche, come nell’argomentazione fatta per l’uguaglianza tra i rapporti, bensì geometriche, ottenute da poligoni circoscritti (o inscritti) con un numero crescente di lati, ma il ragionamento è analogo.

Il metodo di esaustione ha però un aspetto che lascia perplessi: può servire per verificare un’ipotesi sulla proporzione tra figure, ma non per scoprirla. In certi casi (come nel caso del cerchio) il rapporto tra le aree sembrava intuibile, ma in altri casi questo non accadeva, come nel caso del rapporto tra figure curve e rettilinee, dove occorre sempre tenere presente che in generale per i greci retto e curvo erano opposti e quindi inconfrontabili. Per esempio Archimede dimostra col metodo di esaustione che il rapporto tra un segmento di parabola e il triangolo isoscele in esso inscritto è 4 : 3. Ma questo rapporto era tutt’altro che evidente. Come l’aveva scoperto? Questi interrogativi presero ad affiorare tra i matematici del xvi secolo, quando si iniziò a studiare, capire e apprezzare gli scritti di Archimede. Molti sospettarono che Archimede disponesse di un “metodo” segreto per scoprire l’ipotesi “giusta”. Sorprendentemente, nel 1906, il filologo danese Johan Ludvig Heiberg (1854-1928) scoprì in un antico palinsesto un testo dove si parlava del «metodo di Archimede». La sorpresa doveva poi trasformarsi in ammirazione per il genio dell’autore: nella dimostrazione si faceva ricorso a una singolare fusione tra geometria e statica (teoria della leva), sviluppata da Archimede in diverse opere, costruendo una configurazione di equilibrio tra il segmento di parabola e il triangolo, tramite la realizzazione delle figure come unione delle loro sezioni parallele (segmenti, e quindi di dimensione inferiore alle figure).

Diofanto

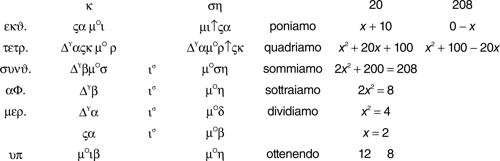

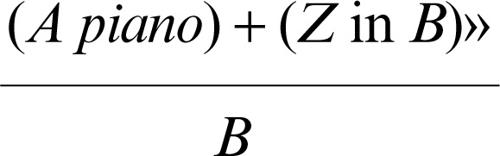

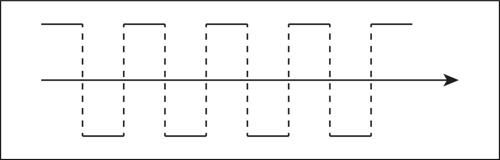

Ad Alessandria è legato anche il nome di un matematico di cui non si sa quasi nulla e che resterà sconosciuto per tutto il medioevo, per diventare famoso con la nascita della matematica moderna: Diofanto (iii sec. d.C.), cui si deve l’ultima grande creazione della tradizione pratica dell’antichità: il primo simbolismo algebrico.

Sin dai babilonesi, l’algebra appare parte integrante della tradizione pratica, come soluzione aritmetica delle equazioni all’interno di una verosimile interpretazione aritmogeometrica dei problemi. In Diofanto si trova invece un autentico simbolismo: ς è l’incognita, probabilmente derivata da arithmós, Δγ è il suo quadrato, Kγ è il suo cubo, ɩσ sta per il segno di uguale (ísos), μO è la monade e ↑ sta per il segno meno. Come si è detto, i numeri venivano rappresentati alfabeticamente.

Eccone un’applicazione che si trova in un matematico bizantino del xiii secolo, editore di Diofanto, Massimo Planude (a sinistra nella tabella, a destra se ne dà una traduzione in forma moderna). Non si conoscono altre versioni precedenti e la notazione potrebbe quindi non essere del tutto quella originaria di Diofanto, ma una notazione simbolica analoga si trova in un papiro matematico che risale al ii secolo, e si può quindi ascrivere la nascita di questo simbolismo algebrico alla matematica pratica tardoantica.

Nell’esempio, si cercano due numeri la cui somma è 20 e la somma dei cui quadrati è 208.

Rispetto agli esempi concreti sulle tavole babilonesi, in Diofanto il problema viene posto in modo astratto. La risoluzione babilonese sembrava seguire i passi di una procedura ben definita, probabilmente legata alla costruzione di una figura (fig. 5) nella quale interpretare i dati numerici del problema e che permetteva di ricavarne la grandezza incognita, mentre Diofanto sembra maneggiare diverse condizioni in forma di equazioni che hanno la loro origine nell’algebra geometrica e nelle proprietà dell’uguaglianza, ma vengono ora manipolate per riscrivere le condizioni del problema. Il tempo della risoluzione non è più quello della costruzione, ma è puramente funzionale, nel senso che la soluzione si ottiene dalla sequenza di diversi passaggi a partire dai dati e dall’incognita del problema (spesso col vincolo di soluzioni intere), e la possibilità di iterare i simboli permette di esprimere potenze superiori alla terza, liberando così tali tecniche dalla limitazione del linguaggio geometrico. L’origine pratica e geometrica delle tecniche e dello stesso linguaggio algebrico appaiono però chiare anche in queste procedure simboliche, come nell’accettazione di sole soluzioni positive o nell’uso di un quadrato disegnato per denotare un quadrato aritmetico, oppure ancora nell’uso del termine «lato» (pleura) per il valore di cui si calcola il quadrato. Non esiste il prodotto tra incognite poiché il quadrato o il cubo non sono il prodotto dei rispettivi lati, ma figure; il prodotto tra un numero e l’incognita o la somma di termini sono date per semplice giustapposizione, come nell’algebra geometrica; i numeri sono semplici aggettivi che devono essere applicati a un’incognita o alla monade per diventare termini. Il segno ↑ compare come la parola «meno» nelle frasi in linguaggio naturale.

È da notare come il calcolo segua la stessa evoluzione della dimostrazione a partire da una comune origine (la costruzione della figura geometrica) tramite una traduzione sintattica, un’analogia questa tra calcolo e dimostrazione che si ripresenterà ancora in matematica. Quanto ciò sia peculiare si può cogliere osservando come le equazioni non comparvero mai nella matematica cinese, che proprio per questo, nonostante il grande sviluppo delle sue tecniche di soluzione dei problemi, non riuscì mai a creare una vera algebra.

La fine della matematica antica

La matematica antica finisce prima della caduta dell’impero romano. I romani avevano sviluppato una fugace passione per la cultura greca, all’inizio del periodo imperiale, al punto che in qualche misura l’impero era diventato bilingue: Cicerone per la filosofia e la retorica, Vitruvio per l’architettura erano state figure in cui riecheggiava la cultura greca. Ma progressivamente la romanità era tornata a prevalere. Del resto la stessa lingua latina mostra l’origine molto più pratica dell’idea romana di conoscenza: mentre i verbi greci di conoscenza richiamavano la visione e la memoria, quelli romani ricordavano l’esperienza pratica: sapio, sapientia («avere sapore»), puto, computo («potare»), penso («pesare»), verus («dritto, spiedo»), cultura («coltivazione»), scientia («tagliare»), forse anche cogito (da cogo, «raccogliere»). La divisione dell’impero in impero d’Occidente e Oriente fu non solo un espediente logistico, ma anche l’esito di una frattura culturale che, a partire dal iv secolo d.C., vide la scomparsa definitiva della matematica (e della filosofia) greca dall’Occidente; solo la retorica vi sopravvisse come traccia di quella antica influenza. La matematica si rifugiò allora nella sua terra d’origine, l’Oriente.

La fine dell’antichità e l’alto medioevo

Fra il v e il x secolo d.C. in Europa occidentale le popolazioni di cultura latina assistono al disgregarsi del loro mondo, sottoposte a invasioni e scorrerie continue dalla Scandinavia, dall’Asia, dall’Europa orientale e dai paesi islamici. La crisi, aggravandosi, travolge la produzione economica, il commercio interregionale, la cultura, e segna il tramonto delle città. Dopo il crollo dell’impero d’Occidente, le aggregazioni politiche che si costituiscono hanno in genere vita difficile: le popolazioni si rifugiano nei villaggi intorno ai castelli che diventano il cuore dei rapporti economici e sociali, delineando quella che viene detta la società feudale.

Il declino della cultura è profondo e inarrestabile: scompaiono le scuole, impallidisce la conoscenza del latino (dopo che quella del greco è caduta in un totale oblio) con l’unica eccezione degli ambienti religiosi, mentre nella vita quotidiana la lingua d’uso inizia a evolversi in quelle che diverranno le future lingue nazionali. Il latino rimane la lingua della cultura, unico strumento unificante della società europea, universale come la chiesa, ma senza vere radici sociali: il suo ruolo è del tutto diverso da quello dell’arabo nell’Islam (il Corano non si può tradurre, mentre i Vangeli sono multilinguistici sin dall’origine: la versione ufficiale della Bibbia è in greco e in latino già nella tarda antichità, e a partire dalla riforma protestante viene tradotta in tutte le lingue nazionali, senza che ciò ne infici il valore religioso), e anche quando nel rinascimento si cercherà una lingua originaria nella quale trovare il vero nome delle cose, la si cercherà nell’ebraico, o addirittura nel cinese, ma non nel latino.

Della matematica sopravvive solo la tradizione pratica nella sua forma più elementare, legata ai più semplici calcoli del commercio, dell’agrimensura e della architettura. Il Codex arcerianus, la principale fonte matematica dell’alto medioevo, raccoglie le conoscenze matematiche di carattere pratico diffuse negli ultimi secoli dell’impero d’Occidente e utilizzate dai gromatici, così chiamati per l’uso della groma, un lungo bastone provvisto in cima di un paio di sbarre orizzontali usato nei rilevamenti per traguardare.

La matematica e il cristianesimo

Unico riferimento culturale dell’Occidente europeo è il cristianesimo, ma il rapporto tra esso e la cultura classica antica è tutt’altro che lineare. Il cristianesimo antico da un lato si diffondeva soprattutto tra strati popolari urbani, dall’altro esibiva una struttura dogmatica sconcertante per la cultura classica (la divinità una e trina, il Cristo uomo e Dio, mangiare il corpo del Cristo, la resurrezione dei corpi ecc.). Era facile per i dotti pagani sottolinearne le assurdità: non è quindi strano che all’inizio si manifestasse l’opposizione tra la nuova religione e l’antica cultura. Tertulliano ne è il testimone più celebre: «Credo quia absurdum, […] tanto stolto da credere in un dio nato, e da una vergine […]. Morto è il figlio di Dio, è credibile poiché è irreale; e sepolto è risuscitato, è certo poiché impossibile». La contrapposizione è totale: «Che cosa hanno in comune Atene e Gerusalemme?».

Tuttavia, il cristianesimo sin dall’inizio è consapevole di doversi misurare con la cultura classica: Paolo predica all’Areòpago di Atene, Dionigi si converte. Così, lentamente, la parola di Cristo si diffonde fra i dotti e inizia una delle simbiosi culturali più importanti della storia.

La cultura delle nuove popolazioni barbariche si afferma nella cultura latina popolare: nelle saghe ed epopee con i cicli arturiano e carolingio, nella poesia col passaggio dalla quantità metrica all’accento e alla rima, nella musica con la nascita della polifonia e degli accordi di terza e sesta. La cultura romana, sconfitta sul terreno popolare, si poteva trincerare solo nella religione e nella filosofia, uniche sue forme di identità culturale nel medioevo. Le grandi questioni teologiche, come le lotte contro le eresie attraverso le quali si è andata formando l’ortodossia cattolica, diventano terreno di battaglia per quelle argomentazioni filosofiche di tipo dialettico e retorico che avevano caratterizzato la cultura classica.

Agostino e l’estensione del concetto di quantità

Tertulliano era nordafricano e la sua formazione era prevalentemente giuridico-retorica. L’Africa settentrionale negli ultimi anni dell’impero romano è un centro culturale di primaria importanza. Da quelle terre e da quell’ambiente proviene anche il più importante pensatore cristiano della tarda antichità: Agostino (354-430). A lui si deve il primo grande tentativo di fondere il platonismo con il pensiero cristiano, ma è anche uno dei pochi e incerti canali della trasmissione del pensiero matematico antico alla cultura medievale: a lui si devono nel De quantitate animae poche pagine contenenti semplici definizioni (punto e segno, figure geometriche) che si ritrovano negli autori medievali. Agostino pone anche un problema nuovo: si può parlare di quantità dell’anima? O di quantità della carità? L’anima non è un corpo, ma è in un corpo e le sue immagini e i suoi ricordi hanno dimensioni; si può parlare di una «grande» anima o di una «maggiore» carità. E le anime si possono anche contare. Si profila così la possibilità inedita di estendere la quantità al di là delle grandezze geometriche, del tempo e del numero di cose.

La cultura nel medioevo

A questo punto si impone un’osservazione generale sull’epoca che si apre: il medioevo, usualmente ritenuto una lunga sequenza di secoli bui, in cui nessuna luce rischiarava il pensiero, e dai suoi stessi difensori esaltato per il trionfo della fede religiosa e dell’irrazionalità cui il rinascimento e la rivoluzione scientifica avrebbero posto fine. Questa lettura ha portato a ignorare il fatto che aspetti essenziali della nuova scienza, del tutto eterogenei rispetto alla scienza antica, siano apparsi già nel medioevo. Lo stesso intellettuale europeo nasce non nell’antichità ad Atene o Alessandria d’Egitto, ma in quelle lande desolate che nell’alto medioevo costituivano l’Europa. Sua prima incarnazione è il monaco benedettino, nel cui precetto «ora et labora» scompare quella scissione netta tra scienza e tecnica tipica della cultura antica, che si formava nella schola, parola che in greco e latino significava «ozio». Nel monastero si studia, si ricopiano i codici antichi, si prega e parimenti ci si dedica all’orto, alla falegnameria, al laboratorio, lavorando pietra e metalli. Le minime competenze matematiche che servivano ai muratori per edificare le chiese antiche si affiancavano a quelle necessarie per calcolare la data della Pasqua. Nella conservazione del patrimonio culturale dell’antichità i monasteri ricoprivano un ruolo non privo di contraddizioni: da un lato molti monaci avevano l’abitudine di cancellare antiche pergamene contenenti testi classici del pensiero greco per scriverci le loro omelie, d’altro lato nell’alto medioevo i monasteri divennero gli unici luoghi in cui quegli stessi classici venivano ricopiati e letti.

Il mondo così come era concepito dal cristianesimo non era eterno e immutabile o ciclico come per gli antichi greci, ma creato da un dio artigiano (artifex) talora rappresentato con il compasso e gli attrezzi intento a “produrre” l’universo, un dio descritto poi nel rinascimento come il divino «orologiaio» creatore della «macchina» del mondo. Il creato era uniforme, fabbricato da Dio: non c’erano divinità, né negli astri né nei fiumi, e appariva ingiustificata la distinzione tra una fisica terrestre e una celeste, così come inaccettabile ogni carattere divino della natura.

Un nome centrale nella storia della trasmissione del sapere logico e matematico antico al medioevo latino è quello di Boezio (480 ca-524 o 526), intellettuale emblema del tentativo dei popoli latini di salvare la propria identità culturale nella nascita dell’Europa all’interno dei nuovi stati barbarici. Senatore al tempo di Teodorico, ne divenne il consigliere, ma non poté evitare di essere coinvolto nelle trame di corte, in un’epoca in cui l’impero bizantino, romano e cristiano, era ancora presente in Italia. Venne giustiziato e la sua morte interruppe il suo tentativo di tradurre in latino tutti i classici della matematica e della logica antica. Alcune sue opere sono andate perdute e quelle rimaste costituiscono il nucleo principale delle conoscenze scientifiche dei greci note nell’alto medioevo europeo: un libro di aritmetica e uno di armonia ricavati da Nicomaco, un libro di geometria che riporta i primi tre libri degli Elementi, quasi del tutto senza dimostrazioni. In realtà di quest’ultimo ci sono pervenute due versioni, entrambe però ascrivibili ad autori medievali successivi, anche se probabilmente basate pure sul testo di Boezio. Sebbene concettualmente molto inferiori all’opera di Euclide, questi testi includono alcune aggiunte abbastanza caratteristiche del pensiero medievale. Così la Geometria ii inizia definendo la misura, che negli Elementi era concetto puramente aritmetico, come «qualunque cosa si definisca» non solo in termini di lunghezza, ma anche di peso, capacità e «animo». Dichiara il punto (che in Euclide era caratterizzato solo dall’essere «senza parti») principium mensurae, include un libro di proposizioni metriche e considera la geometria utile ai meccanici, ai medici e ai filosofi: si tratta quindi di una rilettura (caratteristica dell’alto medioevo) della geometria teorica all’interno della tradizione pratica, con l’idea agostiniana dell’estensione della categoria della quantità al di là delle grandezze geometriche e dei numeri.

Le conquiste del medioevo

L’estensione del «regno della quantità» è una delle novità medievali che risultano cruciali per la nascita della scienza moderna. Il superamento della distinzione tra scienze e tecniche e la progressiva fusione fra tradizione pratica e teorica ne sono un altro aspetto essenziale, anche se nelle università medievali e nell’umanesimo riapparirà una forma di elitarismo della teoria rispetto alle tecniche: di fatto le università del basso medioevo interrompono un processo di osmosi tra scienza e tecnica che invece era evidente nell’alto medioevo, e riemergerà nel rinascimento.

Un altro aspetto essenziale che compare nel medioevo è il superamento dell’idea greca di scienza come pura scienza di universali, per cui era scienza descrivere col sillogismo la causa delle eclissi, ma non era scienza individuarne la data, fatto tecnico che solo con Claudio Tolomeo tornò a caratterizzare l’astronomia. Le idee generali della filosofia naturale aristotelica nel medioevo si estendono invece ai fatti individuali e tecnici, segnando il trionfo di scienze quali l’astrologia e l’alchimia.

L’attenzione verso l’individuo, una delle tematiche più innovative del pensiero cristiano, trova nel francescanesimo la sua lettura più radicale; questo aspetto sarà destinato a caratterizzare una scienza che parla anche di singole cose e non di sole idee, nella quale i fatti individuali non sono solo istanze individuali di attributi universali delle specie, ma fatti complessi, effetti di innumerevoli relazioni causali. Così si assiste al formarsi di un sistema culturale medievale intorno al pensiero cristiano in cui cominciano a delinearsi i caratteri fondamentali della scienza moderna.

Questi processi culturali nell’Occidente si affiancavano a una crescente capacità di assimilare e trasformare novità tecnologiche in gran parte importate dall’Oriente, che riguardavano le tecniche agricole, i finimenti del cavallo, l’uso dei mulini per produrre energia, nuove tecniche costruttive: acquisizioni destinate a trasformare non solo l’economia ma anche il potenziale bellico degli europei. Tuttavia, anche se si intravedevano tutte queste novità, l’Europa occidentale nell’alto medioevo restava, rispetto ai grandi imperi orientali, un continente sottosviluppato.

L’impero romano d’Oriente durò mille anni dopo la caduta di quello d’Occidente. E nei secoli tra la fine dell’antichità e l’inizio del medioevo, soprattutto ad Alessandria, esso fu la dimora della cultura classica. Qui operavano gli ultimi grandi filosofi, da Plotino, padre del neoplatonismo, a Simplicio, uno dei massimi commentatori di Aristotele. Interessante la figura di Giovanni Filopono (490 ca-570), altro esponente della fusione tra pensiero classico e cristiano, e primo pensatore a sottoporre la filosofia naturale dominante, quella aristotelica, a una critica moderna. Aristotele infatti rifiutava il vuoto e l’idea di uno spazio tridimensionale “contenitore” delle cose, considerava la fisica dei cieli e quella terrestre del tutto diverse, riteneva il mondo eterno, considerava la materia una realtà solo negativa, priva di proprietà e dimensioni, e credeva che la velocità di caduta di un grave crescesse col peso. Tutte tesi che Filopono rigetta, anche se occorrerà aspettare un millennio per vedere quelle critiche pienamente accolte.

La matematica nell’Islam