media

media

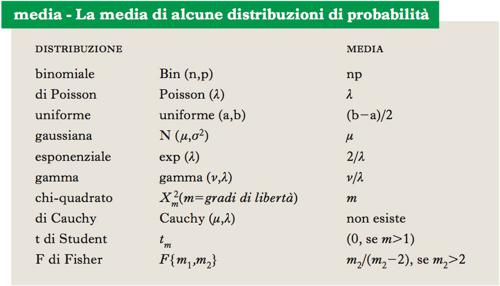

Misura anche nota come ‘valore medio’. Il concetto di m. assume connotazioni diverse a seconda del contesto. Dato un insieme di n numeri, si definisce come loro m. la quantità x̄̄=Σixi/n. La m. così definita è anche chiamata m. aritmetica. Se a ciascun numero xi è assegnato un peso diverso da 1/n, si ottiene la media ponderata x.w‒=Σiwixi, in cui i numeri wi sono chiamati pesi. ● Se {x1,...,xn} sono i valori possibili di una variabile aleatoria discreta X (➔ variabile aleatoria), si definisce m. o valore atteso di X la m. ponderata E(X)=Σipixi , dove il peso pi è uguale alla probabilità che X assuma il valore xi. Si noti che, invece della notazione x., in questo caso si usa la notazione μx oppure E(X), dove la lettera E deriva dall’inglese expectation, cioè valore atteso.

Se X è una variabile aleatoria continua, la definizione di m. è analoga, ma la somma è sostituita da un integrale, mentre i pesi sono proporzionali alla densità f della distribuzione (➔ distribuzione di probabilità). In questo caso, E(X)=ʃx.(x)dx.

Infine, se {x1,...,xn} sono n osservazioni su una variabile ottenute con campionamento casuale semplice (➔ campione statistico) da una popolazione data, allora la m. Σinxi/n è detta m. campionaria. Poiché il campione è costituito da n repliche di una stessa variabile aleatoria, la m. campionaria è anch’essa una variabile aleatoria e può anche essere vista come la m. associata alla distribuzione empirica indotta dal campione (➔ distribuzione empirica). Si dimostra che, sotto condizioni molto generali, la m. campionaria è uno stimatore (➔) non distorto della m. della popolazione da cui il campione è stato estratto.

Proprietà della media

La m., comunque definita, gode di due importanti proprietà matematiche: linearità e monotonia (➔ monotono). Si considerino due variabili aleatorie X e Y con m. finita. La m. è lineare perchè, data una qualunque combinazione lineare di X e Y, Z=aX+bY dove a,b sono due numeri qualsiasi, allora E(Z)=a E(X)+b E(Y). La m. è monotona poichè, se per es. X≥Y con probabilità 1, allora E(X)≥E(Y).

Media condizionata

Date due variabili aleatorie X e Y, definite sullo stesso spazio di probabilità (➔), la m. condizionata di Y dato X=x è la m. della distribuzione condizionata di Y dato X=x e si indica con μ(x) oppure E(Y∣X=x). La m. condizionata di Y dato X=x è semplicemente un numero e, in generale, varia al variare di x. Si definisce m. condizionata di Y dato X la variabile aleatoria μ(X)=E(Y∣X). Tale variabile aleatoria ha m. uguale a E[μ(X)]=E[E(Y∣X)]=E(Y), un risultato noto come legge delle medie iterate. Per es., siano X e Y due variabili aleatorie con distribuzione congiunta gaussiana, medie μx e μy, varianze σ2x e σ2Y, e covarianza Cov(X,Y)=ρσxσy. In questo caso μ(X)=μy+(x−μx)ρσy/σx, cioè la m. condizionata è lineare in x. Segue se serve da questa espressione che E[μ(X)]=μy.