La seconda rivoluzione scientifica: fisica e chimica. La fisica e la chimica intorno al 1900

La seconda rivoluzione scientifica: fisica e chimica. La fisica e la chimica intorno al 1900

La fisica e la chimica intorno al 1900

Il secolo compreso tra il 1870 e il 1970 rappresenta una svolta decisiva nella storia della scienza. Esso ha inizio con la fondazione di istituti per la ricerca scientifica nelle università e nelle scuole superiori europee e con l'elaborazione di un'efficacissima sintesi di vaste aree delle scienze fisiche, in precedenza considerate ben distinte tra loro. La teoria cinetico-statistica dei gas, la teoria elettromagnetica della luce, la tavola periodica degli elementi chimici e la rappresentazione in tre dimensioni delle molecole (stereochimica) risalgono tutte al decennio successivo al 1870. Attorno a quest'ultima data è possibile collocare la nascita delle prime grandi industrie che trovavano fondamento nella scienza accademica, o che da essa traevano sviluppo: l'industria dei coloranti organici (sede dei primi laboratori industriali di ricerca), la telegrafia a grande distanza (da cui ebbero origine la luce e l'energia elettriche) e la manifattura dell'acciaio (stimolo fondamentale per le scienze metallurgiche).

Il punto d'arrivo della nostra analisi, invece, il 1970, benché non segni in modo altrettanto netto una svolta, non sta soltanto a indicare agli storici il termine di un periodo convenzionale. Gli anni intorno al 1970 videro infatti, nel campo della fisica, l'ordinamento del mondo delle particelle elementari basato sulla scoperta dei quark e della cromodinamica quantistica e l'elaborazione di una nuova interpretazione del mondo sensibile, derivante dall'accettazione della tettonica a placche e dalla scoperta di quegli straordinari oggetti astronomici che sono i quasar e le pulsar. Le tecnologie sviluppate in ambito militare consentirono la realizzazione di prodotti di consumo destinati ad avere conseguenze rivoluzionarie sul piano sociale, tra i quali si ricordano gli aviogetti di grandi dimensioni (il primo Boeing 747 entrò in servizio nel 1970), il laser (utilizzato per la prima volta per effettuare tagli e saldature proprio quell'anno) e gli elaboratori elettronici di ridotte dimensioni (risalgono al 1969 il primo microprocessore, o chip, e il primo calcolatore tascabile). Nel 1969, inoltre, gli Stati Uniti portarono per la prima volta l'uomo sulla Luna.

Nei primi anni Settanta, con la crisi finanziaria e la fine ingloriosa della guerra catastrofica condotta nell'Asia sudorientale, l'egemonia degli Stati Uniti nel campo delle scienze fisiche, incontrastata sin dalla fine della Seconda guerra mondiale, iniziò a mostrare segni di cedimento sia all'interno del paese sia all'estero. Gli anni compresi fra il 1968 e il 1976 registrarono una flessione in molti fra i parametri che indicavano la vitalità della ricerca e dello sviluppo americani, tra i quali la percentuale degli scienziati sulla forza lavoro totale, la percentuale del prodotto interno lordo nazionale destinata agli investimenti federali per la ricerca e lo sviluppo, la spesa per la ricerca e lo sviluppo di base depurata dall'inflazione e la pubblicazione di articoli scientifici. Il contributo della scienza e della tecnica alla devastazione del Vietnam e all'inquinamento industriale in tutte le regioni del mondo suscitò una vasta opposizione nel paese, mentre la fiducia nella scienza iniziò nettamente a declinare nei sondaggi di opinione. Una serie di energiche iniziative europee, la sopravvalutazione delle potenzialità dell'Unione Sovietica, la rinascita dell'industria giapponese e di quella tedesca e la crescita di società multinazionali basate sulla ricerca scientifica erano fattori che, combinandosi tra loro, minacciavano la supremazia statunitense. Gli Stati Uniti iniziarono a importare acciaio (tra il 1945 e il 1970 la produzione nazionale di acciaio diminuì dai due terzi a un settimo di quella mondiale) e manodopera specializzata (il numero degli immigranti con un alto livello di qualificazione raddoppiò tra la fine degli anni Cinquanta e la fine degli anni Sessanta).

Il fenomeno più rilevante del periodo che stiamo per considerare è la trasformazione cui andarono incontro la fisica e la chimica nel corso, e in conseguenza, del passaggio dall'egemonia europea a quella americana in ambito scientifico. Già discernibile nel primo decennio del XX sec. dagli osservatori più acuti, questo processo subì una rapida accelerazione per effetto della Prima guerra mondiale. Gli anni fra le due guerre sono da considerarsi invece come un 'sottoperiodo' distinto, durante il quale l'Europa e gli Stati Uniti condivisero una condizione di equilibrio precario, che ben presto venne meno a causa dell'emigrazione degli ebrei in fuga dalla persecuzione nazifascista. La distruzione, durante la Seconda guerra mondiale, delle basi materiali su cui poggiavano la scienza e la tecnologia europee e il concomitante rafforzamento delle scienze applicate americane completarono il quadro che consentì agli Stati Uniti di assumere il ruolo di paese guida in campo scientifico. Tale passaggio incise sulle scienze fisiche, modificandone non soltanto il rilievo e gli indirizzi, ma anche gli obiettivi, le consuetudini, i mezzi di esercizio e le basi filosofiche.

Nel trattare tale processo di transizione e i risultati ai quali condusse, la nostra attenzione si focalizzerà sulla situazione della fisica e della chimica nel momento del loro massimo sviluppo in Europa, ossia negli anni intorno al 1900; tale punto di vista privilegiato permette infatti di volgere lo sguardo all'indietro, alle origini della scienza fisica moderna nel periodo critico intorno al 1870, e di effettuare una valutazione, dalla prospettiva europea, delle potenzialità degli Stati Uniti alla vigilia della Prima guerra mondiale.

Il mondo

Il 1870 fu un anno di svolta nella storia politica, in seguito al quale lo sviluppo della scienza e della tecnologia subì una rapida accelerazione in tutte le regioni del mondo, particolarmente evidente durante la prima metà del secolo successivo. A partire dal 1868 ‒ anno in cui l'inizio del periodo Meiji segnò la fine del potere feudale degli shogun ‒ i giapponesi iniziarono ad assimilare con grande rapidità la scienza occidentale e i suoi prodotti, accogliendo esperti stranieri, studiando le lingue occidentali e fondando università (la prima fu istituita a Tokyo nel 1877) e numerose scuole e istituti superiori di studi tecnici. All'inizio del XX sec. il Giappone disponeva già di scienziati di livello mondiale e aveva acquisito un potere economico e militare sufficiente a sconfiggere in guerra l'Impero russo.

Intorno al 1870 si consolidò anche un'altra potenza più importante del Giappone, gli Stati Uniti, ora effettivamente riuniti (sia pure con la forza); alla disastrosa guerra civile ‒ conclusasi nel 1865 ‒ seguì, infatti, un processo di modernizzazione su larga scala, simboleggiato dal motore a vapore Corliss, lungo 40 piedi (12 m ca.) e del peso di 700 tonnellate, che, all'esposizione organizzata nel 1876 per festeggiare il centenario della fondazione dell'Unione, rifornì di energia molti acri di terreno dove erano esposti i macchinari.

Tra il 1870 e il 1900, la trasformazione degli Stati Uniti in paese industriale diede origine alla costituzione di ingenti patrimoni privati, devoluti, in parte, al finanziamento di università che davano spazio allo studio di discipline moderne e che ospitavano osservatori e biblioteche. Fu grazie a questi capitali che, subito dopo il 1900, venne istituita la fondazione per la ricerca fisica meglio dotata al mondo, la Carnegie Institution of Washington.

In Europa, negli anni 1870-1871 si attuò l'unificazione della Germania, fatto che portò all'integrazione economica e alla rimozione delle barriere commerciali in questo paese, oltre che all'intensificarsi della competizione tra le università pubbliche e all'incentivazione a livello centrale delle tecnologie basate sulla scienza. A partire dal 1900, la Germania assunse la leadership mondiale nella costruzione di strumenti scientifici, nella fabbricazione di vetro per l'ottica e di altri prodotti ad alta tecnologia, così come nel campo delle pubblicazioni scientifiche e dell'applicazione della scienza in ambito amministrativo e militare. Nel 1899, l'imperatore, in segno di rispetto nei confronti dei politecnici tedeschi, per assicurare loro il diritto di rilasciare titoli di dottorato, si presentò alla Technische Hochschule di Berlino indossando l'uniforme di ufficiale dei genieri: evento, questo, che simboleggia l'avvenuta integrazione tedesca tra scienza, tecnologia e Stato e che, in aggiunta, può servire a dare un'idea di quale fosse la reciproca influenza dell'imperatore e dell'accademia; se prima del suo discorso il rapporto tra gli studenti dell'università e quelli dei politecnici era di 3 a 1, nel corso dei due anni successivi la sproporzione invece di diminuire aumentò, divenendo di 4 a 1. La Germania si era unificata subito dopo aver sconfitto la Francia che, umiliata, tentò di rafforzarsi nei settori in cui si sentiva inferiore rispetto ai suoi avversari, ossia la scienza e la tecnologia. Nel corso degli anni Settanta dell'Ottocento, furono inviate delegazioni di esperti a studiare le istituzioni e i metodi tedeschi e, in seguito, fu riorganizzato il sistema di istruzione superiore, concedendo maggiore autonomia alle università delle città di provincia e ricostruendo quelle di Parigi. Così, nel 1900, i francesi uguagliarono i tedeschi per quanto riguardava gli investimenti pro capite in molti settori della scienza e della tecnologia.

L'unificazione dell'Italia e la riduzione dello Stato pontificio alla Città del Vaticano (eventi risalenti anch'essi al 1870-1871) non influirono sulla fisica e sulla chimica nel periodo compreso tra il 1870 e il 1920, ma consentirono al paese di svolgere tra le due guerre un ruolo di primo piano in queste aree di ricerca.

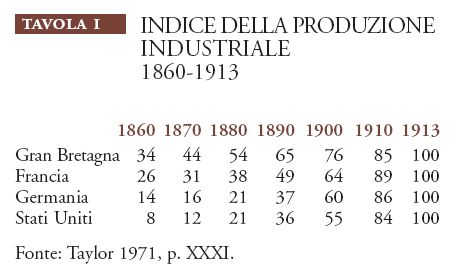

Tra il 1870 e il 1913 si assistette alla rapida industrializzazione non soltanto degli Stati Uniti ma anche delle maggiori potenze europee. Uno degli indici della rapidità della cosiddetta 'seconda rivoluzione industriale' della fine del XIX sec. è costituito dal ritmo di sviluppo molto sostenuto raggiunto alla vigilia della Prima guerra mondiale dalla produzione industriale nei più importanti paesi europei, Gran Bretagna, Francia, Germania (Tav. I, nella quale si assume come riferimento, per ciascun paese, l'indice uguale a 100 nel 1913).

In linea generale si può dire che, sino agli anni Settanta del XIX sec., lo sviluppo industriale complessivo dei paesi europei era compreso tra un quinto e la metà di quello dei cinquant'anni successivi. La tavola indica che, nel 1890, la Gran Bretagna aveva raggiunto un ritmo di incremento stabile, mentre i tassi di crescita della Francia, della Germania e degli Stati Uniti aumentavano rapidamente.

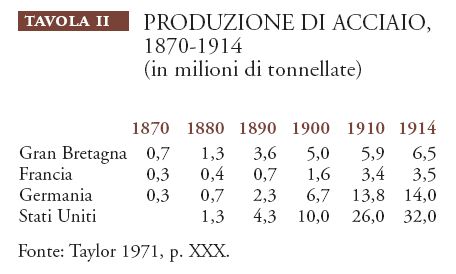

Un altro importante parametro della competizione industriale degli anni intorno al 1900 è rappresentato dalla produzione su vasta scala dell'acciaio, che aveva avuto inizio negli anni Sessanta dell'Ottocento (Tav. II).

Come risulta dalla tavola, nel 1870 la produzione della Gran Bretagna, 700.000 tonnellate, superava quella complessiva degli altri paesi; nel 1880, la Gran Bretagna e gli Stati Uniti raggiunsero una situazione di parità e il prodotto totale delle quattro nazioni era almeno triplicato rispetto a quello di dieci anni prima. Nel 1890 gli Stati Uniti produssero una quantità di acciaio superiore a quella prodotta complessivamente nel 1880 dai quattro paesi e, nel 1910, a quella prodotta nello stesso anno dai tre paesi europei.

L'acciaio era utilizzato soprattutto nella costruzione dei piroscafi e delle ferrovie. Il Registro dei Lloyd del 1870 non riporta alcuna nave in acciaio, e meno di 400.000 tonnellate di navi in ferro: la flotta commerciale mondiale, infatti, era costituita da navi a vela per un tonnellaggio sette volte superiore rispetto a quello delle navi a vapore. Nel Registro del 1906 non compaiono più navi in ferro, bensì 1.492.000 tonnellate di navi in acciaio; a questa data, stavano per essere varati il Mauretania e lo sfortunato Lusitania, ciascuno con 32.000 tonnellate di dislocamento (più del doppio del modello più importante del mercato nel 1900, il Deutschland) e una velocità massima di 24 nodi. La proporzione tra vapore e vela era passata da 2 a 1, crescendo di quattordici volte. Sulla terraferma, la rete ferroviaria mondiale era sostanzialmente raddoppiata nel corso degli anni Sessanta, passando da 108.000 a 210.000 km; intorno al 1885 essa eguagliò la distanza dalla Terra alla Luna, ossia 384.000 km; nel 1900 raddoppiò ancora, toccando i 790.000 km e, nel 1910, superò il milione di chilometri, risultando quintuplicata dal 1870. I tre quarti circa della produzione statunitense di acciaio negli anni Settanta e Ottanta del XIX sec. furono destinati alla costruzione di binari.

I treni e i piroscafi consentivano agli scienziati di visitare i laboratori dei loro colleghi e di partecipare in gran numero e con un'assiduità inimmaginabile nel 1870 ai convegni internazionali. Nel 1904 una delegazione di importanti studiosi europei si recò negli Stati Uniti per tenere una serie di conferenze all'Esposizione internazionale di Saint Louis, nel Missouri, e nel 1914 la British Association for the Advancement of Science organizzò in Australia il suo incontro annuale, al quale parteciparono numerosi scienziati tedeschi e britannici: multi pertransibunt et augibitur scientia. Questi accademici 'itineranti' sembravano incarnare i fortunati cittadini di A modern utopia (1905) di Herbert G. Wells, nella quale mezzi di trasporto veloci ed efficienti incoraggiavano lo scambio di informazioni, la libertà individuale e un rapido accesso al lavoro, assicurando la prosperità dello Stato mondiale.

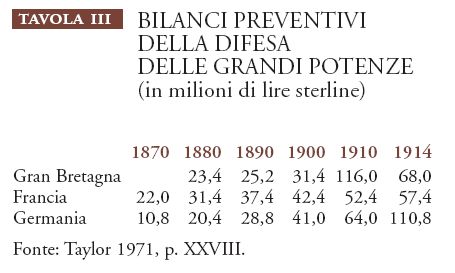

Un settore meno inoffensivo di consumo dell'acciaio era quello militare. Le spese per navi e armamenti in acciaio, comunicazioni elettriche e altri sistemi di 'difesa' ad alta tecnologia, affrontate dalle grandi potenze prima della Grande guerra, finirono per scatenare un'accanita corsa agli armamenti (Tav. III).

Il declino della Francia rispetto alla Germania nel primo quindicennio del XX sec. è molto evidente. Per la Gran Bretagna, l'improvviso incremento del 1900 va posto in rapporto alla guerra boera; nel 1914 la spesa militare britannica pro capite era esattamente uguale a quella tedesca, ossia 1,7 lire sterline, mentre quella francese era di poco inferiore, 1,5 lire sterline. Si trattava di somme di gran lunga superiori a quelle destinate alla ricerca accademica: se negli anni intorno al 1900 le spese militari di questi paesi erano pari al 3-4% del prodotto interno lordo, alla fisica accademica (che assorbiva il 70% circa dei fisici) era destinato soltanto lo 0,005% in Gran Bretagna, Francia, Germania e Stati Uniti. La competizione tra le nazioni nel campo dei preparativi bellici e in quello del commercio e degli scambi aveva prodotto, tra la fine del XIX e l'inizio del XX sec., una domanda analoga di conoscenze fisiche, benché su scala mille volte inferiore.

I primi imprenditori del settore dell'alta tecnologia che avvertirono la necessità di impiegare scienziati di formazione accademica accumularono grandi ricchezze. Alla fine degli anni Settanta dell'Ottocento, Andrew Carnegie (1835-1919), per esempio, scrisse:

abbiamo trovato […] uno specialista tedesco, il dr. Fricke, il quale ci ha svelato straordinari segreti […]. I nove decimi di tutte le incertezze relative alla fabbricazione della ghisa si sono dissipate alla radiosa luce delle conoscenze chimiche […]. Alcuni anni dopo che ci eravamo affidati alla guida della chimica [i nostri concorrenti] dissero che non potevano permettersi un chimico. Se avessero saputo la verità, si sarebbero resi conto che non potevano farne a meno. (Livesay 1975, p. 114)

Gli uomini di scienza iniziarono a essere richiesti anche da industrie che non esistevano prima del 1870, ossia le industrie che producevano coloranti organici, farmaci, gomma, petrolio, luce ed energia elettrica.

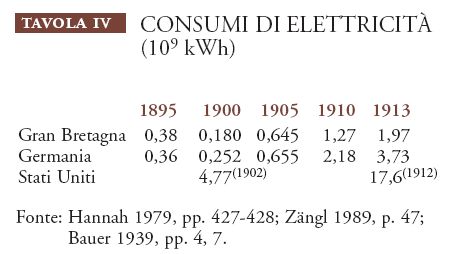

La fonte di energia scoperta più di recente, l'elettricità, impegnava una forza lavoro composita. Tra il 1900 e lo scoppio della guerra, la disponibilità totale di elettricità aumentò del 1500% in Germania, del 1000% in Gran Bretagna, del 400% negli Stati Uniti (Tav. IV); gli americani, grazie allo sfruttamento delle cascate del Niagara, ne producevano la maggiore quantità, pur senza presentare l'incremento più alto.

Soprattutto negli Stati Uniti, gran parte della nuova energia era destinata alle industrie elettrochimiche, che se ne servivano per operazioni quali la separazione criogenica dei gas (in particolare ossigeno e idrogeno), la separazione elettrolitica dei metalli (principalmente rame e alluminio), la riduzione termica degli ossidi di metalli che non si trovano liberi in Natura (cromo, manganese, tungsteno, molibdeno), nonché nei processi di produzione di fertilizzanti (nitrati e fosfati), di alcali, e così via. La progettazione e l'esecuzione di tali processi esigeva la cooperazione di chimici, chimici fisici e ingegneri industriali. Un'indicazione delle dimensioni e della vitalità di questo settore interdisciplinare è rappresentata dalla fondazione, nel 1902, dell'American Electrochemical Society, composta da più di 550 soci attivi nel campo dell'istruzione superiore e dell'industria, un segno, questo, di consolidamento tanto repentino da stupire i contemporanei i quali notarono la 'sorprendente rapidità' di questa 'cristallizzazione'. I saggi governanti dell'Utopia di Wells facevano costruire i laboratori più grandi e meglio equipaggiati non nelle università, ma in siti adiacenti alle centrali di energia e alle industrie più importanti.

Per soddisfare la crescente domanda di esperti nelle scienze fisiche con una formazione adeguata, le università ampliarono i loro curricula ed emersero diversi tipi di scuole tecniche di perfezionamento: le Technische Hochschulen nei paesi germanofoni; i college universitari e le università nelle città industriali, in Gran Bretagna; l'école Municipale de Physique et Chimie Industrielles e le facoltà di scienze e di tecnologia delle università delle città di provincia, in Francia. Si registrò inoltre una maggiore domanda di corsi di formazione universitaria nel campo delle scienze fisiche da parte del mondo della professione medica, dove era richiesta la conoscenza di nozioni di elettricità e di chimica, e da parte dei ministeri della pubblica istruzione, che avevano bisogno di insegnanti in grado di preparare gli studenti delle scuole secondarie ad affrontare corsi superiori di scienze pure e applicate.

Nelle quattro maggiori potenze, il numero degli studenti universitari crebbe molto rapidamente nel corso del primo decennio del XX sec., aumentando del 20% in Gran Bretagna (2500 unità), del 60% in Germania (60.000 unità) e addirittura dell'80% negli Stati Uniti (187.000 unità). Dal momento che il rapporto tra gli studenti universitari e quelli delle Technische Hochschulen rimase costante (4 a 1), anche il numero di questi ultimi aumentò del 60%, toccando le 16.000 unità ca. nel 1910. Le iscrizioni alle facoltà di medicina e alle facoltà scientifiche in generale aumentarono più rapidamente delle altre. Nel periodo compreso fra il 1870 e il 1910, il fattore di crescita del corpo studentesco nelle università tedesche fu pari a 4,6 (fino a raggiungere le 60.000 unità); quello degli studenti di medicina fu pari a 6 (18.000 unità) e quello degli studenti di scienze naturali di un ordine di grandezza superiore (toccando le 7500 unità). Intorno al 1900, in Germania, gli studenti di medicina costituivano più della metà dei frequentanti i corsi elementari di fisica e chimica. Una situazione analoga si determinò in Francia, almeno dopo il 1893, anno dell'introduzione del corso di sciences physiques, chimiques et naturelles e, probabilmente, anche in Gran Bretagna, come avvenne presso il Cavendish Laboratory. Pochi di questi studenti divennero fisici o chimici di professione e pochissimi ‒ in fisica, meno dell'1% ‒ si dedicarono alla ricerca. Tuttavia, la pressione esercitata dall'aumento delle iscrizioni contribuì in modo decisivo all'incremento delle ricerche scientifiche: le università dovettero far ricorso, infatti, a un numero sempre maggiore di insegnanti ai quali si devono la maggior parte delle ricerche fisiche e molte delle ricerche chimiche pubblicate intorno al 1910.

La professione

Demografia

Nel periodo precedente alla Prima guerra mondiale, i fisici si occupavano di molti temi di ricerca oggi divenuti di competenza di altre discipline e, di conseguenza, le conclusioni che possono essere tratte dai dati statistici hanno solo un valore indicativo. Tra le relazioni presentate al Congrès internationale de physique svoltosi a Parigi nel 1900, una su sei concerneva la biofisica o la geofisica. Nei primi anni del XX sec., le bibliografie tedesche di ricerche fisiche includevano abitualmente molti studi di chimica fisica, di geofisica, di meteorologia e di fisica cosmica che, considerati nel loro insieme, nel 1910 rappresentavano la metà della letteratura mondiale di 'fisica'. L'Adressbuch der lebenden Physiker (Annuario dei fisici viventi), edito nel 1909, elenca 3170 'fisici', 592 dei quali si definivano esperti di astronomia, 284 di geofisica o meteorologia, 256 di tecnologia e 214 di chimica fisica; nella maggior parte degli altri settori della chimica la situazione era diversa, a causa dei loro più antichi e stretti legami con l'industria.

Al Congresso di Parigi parteciparono settecento fisici, ossia un quarto ca. delle 2800 persone che nel 1900 insegnavano fisica o lavoravano come fisici in Europa: i tre quinti dei partecipanti erano insegnanti, un quinto ingegneri e un quinto funzionari pubblici o membri delle forze armate. Gli insegnanti, specialmente quelli che lavoravano nelle scuole di specializzazione e nelle università, dominarono l'incontro in misura sproporzionata rispetto al loro numero: benché costituissero soltanto il 40% del totale dei partecipanti, infatti, effettuarono il 90% degli interventi, sia perché avevano un maggior numero di argomenti da esporre ‒ in quanto autori del 70% dei resoconti di ricerca pubblicati sulle pagine delle principali riviste scientifiche ‒ sia perché il loro prestigio era di gran lunga superiore a quello degli altri fisici.

A quel tempo, il numero dei fisici accademici di alto livello, 800 ca. in Europa e 150 negli Stati Uniti, aumentava in media al ritmo del 3% l'anno. Questo dato, ottenuto contando istituzione per istituzione i docenti impiegati anno per anno, concorda con quelli forniti dall'Adressbuch del 1909, secondo cui i fisici che insegnavano nelle università e nelle scuole di specializzazione erano 971. Un'analoga stima può essere effettuata per i chimici, a partire dal dato secondo cui nel 1900 i chimici accademici in attività negli Stati Uniti erano con ogni probabilità 500, più di 2,5 volte il numero dei fisici; assumendo che questo rapporto fosse valido anche per gli altri paesi rilevanti in campo chimico, nello stesso anno dovevano insegnare presso le scuole di specializzazione e gli istituti superiori di tutto il mondo almeno 2500 chimici. Sappiamo che, nello stesso periodo, un quinto circa dei membri dell'American Chemical Society erano docenti universitari. Considerando valido a livello mondiale il rapporto di un accademico su 4 chimici, nel 1900 i chimici in Europa e negli Stati Uniti dovevano essere 12.500, vale a dire quasi il quintuplo dei fisici. Questa stima non è molto lontana dalla realtà: nel 1910-1911, infatti, i membri nelle società chimiche di Gran Bretagna, Francia, Germania e Stati Uniti erano 12.500. Tenendo conto del fatto che il numero dei chimici tra il 1900 e il 1910 subì un aumento, che non tutti erano iscritti alle società chimiche e che nel 1900 i chimici attivi nei quattro maggiori paesi erano più di 9000, si giunge di nuovo alla conclusione che alla fine del secolo operavano nel mondo circa 12.000 chimici.

Benché nel 1900 i chimici tedeschi fossero più del doppio di quelli britannici (più di 4000 contro meno di 2000), probabilmente in quel periodo l'industria chimica britannica era la più grande del mondo. Tale apparente paradosso si spiega con il fatto che la Germania occupava una posizione dominante nel settore dei prodotti chimici di alta qualità ‒ coloranti, farmaceutici e profumi ‒ fabbricati da industrie che richiedevano un gran numero di dipendenti preparati e in grado di introdurre innovazioni. Gli esponenti della chimica britannica lamentarono più volte l'insufficiente livello di preparazione degli 'esperti' di chimica del paese, osservando che in Germania il rapporto tra insegnanti e studenti era molto più alto; falliti i tentativi di porre rimedio a tale divario, allo scoppio della Prima guerra mondiale, la Gran Bretagna si trovava a dipendere dalle forniture della Germania per quanto riguardava un gran numero di prodotti chimici. Peraltro, la situazione della Francia non era migliore; intorno al 1900, il paese aveva svolto un ruolo di primo piano nel campo dell'elettrochimica ‒ grazie soprattutto all'opera di Henri Moissan (1852-1907) ‒ ma, come rilevò la giuria dell'Esposizione internazionale di quell'anno, i francesi non disponevano del personale e delle infrastrutture necessarie a conservare il loro primato.

Da questi dati non emerge un'importante novità relativa alla composizione della popolazione degli scienziati, ossia il sottoinsieme ‒ in lenta crescita ma sempre più importante ‒ degli accademici specializzati nella teoria; essi occupavano numerose cattedre principalmente nelle università tedesche e in quelle che avevano adottato la loro struttura organizzativa, ma anche nelle università britanniche e dell'Impero britannico, dove i laureati in matematica della University of Cambridge ricoprivano intorno al 1900 la metà circa degli incarichi di ruolo nel settore della fisica. I titolari francesi delle poche cattedre di physique mathématique tendevano a identificare la loro materia con la matematica, anche se in alcuni casi ‒ come, per esempio, quello di Jules-Henri Poincaré (1854-1912) ‒ il loro interesse per le basi matematiche delle scienze fisiche non li portò a trascurare quelle epistemologiche. Negli Stati Uniti, propensi, come sempre, al pragmatismo, il numero dei teorici era irrisorio.

Le riflessioni dei teorici non erano dedicate interamente alla fisica, neanche quando essa rappresentava la loro specifica materia d'insegnamento. Hermann von Helmholtz (1821-1894) e Max Planck (1858-1947) a Berlino e Joseph J. Thomson (1856-1940) a Cambridge, per menzionare tre dei più illustri 'fisici teorici' dei decenni a cavallo del secolo, mostrarono un grande interesse per la termodinamica chimica, per le combinazioni chimiche e per la problematica teoria ionica delle soluzioni, e spesso i loro temi di studio coincisero con quelli dei protagonisti e dei teorici della chimica fisica: Friedrich Wilhelm Ostwald (Lipsia, 1853-1922), Svante August Arrhenius (Stoccolma, 1859-1927) e Jacobus Henricus van't Hoff (Berlino, 1852-1911). Dopo aver iniziato la sua carriera come professore di fisica a Gottinga, il loro allievo Walther Hermann Nernst (1864-1941) ottenne, nel 1894, una cattedra di chimica fisica nella stessa università e nel 1904 accettò un incarico analogo in un nuovo istituto di Berlino, dove fornì un importante contributo alla teoria dei quanti; nel tentativo di inserirsi nel mondo accademico, il neolaureato Albert Einstein (1879-1955), cercò, invano, di ottenere l'incarico di assistente di Ostwald.

I dati relativi al numero dei teorici in attività nel 1900 non sono molto attendibili, perché spesso essi insegnavano materie di carattere generale mentre, in alcuni casi, le cattedre di teoria erano assegnate a sperimentali per i quali non era disponibile un'altra collocazione. Il dato forse più significativo è che, nella Germania del 1900, il 15% degli incarichi accademici di fisica erano destinati, anche se non effettivamente ricoperti, da teorici. La modesta stima di un totale di 16 concorda alla perfezione con l'elenco delle attività dichiarate dai fisici tedeschi nell'Adressbuch del 1909.

I professori di fisica britannici che avevano studiato matematica a Cambridge non erano teorici nell'accezione tedesca del termine: pochi cercarono di elaborare su basi quantitative sistemi del mondo in cui inserire dati sperimentali. Ciononostante la capacità, affinata grazie ai corsi di studio seguiti, di elaborare ipotesi e di eseguire calcoli relativi al comportamento di modelli meccanici li portò a fornire un contributo straordinariamente utile alle prime esplorazioni del mondo microscopico.

Anche la fisica francese presentava un suo tratto distintivo derivante dal positivismo istillato dall'école Polytechnique e dall'école Normale a Parigi, istituti dove aveva studiato più della metà dei fisici e dei chimici accademici attivi in Francia nel 1900. Centri analoghi non esistevano in Germania, dove gli studenti esercitavano regolarmente la loro Lernfreiheit (libertà di studio), frequentando diverse università o politecnici, e neppure negli Stati Uniti, dove molti professori ‒ soprattutto di chimica ‒ avevano condotto ricerche di alto livello in varie regioni della decentralizzata Germania. Gli statunitensi che avevano conseguito il dottorato in patria provenivano da diversi istituti di studi superiori e soprattutto dalle università Johns Hopkins, Cornell, Harvard, Columbia e Chicago; nella misura in cui mostravano un diverso orientamento, esso derivava dalla possibilità di usufruire di un maggiore spazio e di una maggiore libertà, oltre che di attrezzature più grandi e più numerose rispetto alla maggior parte dei loro colleghi europei. Il livello di preparazione e le capacità di questi dottori 'allevati in patria' non sfuggirono al Ministero dell'educazione prussiano che, nel 1910-1911, parificò una dozzina di università americane a quelle tedesche.

Le risorse

Tra la fine del XIX e l'inizio del XX sec., gli osservatori più informati classificavano al primo posto fra le nazioni 'produttrici di scienza' la Germania, seguita, nell'ordine, da Gran Bretagna, Francia e Stati Uniti, ultimi tra i quattro grandi paesi. L'idea della supremazia tedesca derivava non solo, o forse (tranne che per la chimica) non principalmente, dalla qualità del prodotto. Il più grande esperto di misurazioni del mondo, Albert A. Michelson (1853-1931), era un americano; nessuno padroneggiava l'aspetto matematico della fisica meglio dei laureati di Cambridge, e i francesi non avevano eguali in quanto a eleganza espressiva. La Germania sembrava dominare la fisica e la chimica grazie alla qualità e alla serietà delle pubblicazioni in lingua tedesca, per la superiorità delle aziende tedesche nel campo della fabbricazione degli strumenti scientifici, per il sostegno economico relativamente generoso assicurato agli istituti scientifici dai diversi Stati del Reich e per il prestigio di cui godevano i suoi professori.

Il vantaggio più rilevante ed evidente della scienza tedesca era costituito dal riconoscimento, da parte dei governi dei diversi Stati, della necessità di finanziare le attività scientifiche. La Prussia (dove la principale università era quella di Berlino), la Sassonia (Università di Lipsia), la Baviera (Università di Monaco) e Hannover (Università di Gottinga) erano relativamente generose nel concedere finanziamenti per l'acquisto di costose attrezzature e la realizzazione di nuovi impianti. Il particolare complesso di norme tedesco che prevedeva la chiamata diretta dei docenti e la contrattazione ad personam del relativo trattamento non era estraneo a questa situazione; un professore chiamato a insegnare in un altro Stato poteva intavolare una trattativa sulla remunerazione, sull'assistenza, sul budget, sulle attrezzature e sulle strutture; figure di crescente prestigio, come Helmholtz, Ostwald o Nernst, si lasciavano a volte alle spalle una scia di laboratori e persino interi istituti completamente rinnovati. Il principio guida era il decentramento e la garanzia che in Germania i migliori scienziati non si sarebbero trovati compressi al vertice di un sistema di istruzione monolitico, come in Francia. Qui, infatti, le attività didattiche e scientifiche delle università più importanti erano finanziate quasi interamente dal governo centrale. Non si negoziavano le nomine: l'ambizione di tutti i professori era quella di conseguire una nomina a Parigi e, dopo averla ottenuta, di dedicarsi alla pratica del cumul, vale a dire all'accumulazione degli incarichi. Henri Becquerel (1852-1908), che non era uno scienziato particolarmente attivo, ricopriva a Parigi tre incarichi di professore: uno ottenuto autonomamente e gli altri ricevuti 'in eredità' dal padre, il quale ne aveva a sua volta ereditato uno dal suo. I 'matrimoni dinastici' nell'ambito delle famiglie dei professori restringevano ulteriormente le possibilità di accesso ai vertici: la generazione dei Curie, che aveva pochi vincoli di sangue con quella dei Becquerel, trovò conveniente condurre una politica matrimoniale interna. L'accentramento dell'erogazione dei finanziamenti nelle casse di un governo sempre più assediato da richieste di denaro, la pratica del cumul e la consuetudine di contrarre matrimoni endogamici contribuiscono a spiegare perché la fisica e la chimica francesi abbiano prodotto scarsi risultati nel primo decennio del XX secolo.

Nell'Impero britannico, il governo centrale finanziava in misura ridotta le scienze fisiche accademiche e negli Stati Uniti non lo faceva affatto; nel primo caso, erano i comuni a erogare i finanziamenti e nel secondo gli Stati, ma gran parte delle risorse necessarie a promuovere lo sviluppo scientifico proveniva ‒ in entrambi i paesi ‒ da singoli o da enti morali. I portavoce della scienza, soprattutto in Gran Bretagna, confrontavano tale precario sistema di finanziamento con la generosità dei Länder tedeschi, considerandolo negativamente. Questa opinione, tuttavia, non rifletteva la situazione reale della chimica verso il 1900 ed era certamente erronea per quanto concerneva la fisica, le cui basi materiali si estendevano più rapidamente nell'area anglosassone che non nel principale paese rivale. Tutti gli istituti di studi superiori più importanti dell'Impero britannico e degli Stati Uniti (università di Cambridge, Londra, Manchester, McGill, Johns Hopkins, Harvard, Columbia, Cornell e Chicago) erano stati costruiti e finanziati da filantropi. Gli uomini di Stato tedeschi investiti del compito di promuovere lo sviluppo scientifico indicavano in questa generosità un fenomeno da temere e, allo stesso tempo, da imitare.

Già allora, la spesa americana per salari, attrezzature e impianti destinati alla scienza accademica era più alta di quella degli altri paesi: la spesa per la fisica superava di una volta e mezzo quella dell'Impero britannico, di due volte quella della Germania e di tre volte quella della Francia. Tale disparità tendeva peraltro ad accentuarsi, in quanto gli stanziamenti aumentavano del 10% l'anno negli Stati Uniti, del 5% in Gran Bretagna e in Germania e del 2% in Francia (le dodici università americane equiparate a quelle tedesche dal governo prussiano nel 1910-1911 disponevano di budget operativi tre volte più alti, in media, delle università prussiane). Come abbiamo già osservato, verso il 1900 le spese per la fisica accademica nelle quattro maggiori potenze erano comunque grosso modo uguali se rapportate al reddito nazionale. Poiché anche il numero degli addetti del settore sulla popolazione totale era in proporzione sostanzialmente lo stesso (all'incirca tre per milione di abitanti), tra la fine del XIX sec. e l'inizio del successivo la spesa pro capite per i fisici accademici aveva raggiunto lo stesso livello nei quattro paesi, nonostante le differenze che caratterizzavano le modalità di finanziamento e i sistemi di reclutamento. La situazione, tuttavia, cambiava rapidamente: gli Stati Uniti avanzavano a gran velocità, la Gran Bretagna e la Germania mantenevano le loro relative posizioni e la Francia rimaneva indietro; nel 1903 cominciarono a diminuire le spese operative della principale istituzione francese destinata alla formazione dei fisici, l'école Normale Supérieure.

Questi investimenti, tuttavia, non diedero risultati proporzionati: nel 1900, almeno un terzo degli articoli pubblicati sulle pagine delle più autorevoli riviste di fisica erano redatti da studiosi tedeschi e ‒ a giudicare dal numero delle pubblicazioni ‒ i professori tedeschi erano tre volte più attivi degli americani (sotto questo profilo, gli ultimi della lista). Nel campo della chimica, la supremazia tedesca era ancora più evidente, grazie al numero e alla competenza dei chimici che avevano conseguito un titolo di dottorato e alla qualità delle riviste specializzate e dei testi fondamentali. Tra il 1900 e l'inizio della guerra, il 50% delle citazioni presenti nelle riviste americane di chimica rinviavano a pubblicazioni tedesche e la Société Chimique di Parigi dedicava più del 70% delle pagine del suo "Bulletin" alle ricerche condotte al di là del Reno.

Fu soprattutto il riconoscimento dell'utilità della scienza accademica a favorire il livellamento degli investimenti pro capite. Del resto, i portavoce della scienza ricorrevano di frequente alla vecchia strategia di attribuire un'importanza esagerata ai progressi scientifici compiuti negli altri paesi al fine di migliorare la situazione della scienza nel loro. Nel decennio che precedette la Prima guerra mondiale, gli effetti prodotti da questa competizione commerciale, militare e retorica divennero ancora più evidenti, soprattutto per quanto riguardava la manodopera e le attrezzature. La Gran Bretagna e gli Stati Uniti, in difficoltà a causa dell'obbligo di inviare i loro prodotti alla Physikalisch-Technische Reichsanstalt (PTR, fondata nel 1887) per le certificazioni tecniche, istituirono laboratori autonomi per la valutazione degli standard. Il National Physical Laboratory (1900), diretto da Richard T. Glazebrook (1854-1935) ‒ proveniente dal Cavendish Laboratory ‒, disponeva nel 1905 di un reparto di fisica in cui lavoravano 24 persone, la metà circa delle quali laureate, il cui numero salì a 63 nel 1914. Il National Bureau of Standards di Washington (1901), diretto dal professore di ingegneria e fisica Samuel W. Stratton (1861-1931), entrò in attività con tre fisici, due dei quali in possesso di un titolo di dottorato, e nel 1910 arrivò a impiegare 31 fisici, oltre che a disporre di un reparto di chimica e di un budget due volte superiore a quello della Physikalisch-Technische Reichsanstalt. Gli stanziamenti pubblici, i proventi derivanti dai collaudi e le donazioni ‒ particolarmente importanti nel caso del National Physical Laboratory ‒ sia di privati sia di aziende, consentivano ai tre uffici di collaudo di disporre di un reddito operativo e di fondi destinati all'acquisto di strumenti più grandi di quelli a disposizione delle università.

Le industrie che fabbricavano i prodotti da collaudare disponevano sin dal 1913 di propri laboratori di ricerca. Il General Electric Research Laboratory, istituito nel 1900 e inizialmente dotato di uno staff di due o tre persone, nel 1913 ne impiegava probabilmente 200, tra cui si distinguevano il fisico accademico Irving Langmuir (1881-1957), che aveva ottenuto il titolo di dottorato nel 1906 con Nernst, e William D. Coolidge (1873-1975), anch'egli in possesso di un titolo di dottorato conseguito in Germania, che aveva lavorato al Massachusetts Institute of Technology sotto la guida di Arthur A. Noyes (1866-1936), un allievo di Ostwald. A una certa distanza dal General Electric per data di fondazione e per larghezza di vedute, venivano i laboratori dell'American Telephone and Telegraph (1907), della Corning Glass (1908), dell'Eastmann Kodak (1912), della Philips Eindhoven (1914) e della Siemens and Halske (quest'ultimo creato prima del 1909 e notevolmente ampliato nel 1913). Nel 1909, duecento persone ca. nel mondo si definivano fisici industriali o elettrotecnici e cinquanta dichiaravano di essere impegnate nel campo della fisica tecnica. I fisici restarono indietro rispetto ai chimici che, a partire all'incirca dal 1870, avevano iniziato a organizzare laboratori di ricerca industriale per migliorare i prodotti destinati al mercato, molto competitivo, dei coloranti organici. Nel 1900 tutte le aziende leader del settore ‒ le tedesche AGFA, Bayer, BASF, Hoechst e Ohler ‒ si dotarono di laboratori ognuno dei quali impiegava più di un centinaio di chimici; nel 1913 le industrie chimiche tedesche davano lavoro a 3000 chimici ca. e il numero delle nuove assunzioni raggiunse le 400 unità l'anno.

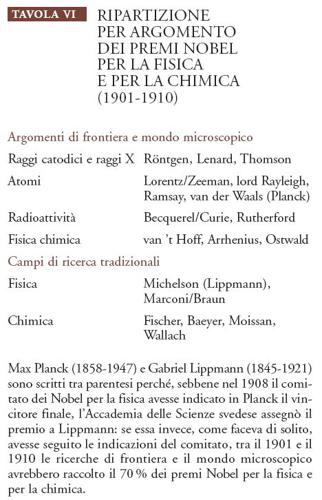

Altre tre istituzioni, create agli inizi del XX sec. grazie al denaro pubblico e/o degli industriali, condizionarono le caratteristiche e il ritmo di sviluppo delle scienze fisiche. Creando una fondazione incaricata di distribuire cinque premi l'anno, finanziati con i proventi derivanti dalla scoperta della dinamite e della polvere senza fumo, Alfred Nobel si proponeva di remunerare coloro che, nel corso dell'anno precedente, avessero acquisito delle benemerenze verso l'umanità; per quanto riguardava la fisica e la chimica, Nobel pensava che i premi dovessero essere assegnati a scienziati che avevano effettuato scoperte e invenzioni dello stesso genere di quelle che si dovevano a lui. In un primo momento, questo criterio di valutazione fu rispettato, come dimostrano il primo Nobel per la fisica, concesso nel 1901 a Wilhelm Conrad Röntgen (1845-1923) per la scoperta dei raggi X, e molti dei primi premi Nobel per la chimica; ben presto, tuttavia, 'i professori' si impossessarono della fondazione e i premi cominciarono sempre più spesso a essere attribuiti a lavori di tipo accademico privi di valore pratico immediato, con la conseguenza che il patrimonio dell'industriale fu usato per finanziare il più ambito e remunerativo riconoscimento nel campo della ricerca scientifica di base.

Gli utili derivanti dal fondo di dieci milioni di dollari di cui nel 1901 Andrew Carnegie dotò un istituto che si proponeva di "condurre, finanziare e sostenere la ricerca in qualsiasi settore della scienza, della letteratura o delle arti, cooperando a tale scopo con amministrazioni, università, istituti superiori, scuole professionali, società scientifiche e singoli studiosi" furono destinati soprattutto a studi sul magnetismo terrestre, sulla geofisica e sulla fisica solare. I fisici occupavano una posizione di primo piano all'interno della Carnegie Institution, diretta, a partire dal 1904, da Robert S. Woodward (1849-1924) che aveva insegnato meccanica e fisica matematica alla Columbia University; le ricerche sul magnetismo terrestre erano condotte sotto la guida di un fisico laureatosi all'Università di Berlino e quelle di geofisica da un laureato di Yale, formatosi presso la Physikalisch-Technische Reichsanstalt; il direttore dell'Osservatorio solare di Mount Wilson, George Ellery Hale (1868-1938), un intraprendente astronomo più volte candidato al premio Nobel per la fisica, svolse, durante la Prima guerra mondiale, un ruolo di primo piano nell'organizzazione della mobilitazione degli scienziati americani.

L'entità dei fondi a disposizione della Carnegie Institution sbalordì i contemporanei. James Dewar (1842-1923), professore di filosofia naturale a Cambridge e di chimica alla Royal Institution a Londra, calcolò che gli interessi annuali della donazione superavano le spese complessive sostenute nell'arco di un secolo dal laboratorio della Royal Institution of Great Britain, nel quale Michael Faraday (1791-1867) aveva effettuato le sue scoperte chimico-fisiche. Nel tentativo di suscitare un'analoga generosità negli industriali del Reich, in Germania fu proposta la creazione di un'istituzione destinata a contribuire al finanziamento di istituti dediti alla ricerca 'pura', la Kaiser-Wilhelm-Gesellschaft. La società avrebbe sostenuto ricercatori di talento affinché si dedicassero alla ricerca della verità con le armi più efficaci dell'indagine scientifica, tenendosi a distanza dalle beghe accademiche. Partendo da una premessa che oggi può apparire singolare ‒ la scienza ha raggiunto un tale livello di importanza e di sviluppo che lo Stato non può più far fronte alle sue necessità da solo ‒ gli ideatori della Kaiser-Wilhelm-Gesellschaft indicavano l'esempio della Carnegie Institution, del laboratorio diretto dal chimico Theodore W. Richards (1868-1928) a Harvard (finanziato dalla Carnegie Institution e impegnato nel campo della determinazione dei pesi atomici) e del Nobel Institute for Physical Chemistry diretto da Arrhenius a Stoccolma, che dimostravano il ritardo della Germania nel campo della mobilitazione delle risorse private da destinare alla scienza e quindi nella costruzione delle 'basi scientifiche' del progresso tecnologico. Nel 1909, la notizia del finanziamento di più di quattro milioni di dollari effettuato a favore della Columbia University e della donazione di un milione di dollari ricevuta dalla University of Chicago per la costruzione di un istituto di fisica, influì favorevolmente sul progetto tedesco. Così, nel gennaio del 1911, venne fondata la Kaiser-Wilhelm-Gesellschaft zur Förderung von Wissenschaft und Forschung, con un capitale vincolato di 10 milioni di marchi ca. (un quarto di quello a disposizione della Carnegie Institution).

Nei primi piani di realizzazione (delineati nel 1908-1909) dei futuri istituti Kaiser-Wilhelm (KWI) si stabilì che il primo obiettivo da conseguire a favore della scienza tedesca fosse la fondazione di un centro di ricerche sulla radioattività e sulla fisica degli elettroni. Tale scelta, operata grazie al contributo di Nernst e dell'Akademie der Wissenschaften di Berlino, rispondeva perfettamente ai problemi più urgenti emersi in campo fisico allora suscettibili di indagini sperimentali dirette. Tuttavia, i primi tre istituti di 'scienze fisiche' furono dedicati alla chimica, come sostituto collettivo di un organismo di ampie dimensioni, analogo alla Physikalisch-Technische Reichsanstalt; i chimici non erano riusciti a ottenere i fondi necessari alla realizzazione di un tale progetto e la Kaiser-Wilhelm-Gesellschaft decise di promuoverlo, facendone un obiettivo prioritario. Il Kaiser-Wilhelm Institut für Chemie conservava del progetto originario solo la sezione per la radioattività diretta da Otto Hahn (1879-1968) e il Kaiser-Wilhelm Institut für Chemie und Elektrochemie destinò le proprie risorse a ricerche di base e, al tempo stesso, applicate, di chimica fisica, del tipo di quelle condotte dal suo direttore Fritz Haber (1868-1934); entrambi furono dotati nel 1911 di uno statuto e nel 1912 entrarono in attività. I costi di costruzione degli edifici (un milione di marchi ca. ciascuno) erano di poco inferiori a quelli sostenuti per il nuovo istituto di fisica di Lipsia, che era costato 1,3 milioni di marchi nel 1904. Il terzo istituto, il Kaiser-Wilhelm Institut für Kohlenforschung (dotato di uno statuto nel 1912 e inaugurato nel 1914), che si dedicava alla ricerca sugli idrocarburi, come combustibili e materie prime, era quello più impegnato in problemi di chimica applicata.

L'integrazione fra chimica di base e chimica applicata che caratterizzava i primi Kaiser-Wilhelm Institut e la Chemische Gesellschaft di Berlino ‒ che nel 1900 contava 3100 membri provenienti da contesti diversi come il mondo accademico e l'industria, vale a dire sia dalla ricerca di base sia da quella applicata ‒ non fu raggiunta né dalla Francia né dalla Gran Bretagna. Al contrario, la Société Chimique de Paris, che intorno al 1900 contava 1100 membri ca., perlopiù insegnanti, non era interessata più di tanto alla chimica applicata. È per questo probabilmente che la sua conferenza all'Esposizione universale del 1900 fu disertata, mentre nello stesso anno il Congresso internazionale di chimica applicata dell'Association des Chimistes de la Sucrerie et de la Distillerie attrasse più di 1800 partecipanti. In Gran Bretagna molti studenti (2400 ca. nel 1895) sostenevano esami che avevano a che fare con la chimica ma pochissimi sceglievano di approfondire lo studio di tale disciplina e, tra questi ultimi, pochi finivano per lavorare nell'industria: tra il 1888 e il 1901, tutti i chimici che conseguirono presso lo University College of London, uno dei centri più importanti per lo studio di questa disciplina, la laurea e il titolo di dottorato si dedicarono all'insegnamento, mentre nel 1902-1913 la percentuale scese al 53%. Tra coloro che si erano soltanto laureati, si passò dal 33% al 20%, un dato che concorda con quello relativo alle carriere intraprese dai laureati del corso di studio in chimica di Cambridge (seconda parte dell'esame finale per ottenere la laurea con lode in scienze naturali). Tuttavia, quasi tutti i chimici impiegati nell'industria svolgevano ricerche analitiche di routine.

L'organizzazione

Uno dei motivi che ci hanno indotto a considerare congiuntamente la professione dei fisici e quella dei chimici va ricercato nel fatto che, intorno al 1900, essi si trovavano di fronte a scelte e percorsi di carriera analoghi. Si prospettavano loro gli stessi tipi di attività: l'insegnamento, la ricerca, l'impiego nell'industria o nello Stato, sia pure in proporzioni diverse, date le maggiori opportunità offerte ai chimici nei settori applicativi. Il riconoscimento del mondo scientifico era legato alla pubblicazione delle ricerche condotte sulle pagine delle principali riviste specialistiche e dei bollettini o atti delle associazioni professionali e delle accademie scientifiche. Tra i bollettini delle associazioni, quelli della Deutsche Physikalische Gesellschaft, della Deutsche Chemische Gesellschaft, della Physical Society di Londra, della Chemical Society di Londra e dell'Institute of Electrical Engineers erano forse i più prestigiosi; tra le accademie nazionali, l'Académie des Sciences di Parigi, la Royal Society di Londra e, a grande distanza, l'americana National Academy of Sciences di Washington non avevano equivalenti in Germania, dato che in questo paese non esisteva ‒ e a tutt'oggi non esiste ‒ un'accademia nazionale; tra le accademie regionali, le più importanti erano quelle di Berlino (Prussia), di Gottinga (Hannover), di Lipsia (Sassonia), di Monaco (Baviera) e, in Inghilterra, di Cambridge. Inoltre, il successo professionale degli scienziati impiegati nell'industria poteva essere favorito dalla divulgazione dei brevetti, mentre periodici di carattere generale o dedicati a singole discipline, come "Nature" (fondata nel 1871), "La nature" (1873), "Physikalische Zeitschrift" (1899) e "Chemical news" (1859) divulgavano notizie scientifiche e non.

Le accademie promuovevano le carriere individuali assegnando premi ed eleggendo nuovi membri. L'Académie des Sciences di Parigi era la più attiva nell'assegnare premi (diverse centinaia l'anno) e nel limitare il numero dei suoi membri (meno di cento, escludendo i corrispondenti). Data la forte coesione del corpo docente francese e la preponderanza dei professori all'interno dell'accademia, molti membri dell'esclusiva Académie erano tra loro in rapporto di parentela sia diretta sia acquisita. La Royal Society era più grande, più democratica e più aperta a persone estranee alla vita accademica e, per tradizione, accoglieva tra i propri membri ingegneri e altri uomini d'azione. Per rendere chiara al pubblico la distinzione tra scienza e tecnologia, la National Academy of Sciences americana invece rifiutò di accogliere il più grande inventore del tempo, Thomas A. Edison (1847-1931). Le accademie regionali tedesche offrivano il privilegio dell'ammissione ai rappresentanti delle più autorevoli discipline, e non solo a quelli delle scienze naturali (come le accademie nazionali di Parigi, Londra e Washington) ma tenevano a distanza gli ingegneri e gli esperti di tecnologia privi di seri titoli di studio; ancora negli anni Venti del XX sec., Planck, da lungo tempo segretario permanente della Preussische Akademie di Berlino, si oppose con successo all'idea di creare all'interno dell'accademia una sezione di scienze applicate; nel suo sistema di valori, infatti, la scienza naturale era più vicina alla storia che all'ingegneria.

Le istituzioni di livello locale (università, politecnici, laboratori pubblici e industriali), regionale e nazionale (associazioni professionali e accademie) erano precedute, nella scala della comprensività, dalle associazioni nazionali per il progresso della scienza e da una serie di organizzazioni internazionali dotate di vari livelli di specializzazione e di continuità. Le associazioni nazionali organizzavano incontri annuali che riunivano scienziati, sostenitori della scienza e il pubblico interessato a temi scientifici in luoghi di anno in anno diversi. I fisici e i chimici consideravano un grande onore quello di essere invitati a prendere la parola nelle assemblee plenarie che si svolgevano nel corso di questi incontri e di informare il pubblico sugli ultimi sviluppi registrati nelle loro aree di indagine. Soprattutto intorno al 1900, periodo in cui il paesaggio della scienza fisica mutava molto rapidamente, ai meeting dell'associazione nazionale britannica (British Association for the Advancement of Science) e di quella tedesca (Gesellschaft deutscher Naturforscher und Ärzte) intervenivano illustri scienziati, spesso provenienti dall'estero.

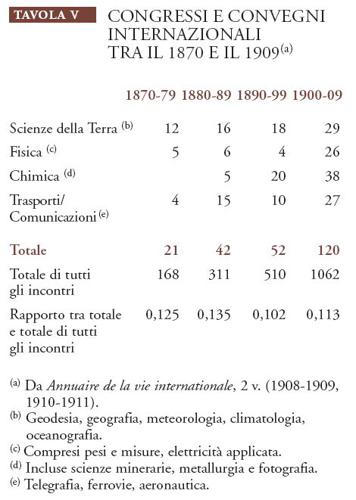

L'internazionalismo era una caratteristica distintiva del periodo compreso tra il 1870 e il 1914, come, del resto, i nazionalismi che cercava di contenere. Il parametro più istruttivo in tal senso forse è quello della frequenza dei congressi e dei convegni internazionali, favorita non soltanto dalle spinte cosmopolite o filantropiche, ma anche dal sistema di comunicazioni e di trasporti europeo, sempre più efficiente e organizzato, grazie al vapore, all'acciaio e all'elettricità. La necessità di coordinare e di regolamentare tale sistema fu all'origine di molti incontri internazionali, come mostrano i dati riportati nella Tav. V.

Questi dati ordinati in modo approssimativo indicano che gli incontri internazionali che avevano come oggetto le scienze fisiche e le loro applicazioni aumentarono allo stesso ritmo degli incontri internazionali tout court, mantenendosi costantemente al di sopra del 10% e conservando la loro relativa importanza rispetto agli incontri dedicati agli affari diplomatici, commerciali e legali, che costituivano la maggioranza dei meeting internazionali, ma la loro frequenza non sta a indicare che gli scienziati avessero una mentalità più internazionale degli uomini d'affari.

In realtà, la percentuale della fondazione di nuove organizzazioni internazionali permanenti mostra uno spostamento nel tempo in direzione delle scienze sociali più generali. Nel periodo 1870-1879, le categorie considerate nella Tav. V diedero origine ad almeno il 40% delle nuove organizzazioni, percentuale che scese al 20% nei vent'anni successivi.

La maggior parte dei congressi e dei convegni internazionali scientifici verteva su argomenti relativi agli standard (delle procedure e delle unità) da adottare o su fenomeni che si riteneva fosse opportuno discutere a livello mondiale, come, per esempio, le scienze della Terra, e che rientravano nella categoria dell''internazionalismo inconscio', secondo la distinzione proposta da Alfred Fried (1864-1921), capo dell'Office Central des Institutions Internationales di Bruxelles. Secondo Fried i rapidi progressi compiuti nel campo dei trasporti, delle comunicazioni e della tecnica riducevano inesorabilmente le dimensioni del mondo, avvicinando le persone e rafforzando la cooperazione: "la scienza intera lavora inconsciamente in modo internazionale". Le organizzazioni che si proponevano come fine di promuovere una particolare area di studio attraverso l'istituzione di organismi permanenti e l'organizzazione di incontri regolari erano invece ricondotte alla categoria dell''internazionalismo conscio'.

Tra le organizzazioni più consapevolmente internazionali figuravano le associazioni di organismi nazionali. L'International Association of Academies, fondata nel 1899 su iniziativa dell'Akademie der Wissenschaften di Berlino e della Royal Society di Londra, fu forse la prima organizzazione a 'ombrello' non pubblica. Essa si proponeva di promuovere una 'scienza senza frontiere' e di ritagliare uno spazio per le accademie nell'affollato mondo delle organizzazioni scientifiche, dichiarazione di intenti rispettata con la realizzazione di progetti bibliografici, con la standardizzazione della nomenclatura e con l'esecuzione di rilevamenti geografici su vasta scala. Nel 1911 fu fondata l'Association Internationale des Sociétés Chimiques, su proposta di Ostwald, il quale offrì la propria casa come sede, i propri libri come biblioteca e il premio Nobel che gli era stato assegnato come fondo economico. Nel 1914, Charles Edouard Guillaume (1861-1938) propose la fondazione di un'associazione analoga per le società di fisica, proprio nel momento in cui l'internazionalismo, che Fried e i suoi colleghi consideravano "il fenomeno più caratteristico e più impressionante del XX sec.", era sul punto di essere spazzato via dalla guerra. Guillaume diresse il Bureau International des Poids et des Mesures, fondato nel 1875. Finanziato da un consorzio di Stati grosso modo allo stesso livello dell'Institut für Physik dell'Università di Berlino, questo ufficio controllava gli standard metrologici, sottoponeva i nuovi prodotti a test e svolgeva una serie di ricerche, concernenti in particolar modo le misurazioni di precisione relative alle proprietà delle leghe di nickel e acciaio, per le quali Guillaume ottenne il premio Nobel nel 1920.

La più rilevante e logica conseguenza dello scambio internazionale in campo fisico e chimico sarebbe stata la creazione di un'organizzazione incaricata di coordinare il lavoro svolto nel mondo nelle scienze fisiche in un imponente progetto di ricerca. Nel 1912-1913 quest'esigenza fu soddisfatta grazie alla generosità di Ernest Solvay (1838-1922), facoltoso barone belga dell'industria chimica e aspirante fisico teorico. Egli aveva già effettuato donazioni destinate a istituti di fisiologia e di sociologia di Bruxelles, dove Nernst lo aveva convinto a finanziare un incontro internazionale nel corso del quale molti illustri fisici avrebbero discusso le questioni più scottanti del momento, ossia la teoria della radiazione e i quanti. Solvay vedeva in questo meeting un'opportunità di comunicare le proprie idee ai più grandi esperti del mondo; benché questi ultimi lo avessero ignorato, l'incontro si rivelò un tale successo che l'industriale decise di fondare l'Institut International de Physique Solvay, per poter continuare la discussione. L'Institut avrebbe impiegato i fondi di cui era stato dotato per assegnare borse di studio a giovani laureati belgi e piccoli contributi di ricerca a studiosi europei, oltre che per organizzare altri incontri nel corso dei quali sarebbero stati affrontati problemi di fisica e di chimica correlati alla realizzazione della sua grandiosa visione scientifica. In seguito, Solvay pensò di finanziare l'Association Internationale des Sociétés Chimiques di Ostwald ma poi decise di creare invece un istituto per la chimica parallelo all'Institut International de Physique; entrambi erano stati progettati per durare trent'anni, un periodo di tempo sufficiente ‒ secondo i calcoli di Solvay ‒ al completamento delle scienze fisiche.

All'inizio del 1914, quando l'Institut International de Physique aveva già iniziato la sua attività, la nuova rivista scientifica francese "La nature" lo descrisse come parte del vasto movimento internazionale per la fondazione di organizzazioni scientifiche e come "il tentativo più concreto realizzato fino a questo momento di creare un'organizzazione [per la gestione e l'attività sistematica] della scienza nella sua interezza". Gli istituti riuscirono a definire, se non a coordinare, i temi più importanti sul fronte della ricerca per almeno un quarto di secolo.

La disciplina

La conferenza tenuta da Solvay a Bruxelles nel 1911 si basava su molte idee universalmente accettate, delineando una fisica e una chimica unificate da principî elettrici ed energetici e applicate alla fisiologia (e, in definitiva, a questioni sociologiche) in base a criteri rigidamente materialisti e positivisti. Nella vera scienza non potevano trovare spazio il mistero, gli spiriti vitali, le anime o le costruzioni grandiose, a eccezione di quella di Solvay, che poggiava su leggi chiaramente derivanti dall'esperienza e dalla stessa confermate. Il suo parere era che tutti i gruppi sociali e persino l'intero genere umano dovrebbero essere immaginati come una reazione chimica organizzata; la chimica e la fisica sono le scienze "éther direct et éther inverse atomiquement et invariablement cubifiables; [...] spacification et superficialisation énergétiquement produites, et énergie exclusivement engendrée par contacts moléculaires" (Langevin 1912, p. 2). In queste considerazioni azzardate è facile riconoscere alcune tesi dello scientismo ed echi dei dibattiti sull'etere, sull'energia e sull'atomo in corso negli incontri tra fisici intorno al 1900.

Scientismo e descriptionism

I pilastri sui quali poggiava lo scientismo della fine del XIX sec. erano il materialismo e il positivismo, dottrine secondo le quali lo scopo della scienza è quello di stabilire le leggi del comportamento della materia e che ritengono che la scienza in tal modo concepita contenga soltanto conoscenze 'positive', ossia conoscenze vere.

Le loro fondamenta erano costituite dagli insegnamenti di Auguste Comte (1798-1857), dalle leggi dell'evoluzione e della combinazione chimica e dalle grandi sintesi operate dalla fisica del XIX sec.: tra la teoria della luce e quelle dell'elettricità e del magnetismo, tra la teoria del calore e quella del movimento e, tramite le leggi dell'energia, tra la meccanica newtoniana e tutte le altre teorie. La sempre più rilevante applicazione della fisica e della chimica all'obiettivo di moltiplicare i 'beni' materiali e la conseguente confusione della scienza con le volgari attività commerciali confermavano l'idea che la scienza fosse divenuta una minaccia per i valori tradizionali. In tal senso Solvay, che progettava di impiegare i metodi del mondo degli affari per ottenere il riconoscimento del suo programma materialista, rappresentava un esempio perfetto.

Benché molte delle prove a favore del materialismo provenissero dalle ricerche degli scienziati accademici, la maggior parte di essi non condivideva in pieno le posizioni dello scientismo. Specialmente l'assimilazione della scienza alla tecnologia ‒ che fosse dovuta a un'epistemologia ragionata o a semplice confusione ‒ sollevava la loro opposizione. Questa assimilazione minacciava il loro status: lo scienziato tedesco, che si considerava l'incarnazione e il portatore delle più alte aspirazioni del popolo tedesco, si sentiva sminuito dall'identificazione con i seguaci del 'Materialismus und Amerikanismus'. I fisici sottolineavano la propria formazione umanistica, che condividevano con gli alti funzionari dello Stato e che li distingueva dalle categorie dei commercianti e degli industriali, ed erano i più refrattari ad accettare l'idea di elevare il livello degli istituti tecnici e di introdurre corsi di carattere tecnico nelle università.

Negli Stati Uniti, molti importanti uomini di scienza cercarono di prendere le distanze da una tecnologia che rischiava di compromettere la loro battaglia per ottenere il pubblico riconoscimento del valore della ricerca pura o disinteressata. "The popular science monthly" protestava contro la tendenza a degradare la scienza trasformandola "in una volgare attività a fini di lucro"; all'American Association for the Advancement of Science giungevano lamentele sull'inutile spreco dell'intelletto americano teso a perseguire la cosiddetta 'scienza pratica'; il chimico fisico Noyes temeva di essere disprezzato "per aver abbandonato le ricerche [sugli ioni] a favore di attività di tipo industriale"; i memorialisti elogiavano i fisici defunti che non avevano ceduto alle lusinghe dell'industria. Secondo l'eminente fisico Henry Rowland (1848-1901) il telegrafo elettrico, che in teoria avrebbe dovuto rappresentare un fiore all'occhiello per la fisica, costituiva in realtà un gravissimo pericolo per questa scienza. La fisica pura rischiava infatti di perdere il sostegno di un'opinione pubblica che tendeva a confondere il telegrafo e la luce elettrica con la vera scienza.

L'elettrotecnica aveva avuto origine dalle scoperte effettuate nei laboratori di ricerca ma, una volta identificati, i suoi principî fondamentali potevano essere sfruttati a livello tecnico; di conseguenza, i ministri dell'istruzione avrebbero potuto ragionevolmente decidere di indirizzare le risorse pubbliche e industriali all'istruzione tecnica di alto livello, sottraendole alla ricerca accademica. In Gran Bretagna le scuole tecniche stavano crescendo e moltiplicandosi molto più rapidamente dei corsi universitari di carattere tecnico. In Francia la classe docente della Sorbona e dell'Académie des Sciences parigina respinse la proposta di aggiungere corsi tecnici ai piani di studio, riconoscendo in essa una minaccia al suo status intellettuale ed economico. Analogamente, la campagna condotta dai politecnici tedeschi per ottenere il diritto di rilasciare titoli di dottorato illustra chiaramente quali fossero gli interessi in gioco.

Le università, compresi molti professori di scienze, si opponevano perché temevano l'abbassamento del livello sia intellettuale sia sociale dell'istruzione superiore al quale avrebbero condotto l'equiparazione dei politecnici ‒ sorti dal nulla ‒ con le antiche sedi della cultura e la riduzione dei fondi per l'insegnamento e per la ricerca riservati alle università (uniche sedi fino ad allora autorizzate al rilascio dei titoli di dottorato). Tali argomentazioni tuttavia non convinsero l'imperatore, il quale, annunciando nel 1899 la concessione dell'agognato diritto, elogiò l'istruzione tecnica per il suo contributo alla prosperità della Germania e per la sua capacità di offrire ai ragazzi di buona famiglia la possibilità di effettuare scelte di vita diverse da quelle tradizionali ‒ una funzione sociale che la concessione del nuovo privilegio le avrebbe consentito di svolgere ancora più efficacemente. A sua volta, il rettore della Technische Hochschule di Berlino definì il programma sociale della sua scuola come l'eliminazione della componente umanistica da quelli che definì 'istituti tecnici per insegnanti', ossia dalle università: agli scienziati al servizio dell'industria erano necessarie la fisica e la chimica come strumenti per migliorare la qualità dei prodotti e non come semplici orpelli dell'intelletto.

La scomoda posizione imposta dalle nuove circostanze a fisici e chimici accademici intorno al 1900 rimase sostanzialmente immutata fino alla guerra. Gli unici miglioramenti si ebbero grazie agli aumenti dei finanziamenti per la ricerca, ai progressi nella teoria della fisica e alla ridefinizione dei ruoli di università, scuole superiori tecniche, uffici governativi e laboratori industriali. Il premio Nobel probabilmente contribuì a evitare che la "dolce musica delle leggi naturali venisse soffocata dagli squilli di tromba del successo tecnico". Questo almeno era il giudizio di van 't Hoff, il primo assegnatario del Nobel per la chimica, il quale plaudì alla decisione di estendere i premi a scoperte utili al progresso della scienza e non soltanto a quello della tecnica: "Nella nostra epoca di competizione industriale tra le varie nazioni l'aspetto [pratico] ha assunto ormai una netta prevalenza".

Rimaneva da risolvere il problema di quei detrattori che confondevano la descrizione meccanicistica della realtà basata sui principî dell'energia, dell'evoluzione, della fisiologia chimica e della psicofisica con il materialismo scientifico e condannavano entrambi in quanto avversari della fede e della poesia. Per questi detrattori l'insegnamento della scienza minava alle fondamenta non solamente la famiglia, l'etica, l'estetica e la religione ma anche i valori di fedeltà e sacrificio sui quali si basava lo Stato moderno, aprendo la strada al socialismo e persino all'anarchia. Per combattere questa minaccia, si stabilì un'inedita alleanza tra esponenti degenerati dell'avanguardia, ansiosi di liberarsi dal determinismo incombente, e i loro più feroci oppositori, ossia i portavoce della religione stabilita e dell'istruzione, gli antirepubblicani e gli ultramontani.

Un caso avvenuto nel 1895 illustra chiaramente lo scambio di accuse tra scienza e scientismo nel periodo fin de siècle. Un famoso critico letterario francese, Ferdinand Brunetière (1849-1906), dopo una visita in Vaticano accusò la scienza di bancarotta morale e filosofica: "non possiamo trarre dalle leggi della fisica o dai risultati della fisiologia nessun metodo per conoscere alcunché". Gli scienziati risposero che la scienza non aveva dogmi. Ottocento non-dogmatisti, compresi quaranta senatori e settanta deputati, organizzarono un banchetto in risposta a Brunetière e in onore di Marcelin Berthelot (1827-1907), chimico positivista e ministro degli affari esteri materialista. Nel proprio brindisi il presidente della Camera dei deputati rivelò ciò che aveva ispirato Brunetière: "La formula 'bancarotta della scienza' [egli disse] è soprattutto un'espressione di carattere politico, un mezzo per riaccendere la reazione clericale". I membri più sensibili della British Association for the Advancement of Science percepirono un'analoga minaccia in un discorso tenuto in quella sede nel 1894 da lord Salisbury, il quale osservò che i fisici onesti ammettevano di conoscere assai poco la natura delle cose e dalla confessione dell'ignoranza presente mosse abilmente verso l'affermazione di un'ignoranza futura, dall''ignoramus' all''ignorabimus'. Una parte dei suoi ascoltatori, tra cui Karl Pearson (1857-1936), studioso di matematica applicata, comprese che l'insistenza di Salisbury sull'impotenza della scienza doveva condurre inevitabilmente alla conclusione che, dal momento che la scienza non aveva le risposte, si doveva concedere che fosse la religione a fornirle. Se le cose stavano così, il pericolo era reale, perché Salisbury, ossia Robert Arthur Talbot Gascoyne-Cecil (1830-1903), era primo ministro dell'Inghilterra.

Forse però il pericolo più grave proveniva dall'opposto versante politico, non dai Salisbury bensì dai socialisti. Così la pensava lo storico Charles Pearson (1830-1894), il quale predisse nel 1893 che le nazioni occidentali, avendo raggiunto i limiti dell'espansione coloniale, si sarebbero stabilizzate internamente attraverso regimi socialisti e che il socialismo avrebbe sovvertito la scienza insieme a tutto il resto. I nuovi Stati non avrebbero eliminato la scienza ma avrebbero favorito piuttosto le attività di dettaglio, relative alla diffusione, all'applicazione e alla misurazione, l'arido lavoro dello specialista. Adolf von Harnack (1851-1930), autore della storia ufficiale dell'Akademie der Wissenschaften di Berlino, che in un momento di maggiore ottimismo aveva contribuito alla fondazione della Kaiser-Wilhelm-Gesellschaft, pensava che già nel 1900 i fisici avessero rinunciato a porsi le grandi questioni e avessero perso il proprio ascendente intellettuale rifugiandosi nell'approfondimento delle questioni di dettaglio.

Non fu facile per gli scienziati che si occupavano di fisica ribattere agli attacchi di segno opposto ‒ ai quali spesso facevano riferimento ‒ che accusavano allo stesso tempo la loro scienza di essere impotente e sovversiva. Da una parte, volendo favorire la diffusione delle proprie scoperte, sia per motivi di soddisfazione personale sia per ottenere maggiori finanziamenti, essi non potevano minimizzarne la portata; dall'altra parte, non potevano neppure affermare di avere conoscenze sufficienti per fornire una descrizione profonda e soddisfacente della Natura, nel senso umanistico. La situazione nella quale si trovava la scienza rendeva necessaria l'adozione di un atteggiamento umile. In occasione del cinquantenario della sua attività, nel 1895, lord Kelvin (William Thomson) per caratterizzare l'opera della sua vita aveva proposto un solo termine: fallimento. Su etere e materia o sul rapporto tra gli stessi egli non era arrivato a conoscere più di quanto non ne sapesse già agli esordi della sua carriera e né Kelvin né altri sapevano sulla natura della gravità più di quanto non fosse già a conoscenza di Newton nel momento in cui egli smise di azzardare ipotesi in proposito. La strategia adottata dai portavoce della scienza per eludere l'abbraccio della tecnologia, ripudiare l'accusa di materialismo scientifico e 'suonare la nota giusta del vigore' era la strategia dell'umiltà. Essi dichiararono che la scienza non poteva arrivare all'essenza delle cose; benché le scoperte nel campo della fisica e della chimica potessero condurre a invenzioni tali da rivoluzionare il vecchio modo di vivere, nulla di ciò che insegnavano poteva costituire una minaccia per i valori umanistici, per la religione o per l'etica. La dottrina secondo la quale la scienza non aspira a scoprire l'essenza della materia bensì solamente a descriverne le apparenze può essere definita descriptionism, dal termine vittoriano descriptionist, 'colui che afferma di fornire una descrizione'.

L'allocuzione principale all'International congress of physics del 1900 fu una lunga e brillante dichiarazione di adesione al descriptionism. Il relatore, Poincaré, fece riferimento al nuovo ruolo sociale della fisica; il compito dei fisici, affermò, è di incrementare la 'produzione della macchina scientifica' ed essi lavorano più come bibliotecari che come filosofi, raccogliendo e catalogando fatti noti, identificando lacune nella collezione e acquisendo dati nuovi dalla Natura grazie alle accresciute risorse dei loro laboratori. Il successo della loro impresa andava misurato in base alla sua completezza, alla sua utilità e alla qualità del catalogo della biblioteca della scienza. Nella classificazione non conta la verità, ma solo l'utilità; i pezzi più pregiati della biblioteca sono costituiti da fatti e da rapporti fenomenologici. Il fisico può modificare il suo catalogo o la sua descrizione ‒ oppure, al di fuori di metafora, le sue teorie e i suoi modelli ‒ per renderla appropriata secondo necessità ma non potrà mai raggiungere la verità.

Elementi di descriptionism possono essere rinvenuti in Kant, in Comte e nella scienza fisica strumentalista della fine del XVIII sec., per non risalire ancora più indietro. Le sue fonti prossime erano principalmente, nella scienza della fine dell'Ottocento, la pratica di Kelvin e di James C. Maxwell, gli scrupoli di Gustav Robert Kirchhoff, le geremiadi di Ernst Mach e l'opposizione all'atomismo di Berthelot, di Ostwald e di altri chimici scettici. Evitando di effettuare indagini sulla natura fondamentale della forza, Kirchhoff aveva dichiarato nel 1875 che i principî della meccanica non erano leggi stabilite dalla Natura bensì descrizioni inventate dai fisici; nello stesso tempo Mach ammoniva i propri colleghi, ricordando loro che nel prendere troppo alla lettera le loro teorie essi avevano dimenticato la verità fondamentale della loro scienza, ossia che essa non ha nulla a che vedere con la verità. Il punto di vista di Mach e quello di Kirchhoff non ebbero successo tra i fisici europei prima che la dimostrazione, da parte di Heinrich Rudolf Hertz (1857-1894), dell'esistenza della radiazione elettromagnetica predetta da Maxwell attirasse la loro attenzione sui metodi della fisica britannica. Molti dichiararono di essere scioccati da quanto avevano verificato.

Maxwell non sembrava tenere in grande considerazione il rigore; coerentemente con l'approccio tipico dei fisici matematici formatisi a Cambridge, egli utilizzava contemporaneamente analogie meccaniche contraddittorie o saltava da un modello all'altro. Poincaré rilevò la 'sensazione di sconforto, addirittura di esasperazione' che le acrobazie di Maxwell suscitavano nei lettori francesi. Hertz riconobbe che non era mai riuscito a comprendere come le equazioni potessero essere dedotte dal modello. Ma il successo non ha bisogno di raccomandazioni. I fisici europei si domandavano come Maxwell avesse potuto erigere un struttura incrollabile ‒ le equazioni fondamentali dell'elettrodinamica ‒ partendo da un'impalcatura traballante, composta da elementi presi a prestito dall'officina meccanica vittoriana. Hertz e Poincaré risposero che, poiché i modelli erano intesi solamente come descrizioni, essi non dovevano essere necessariamente esatti o coerenti e potevano essere scelti o scartati a piacimento, senza per questo mettere in pericolo i risultati ottenuti con il loro aiuto.

Di conseguenza, l'ampio consenso descriptionist coagulatosi intorno al 1900 non implicava un accordo su quale fosse il modo più appropriato di descrivere la realtà. La grande maggioranza degli scienziati riteneva che l'obiettivo fondamentale, e addirittura la definizione stessa, della loro materia dovesse essere la riduzione di tutti i fenomeni fisici ai principî della meccanica. Il principio di conservazione dell'energia sembrava garantire il successo, l'unificazione dell'ottica e dell'elettrodinamica aveva ridotto gli adattamenti richiesti e la teoria dei gas mostrava la direzione da seguire o quantomeno una delle possibili direzioni. Poincaré e Helmholtz raccomandavano di evitare i dettagli 'imbarazzanti' e di limitarsi a enunciare le equazioni dell'elettrodinamica e della termodinamica come conseguenze formali di una formulazione astratta della meccanica generale, quale il principio di minima azione; osservavano, inoltre, che fin quando questo principio reggeva, le descrizioni meccaniche potevano essere moltiplicate a piacimento e, di conseguenza, ritenevano che fosse una perdita di tempo formularne di nuove. Coloro che trovavano troppo astratto questo metodo preferivano in genere ricorrere a una descrizione basata su un sistema meccanico generale, diciamo uno sciame di atomi o i vortici in un etere. Questa era la soluzione scelta da Marie-Alfred Cornu (1841-1902) e da molti altri e anche, per alcuni aspetti, da Kelvin e da Thomson.

L'opposizione più dura al riduzionismo meccanicista venne da Mach e da Ostwald. Secondo Mach persino il concetto di materia era divenuto superfluo: l'obiettivo della scienza doveva essere l'esposizione stringata di rapporti tra sensazioni e non la reificazione di un pio desiderio. In un famoso discorso tenuto davanti alla Deutsche Naturforscherversammlung (Assemblea dei naturalisti tedeschi) nel 1895, Ostwald esortò i suoi colleghi ad abbandonare la teoria atomica e altre immagini esplicite che la termodinamica aveva dimostrato essere insostenibili: "non ti farai idolo o immagine alcuna di nulla".