La seconda rivoluzione scientifica: fisica e chimica. Atomi, molecole e ioni

La seconda rivoluzione scientifica: fisica e chimica. Atomi, molecole e ioni

Atomi, molecole e ioni

La città di Lubecca è stata l'insolita scena dello svolgimento di un dramma intellettuale quando, nel 1895, la Società tedesca di scienziati e medici vi giunse per la sua riunione annuale. L'evento attirò alcuni dei migliori scienziati dell'epoca: figure di primo piano come Ludwig Boltzmann, il principale sostenitore della fisica molecolare, nonché giovani celebrità quali Max Planck, un perspicace studioso di termodinamica, e Walther Hermann Nernst, un chimico fisico affermatosi grazie alla sua nuova teoria sulle celle galvaniche. Costoro erano tutti presenti quando il loro collega Friedrich Wilhelm Ostwald (1853-1932), proveniente da Lipsia, tenne una conferenza sul tema intenzionalmente provocatorio Die Überwindung des wissenschaftlichen Materialismus (Il superamento del meterialismo scientifico). Ostwald possedeva una vasta conoscenza delle scienze fisiche e un talento innegabile nel riconoscere l'importanza di nuove idee. Alla metà degli anni Ottanta del XIX sec. egli era stato tra i primi a ravvisare l'importanza di una teoria della ionizzazione nelle soluzioni chimiche avanzata da uno svedese ancora poco noto, Svante August Arrhenius; pochi anni dopo aveva scoperto i raffinati lavori di termodinamica di un americano ugualmente sconosciuto, Josiah W. Gibbs, e li aveva tradotti in lingua tedesca. Ostwald era un intelligente sperimentatore, un instancabile autore e un professore carismatico, qualità che gli permisero di acquistare una grande stima.

Malgrado il titolo wagneriano, la conferenza di Ostwald fu breve; il 'materialismo' cui egli si riferiva era quello che basava la propria comprensione del mondo naturale sulle concezioni cinetico-molecolari. Ostwald riconosceva che in passato la teoria atomica della materia, la teoria cinetica dei gas e le altre teorie meccaniche basate sulle forze agenti su e tra ipotetiche particelle erano state di grande aiuto alla scienza, ma ora dovevano confrontarsi con sfide che richiedevano altri tipi di soluzione. Invece di "cercare forze la cui esistenza non possiamo provare, tra atomi che non possiamo osservare", egli esortò gli scienziati a focalizzare di nuovo i loro sforzi su un'alternativa che comportasse meno assunzioni su entità non osservabili, ossia su una scienza basata sull'energia e sulle sue trasformazioni. Ostwald sosteneva che l'energia era conoscibile attraverso la misura diretta del calore, della pressione e del lavoro; il suo studio, in particolare mediante la termodinamica, aveva permesso di risolvere molti problemi in fisica e chimica. Era tempo di accorgersi che la termodinamica poteva non soltanto essere indipendente dall'assunzione di ipotesi sulla materia, ma anche, se opportunamente utilizzata, ovviare alla necessità di adottare tali ipotesi in tutti i settori della fisica e della chimica. All'interno di questo sistema, la massa poteva essere definita come il fattore di capacità dell'energia cinetica, l'occupazione dello spazio come energia di volume, la gravitazione come energia di distanza, e così via. La materia stessa, secondo Ostwald, non era "altro che un gruppo di varie forme di energia coordinate nello spazio".

Coloro che assistettero alla conferenza di Ostwald erano pronti a comprendere la sua diagnosi dei mali della teoria cinetico-molecolare e forse anche la sua prescrizione per il loro trattamento. Le teorie meccaniche della materia e del moto avevano dominato la fisica del XIX sec. ed erano state il prisma attraverso il quale la maggior parte degli scienziati, e non solo loro, aveva osservato la Natura. Tuttavia molti studiosi erano consci dell'esistenza di un divario persistente tra le ambizioni della scienza meccanicistica ‒ ossia descrivere l'azione delle forze della Natura in modo sia internamente coerente sia fedele all'evidenza empirica ‒ e i risultati effettivamente conseguiti. Formatisi culturalmente in ambienti in genere kantiani, i fisici erano dolorosamente consapevoli della necessità di risolvere una questione fondamentale, ossia se i modelli concepiti dalla mente umana potessero cogliere la realtà della Natura in termini delle categorie derivanti dall'esperienza di ogni giorno.

Ciononostante, il rimedio adottato da Ostwald per sanare i ben definiti difetti della teoria cinetico-molecolare non suscitò un grande entusiasmo. Il suo totale rifiuto della teoria meccanica a favore di una concezione filosofica approssimativa basata sul concetto di energia sembrò ai suoi colleghi un atteggiamento avventato e, a quanto pare, Ostwald e i suoi pochi seguaci ebbero la peggio nelle discussioni che seguirono la conferenza. Gli sforzi per diffondere la loro concezione provocarono molta curiosità e qualche approvazione, ma anche pungenti critiche. Perfino chi nutriva profonde riserve nei confronti degli atomi e delle teorie meccaniche, come Planck, richiamò Ostwald sulla portata esagerata dei principî basati sull'energia, sulla minimizzazione delle difficoltà incontrate per spiegare fenomeni come quelli chimici in termini energetici e sull'alterazione dei concetti della termodinamica nel portare avanti la sua teoria. L'idea che l'energia potesse servire quale base di una teoria fisica completa sopravvisse a malapena al XIX secolo.

Pur se fallito, il tentativo di rivoluzione portato avanti da Ostwald testimoniò comunque la condizione della comunità scientifica; inoltre il suo attacco alle teorie atomiche, molecolari e meccanicistiche non fu l'unico. Il confronto svoltosi a Lubecca fu un episodio che si rivelò particolarmente importante nei numerosi dibattiti sui fondamenti delle scienze fisiche alla fine del XIX sec., soprattutto negli anni Novanta e all'inizio del XX secolo. La veemenza di questi dibattiti smentisce l'idea, una volta luogo comune, che la scienza di fine secolo fosse una tranquilla impresa adibita alla determinazione delle costanti fisiche, al perfezionamento della meccanica classica e all'assidua applicazione della conoscenza scientifica per scopi industriali.

Per la verità, la maggior parte degli argomenti dei dibattiti era obsoleta. Gli Antichi avevano discusso l'esistenza delle particelle indivisibili, il loro ruolo nello spiegare le proprietà della materia e la relazione esistente tra gli schemi umani dell'ordine naturale e la realtà. Gli scienziati moderni sono tornati sugli stessi argomenti, opportunamente aggiornati, non appena l'atomismo nel XVII sec. è rifiorito come parte della filosofia naturale. Le antiche questioni hanno assunto tuttavia una rilevanza sempre maggiore nel XIX sec., quando l'atomismo è divenuto parte integrante di nuove discipline scientifiche teoriche e pratiche, e quando gli scienziati hanno consapevolmente posto la loro conoscenza a debita distanza da altre forme di apprendimento, esigendo per essa un'opportuna certezza o, almeno, verificabilità.

Soltanto uno storico sprovveduto potrebbe sostenere che tali questioni non sono mai state risolte. È chiaro invece che nei primi anni del XX sec. emerse qualcosa di simile a un consenso generale, che sembrò rendere superabili in linea di principio, se non nei particolari, i contrasti degli anni Novanta dell'Ottocento. Energia e materia, considerate da Ostwald fondamenti scientifici alternativi, furono unificate dalla teoria della relatività di Einstein. La teoria cinetica e la termodinamica, che qualche sostenitore dell'energetismo descriveva come visioni del mondo antagoniste, vennero successivamente ritenute strumenti complementari di analisi e di interpretazione. L'atomo, sebbene non più indivisibile, acquistò nell'ambito della teoria fisica un consolidamento mai raggiunto prima e una struttura interna adatta a spiegare non soltanto la maggior parte delle proprietà fisiche della materia, ma anche molti fenomeni chimici. Le questioni riguardanti i costituenti ultimi della materia e la nostra capacità di conoscerli non furono risolte, ma trasferite in un altro ambito, ossia a un nuovo complesso di particelle che si pensava componessero gli atomi e alla teoria quantistica concepita per studiarle. La scienza del XX sec. diventò decisamente e autoconsapevolmente di tipo corpuscolare.

Negli anni Novanta del XIX sec. questo sviluppo era tanto imprevisto quanto imprevedibile. La strada che portò a tale situazione non passò attraverso la rielaborazione di concetti e di convinzioni familiari, che è essenzialmente la direzione che sia Ostwald sia i suoi oppositori perseguirono; piuttosto, la controversia sull'esistenza e sull'utilità degli atomi produsse idee e metodi che provenivano da lavori su argomenti e fenomeni che non avevano fatto parte dei discorsi tenuti a Lubecca o dei dibattiti precedenti sull'atomismo.

Atomismo fisico e chimico

Lo scetticismo generale verso l'atomismo, che caratterizzò l'ultimo decennio del XIX sec., sembra a prima vista un mistero, non soltanto perché sappiamo come sarebbe diventata centrale nel secolo a venire la teoria corpuscolare, ma anche perché l'atomismo aveva riscosso fino a quel momento un vasto consenso. Dal 1870 gli atomi e le molecole furono incorporati nei fondamenti di molte discipline della fisica: per esempio, negli studi di dinamica centrati sulle forze attrattive e repulsive esercitate da particelle, nel tentativo di spiegare fenomeni come l'azione capillare e l'elasticità, e, dopo la metà del secolo, nelle teorie dell'elettricità, dove gli atomi venivano considerati come portatori di carica. Tuttavia i campi nei quali gli atomi e le molecole ebbero il ruolo più importante furono la teoria cinetica dei gas e la chimica che, per contro, fornirono le argomentazioni più convincenti a favore della teoria corpuscolare della materia.

La teoria cinetica ha assunto in questo contesto il ruolo più importante, sia per la forma matematica con la quale poteva essere espressa la maggior parte dei suoi principî, sia per la riuscita nel coordinare molte leggi scoperte per via sperimentale. Sebbene le sue radici si possano far risalire al XVIII sec., gli sviluppi più coerenti di tale disciplina ebbero inizio negli anni Quaranta del XIX sec. con James P. Joule, che descrisse il calore come una manifestazione del movimento, e proseguirono con Rudolf Clausius e James C. Maxwell, che negli anni Cinquanta e Sessanta utilizzarono con efficacia le intuizioni di Joule per lo studio dei gas.

Le loro ipotesi erano semplici e i risultati ottenuti di notevole portata. Essi consideravano i gas composti da costituenti atomici o molecolari che potevano essere trattati quali sfere elastiche o centri puntiformi delle forze newtoniane: la temperatura era ritenuta una manifestazione dell'energia cinetica media delle particelle del gas e la pressione una conseguenza delle numerose collisioni tra le particelle del gas e le pareti del contenitore. Avanzando semplici ipotesi sull'interazione tra le particelle, Clausius e Maxwell fornirono una base teorica alle ben note leggi di Boyle, Charles e Henry, dimostrarono l'ipotesi di Avogadro e ottennero risultati riguardanti problemi come la diffusione dei gas, la loro conduzione del calore e la loro viscosità.

Il potere aggiuntivo della teoria cinetica e le sue occasionali nuove predizioni quantitative fornirono una prova inconfutabile a favore dello stato granulare della materia. Allo stesso modo fu sensazionale la forza dei modelli cinetico-molecolari per stimolare idee creative su problemi al di fuori del suo ambito principale, cioè il comportamento dei gas. Per esempio, nel 1873 il fisico olandese Johannes Diderik van der Waals (1837-1923) incluse i liquidi omogenei tra ciò che poteva essere descritto in termini cinetici, modificando le leggi dei gas in modo tale da includervi termini coinvolgenti la dimensione finita delle molecole e le forze intermolecolari agenti nei sistemi condensati. All'incirca nello stesso periodo, due norvegesi, Cato Maximilian Guldberg (1836-1902) e Peter Waage (1833-1900), utilizzarono la rappresentazione cinetica di Clausius per sviluppare la loro legge dell'azione di massa, un'espressione quantitativa per l'equilibrio tra i prodotti e i reagenti nelle reazioni chimiche. Inoltre, il chimico fisico olandese Jacobus Henricus van 't Hoff (1852-1911) divenne famoso per le sue applicazioni della termodinamica ai sistemi chimici: durante la metà degli anni Ottanta del XIX sec. egli combinò liberamente le argomentazioni cinetiche con i metodi termodinamici per individuare comportamenti analoghi tra i gas e le soluzioni diluite.

Il vantaggio di utilizzare entrambe le forme di ragionamento, cinetica e termodinamica, ci ricorda che la teoria cinetica fu sviluppata parallelamente alla termodinamica, la quale trattava il calore facendo riferimento a principî non fondati su particolari concetti riguardanti la natura della materia. La relazione tra queste due discipline fu infatti così stretta che possono a ben ragione definirsi sorelle; entrambe si svilupparono attorno al concetto di energia che prese forma negli anni Quaranta e Cinquanta dell'Ottocento. Scienziati come Clausius e Maxwell, che diedero contributi decisivi in uno di questi due campi, furono spesso all'avanguardia anche nell'altro e i risultati raggiunti attraverso uno di tali percorsi convergevano generalmente con quelli ottenibili mediante l'altro. Le leggi dei gas, per esempio, possono essere derivate formulando ipotesi sul moto molecolare o attraverso la legge di conservazione dell'energia. Alcuni scienziati, compreso Clausius, credevano che le leggi della termodinamica si fondassero su una base cinetico-molecolare; altri, come Maxwell, erano più accorti e preferivano separare la termodinamica da ipotesi avanzate su entità non osservabili. Si trattava comunque di una scelta essenzialmente di gusto e la maggior parte degli scienziati si aspettava che prima o poi la teoria cinetica e la termodinamica si sarebbero unificate in un'unica concezione meccanicistica della Natura.

L'utile relazione tra queste due discipline sorelle diventò comunque difficoltosa negli anni Settanta e Ottanta, in parte a causa delle persistenti difficoltà incontrate nel conciliare la teoria cinetica con l'evidenza sperimentale e in parte perché gli sforzi effettuati per ampliare l'ambito della teoria cinetica manifestarono un'imprevista rottura nei confronti della termodinamica. Il primo problema derivò dalle continue discrepanze esistenti tra i valori dei calori specifici dei gas poliatomici previsti in base alla teoria cinetica e quelli ottenuti per via sperimentale. Clausius e Maxwell avevano dimostrato che l'energia cinetica doveva dividersi in parti uguali tra i gradi di libertà delle molecole, cioè tra i loro movimenti traslatorio, vibratorio e rotatorio, e avevano utilizzato questo teorema per ricavare previsioni riguardanti i rapporti dei calori specifici dei gas a pressione e volume costanti.

Mentre nel caso dei gas monoatomici (per es., i vapori di mercurio) le previsioni si accordavano con i valori ottenuti sperimentalmente, nel caso dei gas biatomici esse fallivano costantemente, facendo presupporre l'esistenza di un numero inferiore di gradi di libertà rispetto a quanto ci si potesse aspettare. Ancora più fastidioso era il fatto che i dati spettroscopici che gli scienziati avevano cominciato ad accumulare sistematicamente negli anni Sessanta rivelavano l'esistenza di migliaia di righe negli spettri dei gas più semplici; queste righe indicavano che gli atomi e le molecole possedevano molti più gradi di libertà del piccolo numero che era previsto dalla teoria cinetica. Sebbene questi risultati contrastanti potessero essere giustificati adottando opportune ipotesi sui moti molecolari e attribuendo la causa della forma degli spettri alla struttura interna degli atomi e delle molecole, tali aggiustamenti sembravano apportati ad hoc.

Un secondo tipo di problema si presentò negli anni Settanta, quando Boltzmann cercò di includere la seconda legge della termodinamica nel quadro della teoria cinetico-molecolare. L'interpretazione cinetica della prima legge della termodinamica ‒ il principio di conservazione dell'energia ‒ era relativamente semplice poiché la conservazione dell'energia poteva facilmente essere messa in relazione con le corrispondenti leggi di conservazione della teoria cinetica. Al contrario, la seconda legge, espressa in diversi modi come il principio dell'aumento dell'entropia o della dissipazione del calore, non presentava un'evidente correlazione con la teoria cinetica. Clausius avanzò l'idea che l'entropia potesse essere identificata con la disgregazione di un sistema ‒ un concetto che Maxwell trovò più oscuro che utile.

Riflettendo sulle macchinazioni di un ipotetico demone capace di distinguere le molecole veloci da quelle lente, Maxwell, da parte sua, giunse alla conclusione che ogni interpretazione meccanica della seconda legge della termodinamica avrebbe dovuto fare affidamento su generalizzazioni statistiche relative al grande numero di molecole piuttosto che sull'analisi di particelle individuali e sulla loro interazione. Basandosi sul lavoro di Maxwell, nel 1872 Boltzmann formulò un'interpretazione di questo tipo derivando la seconda legge della termodinamica dalla distribuzione delle velocità tra le molecole di un gas. La sua trattazione focalizzò comunque l'attenzione su un problema che fino ad allora era stato poco considerato: le leggi della meccanica che, secondo Boltzmann, governavano i moti molecolari sono invarianti rispetto al segno della grandezza tempo. Tali leggi non impediscono al sistema di fare ciò che l'esperienza comune nel mondo macroscopico e la seconda legge della termodinamica indicano come impossibile, ossia ricomporre lo stato iniziale di un sistema invertendo i movimenti di tutte le parti che lo costituiscono. Se la seconda legge della termodinamica fosse stata valida in senso assoluto, come la maggior parte dei fisici pensava, allora ci doveva essere un difetto nella trattazione di Boltzmann; se invece essa poteva essere derivata da principî meccanici, allora non poteva essere considerata assoluta.

Boltzmann affrontò questo dilemma riformulando la seconda legge della termodinamica in termini probabilistici. La crescita dell'entropia era considerata una probabilità statistica, così grande nei sistemi con molte particelle da essere considerata quasi una certezza. Tuttavia questa soluzione, che venne pubblicata nel 1877, non raccolse il consenso generale fino a quando, nel primo decennio del XX sec., non divennero disponibili nuove prove che supportavano il fondamento cinetico-molecolare del suo ragionamento. Anche i problemi riguardanti la spiegazione dei calori specifici e della forma degli spettri si rivelarono più ardui da risolvere; non venne trovata una soluzione soddisfacente fino a quando, negli anni Venti del Novecento, non emerse una nuova conoscenza dell'atomo.

Malgrado i molti successi, la teoria cinetica e la visione atomico-molecolare della materia associata a essa entrarono in crisi negli anni Novanta dell'Ottocento. Persino i loro più vigorosi sostenitori, tra cui Boltzmann, si trovavano sulla difensiva, non tanto contro i sostenitori di una nuova esotica teoria basata sull'energia quanto contro gli scienziati più conservatori come Planck, che tendeva a una termodinamica assiomatica, purificata dalle ipotesi sugli atomi e sulle molecole, così da offrire un fondamento più sicuro per la teoria fisica.

È sintomatico dell'atteggiamento difensivo dei sostenitori della teoria cinetica che Boltzmann, in risposta agli attacchi a tale teoria, tentasse di dimostrarne la fondatezza, non tanto evidenziando tutti gli importanti risultati che egli e i suoi predecessori avevano raggiunto in questo campo, quanto esaltando il valore euristico della teoria molecolare e l'importanza degli atomi e delle molecole in altre discipline scientifiche, in particolare la chimica. Quest'ultima era una mossa insolita: generalmente i fisici non condividevano gli interessi dei chimici e inoltre numerose erano le loro osservazioni denigratorie riguardanti la chimica. Essa, quindi, sembrò estremamente strana anche perché l'atomismo chimico aveva mantenuto soltanto sporadici contatti con l'atomismo fisico sin dagli inizi del XIX secolo.

Effettivamente, come gli americani e gli inglesi, i chimici e i fisici erano un'unica comunità divisa da un linguaggio comune! Per i fisici l'atomo era l'ultima ipotetica unità di materia, una particella che poteva essere trattata come un punto materiale nelle equazioni del moto e nella meccanica, oppure, nell'ambito della tradizione dinamica di William Thomson (lord Kelvin, 1824-1907), un persistente vortice nell'etere; per molti chimici, invece, era la più piccola parte di un elemento e dunque per essi esistevano più tipi di atomi diversi. I movimenti degli atomi, così importanti nella cinetica, per i chimici assumevano un significato molto meno rilevante rispetto ai loro pesi; inoltre, mentre i fisici consideravano le molecole a seconda dei casi come sfere elastiche, centri di forze attrattive o repulsive, vortici atomici connessi tra loro o elementi indistinguibili di un insieme costituito da un grande numero di particelle, i chimici le vedevano come entità complesse caratterizzate da composizione, forma e proprietà specifiche che richiedevano una spiegazione.

Queste differenze riflettevano il cammino in gran parte indipendente che la chimica e la fisica avevano seguito durante il loro sviluppo nel XIX secolo.

A partire dalla metà del secolo, e anche precedentemente in Germania, i chimici e i fisici conducevano le ricerche nei propri istituti, ne pubblicavano i risultati nelle proprie riviste ed erano membri di proprie comunità scientifiche. Gli stretti rapporti tra la chimica e le sue applicazioni pratiche, specialmente l'arte di guarire, l'analisi e, nell'ultima parte del secolo, la sintesi, garantirono che la cultura chimica avrebbe sempre tenuto in una buona considerazione le proprietà di sostanze specifiche.

Come i naturalisti, i chimici erano impegnati a esplorare e catalogare le ricchezze di ciò che Paracelso aveva chiamato 'la farmacia di Dio'; e come i loro colleghi botanici e mineralogisti, affrontarono l'arduo compito di escogitare metodi per classificare le specie. Inoltre, essi dovevano capire come queste si trasformassero e interagissero tra loro. L'istruzione dei chimici aveva come obiettivo primario soprattutto l'identificazione e la classificazione delle sostanze, nonché l'individuazione di una tipologia delle loro reazioni, e la maggior parte delle teorie chimiche era diretta verso questo compito.

La teoria atomica chimica, concepita da John Dalton e sviluppata da Jöns Jacob Berzelius, ha fornito un potente mezzo per il raggiungimento di questo scopo. Dalla metà degli anni Settanta dell'Ottocento essa è stata massicciamente introdotta in tutte le branche della chimica e usata da un ingente numero di chimici, implicitamente o esplicitamente, nei loro studi ordinari. Dopo decenni di contese, i fautori dell'atomismo chimico avevano raccolto una più o meno coerente tavola dei pesi atomici con metodi non sempre precisi, che andavano dalle misurazioni delle densità di vapore degli elementi volatili, alla determinazione dei calori specifici, all'uso di argomentazioni analogiche basate sull'isomorfismo nei cristalli. Ognuno di questi metodi richiese l'assunzione di qualche ipotesi sullo stato atomico o molecolare delle sostanze: le pressioni delle densità di vapore dipendevano dalla validità dell'affermazione di Amedeo Avogadro che volumi uguali di gas contenevano un numero uguale di particelle; le misurazioni dei calori specifici producevano valori approssimati dei pesi atomici finché era valida la regola empirica di Petit e Dulong, cioè che il prodotto dei pesi atomici e dei calori specifici era approssimativamente costante per tutti i solidi; infine l'isomorfismo valeva soltanto se le dimensioni degli atomi erano in rapporto con la forma dei cristalli visibili. I sostenitori dell'atomismo, come Stanislao Cannizzaro (1826-1910), enfatizzarono l'importanza di avere a disposizione metodi indipendenti per effettuare riscontri sulle stime dei pesi atomici ottenute. Gli oppositori, alcuni dei quali persisterono anche dopo il 1870, evidenziarono l'instabilità di una struttura che comportava l'assunzione di un così grande numero di ipotesi legate tra loro.

Nonostante la teoria atomica non si fosse completamente affermata, le argomentazioni che su essa si basavano portarono a molti importanti progressi nella chimica durante la seconda metà del XIX secolo. I valori dei pesi atomici furono la base su cui Dmitrij Ivanovič Mendeleev (1834-1907) classificò la maggior parte degli elementi chimici nella sua tavola periodica. La lunghezza delle catene degli atomi di carbonio nelle molecole organiche mise in evidenza interessanti correlazioni con le caratteristiche di alcune proprietà fisiche e chimiche, come i punti di ebollizione. Le argomentazioni sulla disposizione degli atomi nelle molecole fornirono una base razionale per la spiegazione della valenza. Inoltre, le ipotesi sulla forma tridimensionale delle molecole divennero sempre più importanti nel chiarire proprietà quali il colore e la reattività chimica delle sostanze. In modo ugualmente importante, le scelte alternative all'uso dei pesi atomici, come l'uso di formule basate sugli equivalenti, non permisero di ottenere né una maggiore semplicità nella pratica né una maggiore chiarezza sulle ipotesi assunte. Mentre fu possibile formulare le regole della stechiometria in termini di pesi equivalenti, fu molto più difficile spiegare l'isomeria, un fenomeno che invece appariva subito chiaro facendo riferimento alla disposizione degli atomi nelle molecole.

L'interesse dei chimici nei confronti dei pesi atomici, della specificità dei composti e dei problemi di classificazione era antitetico a quello dei fisici nei confronti delle forze, del moto e dell'unificazione delle leggi fisiche mediante l'impiego di una matematica superiore. Tuttavia, né i chimici né i fisici avevano un atteggiamento univoco, e vi era una tradizione minoritaria tra i primi che cercava di infondere nella chimica concetti e metodi fisici. Questa tradizione, riconducibile a Claude-Louis Berthollet (1748-1822), si manifestò vigorosamente negli anni Ottanta dell'Ottocento soprattutto nei lavori di van 't Hoff e del suo giovane collega Arrhenius. Van 't Hoff, in una monografia sulla dinamica chimica e in una serie di scritti successivi, studiò il comportamento delle soluzioni acquose diluite utilizzando le stesse leggi che si applicavano ai gas ideali coinvolgenti la pressione, il volume e la temperatura. Al tempo stesso Arrhenius, studiando il problema della conduzione elettrica nelle soluzioni, sviluppò una teoria della dissociazione elettrolitica che si riprometteva di fare luce non soltanto sulle proprietà elettriche delle sostanze disciolte, ma anche sulle relazioni tra l'attività chimica e quella elettrica.

Entrambi fecero ricorso alla cinetica per sviluppare una rappresentazione fisica delle soluzioni chimiche. Per esempio, van 't Hoff interpretò la pressione osmotica come il risultato delle collisioni delle particelle del soluto con le pareti del recipiente contenitore. Arrhenius, dal canto suo, si riferì esplicitamente a Clausius quando, nel 1887, avanzò l'idea che le molecole degli elettroliti si dissociassero nella soluzione in costituenti carichi, attribuendo in questo modo un'identità fisica agli ipotetici 'ioni' che gli scienziati, a partire da Michael Faraday (1791-1867), avevano introdotto per spiegare il fenomeno dell'elettrolisi.

Le due teorie si completarono perfettamente l'una con l'altra quando l'applicazione delle leggi dei gas alle soluzioni chimiche richiese l'introduzione di un fattore di correzione per gli elettroliti che trovò una spiegazione razionale nell'ipotesi della dissociazione di Arrhenius. Entrambe le teorie erano anche un esempio della fruttuosa interazione esistente tra la tradizione cinetica e quella termodinamica. Sebbene la descrizione delle soluzioni diluite di van 't Hoff fosse pervasa da considerazioni che facevano riferimento alla teoria cinetica, egli attribuì a tale descrizione un contenuto matematico applicando le leggi della termodinamica, un'azione, questa, che gli permise di separare i risultati più importanti delle sue ricerche dalle ipotesi di carattere cinetico da cui ebbero origine.

Van 't Hoff e Arrhenius gettarono molti nuovi ponti tra la chimica e la fisica, ma la disciplina che si diffuse sulla loro scia, la chimica fisica, assorbì al suo interno le tensioni che si stavano manifestando nella fisica verso la fine del secolo. Esattamente come i fisici discutevano se le leggi dei gas dovessero essere inserite nei presupposti della teoria cinetico-molecolare oppure in una termodinamica fenomenologica, così i chimici fisici dibattevano se una visione cinetico-molecolare fosse essenziale per la loro nuova disciplina. Forme di ragionamento che erano state complementari nei lavori di van 't Hoff degli anni Ottanta finirono con il diventare soluzioni alternative per alcuni protagonisti del campo, soprattutto Ostwald, Pierre-Maurice-Marie Duhem (1861-1916) e Planck (che in gioventù aveva avuto stretti rapporti con la nuova chimica fisica), mentre altri, come Nernst e Arrhenius, sostenevano fermamente che la cinetica e la termodinamica fornissero metodi complementari e di sostegno reciproco per il pensiero chimico.

In questo contesto, l'atteggiamento di Boltzmann di evidenziare l'importanza degli atomi e delle molecole per la chimica del suo tempo fu sicuramente appropriato. Gli sforzi di Ostwald per liberare questa scienza delle ipotesi sugli atomi e sulle molecole furono dibattuti all'interno della cerchia di chimici fisici cui apparteneva e risultarono estranei al modo di pensare della maggior parte dei chimici. Tuttavia la questione non era affatto facile come l'osservazione di Boltzmann faceva pensare. I chimici erano lontani dall'aver raggiunto un accordo sulla questione se la cinetica ricoprisse qualche ruolo importante nella chimica, e i concetti sugli atomi e sulle molecole che la maggior parte di essi accettava ‒ l'atomismo incluso nella tavola periodica degli elementi e nella teoria di struttura della materia ‒ erano distanti da quelli di Boltzmann e dei fisici che la pensavano come lui. Anche se la chimica offriva ampi esempi dell'importanza della concezione corpuscolare della materia, essi erano troppo poco integrati con l'atomismo fisico per fornire un sostegno organico al programma cinetico-molecolare di Boltzmann. La molteplicità dei modi con cui i fisici e i chimici consideravano l'atomo era per qualche verso un bene, perché forniva agli specialisti libertà d'azione per forgiare teorie atomiche appropriate adattabili a qualcuno degli insiemi di dati raccolti. Allo stesso tempo, però, tale molteplicità metteva in evidenza un problema di base dell'atomismo di fine secolo. Malgrado molti tentativi e ingegnosità, la natura della particella costituente ultima della materia, se mai fosse esistita, era ancora sconosciuta.

Un nuovo corso

Le difficoltà nel concepire l'atomo furono risolte soprattutto in seguito all'impiego di nuovi strumenti per investigare fenomeni naturali a lungo trascurati (il moto browniano), completamente inaspettati (la radioattività) o previsti soltanto come possibilità teorica (l'elettrone). Il risultato non fu tanto una vittoria di uno dei gruppi che aveva partecipato ai dibattiti iniziati a Lubecca quanto una dimostrazione del potere degli esperimenti di modificare le strutture del pensiero e della teoria. All'inizio del XX sec., gli sperimentatori indirizzarono le scienze fisiche verso una nuova via e i programmi assunsero forme che né Ostwald né i suoi oppositori potevano immaginare.

Soltanto una delle nuove linee di ricerca, lo studio del moto browniano, fu diretta consapevolmente verso la risoluzione delle controversie degli anni Novanta dell'Ottocento. La figura chiave in questo senso fu un giovane chimico fisico parigino, Jean-Baptiste Perrin (1870-1942). Gli scienziati francesi, come quelli di altre nazioni, si divisero sulla questione della realtà dell'atomo e sull'utilità delle teorie molecolari. In Francia, tuttavia, a un livello non raggiunto nel resto d'Europa, l'istruzione di grado più elevato era particolarmente centralizzata e chi era in cima alla gerarchia accademica francese aveva spesso una reazione di rifiuto nei confronti delle teorie ipotetiche e dell'atomismo in particolare. Il loro energico scetticismo fece sì che la teoria cinetico-molecolare esercitasse un fascino ugualmente intenso sulla generazione più giovane, nella quale il personaggio di maggiore spicco era Perrin.

Nel 1905 egli si avvide della straordinaria occasione di utilizzare un nuovo strumento per affrontare la vecchia questione dell'esistenza degli atomi e delle molecole e la validità della teoria cinetica. Lo strumento era l'ultramicroscopio, da poco costruito da Richard Zsigmondy (1865-1929) e dai suoi colleghi nella fabbrica Zeiss, in Germania. Nell'ultramicroscopio le lenti, invece di essere collocate lungo l'asse d'illuminazione, cosicché l'oggetto da osservare si vedesse su un fondo luminoso, erano poste perpendicolarmente a esso, in modo che l'osservatore potesse scorgere su un campo scuro soltanto la luce diffusa dalle particelle sospese in un liquido chiaro, così come si possono vedere le particelle di polvere muoversi nell'aria osservando di lato in un ambiente scuro un fascio di radiazione luminosa. L'aggiunta di un micrometro nell'oculare dello strumento permise di seguire il movimento delle singole particelle per periodi di tempo lunghi; il collegamento a una macchina fotografica consentì di studiare il numero e la distribuzione di numerose particelle in sospensione.

L'ultramicroscopio si adattò perfettamente allo studio delle sospensioni colloidali e Perrin lo adoperò per studiare i moti vibratori spontanei di particelle, come i granelli di polline, sospese nei liquidi. Tali moti, detti 'browniani', in onore del botanico inglese Robert Brown (1773-1858) che per primo li studiò nel 1827, si pensava fossero la conseguenza delle collisioni con le molecole del liquido, che si muovevano in modo del tutto casuale; furono tuttavia trovate anche molte altre spiegazioni, di tipo meccanico, termico o elettrico. Utilizzando l'ultramicroscopio, Perrin e i suoi collaboratori portarono avanti una serie di ricerche accurate, che si protrassero fino alla vigilia della Grande guerra, allo scopo di analizzare in modo sistematico il comportamento delle particelle colloidali per confrontarlo con quello previsto dalla teoria cinetico-molecolare e, in particolare, da un ampliamento della teoria cinetica volta a studiare il comportamento delle particelle sospese in un mezzo viscoso elaborato da Albert Einstein (1879-1955) nel 1905. Il risultato fu decisivo: le particelle colloidali, di dimensioni all'incirca da quattro a quaranta volte quelle delle molecole, si comportavano esattamente nel modo previsto dalla teoria cinetico-molecolare. Esse erano sottoposte a spostamenti proporzionali alla radice quadrata del tempo trascorso; l'ampiezza dei loro movimenti variava con la temperatura ed era indipendente dalla pressione; infine, le particelle si disponevano in un campo gravitazionale secondo la distribuzione di Laplace delle particelle nell'aria e fornivano un valore del numero di Avogadro coerente con altre stime indipendenti. Anche Ostwald riconobbe la persuasività di questa evidente dimostrazione della validità della teoria cinetico-molecolare.

Mentre Perrin produceva questi risultati, i vecchi dibattiti sulla teoria cinetica erano stati quasi eclissati dagli sbalorditivi nuovi dati e idee sulla radioattività e sull'elettrone, agli inizi del XX secolo. Entrambe queste linee di ricerca aumentarono la fiducia nei confronti della natura corpuscolare della materia, poiché indebolirono la validità dei concetti sulla stabilità degli elementi e sulla semplicità degli atomi che li componevano. Lo studio della radioattività fornì gli scienziati di mezzi per investigare l'interno degli atomi e per formulare ipotesi sulla loro struttura; lo studio dell'elettrone si rivelò importante per l'analisi delle interazioni dell'atomo con il suo ambiente, in particolare quelle con gli altri atomi e con la radiazione elettromagnetica. Insieme fissarono le basi nell'avviare la costruzione dei modelli che sarebbero diventati così caratteristici nelle scienze fisiche del XX secolo.

La scoperta, assolutamente inattesa, dei raggi X realizzata da Wilhelm Conrad Röntgen (1845-1923) nel 1895 e quella, ugualmente sorprendente, che i sali di uranio emettono una radiazione penetrante, compiuta da Henri Becquerel (1852-1908) all'inizio del 1896, suscitarono un largo interesse sia tra i fisici sia tra i chimici, non soltanto perché produssero nuovi effetti, ma anche perché sollevarono questioni attinenti a quasi tutti gli aspetti della scienza fisica. Tali radiazioni consistevano di particelle o erano nuove forme della radiazione elettromagnetica? Qual era la sorgente di queste radiazioni? Esse potevano integrarsi nella struttura esistente della spiegazione fisica? Se così era, come si sarebbe dovuta adattare questa struttura per accogliere i nuovi fenomeni? Se invece così non era, lungo quale direzione sarebbe dovuta emergere una nuova e più soddisfacente struttura?

Alla fine i raggi X si rivelarono meno bizzarri di quanto inizialmente si pensasse. Dopo alcuni anni di dispute, essi trovarono una definitiva sistemazione nello spettro elettromagnetico, che era ormai stato ampliato fino a comprendere la radiazione ultravioletta e le onde radio.

La radioattività si dimostrò poco maneggevole. Il suo studio produsse una sorpresa dopo l'altra e le spiegazioni teoriche fornirono un modesto aiuto nell'interpretazione dei risultati. L'uranio finì con il nascondere l'esistenza di impurezze che si dimostrarono emettitori di radiazione ancora più potenti: il radio, il torio e nuovi elementi come il polonio. L'energia liberata da minuscole quantità di queste sostanze rese quasi increduli gli scienziati: il radio, l'elemento dal comportamento più sorprendente, rilasciava un'energia all'incirca quattro milioni di volte maggiore rispetto a quella rilasciata nelle reazioni chimiche ordinarie da una stessa quantità di materia. Questi elementi erano capaci di generare tali energie dall'interno? E in quale modo ciò si realizzava? Inoltre, perché alcuni elementi erano in grado di farlo mentre altri no? La sorgente era forse esterna e i radioelementi erano trasmettitori o ricevitori di una energia presente nell'etere, così come i cristalli nei radioricevitori? I bizzarri effetti che si presentavano studiando in funzione del tempo campioni di radio e di torio erano un vero e proprio mistero. Essi non producevano soltanto enormi quantità di radiazione, ma anche tracce di nuove sostanze, come un'emanazione gassosa che successivamente sarebbe stata chiamata 'radon'. Queste sostanze, difficili da isolare ed evanescenti, erano immediatamente rimosse come impurezze, e talvolta in effetti lo erano.

La radiazione emessa dai radioelementi si rivelò tutt'altro che semplice da esaminare. L'analisi evidenziò tre tipi distinti di emissione, che differivano per il potere di penetrazione e per le proprietà elettriche: una forma alfa che era arrestata da una sottile foglia di alluminio e, dopo un po', mostrava un comportamento simile a quello di uno ione positivo all'interno di un campo elettromagnetico; una forma beta che passava attraverso sottili lamine di alluminio e trasportava una carica negativa; infine, una forma gamma che attraversava mezzo centimetro di piombo e non era deflessa dalla presenza di un campo magnetico. Il raggio gamma fu rapidamente identificato come una forma di radiazione elettromagnetica simile ai raggi X, mentre la radiazione beta mostrava proprietà identiche a quelle dei corpuscoli di carica negativa, o 'elettroni', che Thomson aveva identificato nei tubi a raggi catodici. Le particelle alfa si rivelarono invece molto più difficili da qualificare, così come il processo con il quale esse e le altre radiazioni venivano prodotte. Erano una forma di radiazione primaria e le altre erano prodotte per conseguenza oppure erano tutte emesse in seguito a un unico evento?

Questi misteri suscitarono interesse e curiosità, così come gli scienziati che se ne occuparono: Marie Curie (1867-1934), che mostrò una determinazione, un intuito e una chiarezza allora inaspettate per una donna, e suo marito, Pierre (1859-1906); e l'esuberante neozelandese Ernest Rutherford (1871-1937), che combinò le sue straordinarie doti di sperimentatore con un indubbio istinto per le grandi opportunità. Mentre i coniugi Curie si impegnarono soprattutto per isolare i radioelementi e le radiazioni da essi emesse (coniando tra l'altro il termine 'radioattività'), Rutherford, lavorando alla McGill University insieme a un suo collega, il chimico Frederick Soddy (1877-1956), mise insieme uno schema generale che unificava le evidenze sperimentali provenienti dal proprio laboratorio con quelle dei laboratori di altri ricercatori, a Parigi e altrove.

La teoria risultante concepiva la radioattività come derivante da un processo di disintegrazione atomica. Prima abbozzata nel 1902, poi sviluppata nel corso di pochi anni successivi, la nuova teoria considerava gli atomi elementi radioattivi intrinsecamente instabili e soggetti a un rischio statistico di decomposizione spontanea. Gli atomi in disintegrazione potevano produrre particelle alfa (poi identificate come ioni d'elio), particelle beta (elettroni) e raggi gamma penetranti, nonché nuovi elementi più leggeri. Il processo era un fenomeno atomico. Il tasso di disintegrazione poteva essere descritto da un'equazione caratteristica delle reazioni chimiche monomolecolari e, a differenza di tutte le reazioni note tra gli atomi, quelle che producevano la radioattività erano indipendenti dalla temperatura e dalla pressione. Ogni radioelemento, allo stato puro o in un composto chimico, perdeva la sua iniziale attività a un tasso costante che variava da specie a specie. La specificità e la costanza di questo decremento dell'attività fornì i mezzi con i quali individuare i prodotti della disintegrazione: il periodo di dimezzamento, o tempo necessario per una sostanza per perdere metà della sua radioattività iniziale, variava ampiamente da una specie all'altra. Le specie radioattive, ognuna con il suo caratteristico tempo di dimezzamento, potevano essere ordinate in serie, a cominciare dalle sostanze più pesanti, come il torio, e proseguendo verso il basso, attraverso ripetute disintegrazioni di atomi progenitori e discendenti, lunghe catene che terminavano con il piombo non radioattivo.

Un'esposizione semplificata di questa teoria nasconde le complesse argomentazioni e gli ingegnosi esperimenti che diedero vita alla sua articolazione e al suo sviluppo, oltre alla tipica fortuna di cui godette Rutherford. Tuttavia in questa sede è importante porre l'accento semplicemente sul fatto che le caratteristiche principali dello schema teorico si rivelarono durature, in grado di accogliere le nuove evidenze sperimentali, e persuasive nei confronti di gran parte degli scienziati. Forse l'aspetto più rimarchevole di questa storia è infatti che sia i chimici sia i fisici sostennero con tranquillità le loro idee sulla disintegrazione atomica e sulla trasformazione degli elementi. La teoria della disintegrazione considerava gli atomi come oggetti utili e reali, ma soltanto per trasformarli in qualcosa di complesso e transitorio. Parte del motivo di questa calma è dovuta all'esistenza di un'altra linea di ricerca, che procedette fianco a fianco con il lavoro sulla radioattività e lo incrociò in modo da sostenersi reciprocamente, vale a dire la ricerca sull'elettrone.

Il concetto di un'unità elementare di carica elettrica aveva molti precedenti. Faraday aveva mostrato che nell'elettrolisi la stessa quantità di elettricità liberava sempre il medesimo peso equivalente di sostanze e ipotizzò che ciò suggeriva l'esistenza di qualche 'atomo' fondamentale di elettricità. Studi successivi confermarono che le cariche associate agli elettroni in soluzione erano sempre multiple di una quantità singola; ciò portò anche il cauto Hermann von Helmholtz (1821-1894) ad approvare nel 1881 la conclusione di Faraday. Un decennio dopo, il fisico anglo-irlandese George J. Stoney (1826-1911) coniò il termine 'elettrone' per descrivere questa ipotetica entità. In tale visione, essa rappresentava l'unità di elettricità che attraversava una soluzione quando un legame chimico era rotto e l'entità i cui movimenti periodici davano origine agli spettri di righe. Il concetto di 'atomo di elettricità' era comune. Tuttavia, la maggior parte delle prove sperimentali per associare cariche discrete a corpi discreti derivava dallo studio delle soluzioni, dove l'elettricità era associata a materia di dimensioni atomiche o molecolari; non esisteva una corrispondente evidenza di discontinuità nel modo con cui i metalli conducevano l'elettricità. Il concetto di un 'atomo di elettricità' sembrava anche essere in conflitto con l'idea largamente diffusa che l'elettricità fosse il risultato di vibrazioni nell'etere, uno schema che aveva troppo successo per essere scartato con leggerezza.

Una chiarificazione più convincente della particolare natura della carica elettrica emerse alla fine del XIX sec., grazie soprattutto a un autorevole e instancabile gruppo di ricerca associato a Joseph J. Thomson (1856-1940) e al Cavendish Laboratory of Physics di Cambridge nel quale egli operava. Thomson era un leader poco credibile di fisica sperimentale, il quale si era fatto conoscere nel mondo scientifico come abile fisico matematico che seguiva la tradizione di Maxwell. Il suo acume nel riconoscere studenti capaci era leggendario quanto la sua goffaggine e ben note erano altre sue qualità non meno importanti: genialità nel progettare gli esperimenti e gli apparati necessari per svolgerli; notevole inventiva (qualche volta temeraria) nell'organizzare i dati in teorie di ampia portata; capacità di stimolare gli altri con la sua forte immaginazione e il suo vigoroso modo d'esprimersi.

Nel corso degli anni Novanta, Thomson centrò il suo programma di ricerca a Cambridge sullo studio delle scariche elettriche e concentrò prevalentemente gli sforzi dei suoi allievi sull'investigazione dei fenomeni riguardanti i tubi a raggi catodici, nei quali tali scariche erano più facili da studiare.

Le correnti che passavano attraverso i gas rarefatti contenuti in tali tubi producevano singolari effetti visivi e gli esperimenti attiravano l'attenzione di un pubblico che ancora oggi continua a essere attratto da essi. Thomson e i suoi allievi, tuttavia, erano interessati soprattutto a studiare i raggi catodici in sé e il loro rapporto con il fenomeno della conduzione elettrica nei gas, un argomento assai meno sviluppato rispetto allo studio della conduzione nelle soluzioni chimiche.

La natura dei raggi catodici era controversa. Molti studiosi, specialmente in Germania, li consideravano una forma di radiazione elettromagnetica, poiché riuscivano ad attraversare strati di dimensioni atomiche che non lasciavano passare particelle di materia. Tuttavia i raggi catodici mostravano anche proprietà tipiche delle particelle: per esempio, gli oggetti opachi nel fascio facevano ombra e i campi magnetici deviavano i raggi di questo. Thomson risolse questa difficoltà mettendo in pratica una serie di ingegnosi esperimenti guidati dal fermo proposito di comprendere la natura della scarica elettrica. Questi esperimenti confermarono che i raggi catodici trasportavano una carica negativa, che potevano essere deviati da un campo elettrostatico e anche da uno magnetico e infine che viaggiavano con una velocità che era circa un quarto di quella della luce. Unite insieme, queste evidenze sperimentali formarono un'argomentazione convincente del fatto che i raggi catodici fossero composti di corpuscoli di carica negativa. Fatto estremamente importante, Thomson sviluppò metodi per stimare il rapporto tra la carica e la massa di questi corpuscoli, misurando la loro curvatura nei campi magnetici ed elettrostatici. Gli esperimenti produssero stime dei rapporti che erano molto coerenti indipendentemente dalla natura del gas nel tubo di scarica o del metallo negli elettrodi e sempre circa un migliaio di volte più grandi dei corrispondenti rapporti per gli ioni di idrogeno nell'elettrolisi (un numero che fu presto provato essere troppo grande di quasi un fattore due). Assumendo che gli ioni nella soluzione e i corpuscoli nei raggi catodici trasportavano la stessa unità di carica elettrica, Thomson concluse che i suoi corpuscoli possedevano una massa un migliaio di volte più piccola rispetto a quella dell'atomo di idrogeno e che pertanto potevano essere gli 'atomi primitivi' o i corpuscoli elementari di cui erano costituiti gli 'atomi chimici ordinari'.

Altri scienziati erano molto più prudenti nelle conclusioni, tuttavia dopo pochi anni dall'annuncio nel 1897 di questi risultati fu pubblicata una quantità notevole di dati che confermò l'onnipresenza degli elettroni (come qualcuno, ma non Thomson, la chiamò) e il loro doppio ruolo di unità di carica e di componenti degli atomi. Nei Paesi Bassi, il fisico Hendrik Antoon Lorentz (1853-1928) calcolò il valore del rapporto tra la carica e la massa di un 'elettrone' che sembrava necessario per spiegare la separazione delle righe spettrali in un campo magnetico, fenomeno che era stato scoperto nel 1896 dal suo collega Pieter Zeeman (1865-1943). Pochi anni dopo, in Germania, Walter Kaufmann (1871-1947) utilizzò i metodi di Thomson per mostrare che i raggi beta emessi dal radio e da altre sostanze radioattive erano particelle di carica negativa con un valore del rapporto carica/massa identico a quello dei corpuscoli di Thomson. Nel frattempo, un allievo di Thomson progettò un ingegnoso metodo per determinare il valore assoluto della carica elettronica misurando il tempo di caduta delle goccioline d'acqua che si condensavano attorno agli ioni in un gas sottoposto a espansione adiabatica. Questo metodo, applicato a goccioline d'olio, sarebbe stato portato quasi alla perfezione nel 1913 dall'americano Robert A. Millikan (1868-1953) con i suoi famosi esperimenti. Sebbene fosse stato necessario più tempo per il posarsi della polvere che lo circondava piuttosto che per la caduta delle gocce d'acqua e d'olio, l'elettrone ebbe un posto sicuro nella fisica a partire dalla vigilia della Prima guerra mondiale.

L'atomo dentro e fuori

All'inizio del XX sec. lo studio della radioattività e dell'elettrone aprì molte vie agli scienziati tra le quali due, in particolare, ne furono la diretta conseguenza. Una condusse alla fisica atomica, una disciplina che difficilmente si poteva affermare fosse esistita nel 1900 o anche nel 1910, ma che fiorì nei decenni successivi. Le parti che diedero luogo alle controversie degli anni Novanta dell'Ottocento avevano qualche volta utilizzato il termine 'atomistica' per descrivere quei settori della scienza che facevano uso degli atomi e delle ipotesi che li coinvolgevano. Qualcosa che in precedenza apparteneva al campo dell''ipotetico' ora era stato rimosso e la nuova scienza, dopo aver inizialmente arruolato molti chimici e fisici, stava decisamente cominciando a essere incorporata nella fisica. In gran parte ciò era dovuto all'instancabile vitalità del gruppo di ricerca di Rutherford. Anche durante il trasferimento di Rutherford da McGill a Manchester (1908) e successivemente a Cambridge (1919), egli e i suoi allievi continuarono a elaborare nuovi dati, tecniche e idee, delle quali non trascurabile è quella di un atomo nucleare che avrebbe ispirato uno dei giovani ricercatori di Rutherford, il danese Niels Bohr (1885-1962).

La seconda via portò a un nuovo tipo di chimica strutturale, riguardante la caratterizzazione delle molecole non soltanto per mezzo del loro comportamento chimico e delle proprietà fisiche di massima, come avveniva tradizionalmente, ma anche prendendo in considerazione i legami che tenevano unite le loro parti. Thomson stesso indirizzò la linea di ricerca in questo settore, trattando compiutamente le implicazioni chimiche degli elettroni in due autorevoli libri: Electricity and matter (1904) e The corpuscular theory of matter (1907). La sua opera di proselitismo per una 'teoria corpuscolare della materia' suscitò notevole interesse tra i chimici e i fisici e stimolò un'ondata di speculazioni sui legami chimici che culminò direttamente nella formulazione del punto di vista della 'coppia di elettroni condivisi' del chimico americano Gilbert N. Lewis (1875-1946).

Le due linee di sviluppo ebbero un punto di partenza comune nel lavoro di Thomson sull'elettrone e sul suo ruolo nell'atomo. Dal momento in cui egli per primo gli diede realtà, l'elettrone rappresentò il crocevia verso il quale conversero molte tradizioni di ricerca. Fu l'unità fondamentale di carica che le teorie elettriche avevano da tempo previsto; la sua emissione durante il decadimento radioattivo implicava che fosse presente nella struttura atomica; le sue ipotetiche vibrazioni fornivano i gradi di libertà necessari per produrre i complessi spettri atomici osservati; infine, la sua manifestazione associata agli ioni suggeriva lo svolgimento di un suo ruolo nella chimica.

Teorico ostinato che si preoccupava più del potere euristico dei suoi modelli piuttosto che della loro coerenza o precisione, Thomson aveva largamente diffuso la teoria corpuscolare della materia al di fuori dei confini del suo lavoro sperimentale sui tubi a raggi catodici e sugli elettroni. Il suo schema teorico venne sottoposto a costanti verifiche, ma ebbe un impatto maggiore quando fu formulato nei due libri precedentemente citati, nei quali egli descrisse l'atomo come una sfera di carica positiva all'interno della quale gli elettroni si muovevano su orbite circolari intorno al centro. Gli elettroni, in numero proporzionale al peso atomico dell'elemento chimico preso in considerazione, si sistemavano in anelli o gusci in grado di contenerne un massimo di otto (spiegando in questo modo il significato delle otto righe nella tavola periodica). Gli atomi dei gas nobili inerti non potevano né ricevere né cedere un elettrone senza a loro volta perdere stabilità e per questo erano inerti. Gli altri atomi formavano legami trasferendo elettroni; il numero di elettroni persi o guadagnati corrispondeva alla valenza dell'atomo. Nella molecola, il trasferimento di elettroni produceva atomi con cariche elettriche opposte e in tal modo creava un tubo di forza tra essi che formava un legame chimico. Questi legami, secondo Thomson, avevano una direzione, poiché iniziavano sempre nell'atomo con carica positiva e finivano in quelli con carica negativa.

I chimici reagirono alla teoria di Thomson con un entusiasmo di gran lunga superiore a quello mostrato nel XIX sec. nei confronti dell'atomistica fisica. Nonostante lasciasse irrisolta la maggior parte dei problemi chimici, l'opera di Thomson fu tuttavia molto significativa dal punto di vista chimico. La concezione dell'elettrone in essa contenuta, infatti, aprì nuove strade per affrontare vecchi problemi come la valenza e i fondamenti della tavola periodica degli elementi. Tra i molti chimici che tentarono di migliorare la teoria di Thomson un ruolo rilevante lo ebbe Lewis un chimico fisico per formazione e un iconoclasta per temperamento, che giudicò la teoria polare del legame di Thomson (e la maggior parte delle modifiche a essa apportate) non plausibile chimicamente. Egli si domandava in che modo gli elettroni potessero conoscere il loro punto d'origine, come la nozione di legami direzionali sembrava ipotizzare. Inoltre, si interrogava dove fosse la prova sperimentale che nelle semplici molecole biatomiche, come quelle dell'idrogeno, gli atomi avessero cariche diverse, e come potesse una tale teoria elettrica delle combinazioni conciliarsi con tutti i fatti che avevano invalidato le precedenti teorie elettrochimiche, a partire da quelle di Berzelius. Mentre molte molecole inorganiche mostravano le qualità polari richieste dal modello di Thomson, i composti del carbonio generalmente non le presentavano. La semplicità, che era il pregio della teoria di Thomson, era anche il suo difetto; la teoria era troppo debole per poter spiegare la varietà delle combinazioni chimiche.

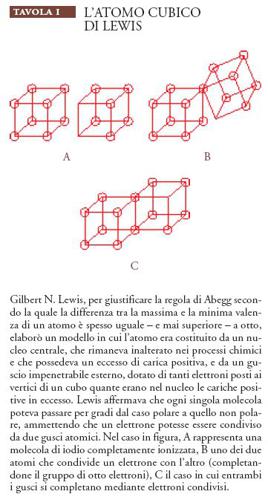

Al suo posto nel 1916 Lewis propose un modello che definiva il legame chimico come una ridistribuzione piuttosto che un trasferimento di elettroni. Egli concepì l'idea in un modo insolito immaginando gli atomi (eccetto quello dell'idrogeno) come cubi nei cui otto vertici potevano trovare posto gli elettroni (Tav. I).

Quando tutti i posti erano occupati, l'atomo acquisiva la stabilità esemplificata dai gas nobili; quando uno o più posti mancavano di un elettrone, l'atomo diventava reattivo e capace di condividere gli elettroni con gli atomi adiacenti che avevano anch'essi i posti esterni non occupati. Così, per esempio, i due atomi di cloro, ognuno con un guscio esterno di sette elettroni, potevano completare ottetti condividendo i loro elettroni spaiati. La coppia condivisa conferiva stabilità a ognuno degli atomi partner e costituiva il legame della molecola biatomica. Nei casi come questo, dove gli atomi che formavano un legame esercitavano un'uguale affinità per gli elettroni distribuiti, la molecola risultante era non polare, relativamente non reattiva e un cattivo conduttore di elettricità nelle soluzioni. Al contrario, quando gli atomi partner esercitavano differenti affinità per gli elettroni condivisi, per esempio in un sale come il cloruro di sodio, la molecola risultante era polare, reattiva e facilmente ionizzata.

Il modello di Lewis era fisicamente inammissibile, poiché considerava gli elettroni essenzialmente statici e mancava di un fondamento convincente sia nell'ambito dell'elettrodinamica sia in quello della meccanica. Non forniva neanche valori quantitativi per qualche variabile chiave come l'energia degli elettroni o le lunghezze di legame. Tuttavia, metteva in relazione la maggior parte di ciò che i chimici conoscevano sulla valenza e sul legame e in una forma che si prestava facilmente a una rappresentazione sia visiva sia tipografica. Il puntino dell'elettrone divenne alla fine il metodo quasi universale di rappresentazione degli atomi e delle molecole nei testi di chimica e le strutture di Lewis avrebbero continuato a essere utilizzate a lungo dai chimici, anche dopo che il suo atomo cubico era stato dimenticato; questo fatto ci ricorda che una teoria non necessita di essere esatta per essere utile.

Lewis, non ritenendolo necessario, aveva fornito poche spiegazioni su ciò che esisteva all'interno dell'atomo cubico. Seguendo Thomson, egli e la maggior parte degli scienziati che consideravano la questione ritenevano che gli elettroni occupassero anelli o gusci concentrici. In condizioni normali, soltanto i più esterni di essi avevano una interazione significativa con quelli vicini. I chimici si erano occupati di come gli atomi interagivano tra loro, ma i fisici cercavano qualcosa di più. I fenomeni di decadimento radioattivo fornirono a quel punto la pista più interessante e il mezzo più potente da seguire. Non appena si accumularono le prove sperimentali a favore della teoria di disintegrazione di Rutherford e di Soddy, le particelle alfa divennero un argomento di studio particolarmente interessante. Esse erano molto più massicce delle piccole particelle beta, trasportavano una carica positiva e sembravano essere i frammenti degli atomi in disintegrazione. Inoltre potevano essere ottenute da sorgenti naturali quali il radio e il polonio, che espellevano particelle alfa con un'energia che le trasformava in potenti proiettili.

Giunto a Manchester, Rutherford focalizzò la maggior parte dei suoi sforzi su queste particelle e sulla verifica di una conclusione cui era giunto dal 1903, cioè che le particelle alfa fossero atomi di elio che trasportavano una doppia carica positiva. Il suo gruppo di ricerca raggiunse velocemente questo scopo, in parte facendo un buon uso delle tecniche sperimentate per la prima volta nel laboratorio di Thomson per determinare il rapporto tra la carica e la massa degli elettroni, e in parte sviluppando nuovi metodi per il conteggio delle particelle alfa e per la misurazione delle loro proprietà fisiche. Un filone di questo lavoro fu un esperimento assegnato a un giovane studente universitario inglese, Ernest Marsden, che aveva il compito di esaminare come le traiettorie delle particelle alfa fossero deflesse quando passavano attraverso una sottile lamina d'oro. L'esperimento produsse un risultato sorprendente: mentre molte particelle passavano con una piccola deviazione, qualcuna era diffusa ad angoli maggiori di novanta gradi. L'analisi dei dati mostrò che tale deviazione era inconsistente con il modello di Thomson, nel quale la carica positiva era distribuita sull'intero volume dell'atomo. L'esperimento faceva pensare, al contrario, che la carica positiva dell'atomo fosse concentrata.

Ciò fu sufficiente a spingere Rutherford a proporre nel 1911 un modello 'nucleare' dell'atomo. In quello stesso anno Bohr, si unì al gruppo di Rutherford con la medesima motivazione. Bohr, conversatore e temporeggiatore, intellettuale con numerosi interessi e fisico stimolato dal lavoro teorico piuttosto che da quello sperimentale, per molti versi era l'antitesi di Rutherford il quale ammirava nel giovane ricercatore le ambizioni scientifiche e il profondo rispetto per le prove sperimentali, e ne condivideva il potere di sintetica immaginazione. Mentre si trovava a Manchester, Bohr concentrò gli sforzi verso un progetto che ben si adattava al suo talento e alle sue ambizioni: lo sviluppo di una teoria dell'atomo che avrebbe dovuto conferire unità e chiarezza alle idee diffuse e ai risultati che si erano accumulati nel corso dei precedenti quindici anni.

Pubblicata in tre parti nel 1913 sul "Philosophical magazine", la teoria di Bohr riunì le prove sperimentali di diversa autorevole provenienza. Basandosi sulla rappresentazione di Rutherford, egli descrisse l'atomo come un sistema dinamico nel quale gli elettroni si muovevano lungo anelli coassiali attorno a un nucleo carico positivamente. Come i pianeti che si muovono attorno al Sole, gli elettroni erano soggetti a una forza centripeta che variava in modo inversamente proporzionale con la loro distanza dal nucleo di massa maggiore. Rutherford e altri scienziati si erano in questo modo spinti un po' avanti, ma nessuno di essi aveva elaborato una spiegazione soddisfacente di come un tale sistema potesse restare stabile. A questo punto Bohr fece la sua mossa più audace: contrariamente ai dettami di Rutherford, e a quelli della meccanica classica, sostenne che gli elettroni potevano muoversi lungo le loro traiettorie senza irradiare energia, purché occupassero certe orbite stabili, o 'stazionarie'. Essi diventavano sorgenti di radiazione soltanto quando si spostavano da una all'altra di tali orbite e la radiazione emessa nell'effettuare un tale salto era discreta o quantizzata, in conformità con l'interpretazione di Bohr della teoria quantistica iniziata da Planck nel 1900 nella sua trattazione dell'energia radiante, che soltanto da poco aveva cominciato a ottenere un largo consenso tra i fisici teorici. Facendo uso sia dell'analisi classica dei moti orbitali sotto l'influenza della forza centripeta, sia dell'ipotesi quantistica su come l'energia è emessa o assorbita in pacchetti discreti, Bohr ricavò un'espressione generale per le frequenze della radiazione emessa dagli elettroni durante le loro transizioni ‒ un'espressione che forniva valori coerenti con le frequenze della luce misurabili nello spettro dell'idrogeno.

La fisica della teoria di Bohr era oscura, perché non vi era alcun fondamento che permettesse di accordare la fisica classica con quella quantistica. Il suo scopo era limitato a fornire risultati quantitativi soltanto per i sistemi più semplici ‒ quelli con un unico elettrone, come l'atomo di idrogeno e lo ione di elio. Inoltre, mentre la teoria era coerente con molti dei più importanti fenomeni chimici, essa assimilava in minima parte le caratteristiche di semplicità e finezza del modello chimico qualitativo di Lewis. Come Thomson, Bohr poteva spiegare la 'regola dell'ottetto' con la ridistribuzione degli elettroni nei gusci, ma l'efficacia di tale argomentazione riguardava l'atomo e non la molecola, con l'eccezione di quella dell'idrogeno. Anche con tale limitazione, il modello forniva valori per l'energia, la velocità e le orbite degli elettroni e congetture che ben si accordavano non soltanto con i dati spettroscopici, ma anche con stime indipendenti del raggio dell'atomo e del potenziale di ionizzazione. In conclusione, la teoria funzionava, sebbene in modo imperfetto.

Plus ça change, plus c'est la même chose! Uno scettico convinto avrebbe potuto fare un'affermazione di questo tipo rispetto allo stato precario della teoria atomica e molecolare nel 1920. I fisici erano divisi sul fatto che l'atomo di Bohr rappresentasse una strada promettente per lo sviluppo futuro oppure fosse l'analogo novecentesco dell'atomo vortice di lord Kelvin, vale a dire un'idea brillante ma profondamente fuorviante. I chimici portavano avanti le loro stravaganze atomiche e molecolari, che tanto poco ricordavano quelle dei fisici, così come i cubi statici di Lewis non somigliavano agli anelli dinamici di Bohr. E nessuno, compresi i teorici, attribuiva molta fiducia nella capacità delle loro teorie di far comprendere il mondo come era in realtà.

Tuttavia molte cose erano cambiate. Gli spavaldi modelli degli anni Dieci del XX sec. si contrapponevano nettamente allo stile incerto di quelli della metà degli anni Novanta del secolo precedente, quando era consuetudine che anche i sostenitori delle ipotesi atomiche apparissero poco convinti e ne facessero ironia. Mentre né Bohr né Lewis erano così ingenui da credere che i loro modelli fossero totalmente fedeli alla realtà della Natura, entrambi erano fiduciosi del fatto che gli oggetti da loro considerati per descrivere la Natura fossero più che finzioni euristiche. Le tradizioni sperimentali portate avanti da Perrin, Rutherford e Thomson avevano stabilito l'esistenza degli atomi, degli ioni e degli elettroni, e avevano loro associato con le parole un contenuto sufficiente per rendere questi corpi tanto reali agli scienziati quanto lo erano diventate le lune di Giove in una precedente generazione.

Una conseguenza di questa trasformazione sbalorditiva fu la rinnovata fiducia, persa nel XIX sec., che i grandi problemi quali 'il costituente fondamentale della materia' e 'la natura del legame chimico', potessero essere risolti ‒ se non con i mezzi dell'epoca almeno con quelli imminenti.

Un secondo risultato fu quello di portare la chimica a intrattenere un rapporto proficuo con la fisica. Questa conclusione può sembrare singolare, in considerazione dell'evidente divario tra l'atomo di Lewis e quello di Bohr, l'uno statico, qualitativo e mirante a spiegare le evidenze chimiche, l'altro dinamico, quantitativo e rivolto alla spiegazione degli spettri; eppure, molti dei principali argomenti di disaccordo tra Lewis e Bohr furono rapidamente chiariti. A partire dai primi anni Venti del XX sec. Lewis abbandonò i suoi cubi e Bohr abbracciò l'idea di legame formato da una coppia di elettroni condivisi. La loro convergenza fu il preludio a un dibattito più esteso e profondo sugli atomi e sui legami, che avrebbe impegnato i chimici e i fisici negli anni Venti, quando gli atomi di Lewis e di Bohr furono entrambi soppiantati dalla nuova trattazione quantomeccanica degli atomi e delle molecole che accrebbe la capacità dei modelli di spiegare le evidenze fisiche, come il calore specifico e gli spettri, e fornì al tempo stesso una base più soddisfacente per comprendere la valenza e il legame.