La grande scienza. L'astronomia multicanale

La grande scienza. L'astronomia multicanale

L'astronomia multicanale

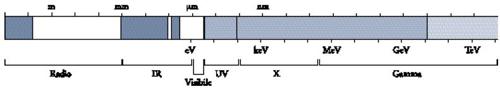

Per lungo tempo le osservazioni astronomiche sono state effettuate soltanto nella parte visibile, od 'ottica', dello spettro elettromagnetico, prima a occhio nudo e, a partire dalla fine del XIX sec., utilizzando sempre più le lastre fotografiche. L'assorbimento delle radiazioni da parte dell'ozono e di altre molecole presenti nell'atmosfera terrestre limitava l'intervallo di lunghezze d'onda osservabili a λ>300 nm (1 nm=10 Å); un altro limite derivava dalla bassa sensibilità dell'occhio e delle lastre fotografiche per λ>750 nm. La fig. 1 mostra quanto sia ristretta la banda visibile rispetto all'intero spettro della radiazione elettromagnetica. Per effettuare alcune osservazioni in infrarosso del Sole e di qualche stella luminosa venivano utilizzati anche i bolometri, strumenti che misurano l'energia totale della radiazione incidente, ma ben poche sono comunque le informazioni che se ne sono ricavate.

Nel 1931 Karl Jansky scoprì per caso un'emissione radio alla lunghezza d'onda di 15 m, ma non si ebbero più scoperte rilevanti fino al termine della Seconda guerra mondiale, quando la tecnologia radar venne impiegata anche per scopi civili. Dal 1950 in alcuni paesi si cominciarono a costruire i radiotelescopi e lo sviluppo della tecnologia dei ricevitori permise di estendere il campo delle osservazioni alle lunghezze d'onda dell'ordine dei centimetri e, successivamente, dei millimetri. La realizzazione di radiotelescopi sempre più grandi consentì una rapida crescita della loro sensibilità, come pure una migliore risoluzione angolare, ossia la capacità dello strumento di separare il segnale proveniente da due sorgenti celesti vicine. Lo sviluppo della radioastronomia svelò un Universo totalmente nuovo, nel quale, per importanza, il gas interstellare, gli elettroni di alta energia e i campi magnetici presero il posto delle stelle.

Attorno al 1950 furono costruiti razzi che permisero di trasportare la strumentazione al di sopra dell'atmosfera terrestre, rendendo possibile l'osservazione della radiazione X di origine celeste, prima quella proveniente dal Sole e, a partire dal 1962, quella in arrivo da sorgenti più distanti. In questo modo fu possibile investigare la natura di un gran numero di processi fisici energetici, anche grazie alla successiva messa in orbita di satelliti in grado di effettuare osservazioni nel campo dei raggi X e gamma. La parte dello spettro elettromagnetico più difficile da analizzare rimase l'infrarosso, perché in tale banda, a prescindere dal fatto che essa può essere osservata solo al di sopra dell'atmosfera, è necessario raffreddare gli strumenti in modo che la radiazione termica che essi emettono non disturbi le osservazioni. La prima esplorazione del cielo alla ricerca di sorgenti infrarosse fu effettuata nel 1984 nel corso di sei mesi dal satellite IRAS (Infrared astronomy satellite): in molte parti furono scoperti addensamenti di gas e polvere a bassa temperatura, nonché intere galassie, che emettono una gran quantità di energia.

In meno di quattro decenni, l'intervallo di lunghezze d'onda osservate è cresciuto da un fattore 2-3 caratteristico dello spettro visibile a un fattore 1020, esteso dalle onde radio più lunghe ai raggi gamma di energia più elevata. La seconda metà del Novecento ha rappresentato per l'astronomia un periodo di conquiste senza precedenti, straordinario e irripetibile. La situazione attuale può essere paragonata a ciò che è avvenuto nel campo geografico. Alcuni secoli fa si esplorò la maggior parte della superficie terrestre: allo stesso modo oggi l'intero spettro elettromagnetico è stato osservato ma, così come avviene per la geografia, si è ancora ben lontani dal disporre di una mappa astronomica completa.

Le onde elettromagnetiche non rappresentano comun-que l'unica fonte di informazioni sull'Universo. All'inizio del XX sec. furono scoperti i misteriosi raggi cosmici, costituiti principalmente da protoni di alta energia e da nuclei atomici pesanti, i quali, come oggi è noto, possono raggiungere un'energia di 1020 eV; le loro sorgenti sono però ancora poco conosciute, perché essi provengono all'incirca da tutte le direzioni, e trascorrerà del tempo prima che le ricerche sui raggi cosmici confluiscano in un settore importante dell'astronomia. Altri settori astronomici potenzialmente interessanti sono quelli riguardanti lo studio dei neutrini e delle onde gravitazionali. È possibile ottenere buoni risultati dalla collaborazione - diventata più stretta negli ultimi vent'anni - tra gli astronomi e i fisici delle particelle: l'impiego dei rivelatori di particelle utilizzati dai fisici potrebbe consentire, mediante gli acceleratori, la scoperta sulla Terra di nuove particelle non ancora individuate, ma che potrebbero essersi prodotte durante le fasi primordiali dell'Universo.

Da quanto esposto appare chiaro che diversi sono i canali attraverso cui si traggono le informazioni sull'Universo, e questo fa dell'astronomia contemporanea una disciplina a tutti gli effetti multicanale. Ancora non sappiamo quale sviluppo tecnologico il futuro riserverà a ognuno di questi canali ma è chiaro che, per migliorare la conoscenza dell'Universo, bisognerà integrare tra loro in modo coerente i dati provenienti da ognuno di essi. Nelle sezioni seguenti sarà data una breve descrizione della strumentazione utilizzata nelle diverse bande di osservazione.

I telescopi ottici

Il principio che sta alla base dello sviluppo del telescopio sembra essere stato delineato per la prima volta nel 1589 da Giambattista Della Porta (1538-1615) nella Magia naturalis. Nel 1608 Johannes Lippershey di Middleburg (m. 1619) vendette il primo telescopio, che l'anno successivo indusse Galilei a costruire il telescopio con il quale realizzò numerose spettacolari scoperte astronomiche. Con il passare del tempo, questi strumenti (rifrattori con due lenti) divennero sempre più grandi sino a che, alla fine del XIX sec., il diametro delle lenti raggiunse la dimensione di circa 1 m. Questo costituisce il limite oltre il quale le dimensioni delle lenti non possono andare, perché esse tendono a flettersi sotto l'azione del proprio peso; nei telescopi riflettori, invece, tale problema meccanico è superato in quanto gli specchi, che sostituiscono le lenti, sono sostenuti nel loro retro da adeguati supporti. Nella maggior parte dei riflettori attualmente utilizzati uno specchio secondario riflette la luce verso uno specchio primario; a seconda della configurazione ottica, la luce passa attraverso un foro ricavato nello specchio primario e raggiunge il fuoco situato poco oltre tale specchio (configurazione Cassegrain) oppure è riflessa sul lato del tubo da un terzo specchio (configurazione newtoniana), anch'esso, come gli altri, montato nel tubo del telescopio. Per compensare gli effetti della rotazione terrestre, questo tubo viene di solito montato su un asse diretto verso il polo celeste. Con lo sviluppo dei sistemi di controllo elettronici, è diventato possibile utilizzare la montatura altazimutale, nella quale il tubo ruota attorno a un asse orizzontale e la sua struttura di supporto ruota, a sua volta, attorno a un asse verticale. Dal punto di vista meccanico, questo tipo di montatura è attualmente il più semplice tra quelli utilizzati nella maggior parte dei telescopi di diametro superiore a 2-3 m.

Nella prima metà del XX sec. non sono stati costruiti telescopi di dimensione maggiore fino al completamento, nel 1949, di quello di 200 pollici (5 m ca.) di Monte Palomar, in California, seguito nel 1976 da quello di 6 m realizzato nel Caucaso, in Russia. Negli anni Settanta e Ottanta sono stati costruiti molti telescopi europei e statunitensi, tutti più piccoli di quello di Monte Palomar, generalmente di ca. 4 m di diametro. Ciò è motivato dal fatto che il costo di un telescopio è una funzione rapidamente crescente del diametro (d2,6), ma, al contrario, la capacità dello strumento di scoprire oggetti molto deboli non aumenta in modo notevole con tale dimensione. Inoltre, l'efficienza dei rivelatori ottici sta progressivamente migliorando, per cui un telescopio di 3-4 m di diametro che utilizza nuovi rivelatori ottici è in grado di raccogliere molta più luce di quanto potesse fare uno strumento di 5 m di alcuni anni fa.

L'efficienza di rivelazione di una lastra fotografica è dell'ordine dell'1%, per cui il 99% della luce incidente si perde. Lo sviluppo dei rivelatori a stato solido, in particolare dei rivelatori CCD (charge coupled device), ha modificato la situazione, portando in alcune lunghezze d'onda l'efficienza di rivelazione dei fotoni a oltre l'80%. Il guadagno di luce raccolta è pari a quello ottenibile mediante una crescita delle dimensioni di un telescopio di un fattore nove; ciò ha diminuito fortemente lo stimolo a costruirne di più grandi. Lo sviluppo dei rivelatori CCD a buon mercato è stato favorito dal loro impiego nella televisione e nelle telecamere; nel 1980 se ne utilizzavano ancora pochi nell'astronomia, mentre dieci anni dopo essi sono diventati i rivelatori più comuni per questo tipo di osservazioni.

Un rivelatore CCD è costituito essenzialmente da una piastrina di silicio con un reticolo di pixel. Quando è colpito dalla luce, ogni pixel produce elettroni; con opportuni procedimenti elettronici si può valutare l'intensità della luce su ogni pixel durante l'esposizione, nonché 'leggere' e trasferire in forma opportuna i segnali prodotti. Oltre all'elevata efficienza, i rivelatori CCD presentano un altro fondamentale vantaggio, la linearità: a differenza delle lastre fotografiche, che diventano meno sensibili quando l'intensità della luce è molto bassa, nei CCD il numero di elettroni prodotti varia per la maggior parte dei valori linearmente con l'intensità. Per evitare l'insorgere di alcuni effetti indesiderati, questi rivelatori operano frequentemente a temperature di circa −100 °C.

Per quanto riguarda la risoluzione angolare, o la dimensione della macchia su cui è concentrata la luce raccolta da un telescopio, in linea di principio essa è proporzionale al suo diametro, ma gli effetti della diffrazione ne limitano il valore a

[1] θ≈1,2 λ/d radianti≈250.000 λ/d secondi d'arco,

dove λ è la lunghezza d'onda e d il diametro dello specchio del telescopio. Un ulteriore limite è quello dovuto alla turbolenza dell'atmosfera terrestre, che rifrange la radiazione luminosa proveniente dalle stelle, impedendo di analizzare i dettagli dell'immagine e di osservare le stelle molto deboli. Per esempio, se si osserva una stella blu alla lunghezza d'onda di 0,4 μm con un telescopio di 5 m di diametro, la risoluzione angolare dovrebbe essere θ=0,02″, mentre le immagini che si ottengono hanno un diametro angolare molto maggiore di 1″.

L'atmosfera terrestre, la luce zodiacale e le altre sorgenti luminose più distanti provocano inoltre una luce diffusa di fondo nell'immagine della stella che si sta osservando: più piccola è l'immagine stellare, minore è la quantità di tale luce di fondo e la stella spicca più chiaramente. Dalla [1] si nota che tale problema si riduce aumentando il diametro del telescopio ma, se il diametro dell'immagine è determinato dall'atmosfera terrestre, tale vantaggio risulta vanificato; inoltre, un telescopio più grande raccoglie più luce stellare ma anche più luce di fondo. Per questi motivi, invece di aumentare le dimensioni dei telescopi, si cerca di installarli in località dove gli effetti di disturbo dell'atmosfera siano minori, come in alta montagna nelle zone subtropicali, preferibilmente vicino a un oceano freddo. Due sono i modi per evitare o ridurre i problemi causati dall'atmosfera terrestre: portare il telescopio nello spazio o compensare gli effetti della turbolenza mediante la cosiddetta 'ottica adattiva'.

La costruzione di telescopi di dimensioni maggiori comporta un problema di peso per lo specchio primario. Nei telescopi classici tale specchio è spesso e rigido, al fine di evitare le deformazioni che esso subirebbe quando lo strumento è puntato in direzioni diverse da quella della forza di gravità. Generalmente, lo spessore dello specchio è uguale a 1/6 del diametro, per cui il volume e, quindi, il peso sono proporzionali al cubo del diametro. Un peso maggiore rende necessaria una struttura più resistente per il tubo del telescopio, coinvolge cioè l'intera struttura dello strumento. Pertanto non deve sorprendere il fatto che il costo del telescopio varia all'incirca come d3 o, più precisamente, tenendo conto di altri fattori, come d2,6: se il diametro dello specchio raddoppia, il costo aumenta di sei volte.

Per ridurre il peso degli specchi primari dei grandi telescopi si utilizza la cosiddetta ottica attiva che, con l'ausilio di leve azionate da motori e regolate da diversi calcolatori, consente l'uso di specchi più sottili e flessibili. La forma della superficie dello specchio è determinata da un analizzatore d'immagine che controlla la luce della stella sotto osservazione: se la forma è diversa da quella necessaria per ottenere l'immagine migliore, l'analizzatore trasferisce l'informazione al calcolatore, che aziona il sistema di leve motorizzate nel modo opportuno. All'European southern observatory (ESO) sono stati costruiti quattro telescopi del diametro di 8,2 m nei quali lo spessore degli specchi primari è di soli 27 mm, cioè circa 50 volte minore di quello dei telescopi tradizionali. Una progettazione leggermente diversa prevede l'uso di specchi suddivisi in segmenti indipendenti e opportunamente allineati mediante il sistema di ottica attiva.

Mentre l'ottica attiva permette la costruzione di telescopi più grandi, l'ottica adattiva ne consente un migliore uso. A causa della turbolenza dell'atmosfera terrestre, le immagini stellari ottenute durante lunghe esposizioni risultano sfocate. Tale sfocamento consiste in una sovrapposizione di migliaia di immagini deformate: se infatti se ne prende una in un solo millisecondo si ottiene una figura molto complessa alla quale è associato l'effetto istantaneo della turbolenza ma che, dopo pochi millisecondi, sarà diversa. Supponendo che il sistema di ottica attiva sia così veloce da cambiare la forma dello specchio primario in un millisecondo, ogni millisecondo si potrà variare tale forma per compensare l'effetto disturbante dell'atmosfera e ottenere un'immagine perfetta. Questo è il principio teorico su cui si basa l'ottica adattiva: mentre l'ottica attiva agisce sulla superficie dello specchio cercando di renderla perfetta, l'ottica adattiva la deforma per eliminare gli effetti atmosferici. Nella pratica, naturalmente, la situazione è molto più complessa. Innanzitutto, perché anche uno specchio sottile di 8 m possiede un'inerzia che impedisce un movimento veloce; per ovviare a questo problema, si pone uno specchio supplementare molto più piccolo e sottile lungo il cammino della luce, in modo da poterne variare la forma più velocemente. Inoltre, è necessario che la stella che si sta osservando sia relativamente luminosa, affinché fornisca in tempo breve le informazioni sufficienti all'analizzatore d'immagine. Infine, nel campo ottico gli aggiustamenti fatti possono correggere i contorni dell'immagine al massimo fino a una distanza di qualche secondo d'arco, mentre nel vicino infrarosso - alla lunghezza d'onda di 2 μm - le condizioni sono più favorevoli, perché in questo campo gli effetti di turbolenza variano molto più lentamente ed è maggiore l'area su cui si ha un'efficace correzione. Attualmente, i sistemi di ottica adattiva funzionano tra 1 e 2 μm; a lunghezze d'onda più corte sono necessari ulteriori sviluppi tecnologici.

Una soluzione ancora più semplice per eliminare i problemi di disturbo delle immagini è quella di collocare il telescopio nello spazio, dove sia gli effetti di gravità sia quelli dovuti alla turbolenza atmosferica sono trascurabili. In questo caso, l'ostacolo principale è il costo. L'Hubble space telescope (HST), lanciato nel 1990, con uno specchio di soli 2,4 m, è costato in totale alcune migliaia di milioni di dollari, centinaia di volte di più di un telescopio simile situato sulla Terra. I risultati ottenuti hanno comunque compensato gli investimenti: grazie alla sua straordinaria risoluzione angolare, 0,05″ a 500 nm, l'HST ha permesso di scoprire stelle molto deboli e di ottenere splendide immagini. Dallo spazio è inoltre possibile effettuare osservazioni nell'ultravioletto; nell'intervallo di lunghezze d'onda 120÷300 nm sono stati ottenuti molti spettri e immagini. Recentemente è iniziata la costruzione di un nuovo telescopio spaziale, il James Webb space telescope (JWST), di 6 m di diametro, che dovrebbe essere ottimizzato per osservazioni nell'infrarosso e medio infrarosso, fino a 35 μm. Il suo lancio è previsto intorno al 2010.

Un modo per migliorare la risoluzione angolare di un telescopio è attraverso l'impiego dell'interferometria. Supponiamo di possedere un telescopio con uno specchio primario di diametro d. Anneriamone alcune piccole parti: raccoglieremo un po' meno luce, ma la risoluzione angolare risulterà appena modificata. Continuiamo il processo finché la maggior parte della superficie dello specchio non sarà nera, lasciando comunque una distribuzione uniforme di parti riflettenti in modo tale che, ancora una volta, la risoluzione angolare non risulti troppo modificata. Disponiamo poi ognuna delle parti riflettenti su un supporto indipendente e combiniamo la luce di ognuna di esse mediante specchi appropriati. Siamo ora in possesso di una serie di piccoli telescopi, con la risoluzione angolare data ancora dalla [1] ma dove d risulta in questo caso uguale al diametro della serie, che corrisponde al diametro del grande telescopio con il quale siamo partiti.

In questo modo si perde naturalmente qualche informazione sull'immagine ma, purché i telescopi siano ben distribuiti, tale problema è trascurabile. Se si riduce troppo il numero delle parti riflettenti, l'informazione persa diventa consistente e la conoscenza fornita dall'immagine molto imprecisa, anche se, pur lasciando soltanto due telescopi separati da una distanza d, un minimo di informazione si conserva sempre. L'informazione minima relativa a una stella la cui immagine è un disco uniformemente illuminato dovrebbe essere la determinazione del suo diametro angolare; con tre telescopi ben posizionati, si è in grado di valutare se il disco è più luminoso all'interno rispetto all'esterno. Ogni telescopio supplementare produce ulteriori informazioni sull'immagine. Se si ha a disposizione una serie interferometrica di telescopi distribuita su un'area del diametro di 100 m, la risoluzione angolare alla lunghezza d'onda di 0,4 μm dovrebbe essere di 0,004″. La turbolenza dell'atmosfera può influenzare la combinazione della luce da parte dei differenti telescopi, ma anche in questo caso è proficuo utilizzare il sistema di correzione dell'ottica adattiva.

I telescopi infrarossi

I telescopi operanti nell'infrarosso sono fondamentalmente dello stesso tipo di quelli ottici, ma in questo settore dello spettro elettromagnetico si presenta qualche problema particolare. A parte alcune ristrette 'finestre' negli intervalli 3-30 μm e 300-1000 μm, nell'infrarosso l'atmosfera è opaca, a causa soprattutto dell'assorbimento dovuto alla presenza di vapore acqueo. Per questo motivo, nell'infrarosso i telescopi vanno collocati nello spazio, anche se da terra qualche finestra atmosferica diventa più ampia qualora le osservazioni siano effettuate a bordo di aerei in alta quota oppure negli elevati altipiani dell'Antartide. Un problema che concerne le osservazioni in questa banda è che, anche a temperature vicine a 0 °C, i telescopi e la strumentazione ausiliaria emettono una forte radiazione infrarossa, molto maggiore della radiazione ricevuta dalle sorgenti celesti; è necessario pertanto portare gli strumenti a temperature più basse. Inoltre, a causa della maggiore lunghezza d'onda, nell'infrarosso i telescopi hanno bassa risoluzione angolare. Infine, poiché nell'infrarosso i fotoni sono poco energetici, fino a poco tempo fa non si sono facilmente riusciti a realizzare adeguati rivelatori a stato solido. A ogni modo, le ricerche portate avanti per la costruzione di strumenti capaci di effettuare osservazioni notturne e gli elevati stanziamenti messi a disposizione per tale scopo hanno permesso di ottenere importanti progressi industriali in questo settore.

Nel 1995 l'ESA (European space agency) ha lanciato la prima grande strumentazione nel campo infrarosso, l'Infrared space observatory (ISO), un telescopio di 60 cm di diametro, raffreddato a circa 2 K (−270 °C ca.) da 2300 l di elio liquido in lenta evaporazione. La missione è terminata dopo 28 mesi, quando l'elio si è esaurito. Una missione della NASA nell'infrarosso, lo Space infrared telescope facility (SIRFT), con un telescopio di 85 cm, è partita nel 2003. Con il suo piccolo telescopio, l'ISO ha una risoluzione angolare di non più di 40″ alla lunghezza d'onda di 100 μm, e il SIRFT, da questo punto di vista, non ne possiede una migliore. Tuttavia l'ISO, grazie alle sue camere per immagini e ai suoi spettrografi, ha effettuato molte scoperte: la presenza di acqua nel mezzo interstellare; l'esistenza di minerali nei dischi di materia che circondano le stelle appena nate, dove possono formarsi i pianeti; una grande varietà di molecole nel gas interstellare; galassie con una luminosità infrarossa migliaia di volte maggiore di quella della Via Lattea. In futuro è prevista la costruzione di telescopi più grandi operanti nell'intervallo di lunghezze d'onda 100÷600 μm, dove non sono necessarie temperature estremamente basse.

Nella zona di separazione tra la banda infrarossa e quella radio dello spettro elettromagnetico, a circa 1 mm di lunghezza d'onda, è stata scoperta la radiazione cosmica di fondo. Questa radiazione è il residuo delle fasi evolutive primordiali dell'Universo e contiene informazioni su ciò che avvenne poco dopo il big bang. Essa corrisponde alla radiazione di un corpo nero alla temperatura di 2,7 K e pervade l'intero Universo; è quasi uniforme ma presenta variazioni dell'ordine di circa una parte su 105, scoperte per la prima volta nel 1992 dal satellite Cosmic background explorer (COBE) della NASA, che aveva una risoluzione angolare di 7°. Attualmente è in orbita un secondo satellite della NASA, il Microwave anisotropy probe (MAP), con una migliore risoluzione angolare (12′). A esso seguirà nel 2007 il satellite Planck dell'ESA, che avrà una risoluzione di 5′ d'arco. Si sono effettuate osservazioni anche a bordo di palloni stratosferici, ma soltanto concernenti aree limitate di cielo; in questo caso, per scoprire le piccolissime variazioni di temperatura nella radiazione cosmica di fondo serve ovviamente molta attenzione per eliminare tutti gli effetti di disturbo.

Una delle più grandi sfide del futuro è la scoperta di pianeti simili alla Terra in orbita attorno a stelle vicine. Tali pianeti dovrebbero emettere soprattutto una forte radiazione infrarossa attorno a 10 μm. Per scoprirli, è necessario osservarli con un'alta risoluzione angolare ed eliminare il disturbo della luce stellare, che è più intensa di quella emessa dal pianeta alcuni milioni di volte. La tecnica interferometrica può fornire la soluzione. Un progetto di questo tipo prevede il volo in formazione di sei telescopi spaziali indipendenti, distanti tra loro fino a 250 m. Poiché la distanza tra i telescopi dev'essere mantenuta costante per una frazione di lunghezza d'onda, è necessario un controllo estremamente accurato dei movimenti degli strumenti in volo. Di particolare interesse dovrebbe essere la possibilità di scoprire l'assorbimento di ozono (O3) a 10 μm, perché la presenza di ozono indica anche quella di ossigeno. Si pensa che, in mancanza di forme di vita di tipo microbico, l'ossigeno non esisterebbe nell'atmosfera terrestre, poiché si troverebbe tutto in forma ossidata nelle rocce; la scoperta di ozono può essere pertanto indicativa della presenza di vita.

I radiotelescopi

Nell'intervallo di lunghezze d'onda che vanno dai millimetri ai decimetri, i radiotelescopi non differiscono significativamente dai telescopi ottici, che però sono molto più difficili da realizzare e senza dubbio più costosi poiché, per ottenere buone immagini, la forma della superficie dello specchio non dovrebbe modificarsi per più di λ/20, dove λ è la lunghezza d'onda. Il più grande radiotelescopio totalmente orientabile ha un diametro di circa 100 m. Dalla [1] si ricava che alla lunghezza d'onda di 1 cm la sua risoluzione angolare è di 25″ e a 1 m soltanto 0,7°; per migliorarla è pertanto necessario utilizzare l'interferometria. Il Very large array (VLA), costruito nel 1980 presso Socorro nel New Mexico, è un grande sistema di radiotelescopi che utilizza tecniche interferometriche, composto da 27 telescopi mobili di 25 m di diametro distribuiti a forma di 'Y' su un'area che si estende per più di 36 km; alla lunghezza d'onda di 1 cm la sua risoluzione angolare è di 0,07″.

Un sistema interferometrico ancora più grande, il Giant meterwave radio telescope (GMRT), comprendente 30 telescopi di 45 m di diametro ciascuno, è stato realizzato vicino Poona, in India. Poiché a grandi lunghezze d'onda non è necessario avere uno specchio solido, la superficie riflettente è costituita da una rete di fili, che diminuiscono notevolmente sia il peso sia il costo. Per quanto il GMRT sia lo strumento più sensibile alle grandi lunghezze d'onda, esso non può essere comunque utilizzato al di sotto dei 20 cm.

Una risoluzione angolare ancora più grande può essere ottenuta con il Very long baseline interferometry (VLBI), nel quale i dati ricavati da una serie di telescopi molto distanti tra loro sono registrati su nastri magnetici ad alta velocità e sincronizzati da orologi atomici molto precisi. La configurazione interferometrica prevede che la distanza tra i telescopi possa essere grande quanto il diametro della Terra, e ancora maggiore qualora si collocasse uno dei telescopi in un'orbita spaziale. L'agenzia spaziale giapponese ISAS ha lanciato un telescopio di 10 m, denominato HALCA, in un'orbita con una distanza massima dalla Terra di 21.000 km. Combinato con il VLBI terrestre, esso ha consentito di ottenere una risoluzione angolare di 0,0007″ alla lunghezza d'onda di 6 cm. Questo sistema è stato utilizzato per studiare i processi energetici che avvengono attorno ai buchi neri situati nei nuclei galattici attivi e nelle quasar.

A lunghezze d'onda submillimetriche la condizione che la superficie degli specchi non subisca modificazioni geometriche diventa essenziale, e ciò fa aumentare il costo dei telescopi. La risoluzione angolare migliora ma resta ancora insufficiente per ottenere buoni risultati in molti tipi di osservazioni. Inizialmente anche i ricevitori comportavano alcuni problemi. Inoltre, a causa dell'assorbimento della radiazione da parte del vapore acqueo presente nell'atmosfera, è necessario far operare i telescopi in luoghi a elevate altitudini e dal clima secco. Attorno al 2010 entrerà in funzione un sistema di telescopi interferometrici di piccole dimensioni, l'Atacama large millimeter array (ALMA), ancora più piccolo di quelli di modesta grandezza finora costruiti. L'ALMA consisterà di 64 telescopi di 12 m di diametro e verrà collocato sul Llano de Chajnantor (200 km a est della città di Antofagasta) a un'altezza di 5200 m; la precisione geometrica della superficie degli specchi sarà sufficiente per effettuare osservazioni alla lunghezza d'onda di 0,3 mm. Con i telescopi distribuiti su un'area di circa 10 km, la risoluzione angolare dovrebbe essere di 0,025″ alla lunghezza d'onda di 1 mm. Grazie a queste due caratteristiche senza precedenti, l'ALMA dovrebbe consentire di osservare la formazione di pianeti attorno alle stelle, la chimica del gas interstellare e i processi di formazione delle galassie nell'Universo primordiale. L'ALMA è un progetto in collaborazione tra Stati Uniti, Canada, Europa e, forse, Giappone, del costo di circa 650 milioni di euro, sostanzialmente pari a quello di un comune grande progetto spaziale; il suo termine è previsto per il 2010.

I telescopi a raggi X

Alle lunghezze d'onda minori di 91 nm, fino a circa 10 nm, il gas interstellare è opaco e, di conseguenza, è possibile osservare soltanto alcune stelle vicine, mentre quelle al di fuori della nostra galassia sono invisibili perché completamente nascoste dal gas interstellare. La prima sorgente di raggi X fu scoperta dai fisici che studiavano i raggi cosmici e per questo motivo l'energia dei fotoni si misura di solito in elettronvolt (eV), piuttosto che in lunghezza d'onda (1 keV corrisponde alla lunghezza d'onda di 1,2 nm, mentre 10 keV corrispondono a 0,12 nm).

I telescopi ottici hanno specchi che riflettono i raggi luminosi ad angoli di incidenza vicini a 90°. Tali specchi riflettono invece i raggi X in modo trascurabile tranne che ad angoli di incidenza molto bassi, rendendo pertanto necessari telescopi molto diversi. La prima osservazione di raggi X fu effettuata esponendo contatori proporzionali direttamente verso il cielo. In questo tipo di contatori è presente un gas, del quale i raggi X possono ionizzare alcuni degli atomi; gli elettroni prodotti nella ionizzazione sono raccolti in un anodo costituito da un sistema di fili. Davanti a questo dispositivo è posto uno speciale tipo di collimatore metallico che limita le direzioni da cui i raggi X possono raggiungere il contatore. Questa sistemazione è comunque poco soddisfacente, perché la risoluzione angolare ottenuta con tali collimatori è scarsa. Inoltre, la necessità di disporre di grandi rivelatori, al fine di ottenere una sufficiente sensibilità, causa l'aumento del disturbo dovuto agli effetti di fondo procurati dalla presenza di particelle ambientali; il problema si riduce notevolmente con l'ottica di focalizzazione, che permette di utilizzare rivelatori molto più piccoli.

L'ottica di focalizzazione per i raggi X è stata sviluppata nel secolo scorso. Si basa su una doppia riflessione ad angoli di incidenza molto bassi, ottenuta combinando una superficie parabolica con una iperbolica. Tale ottica funziona soltanto fino a 10 keV, ma si pensa che, utilizzando uno speciale rivestimento multistrato per lo specchio, il limite possa essere portato fino a 50 oppure anche fino a 100 keV. Questa tecnica è stata introdotta per l'uso astronomico da un gruppo di ricercatori guidato da Riccardo Giacconi e Bruno Rossi il quale nel 1962, con un primitivo sistema di rivelazione, scoprì la prima sorgente di raggi X esterna al Sistema solare. Tale scoperta ha portato nel 1978 a lanciare il satellite Einstein in grado di osservare molte sorgenti di raggi X. Numerosi altri satelliti con le medesime finalità si sono susseguiti a Einstein: tra questi, i più produttivi sono il satellite tedesco per i raggi X molli ROSAT (1990), che ha esplorato l'intero cielo scoprendo circa 150.000 sorgenti; il giapponese ASCA (1993) per la rivelazione di raggi X più duri, fino a 10 keV, inclusa l'importante riga del ferro a 6,4 keV, e l'italo-tedesco BeppoSAX (1996), che ha coperto con diversi strumenti l'intervallo di energie da 0,1 a 200 keV. Quest'ultimo satellite ha permesso di determinare la posizione dei misteriosi lampi di raggi gamma con sufficiente precisione favorendo studi ottici successivi i quali hanno stabilito come tali raggi siano dovuti a processi molto energetici che avvengono in zone assai distanti dell'Universo, a redshift dell'ordine dell'unità. Nel 1999 sono stati lanciati due grandi satelliti: il Chandra dalla NASA e l'XMM-Newton dall'ESA. Il primo ha una risoluzione angolare migliore di 1″, il secondo un'area di raccolta di fotoni molto grande, per scopi spettroscopici. La differenza rispetto ai telescopi ottici resta però cospicua: complessivamente, l'area di raccolta effettiva dei due satelliti è minore di 1 m2. In linea di principio, sono circa 50 milioni le sorgenti di raggi X che potrebbero essere scoperte, ma servirebbero circa 5000 anni per esplorare l'intero cielo alla giusta profondità. Queste sorgenti sono costituite per la maggior parte da nuclei galattici attivi e stelle, ma grande interesse suscitano anche i residui di supernova, alcuni dei quali con elementi chimici sintetizzati da relativamente poco tempo. Nei nuclei galattici attivi e nelle quasar i raggi X si producono in parte vicino al buco nero centrale, dove il gas si muove a velocità dell'ordine di un decimo della velocità della luce. È previsto che durante l'attuale decennio il Chandra e l'XMM-Newton continueranno a fornire dati; questi due satelliti dovevano congiungersi con il satellite giapponese Astro E, che però è andato perduto a causa del fallimento del lancio; un nuovo lancio di Astro E è programmato per il 2004.

In un futuro meno immediato è prevista la costruzione di telescopi a raggi X di dimensioni ancora più grandi. La missione X-ray evolving universe spectroscopy (XEUS), che si sta pianificando all'ESA, dovrebbe alla fine avere un'area di raccolta effettiva da 20 a 100 volte maggiore di quella dell'XMM-Newton. Essa dovrebbe essere montata sulla Stazione Spaziale Internazionale ma, dal momento che questa non fornisce una piattaforma sufficientemente stabile, verrebbe poi depositata nello spazio durante la sua vita operativa, per essere di tanto in tanto riportata sulla Stazione Spaziale stessa per montare nuovi rivelatori e allargare l'area di raccolta di fotoni, qualora diventassero disponibili nuovi fondi. Un progetto alternativo della NASA, la 'Costellazione X', coinvolgerebbe un certo numero di satelliti indipendenti, ognuno con un telescopio a raggi X più modesto, i dati dei quali sarebbero combinati elettronicamente.

I contatori proporzionali hanno una scarsa risoluzione energetica (ΔE/E≈1/7), che è stata però di recente migliorata significativamente, adattando i CCD e i bolometri alla banda dei raggi X; anche gli spettrografi a reticolo hanno raggiunto risoluzioni energetiche più alte (circa 1/300, con l'XMM-Newton, a 1 keV), ma la loro bassa efficienza ne limita l'uso soltanto alle sorgenti piuttosto luminose.

I raggi gamma

Senza l'ausilio dell'ottica di focalizzazione la radiazione gamma può essere osservata soltanto esponendo i rivelatori direttamente verso il cielo. Ciò non costituisce un grande svantaggio per le energie corrispondenti ai raggi gamma duri, perché la traccia che essi lasciano può essere seguita attraverso il materiale del rivelatore grazie alle particelle secondarie che quest'ultimo genera. In tale modo si può determinare la direzione d'arrivo della radiazione. Poiché nel cielo le sorgenti di raggi gamma non sono numerose e sono tutte puntiformi, la risoluzione angolare che si ottiene è sufficiente. La natura delle particelle o dei fotoni incidenti si può investigare analizzando le singole tracce e l'effetto di fondo creato dai protoni o dagli elettroni locali non rappresenta un problema rilevante.

La situazione cambia per i raggi gamma molli, attorno a 1 MeV. Dato che prima di diffondersi tali raggi non attraversano molta materia, non si può determinare con sufficiente precisione la direzione di provenienza delle tracce. Si può soltanto collocare una maschera davanti al rivelatore per eliminare alcune direzioni di arrivo della radiazione; attraverso l'impiego di maschere codificate, nelle quali queste direzioni sono stabilite con un determinato criterio, è possibile raggiungere risoluzioni angolari dell'ordine di 10 minuti d'arco. Dal momento che il rivelatore può essere colpito anche da particelle di alta energia non riconosciute, è sempre presente un significativo effetto di fondo, relativamente uniforme, che riduce la sensibilità. Questa problematica regione dello spettro è importante perché attorno a 1 MeV sono stati scoperti raggi gamma prodotti da elementi radioattivi sintetizzati relativamente da poco tempo nelle supernovae. Inoltre, gli spettri dell'ordine dei MeV forniscono particolari informazioni sulle energie raggiunte dalle particelle presenti nei nuclei galattici attivi e in altre sorgenti.

La banda elettromagnetica a 1 MeV è attualmente oggetto di studio del satellite Integral dell'ESA. La NASA, invece, in continuità con il Compton gamma ray observatory (CGRO) degli anni Novanta del secolo scorso, prevede di lanciare nel 2008 il Gamma-ray large area space telescope (GLAST), che dovrebbe essere in grado di scoprire raggi gamma con energie fino a 100 GeV.

È possibile individuare raggi gamma di energia ancora più elevata utilizzando come rivelatore l'atmosfera terrestre. Quando un fotone di tale energia colpisce l'atmosfera, lascia una traccia di radiazione Čerenkov che può essere rivelata mediante telescopi terrestri a largo campo. Con questa tecnica sono stati scoperti raggi gamma con energie fino ad alcuni TeV (=1012 eV); una parte di essi può essere prodotta da protoni di alta energia che interagiscono con un gas, un'altra parte da elettroni altamente energetici interagenti con fotoni dell'ambiente della sorgente.

I raggi cosmici, i neutrini e le onde gravitazionali

La radiazione elettromagnetica costituisce la fonte principale di informazioni riguardanti l'Universo, ma non è l'unica. Ai fini della conoscenza del Cosmo sono importanti anche i raggi cosmici, i neutrini e le onde gravitazionali.

I raggi cosmici furono scoperti nel 1912 da Victor Hess il quale dimostrò che gli effetti di una misteriosa sorgente ionizzante rivelata dai palloni stratosferici diventavano più intensi quando i palloni volavano più in alto nell'atmosfera. Ulteriori studi condotti da Bruno Rossi mostrarono che i principali costituenti dei raggi cosmici erano particelle cariche positivamente. Ormai è chiaro che le particelle principali dei raggi cosmici sono i protoni, seguiti da particelle alfa (nuclei dell'elio) e da nuclei atomici più pesanti, questi ultimi essendo in media relativamente più abbondanti che nella materia della nostra Galassia. Per l'1% sono stati scoperti anche elettroni; quelli presenti in un campo magnetico emettono radiazione di sincrotrone; infatti, la componente non termica delle onde radio emesse dalla nostra Galassia è dovuta agli elettroni che irradiano nei campi magnetici interstellari. I raggi cosmici di alta energia che colpiscono l'atmosfera superiore creano una pioggia di particelle secondarie, la cui osservazione fornisce informazioni sull'energia di quelle primarie. Si è trovato che le energie si estendono fino a 1020 eV, e forse di più, sebbene particelle di così elevata energia siano molto rare. Tali particelle, dette extreme energy cosmic-ray (EECR), sono molto interessanti, per diversi motivi. I raggi cosmici di energia più bassa sono diffusi e confinati in larga parte nella nostra Galassia dai campi magnetici interstellari, i quali sono però troppo deboli per deviare significativamente gli EECR e, dal momento che questi sono distribuiti in maniera largamente isotropa, ciò implica che non siano di origine galattica. Il fatto che non sono molto deflessi rende possibile ripercorrerne all'indietro le tracce per individuarne il luogo di origine. Se esistono veramente EECR con energie maggiori di 1020 eV, essi non possono comunque provenire da luoghi molto distanti dell'Universo, perché sarebbero distrutti dall'interazione con i fotoni della radiazione cosmica di fondo. Per campionare le particelle secondarie, e ottenere di conseguenza le energie delle primarie, è stato costruito in Giappone, nell'ambito del progetto AGASA, un sistema molto esteso di contatori, con una superficie di 100 km2. AGASA registra ogni anno circa 100 eventi con energia maggiore di 1019 eV, ma solo pochi sembrano eccedere i 1020 eV. Un altro sistema molto esteso di rivelatori, distribuiti su un'area di alcune migliaia di chilometri quadrati è in costruzione in Argentina. Si tratta del progetto Auger, frutto di una cooperazione mondiale, il cui scopo è quello di determinare in modo preciso l'energia degli EECR e l'eventuale anisotropia nelle loro direzioni di provenienza; quest'ultima possibilità è emersa dallo studio dei dati di AGASA.

Per determinare la composizione chimica dei raggi cosmici bisogna collocare i rivelatori nello spazio. Attualmente si ha un quadro abbastanza dettagliato dell'abbondanza dei principali elementi chimici e isotopi, anche se c'è da sottolineare che si conosce soltanto la composizione chimica dei raggi cosmici di energia relativamente bassa (di circa 1 GeV per nucleone). Di particolare interesse sono i dati relativi ad alcuni isotopi radioattivi prodotti nelle esplosioni delle supernovae, che mostrano come l'accelerazione verso energie elevate avvenga molte migliaia di anni dopo l'esplosione, presumibilmente negli urti che si verificano nel mezzo interstellare prodotto dalle supernovae.

I raggi cosmici sono composti anche dagli antiprotoni, prodotti principalmente nelle collisioni tra i protoni di alta energia e la materia interstellare della nostra Galassia. In linea di principio è possibile che nell'Universo esista l'antimateria, ma gli antiprotoni non possono fornire informazioni su di essa; inoltre, nelle collisioni non possono essere prodotti antinuclei più complessi degli antiprotoni. Per scoprire l'antielio è stato perciò lanciato dalla Stazione Spaziale Internazionale l'esperimento Anti matter spectrometer.

I raggi cosmici sono composti probabilmente anche da neutrini di alta energia. A causa della loro scarsa interazione con la materia, i neutrini attraversano indisturbati l'atmosfera, ma sono difficili da scoprire. La tecnica più promettente per individuarli implica l'osservazione della radiazione Čerenkov che è emessa quando i neutrini attraversano grandi volumi di materia trasparente. Un rivelatore che utilizza tale tecnica, situato in Antartide, esaminerà un chilometro cubo di ghiaccio mediante un gran numero di fotomoltiplicatori; altri rivelatori analizzano una quantità simile di acqua marina profonda. Lo studio delle tracce lasciate dai neutrini aiuta a capire da dove essi provengano.

I neutrini provenienti dal Sole, di energia molto minore, sono stati scoperti in diversi modi, per esempio misurando la trasformazione dell'isotopo del cloro in quello dell'argo; essi sono prodotti nelle reazioni nucleari che permettono al Sole di splendere. In passato gli scienziati rimasero sbigottiti quando in ripetuti esperimenti si misurò un flusso di neutrini solari che era meno della metà di quanto ci si aspettasse. È stato poi dimostrato che ciò è dovuto alle oscillazioni del neutrino, ossia alla spontanea trasformazione delle tre specie di neutrini l'una nell'altra, una possibilità suggerita da Bruno Pontecorvo non pochi decenni fa: parte dei neutrini che provengono dal Sole si trasforma in un'altra specie, che è stata scoperta soltanto di recente.

Quando una stella di grande massa, al termine della sua vita, collassa per diventare una supernova e lasciare una stella di neutroni, emette gran parte dell'energia sotto forma di neutrini. Nel 1987 una supernova apparve nella Grande Nube di Magellano, la galassia più vicina alla nostra, e furono scoperte alcune dozzine di neutrini, sia negli Stati Uniti sia in Giappone. Purtroppo l'apparizione di supernovae vicine è un evento molto raro.

Le onde gravitazionali, predette dalla teoria della relatività generale di Einstein, non sono ancora state scoperte in modo sperimentale; di esse esistono soltanto alcune prove indirette. Tali onde causano piccolissime dilatazioni o compressioni nella struttura dello spazio-tempo. Per individuarle sono stati costruiti rivelatori molto sensibili, sia negli Stati Uniti sia in Europa; vicino Pisa è stato completato il progetto italo-francese Virgo. Con questi rivelatori si possono osservare le onde gravitazionali prodotte dal collasso di una supernova, che possono provenire anche da stelle doppie molto vicine tra loro oppure dalla fusione di due buchi neri di grande massa e che hanno un periodo piuttosto lungo, dell'ordine di un'ora. La scoperta di tali onde può verificarsi soltanto al di fuori del campo di gravità della Terra. La NASA e l'ESA hanno cooperato per pianificare un esperimento spaziale - LISA (Laser interferometer space antenna) - che partirà all'inizio del prossimo decennio.

Conclusioni

La luce visibile, l'unica fonte di informazioni sull'Universo fino a circa sessant'anni fa, è soltanto una piccola parte dei canali di conoscenza oggi disponibili per gli astronomi. Gli strumenti utilizzati in questi canali necessitano tutti di tre requisiti: la sensibilità, la risoluzione angolare e quella spettrale. Quanto migliori sono le ultime due, tanta più sensibilità è necessaria per osservare piccole caratteristiche angolari e spettrali con un sufficiente rapporto segnale/rumore. Una volta acquisita un'alta efficienza, la crescita della sensibilità implica la costruzione di strumenti più grandi; per questa ragione l'astronomia è una scienza costosa.

È necessario che le informazioni che provengono dai diversi canali siano correlate tra loro: per esempio, quando si osserva una debole sorgente di raggi X, di solito non se ne conosce la natura e il luogo di provenienza fino a che non si hanno a disposizione anche i dati relativi alle osservazioni effettuate nel visibile o nell'infrarosso. L'astronomia può progredire soltanto migliorando la strumentazione su più fronti diversi. Molti nuovi progetti - un telescopio ottico terrestre di 100 m, un grande telescopio spaziale per osservazioni in diverse lunghezze d'onda, un sistema interferometrico nel campo delle onde radio esteso un chilometro quadrato, e così via - sono attualmente in corso di pianificazione ma, benché siano tutti importanti, il loro sviluppo è limitato dalle restrizioni economiche. È pertanto indispensabile un attento lavoro di selezione sia per stabilire le priorità sia per elaborare piani intelligenti a costi il più possibile contenuti.

Bibliografia

Bleeker 2001: The century of space science, edited by Johan A.M. Bleeker, Johannes Geiss, Martin C.E. Huber, 2 v., Dordrecht-London, Kluver, 2001.

Bonetti 1997: Cosmic ray, particle and astroparticle physics. A conference in honour of Giuseppe Occhialini, Bruno Pontecorvo and Bruno Rossi, Firenze 1995, a cura di Alberto Bonetti, Ilaria Guidi, Bianca Monteleoni, Atti dei Convegni Lincei 133, Roma, Accademia Nazionale dei Lincei, 1997.

Rossi 1984: Rossi, Bruno, Stelle: astronomia a raggi X, Enciclopedia del Novecento, Roma, Istituto della Enciclopedia Italiana, 1984, VII, pp. 114-140.

Woltjer 1998; Woltjer, Lodewijk, Telescopi, Enciclopedia del Novecento, Roma, Istituto della Enciclopedia Italiana, 1998, XI, Suppl. II, pp. 774-785.

Wootten 2001: Science with the Atacama large millimeter array (ALMA), edited by Alwyn Wootten (Astronomical Society of the Pacific, Conference Series, 235), San Francisco, Astronomical Society of the Pacific, 2001.