Geofisica

Geofisica

(App. I, p. 647; III, i, p. 722; IV, ii, p. 27; V, ii, p. 383)

Nei vari settori di pertinenza della g. è proseguito negli ultimi anni il progresso tecnico e delle conoscenze secondo le linee esaurientemente illustrate nell'Appendice V; come fatto nuovo, determinato in gran parte proprio da questo progresso tecnico, è inoltre importante segnalare la recente comparsa di alcuni aspetti evolutivi che vanno a toccare ardue problematiche di fondo. Il fatto che sia passato circa un secolo da quando la g. raggiunse una sua compiuta connotazione induce a considerare tali aspetti evolutivi come uno dei punti d'arrivo di questa scienza.

L'evoluzione delle idee sull'ambiente fisico terrestre

La g., detta anche, specie in passato, fisica terrestre o fisica della Terra, è la scienza dei fenomeni terrestri indagabili con i metodi propri della fisica.

Come fenomeni terrestri s'intendono quelli che si svolgono nell'ambiente terrestre (geosfera), cioè nello spazio occupato dal pianeta Terra, includente la parte solida di questa (studiata dalla g. della Terra solida), quella liquida (costituita dall'insieme degli oceani e dei mari, e dalle acque di superficie e sotterranee, studiata dalla g. dell'idrosfera) e quella aeriforme (costituita dalle particelle neutre e ionizzate di gas controllati dal campo gravitazionale e dal campo magnetico terrestri, studiata dalla g. dell'atmosfera). Scienze di confine con la g. sono la geodesia, la geologia, l'idrologia e la geochimica per quanto riguarda la forma e la costituzione della Terra solida e l'idrosfera, l'astrofisica dello spazio circumterrestre per quanto riguarda la forma e l'estensione dell'atmosfera, la meccanica celeste del Sistema solare per ciò che concerne i movimenti della Terra e del suo ambiente nello spazio (rotazione intorno all'asse polare, rivoluzione intorno al Sole, partecipazione al moto di rotazione dell'intera Galassia, di cui il Sistema solare fa parte) e, infine, la matematica per quanto concerne la formalizzazione analitica delle questioni studiate dalle dette scienze.

Questo schema dell'ambiente terrestre sembra ricalcare quello che l'insieme delle nozioni di tipo naturalistico, fino ad allora acquisite, proponeva all'inizio del 20° secolo; ma l'insieme delle conoscenze di carattere scientifico acquisite via via sui fenomeni terrestri è profondamente diverso rispetto a quello accettato nel lontano passato. I fatti principali sono:

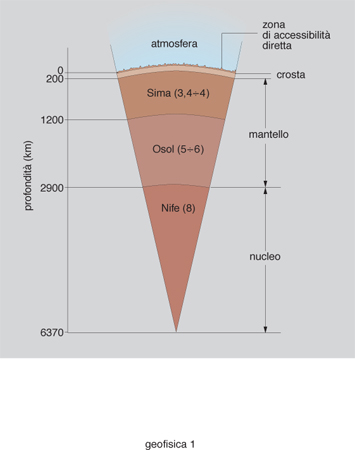

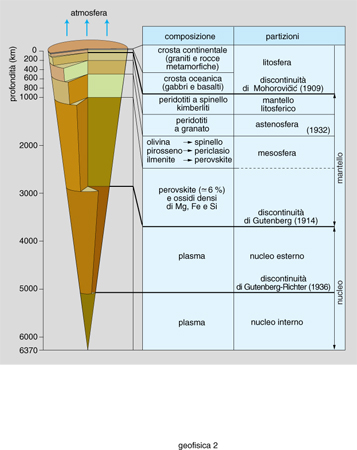

a) la struttura fisica della Terra solida oggi considerata, soprattutto in base alle evidenze di natura fisica della sismologia e del magnetismo terrestre, è assai differente e molto più dettagliata rispetto alla vecchia ripartizione ottocentesca negli strati sferici concentrici Sial (crosta), Sima, Osol e Nife, come è illustrato nei due schemi delle figg. 1 e 2;

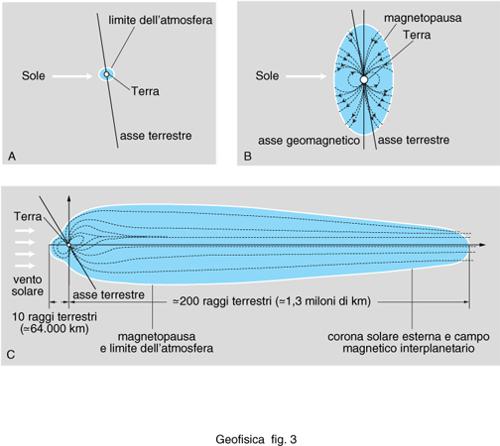

b) ancora più grande è la differenza riguardante la composizione e l'estensione dell'atmosfera terrestre. Sul finire dell'Ottocento e ancora nei primi anni del Novecento l'atmosfera della Terra era vista come una buccia sferica di gas elettricamente neutri a pressione decrescente, sfumante nello spazio interplanetario a circa 2500 km di distanza dalla superficie terrestre (fig. 3A). Si fu costretti a modificare drasticamente tale concezione in seguito alla scoperta (1925) che l'alta atmosfera, da circa 50 km di quota in su, è fortemente ionizzata (ionosfera); in seguito a ciò il ruolo di campo di controllo dei gas nello spazio circumterrestre, che prima era stato riconosciuto al campo gravitazionale, lo si dovette affidare al campo magnetico terrestre, derivandone per l'atmosfera una struttura a forma di ellissoide di rotazione (fig. 3B), con il raggio equatoriale di circa 10 raggi terrestri (≃64.000 km) e quello polare di circa 20 raggi terrestri (≃128.000 km, quasi nella direzione dell'asse della rotazione terrestre). All'incirca nel 1961, i primi risultati dell'esplorazione dello spazio circumterrestre mostrarono che l'alta atmosfera era completamente ionizzata a partire da circa 700 km di quota e aveva una forte interazione, mediata dal campo geomagnetico, con la radiazione particellare proveniente dal Sole (vento solare), per cui si è denominata magnetosfera questa parte estrema dell'atmosfera terrestre e si è riconosciuta per quest'ultima una forma vagamente cometaria assolutamente insospettata, assai estesa (fig. 3C), il cui confine (magnetopausa) si estende fino a circa 64.000 km nella direzione del Sole e fino a circa 1,3 milioni di km nella direzione opposta (la cosiddetta coda magnetica: v. atmosfera, App. V, nonché, ivi, fig. 4 per lo schema generale e la ripartizione in zone);

c) relativamente all'osservabilità diretta dell'ambiente terrestre, resta ancora inaccessibile la quasi totalità della Terra solida (il sondaggio più profondo ha permesso di raggiungere circa 12,5 km), per la quale è necessario quindi ricorrere a osservazioni indirette (principalmente offerte dalla sismologia e dal magnetismo terrestre), né tale situazione appare destinata a cambiare nel futuro (è fallito, per es., il tentativo di penetrare profondamente nella litosfera mediante una perforazione del fondo oceanico, dove la crosta terrestre è meno spessa); è invece sensibilmente migliorata l'osservabilità degli oceani, grazie all'entrata in servizio di efficienti sistemi di telerilevamento da terra e spaziale per l'investigazione della loro superficie (v. oltre: L'evoluzione dei mezzi di osservazione, al punto b) e di efficienti batiscafi per le grandi profondità, a partire dal Trieste realizzato in Italia da A. Piccard (1953); un cambiamento decisivo e definitivo riguarda invece l'atmosfera terrestre, che le tecniche dell'esplorazione spaziale hanno completamente aperto, a partire dal 1957, alla misurazione locale delle grandezze geofisiche, anche da parte di operatori umani;

d) mentre nel passato i tre grandi corpi terrestri, e cioè le parti solida, liquida e aeriforme della Terra, erano considerati ognuno nel suo stretto ambito e praticamente indipendenti tra loro, un risultato oramai acquisito (all'incirca dai primi anni Settanta) è che essi, in virtù delle reciproche profonde interazioni vanno a costituire l'ambiente terrestre come un tutto unico e indivisibile, interagente con il Sole e i corpi planetari solari.

L'evoluzione delle discipline geofisiche verso la 'globalizzazione': le 'scienze della Terra'

Il recente riconoscimento, prima ricordato, del carattere unitario dell'ambiente terrestre è derivato dalla constatazione che certi fenomeni non possono essere riconosciuti e compiutamente studiati altro che in questo ambito globale.

Un convincente esempio di fenomeni di questo tipo è costituito dal campo magnetico terrestre (campo geomagnetico), posto che esso per la grandissima parte (campo nucleare) è generato da correnti elettriche che si formano in virtù dell'interazione tra la rotazione terrestre, il campo magnetico medesimo e la materia fluida elettricamente conduttrice costituente il nucleo esterno terrestre (che si sviluppa tra circa 2900 e circa 5200 km di profondità: fig. 2), per una piccola parte (campo crostale) è generato dalle rocce della crosta terrestre magnetizzate dal campo nucleare e per una parte ancora più piccola è generato da correnti elettriche, particolarmente da quelle che si formano a circa 120 km di quota per interazione dei gas ionizzati della ionosfera con il campo medesimo, mediata dai parametri della rotazione terrestre: come si vede, nei fenomeni relativi al Campo magnetico terrestre sono coinvolte la Terra solida nel suo complesso (includendo le caratteristiche della sua rotazione diurna), l'atmosfera nel suo complesso e la radiazione ionizzante solare (responsabile della ionizzazione dei gas atmosferici).

Un altro esempio, questa volta di interazione non tra differenti corpi terrestri ma tra differenti scienze, è costituito dal fenomeno geologico noto come deriva dei continenti: le terre emerse costituenti i continenti sono animate da un lentissimo moto di allontanamento e di avvicinamento reciproco. Questo fenomeno, evidenziato nei primi anni del 20° sec., portò a pensare che in un'epoca primordiale della storia del pianeta le terre emerse costituissero un unico supercontinente. Questa opinione fu espressa per la prima volta nel 1915 dal geofisico austriaco A. Wegener (1880-1930), in base ad alcune evidenze di carattere naturalistico e geomorfologico (si vede a occhio, per es., che la grande sporgenza dell'America meridionale si adatta bene al grande golfo di Guinea nell'Africa, e le coste contrapposte mostrano molte somiglianze di flora e fauna; analogamente accade per altre zone continentali). Tale opinione tuttavia rimase per una cinquantina d'anni una semplice ipotesi, fino a che, nei primi anni Sessanta, gli studi della magnetizzazione propria misurabile nelle rocce vulcaniche - con il supporto della loro datazione, fornita dai geologi - dettero la prova della sua verosimiglianza, dimostrando che in moltissimi casi la posizione nell'attuale reticolato geografico del luogo di rinvenimento delle varie rocce era assai diversa dalla posizione occupata all'epoca della loro formazione, cioè all'epoca del consolidamento in roccia del magma primitivo, consentendo di determinare la posizione dei vari continenti nel corso delle epoche geologiche, fino a riconoscere l'esistenza di un supercontinente primigenio. Anche su questi apporti del geomagnetismo nelle lontane epoche geologiche (paleomagnetismo) si fonda la moderna teoria geologica nota come tettonica a zolle: in termini assai schematici, circa 200 milioni di anni fa il supercontinente iniziale si fratturò (lungo linee di minimo spessore della crosta terrestre, che ora si trovano circa al centro dei fondi dei grandi oceani) in grandi frammenti (zolle litosferiche); il sottostante magma fluido, fuoriuscendo dalle linee di frattura delle zolle e spingendo sui bordi delle fratture, determinò l'allontanamento reciproco di queste zolle, forzandole a scorrere sul sottostante magma semifluido (lo strato terrestre plastico detto astenosfera), e tale processo è tuttora in corso. In questa teoria vengono dunque ad armonizzarsi nozioni di g. (riguardanti il magnetismo delle rocce), di fisica dello stato solido e dei plasmi (riguardanti le proprietà meccaniche e termodinamiche dei magmi e delle rocce) e di geologia.

I due esempi trattati, ma se ne potrebbero citare molti altri, implicano una stretta interazione tra vari settori di ricerca affini alla g., interazione che avrebbe dovuto sviluppare un progressivo avvicinamento delle varie discipline in cui la g. è stata suddivisa (sismologia, vulcanesimo, fisica dell'interno della Terra e altre minori per la parte solida; oceanologia, limnologia e altre minori per la parte liquida; aerologia, meteorologia, fisica della ionosfera e della magnetosfera, ottica atmosferica e altre minori per la parte aeriforme, oltre al magnetismo terrestre e allo studio del campo gravitazionale), e un avvicinamento tra queste e le altre discipline scientifiche riguardanti la Terra, con in testa la geologia e la geochimica.

Si può capire come la differenziazione esistente tra le dette discipline sia un'ovvia conseguenza dello sviluppo storico delle conoscenze sulla Terra, che in genere è stato ineguale nei tempi e indipendente da disciplina a disciplina. Ci si limita a ricordare, a titolo di esempio, che le più antiche tra le discipline geofisiche sono l'ottica atmosferica e la meteorologia, sviluppatesi già nel 18° sec. negli osservatori astronomici (per ovvi motivi legati all'influenza dello stato dell'atmosfera sull'osservabilità degli astri), mentre occorre arrivare alla fine del 19° sec. perché la sismologia si connoti in senso compiutamente fisico, superando il suo primitivo carattere naturalistico maturato nell'ambito della geologia e della geografia; bisogna infine spingersi fino a circa un trentennio fa per riconoscere, come è stato accennato precedentemente, la reale costituzione dell'atmosfera terrestre a partire da certi risultati ottenuti mediante l'esplorazione spaziale.

Tuttavia, questa differenziazione, e specialmente la differenziazione delle filosofie di base (procedure) e dei linguaggi formali, è senz'altro un notevole elemento ostativo a quella che si può chiamare la globalizzazione delle conoscenze sulla Terra, la quale risulta elemento di capitale importanza per ulteriori sviluppi decisivi delle conoscenze fisiche riguardanti il nostro pianeta.

Così, tanto per esemplificare la differenziazione dei linguaggi formali esistente in un settore, quello della g. dell'atmosfera, che si è sviluppato in un ambito strettamente fisico già nella prima metà del 20° sec., è da osservare che il linguaggio usato da chi si occupa della fisica della cosiddetta bassa atmosfera neutra, cioè della parte dell'atmosfera fino a circa 50 km di quota, dove non vi è una sensibile presenza di atomi e molecole ionizzate (ioni) e si sviluppano i fenomeni meteorologici, è quello della fluidodinamica, mentre il linguaggio di chi si occupa della sovrastante ionosfera (parzialmente ionizzata) è quello dell'elettrodinamica, per passare infine al linguaggio della magnetofluidodinamica dei gas ionizzati (plasmi) quando ci si spinge nella parte estrema dell'atmosfera, cioè nella magnetosfera (completamente ionizzata): si tratta di tre linguaggi sensibilmente differenti per tre corpi atmosferici che hanno forti affinità e forti interazioni, sia per la loro comune natura chimica e aeriforme sia perché traggono quasi tutta la loro energia dalla medesima fonte, vale a dire dalla radiazione elettromagnetica (termica, luminosa, ultravioletta e X) e corpuscolare del Sole.

Una situazione analoga si ha anche per le discipline geofisiche interessanti la Terra solida, che sono quelle sopra ricordate, alle quali va aggiunta la geofisica applicata, che si occupa della prospezione del sottosuolo con metodi fisici (v. prospezione mineraria, XXVIII; App. III): orbene, il modo di procedere e lo stesso linguaggio descrittivo sono più o meno fortemente differenti da una disciplina all'altra.

Che dire poi della separatezza, tuttora insopportabilmente forte, tra discipline geofisiche e discipline geologiche, le quali ultime non prevedono l'applicazione sistematica dei metodi e degli algoritmi della fisica, laddove le materie di investigazione sono indissolubilmente connesse e talora sono le stesse?

A proposito di questa lamentata separatezza, è da ricordare che, parlando in termini generali dello sviluppo di una disciplina scientifica a base sperimentale e osservativa, qual è ogni disciplina riguardante la Terra, l'uso di un linguaggio specifico di essa è accettabile nella fase di avvicinamento a un dato problema, nella quale in genere si fanno fortemente sentire caratteristiche di tipo locale (quali quelle morfologico-descrittive), ma appare come elemento negativo nella successiva fase di investigazione causale dei fenomeni, in cui in genere giocano un ruolo via via più importante anche caratteristiche di tipo globale, che coinvolgono domini materiali o di conoscenza finitimi a quello investigato: ciò che prima è stato chiamato la globalizzazione delle procedure e dei linguaggi di discipline finitime è una necessità nell'evolversi stesso delle scienze interessate.

Per quanto riguarda la g., un primo passo in questa direzione è stato compiuto - non soltanto in Italia - nell'ambito dell'insegnamento universitario con la costituzione in varie facoltà scientifiche di raggruppamenti di discipline geologiche, geofisiche e geochimiche intitolati alle scienze della Terra: si tratta di un passo che ha ancora un carattere per molti aspetti formale, ma si può ragionevolmente confidare in esso per arrivare in tempi non lunghissimi alla desiderata e necessaria integrazione fra discipline di origine naturalistica e discipline di natura speculativa.

L'evoluzione dei mezzi di osservazione: dalla filosofia degli osservatori a quella della telemetria accentrata e del telerilevamento

Le discipline geofisiche sono tutte basate sull'osservazione quantitativa, cioè sulla misurazione, diretta o indiretta, delle grandezze rappresentative dei fenomeni naturali dell'ambiente terrestre e sulla successiva elaborazione speculativa delle misure; poiché questi fenomeni hanno una notevole variabilità nello spazio e nel tempo e alcuni di essi anche un'occorrenza casuale, la loro osservazione deve essere continua nel tempo e di tipo zonale, cioè ricoprente lo spazio presumibilmente interessato dai fenomeni in questione.

Nel suo primo sviluppo storico l'osservazione geofisica si è basata su osservatori geofisici (in particolare, meteorologici, sismici, magnetici, ecc.), sul modello degli osservatori astronomici.

Riferendoci alla situazione esistente nel passato, un osservatorio geofisico consisteva in un edificio che ospitava gli apparecchi per le misurazioni dirette e per la registrazione continua nel tempo dei valori delle grandezze di interesse, nonché il personale addetto a essi. Gli strumenti erano analogici, anche per la registrazione, che era di tipo meccanico (l'equipaggio mobile dello strumento di misurazione azionava una punta scrivente su una striscia di carta animata da un moto di scorrimento) oppure fotografico (l'equipaggio mobile portava uno specchietto che defletteva un pennello di luce su una striscia di carta fotosensibile in scorrimento). Nei frequenti casi in cui le grandezze da osservare erano tali da essere disturbate dalle attività dell'uomo (come capita, per es., per le grandezze riguardanti il magnetismo terrestre e la sismologia), gli osservatori venivano situati piuttosto lontano da insediamenti urbani e industriali o simili (per es., linee ferroviarie), e quindi in luoghi desolati e spesso impervi, ragion per cui era anche necessario offrire un adeguato alloggio per il personale. All'eventuale copertura del territorio di interesse si provvedeva con un'opportuna distribuzione geografica degli osservatori, venendosi così a costituire una rete di osservatori geofisici, che si scambiavano informazioni (misure e registrazioni) mediante le normali vie di comunicazione (posta, telefono, telegrafo, raramente telescriventi e ancora più raramente apparati telefotografici). Se la natura dei fenomeni osservati era tale da richiedere una rete osservativa piuttosto fitta sul territorio, com'è il caso, per es., della meteorologia, la richiesta rete di costosissimi osservatori era rimpiazzata da una rete di assai più semplici stazioni di osservazione geofisica, con personale operante, ma in genere non dimorante, in esse.

Tale struttura osservativa geofisica rimase praticamente immutata fino ai primi anni Sessanta, a partire dai quali essa ha subito notevoli modificazioni di carattere migliorativo, i cui aspetti principali ricorderemo qui di seguito.

a) L'impatto dell'elettronica a stato solido. Il primo aspetto riguarda la rivoluzione operata nella strumentazione geofisica e nella struttura stessa delle reti di osservazione dalla massiccia introduzione, appunto a partire dagli anni Sessanta, di dispositivi elettronici a stato solido di vario genere (diodi, transistori, dispositivi integrati e derivati), con le loro positive caratteristiche di piccolo ingombro, robustezza meccanica, ridotte necessità di alimentazione elettrica (a bassa tensione e bassa intensità di corrente) e grande flessibilità operativa, anche per la naturale disponibilità a operare con segnali sia analogici che digitali (più adatti, questi ultimi, all'elaborazione elettronica automatica).

È da osservare che già dagli anni Trenta e Quaranta erano ben noti i miglioramenti che la nascente elettronica era in grado di realizzare nel campo delle osservazioni geofisiche, e in effetti si erano già avute alcune significative realizzazioni: si pensi, per es., alla realizzazione di apparecchi radioelettrici per misurare da terra la concentrazione di elettroni liberi nella ionosfera (ionosonde: v. ionosfera, in questa Appendice) e di radiometeorografi portati da un palloncino sonda (radiosonde meteorologiche) per misurare da terra la pressione, la temperatura, l'umidità e gli elementi del vento dal suolo fino a quote intorno a 30 km e, ancora in meteorologia ma più tardi, negli anni Cinquanta, all'uso di radar per seguire l'evoluzione di sistemi nuvolosi. Si trattava, peraltro, di elettronica con tubi termoelettronici, che, principalmente per la necessità di un frequente controllo dello stato dei tubi e per le gravose esigenze di alimentazione elettrica (tensioni di almeno qualche decina di volt per gli anodi dei tubi e correnti relativamente intense per riscaldare i catodi dei tubi) vedeva le sue possibilità di utilizzazione limitate a strumenti da osservatorio, restando praticamente escluse le apparecchiature destinate a operare in siti senza una continua sorveglianza umana (con l'eccezione di pochissimi strumenti mobili per misurazioni non protratte nel tempo: tipicamente, le radiosonde meteorologiche già ricordate).

L'uso di dispositivi elettronici a stato solido consentì non soltanto di sostituire gli strumenti precedenti con strumenti più maneggevoli, assai poco esigenti quanto ad alimentazione elettrica e manutenzione, e assai più accurati e affidabili, ma soprattutto di risolvere il problema dell'ottimizzazione dei siti di osservazione: poiché tali strumenti potevano operare per periodi anche molto lunghi senza l'assistenza di personale addetto, il sito di installazione poteva essere scelto soltanto in base alle migliori condizioni di osservabilità del fenomeno e quindi, se necessario, anche in posti estremamente ardui per l'uomo (cime di alture, profondità marine ecc.), essendo l'alimentazione elettrica assicurata sia da una fonte locale (una batteria di pile elettriche periodicamente sostituibile o meglio, se possibile, un accumulatore elettrico combinato con un generatore fotovoltaico, quel che si chiama una batteria solare) sia da una fonte remota di energia mediante una linea di collegamento.

In quest'ultimo caso, la linea di alimentazione poteva essere utilizzata senza difficoltà anche per trasferire a un posto pur lontano i dati costituenti le misure via via raccolte, per una successiva registrazione ed elaborazione. Così, molto naturalmente, l'elettronica a stato solido consentì la realizzazione della telemisurazione, o telemetria, il cui risultato finale consistette nel ridurre il dispositivo di osservazione a un sensore della grandezza da misurare, o poco più, il cui segnale veniva avviato mediante una linea elettrica, una linea telefonica o un radiocollegamento al posto di registrazione e di elaborazione (filtraggio, conversione analogico-digitale, calcolo di medie nel tempo ecc.). Da qui fu piuttosto rapido il successivo passaggio (avvenuto negli anni Settanta) alla realizzazione di reti di telemetria accentrata, in cui i segnali dei vari sensori distribuiti sul territorio, anche in gran numero, affluiscono a un unico centro di elaborazione. Vale la pena di ricordare che in Italia sono di questo tipo la Rete meteorologica nazionale del Servizio meteorologico dell'Aeronautica militare, la prima in ordine storico in Italia (circa 200 osservatori, tra presidiati con personale e automatici), la Rete sismica nazionale dell'Istituto nazionale di geofisica (oltre 90 sensori sismici nel 1999, distribuiti sul territorio italiano e collegati mediante linee telefoniche riservate al centro di elaborazione di Roma), la Rete del Servizio idrografico e mareografico del Dipartimento servizi tecnici nazionali della Presidenza del Consiglio dei ministri (già del ministero dei Lavori pubblici: qualche centinaio di stazioni) e la Rete agrometeorologica nazionale dell'Ufficio centrale di ecologia agraria, oltre a varie reti sismiche, meteorologiche ecc. gestite in ambito locale da enti regionali o da enti di ricerca.

È poi banale ricordare che pressoché contemporaneo all'introduzione dell'elettronica a stato solido nelle strutture osservative fu l'uso, diventato sempre più ampio e specializzato, di elaboratori elettronici sia per le procedure di calcolo successive all'acquisizione dei dati sia per il controllo e, in molti casi, l'esercizio automatico delle dette strutture osservative.

Come risulta da quanto detto finora, l'uso di dispositivi elettronici a stato solido ha consentito di ridurre fortemente e spesso eliminare del tutto la presenza di operatori umani nella delicata fase della formazione del segnale costituente la misura (tali operatori intervengono soltanto nelle successive fasi di interpretazione dei risultati delle elaborazioni dei dati, oltre che, ovviamente, in situazioni di emergenza); ciò assicura un'affidabilità dei dati medesimi che era assolutamente impensabile con le vecchie procedure di osservatorio o di stazione: è una cosa ben nota, infatti, che in un processo continuo di misurazioni un operatore adibito a operazioni di routine costituisce la peggiore fonte di errore o, come si usa dire in termini informatici, la peggiore fonte di rumore, in quanto fonte decisamente non razionalizzabile.

Dal punto di vista dell'accuratezza delle misure, un'altra caratteristica positiva delle reti di telemetria accentrata è costituita dal fatto che tutte le misure sono riferite a una medesima scala di tempo, quella dell'orologio elettronico nel centro di elaborazione della rete, anziché, come avveniva e avviene nelle strutture a stazioni indipendenti, a tante scale di tempo quante sono le stazioni, ognuna data dall'orologio locale, affidato al controllo, fatalmente non perfetto, di un operatore. In particolare, questa caratteristica è di capitale importanza nell'elaborazione di dati sismici volta a determinare l'epicentro e l'ipocentro di un terremoto, che è fondata sulla differenza tra i tempi di arrivo delle onde sismiche nei vari siti; una difficoltà che esisteva quando tale elaborazione veniva effettuata in base ai dati provenienti da vari osservatori o da varie stazioni sismiche derivava appunto dall'incertezza sulla coerenza degli orologi locali.

b) Il telerilevamento geofisico da terra e da stazioni spaziali. Costituisce il secondo notevole miglioramento delle tecniche di osservazione geofisica da punti fissi di zone anche molto ampie della superficie terrestre, mari e oceani inclusi.

All'inizio si trattò di un uso più esteso e geograficamente più fitto dei radar per studiare, specialmente nella loro evoluzione, sistemi nuvolosi quali indicatori della dinamica atmosferica a grande scala; si passò poi all'uso di tecniche analoghe a quelle associate all'utilizzo dei radar ma con i lidar e i sonar, che hanno permesso anche di studiare particolarità chimico-fisiche a piccola scala sia della bassa atmosfera (per es., la concentrazione di aerosol e di inquinanti) sia della superficie del suolo e dei mari (per es., le caratteristiche del moto ondoso): v. telerilevamento, App. V.

Un passo molto importante fu l'utilizzazione di tecniche iconografiche, che dapprima furono fotografiche ma poi, piuttosto presto, divennero televisive; questa scelta divenne per molti versi determinante quando ci si servì di satelliti artificiali terrestri come piattaforme (telerilevamento geofisico da satellite o telerilevamento spaziale): tale attività s'iniziò nel 1960 con il lancio del primo dei dieci satelliti statunitensi TIROS per osservare a grande scala i sistemi nuvolosi e i loro spostamenti, e da allora è ampiamente proseguita con satelliti specializzati per i vari tipi di osservazione e di misurazione.

Il principio del telerilevamento spaziale è quello di una ripresa televisiva effettuata da bordo del satellite, con l'invio a stazioni riceventi terrestri delle immagini della superficie terrestre compresa nel campo di vista di una o più telecamere di un sistema televisivo radiocollegato con stazioni terrene; le telecamere sono provviste di opportuni filtri per operare in determinati campi spettrali (dall'infrarosso all'ultravioletto vicino, passando per il visibile), ognuno dei quali è adatto per osservare specifiche particolarità: per es., particolarità meteorologiche, compresa la concentrazione di inquinanti o di altro, oppure, utilizzando campi spettrali nell'infrarosso in cui i sistemi nuvolosi risultino trasparenti, le particolarità del suolo (conformazione geologica e idrogeologica, caratteristiche della vegetazione, temperatura del suolo ecc.). È stato così risolto definitivamente l'annoso problema dell'osservazione geofisica della superficie terrestre, sia globale frequente (ci si serve allora di satelliti in orbita polare o fortemente inclinata sul piano equatoriale) sia zonale continua (con satelliti geostazionari).

c) Estensione dei metodi di osservazione geofisica ai corpi del Sistema solare. L'esplorazione dello spazio circumterrestre e dei corpi astrali in esso è avvenuta anche utilizzando metodi di osservazione propri della g., sia con strumenti a bordo di veicoli spaziali, orbitanti o no (la prima esperienza positiva fu, nel 1959, quella, intorno alla Luna, della sonda sovietica Lunik 1), sia mediante l'installazione di strumenti sulla superficie della Luna (la prima a effettuare ciò fu, nel 1966, la sonda Mariner della statunitense NASA) e di pianeti (il primo tentativo con esito positivo fu per Marte, nel 1976, con le sonde Viking della NASA), sia, infine, mediante operazioni svolte direttamente da astronauti sbarcati su astri (finora soltanto sulla Luna, tra il 1969 e il 1973, da parte di astronauti della NASA): per tutto ciò v. spazio, esplorazione dello, App. IV e V.

I risultati conseguiti (tratti non soltanto da misure, ma anche da campioni del suolo) sono stati importanti non soltanto per la fisica dei corpi planetari, ma anche per la g.: infatti, la comprensione di alcuni fenomeni evolutivi dell'ambiente terrestre ha tratto benefici, e ancor più ne trarrà nel futuro, da informazioni relative a fenomeni analoghi avvenuti in altri corpi planetari; in questa prospettiva si è formata una disciplina, derivata dalla geologia ma con l'aggiunta dei necessari apporti provenienti dalla fisica spaziale e dall'astrofisica del Sistema solare, denominata per il momento, e un poco incongruamente dal punto di vista lessicale, geologia planetaria (v. App. IV).

L'antropizzazione della geofisica

Nella storia recente della g. è ben evidente un altro notevolissimo avvenimento, oltre alla 'rivoluzione elettronica' degli anni Sessanta precedentemente illustrata: ci riferiamo alla presa di coscienza, da parte dell'intera collettività e non soltanto da parte della ristretta comunità dei geofisici e dei geologi, che l'ambiente di cui si occupa la g. non è un continuum spaziotemporale fra i tanti che si considerano nelle scienze fisiche, ma è l'ambiente dell'uomo, in cui questi esplica le sue attività e compie il suo ciclo vitale, anzi dove si sono sviluppate tutte le forme di vita che conosciamo, come dire che l'ambiente terrestre può essere considerato anche come il contenitore di ciò che correntemente si chiama biosfera (per questo aspetto biologico generale, v. geofisica, App. V).

Questa presa di coscienza è avvenuta nella seconda metà degli anni Settanta ed è stata presentata da taluno come una sorta di scoperta: in realtà si potrebbe parlare, al più, di una riscoperta. Infatti, le discipline geofisiche di più antica origine naturalistica sono nate e si sono sviluppate con una forte connotazione antropica, vale a dire con una particolare attenzione all'uomo; ciò è ben avvertibile, per es., nella storia della meteorologia, né potrebbe essere altrimenti per una disciplina che si occupa di fenomeni di primaria importanza per l'agricoltura e tante altre attività umane, nonché, al limite (nella climatologia), per la stessa abitabilità della Terra.

Non è facile capire bene, a distanza di tempo, da che cosa sia derivata esattamente questa improvvisa evoluzione, che può a ragione essere definita antropizzazione della g. e, in generale, delle scienze della Terra; è certo che essa, come è stato accennato poco fa, ha interessato un ambito ben più vasto del mondo scientifico, dando luogo nella pubblica opinione ai sentimenti che si sono poi razionalizzati nei punti di vista sull'ecologia e si sono estrinsecati nelle varie prese di posizione in difesa dell'ambiente alle quali si è assistito negli ultimissimi decenni. Probabilmente, molto hanno influito sia il rifiuto di assistere impotenti alla progressiva degradazione dell'ambiente (deforestazione e desertificazione di vaste zone, inquinamento dell'aria e delle acque, riduzione dell'azione schermante dello strato di ozono atmosferico nei riguardi dei nocivi raggi ultravioletti solari), sia, da una differente prospettiva, la presunzione che il progresso scientifico e tecnico consentisse di abbandonare il tradizionale atteggiamento passivo e fatalista nei riguardi dei grandi fenomeni naturali, e segnatamente di quelli catastrofici (uragani, inondazioni, terremoti, eruzioni vulcaniche ecc.), in favore di un atteggiamento attivo, volto a controllare tali fenomeni e in particolare a contrastarne gli effetti dannosi che ne derivano. Si trattò di un atteggiamento che pervase in modo particolarmente vivo l'opinione pubblica e il mondo scientifico dei paesi sviluppati esposti a gravi rischi idrologici, vulcanici e specialmente sismici, quali, per quanto riguarda questi ultimi, il Giappone, la California, la Russia centrale asiatica, la Cina centrale e le tre penisole nel mare Mediterraneo, Italia, Grecia e Turchia.

Nel nostro paese quel moto d'opinione veniva a capitare in un periodo di notevole attività sismica distruttiva, che, iniziatosi nel 1968 con il terremoto del Belice, in Sicilia, proseguì con i terremoti dell'Anconetano nel 1972, della Valnerina nel 1973-74 e dei due, assai gravi, del Friuli nel 1976, e che avrebbe raggiunto il suo culmine con il disastroso terremoto dell'Irpinia nel 1980. La risposta del mondo scientifico italiano alle sollecitazioni avanzate dalla pubblica opinione fu pronta e si manifestò in varie iniziative di ricerca, volte specialmente alla precisazione del concetto di 'rischio' connesso ai fenomeni naturali (v. geofisica, App. V) e al problema della 'previsione' delle caratteristiche di localizzazione spaziotemporale e di intensità di tali fenomeni. In particolare, le attività riguardanti i fenomeni sismici furono promosse e coordinate nel grande Progetto finalizzato 'Geodinamica' del Consiglio nazionale delle ricerche, che coinvolse tutti i ricercatori italiani alla fine degli anni Settanta e negli anni Ottanta. Nacquero così grandi aspettative, sia per le previsioni sismiche sia per quelle meteorologiche, ben fondate sul grande sviluppo che ci si poteva fiduciosamente attendere relativamente ad adeguati mezzi di osservazione e di calcolo (v. oltre: Situazione attuale: alcuni problemi emergenti e loro prospettive future).

Quanto al vagheggiato intervento umano sull'evolversi dei fenomeni catastrofici, considerazioni di vario tipo sulla natura stessa di questi ultimi e sulla scala assolutamente sovrumana delle energie messe in gioco, portarono presto a escludere per la maggior parte degli eventi la possibilità di interventi diretti e a fissare piuttosto l'attenzione sui mezzi per contenere i danni. Per es., questo filone di ricerca portò in vari paesi, compresa l'Italia, all'introduzione di migliori normative per le costruzioni in zone con sensibile rischio sismico.

Un altro risultato, in parte già noto, fu la constatazione che in alcune situazioni potevano entrare in gioco fattori di natura non scientifica, talora capaci di bloccare ogni iniziativa.

Un caso tipico è quello della pioggia provocata, cioè delle tecniche per provocare la condensazione in gocce dell'umidità atmosferica e la caduta della pioggia, non soltanto per ovviare a una situazione di siccità ma anche per sciogliere in pioggia le pericolose nubi grandinigene. I primi esperimenti positivi di queste tecniche (principalmente la disseminazione nell'atmosfera, mediante bruciatori al suolo, di particelle di ioduro d'argento agenti come nuclei di condensazione dell'umidità dell'aria) risalgono agli anni Cinquanta e Sessanta, ma quando si tentò di passare all'applicazione su grande scala per razionalizzare la caduta della pioggia al momento buono e su una data zona, insorse appunto un grave ostacolo di natura non scientifica ma legale, costituito dalle cause intentate dai proprietari dei fondi agricoli contigui a quelli irrorati dalla pioggia provocata e non beneficiati da questa, sulla base della non infondata pretesa che l'umidità in tal modo sottratta all'atmosfera sarebbe stata altrimenti portata dai venti sui loro fondi, determinando su questi la caduta normale della pioggia (a complicare le cose sono intervenute anche questioni analoghe sollevate addirittura da alcuni Stati). La questione della 'proprietà' dell'umidità atmosferica sovrastante una zona di superficie terrestre non ha trovato ancora soluzione e così uno dei pochi casi possibili di intervento umano diretto su fenomeni naturali non si è realizzato.

Situazione attuale: alcuni problemi emergenti e loro prospettive future

Riassumendo quanto detto finora, le principali linee di tendenza ben riconoscibili nella g. e, generalizzando, nelle scienze della Terra, negli ultimi decenni sono le seguenti:

a) se nell'ambito di alcuni problemi specifici a scala locale si può consentire una certa particolarità di procedure e di linguaggio alle singole scienze della Terra (astronomia del pianeta Terra, geochimica, geodesia, g., geologia, nonché le matematiche interessate) e alle singole discipline in cui queste scienze si articolano, per quanto riguarda i problemi alla grande scala, e soprattutto alla scala planetaria, l'ambiente terrestre (Terra solida, acque terrestri e atmosfera terrestre) va considerato, qual esso è, un sistema unico; in conseguenza, il corpus delle dette scienze e discipline non può che fondarsi su un linguaggio e su procedure logico/analitiche il più possibile comuni (globalizzazione delle scienze della Terra);

b) in questa globalizzazione entrano anche le acquisizioni dell'astrofisica dei pianeti del Sistema solare, particolarmente di quelli evolutivamente più simili alla Terra (Venere e Marte);

c) alla globalizzazione delle scienze si accompagna quella delle osservazioni, basate principalmente - anche se non esclusivamente - su reti di sensori (sia terreni sia spaziali) specializzati per tutte le grandezze di interesse, con elaborazione accentrata in ambito sia planetario sia geografico e topografico, e con operazioni ed elaborazioni completamente automatiche;

d) tra gli scopi della g. e delle altre scienze della Terra un posto fondamentale hanno le questioni riguardanti la conservazione e il miglioramento dell'ambiente terrestre, quale ambiente dell'uomo e, in senso più largo, di tutti gli esseri viventi a noi noti; specificamente per la g., si tratta in primo luogo di farsi carico degli studi volti a salvaguardare l'ambiente e i viventi, nei limiti del possibile, dai rischi connessi alle catastrofi naturali (antropizzazione della geofisica).

I problemi emergenti nell'attuale e per il futuro da queste linee di tendenza hanno caratteristiche differenti. Precisamente, i problemi, sia di concetto sia operativi, relativi ai precedenti punti b) e c), vale a dire relativi agli apporti dell'astrofisica del Sistema solare e alle tecniche di osservazione dei fenomeni e di elaborazione delle misure, sono di natura banale, dato che in definitiva attengono ai sicuri prevedibili progressi dell'esplorazione spaziale, dell'elettronica e dell'informatica. Non è così, invece, per i problemi relativi ai punti a) e d), cioè relativi alla desiderata armonizzazione delle scienze della Terra e alla difesa dell'ambiente terrestre.

A proposito del primo di questi due punti, non v'è molto da dire in aggiunta alla constatazione che si è ancora piuttosto lontani dal raggiungimento dell'obiettivo, anche se in misura disuguale nei diversi paesi. Esaminando le varie situazioni nazionali si ha l'impressione che la compenetrazione reciproca delle scienze della Terra - condizione preliminare all'auspicata globalizzazione - risenta fortemente della maggiore o minore rigidità delle strutture universitarie e di ricerca; così, mentre essa è già sensibilmente sviluppata nei paesi nei quali tali strutture sono relativamente flessibili e facilmente adattabili al singolo individuo e alla singola disciplina - come accade, tipicamente, negli Stati Uniti - lo è assai meno nei paesi europei, compresa l'Italia, che hanno strutture universitarie, e anche di ricerca avanzata, irrigidite dalla lunga tradizione.

A proposito del secondo dei detti punti, cioè il doveroso apporto della g. alla difesa dell'ambiente e in particolare alla difesa dell'uomo e delle sue attività dalle catastrofi naturali, la situazione si presenta in modo assai più complesso, in quanto si vanno a toccare questioni basilari della stessa geofisica. Poiché è difficile condurre un discorso di tipo generale a questo riguardo, ci limiteremo a spendere qualche parola su una questione che appare essere tipica, vale a dire la previsione dell'evoluzione spazio-temporale dei fenomeni naturali, esemplificando con i due casi particolari, ma di grande importanza, della previsione dei terremoti e delle previsioni meteorologiche a medio termine, e dicendo subito che nell'uno e nell'altro caso le grandi speranze nutrite negli anni Settanta si sono rivelate assai più difficili da realizzare rispetto a quello che ci si attendeva: siamo di fronte a due veri e propri problemi emergenti.

Il problema della previsione dei terremoti. - Negli anni Settanta il metodo principe per questo genere di previsione era riconosciuto nello studio dei cosiddetti precursori sismici: certe caratteristiche variazioni temporali e spaziali di grandezze geologiche (per es., la giacitura di strati del sottosuolo e di falde acquee), fisiche (per es., la velocità di propagazione di onde elastiche e le caratteristiche di onde elastiche emesse da rocce sollecitate staticamente) e chimiche (per es., la concentrazione nelle acque sotterranee di gas radioattivi emessi da rocce compresse per il progressivo accumularsi di tensioni elastiche). Ci fu tutto un fiorire di ricerche sperimentali su questi precursori nei paesi afflitti da grave rischio sismico (tra essi, come si sa, è anche il nostro paese); i risultati ottenuti furono però contraddittori, e ciò venne attribuito al numero relativamente ridotto delle osservazioni: si ritenne cioè che per ottenere risultati decisamente significativi fosse sufficiente aumentare il numero delle grandezze da tenere sotto osservazione continua, nonché il numero e la qualità delle stazioni di osservazione.

Da allora si sono fatti grandi sforzi per migliorare le cose secondo questi intendimenti, ma a tutt'oggi gli accurati dati ottenuti dall'esercizio di estese reti locali di osservazione istituite in varie zone a rischio sismico (anche in Italia) hanno portato a uno sconsolante risultato: se è vero che un terremoto è sempre preceduto e accompagnato da variazioni significative delle grandezze sopra citate, non è vero il contrario, cioè che il verificarsi di tali variazioni sia un segno certo e di univoca interpretazione spaziotemporale relativamente al verificarsi di un terremoto. Gli sforzi osservativi cui abbiamo accennato, che hanno compreso anche l'ampliamento della famiglia dei precursori sismici (includendovi, per es., il rilevamento dei campi elettromagnetici naturali), sono stati e saranno assai utili per aumentare le nostre conoscenze fisiche sull'interno della Terra, ma per il momento hanno fallito il loro obiettivo primario. Tuttavia, di fronte all'enorme importanza di ottenere un'attendibile previsione sismica, si è ancora dell'opinione che valga la pena di aumentare ulteriormente la famiglia dei precursori, individuando meglio in essa quelli da correlare con opportuni metodi di elaborazione dei segnali.

Quanto all'altra strada che inizialmente i previsori sismici, specialmente di scuola geologica, avevano tentato di battere, cioè il basarsi su eventuali regolarità spaziotemporali dell'attività sismica in una data regione (cosiddette ricorrenze sismiche) desumibili dallo studio dei dati storici (località, data e ora, intensità dell'evento) riportati nei cataloghi della sismicità regionale (ciò che impropriamente si chiamò statistica dei terremoti), essa si è rivelata presto impercorribile: i concetti e meno ancora i metodi della statistica non possono essere applicati tali e quali a eventi singolari e irripetibili identicamente quali sono i terremoti, anche in una medesima località.

Così, in attesa di qualche risultato di tipo definitivo fornito dalla fisica dei precursori sismici, la riduzione del rischio sismico (per la precisazione di questo rischio e per un più completo quadro delle questioni a esso relative, v. terremoto: Aspetti sociali e di protezione civile: previsione degli eventi e prevenzione dei danni, in questa Appendice) resta ancora affidata a provvedimenti di tipo passivo: principalmente, il rigido controllo dell'edificabilità in zone sismiche, fino ad arrivare al divieto di edificare e all'allontanamento definitivo della popolazione e delle attività preesistenti, e secondariamente, dove ciò non sia necessario o non sia possibile, il rifacimento o il consolidamento delle costruzioni.

Il problema delle previsioni meteorologiche. - Rinviando a meteorologia, in questa Appendice, per una compiuta esposizione degli aggiornamenti in tale settore della g., ci limiteremo a ricordare che un passo ritenuto decisivo fu compiuto quando, nei tardi anni Settanta, alle precedenti procedure di tipo analogico e, almeno in parte, soggettivo, fu sostituita una procedura, comune a tutti i Servizi meteorologici, basata su un modello matematico dei fenomeni atmosferici che condizionano il tempo meteorologico (un sistema di equazioni differenziali non lineari del secondo ordine alle derivate parziali, con un numero di coefficienti dell'ordine delle decine di migliaia), gestito da un elaboratore elettronico; la risoluzione numerica di tale sistema di equazioni, una volta introdotti in esso i necessari dati osservativi a un certo istante in un numero sufficientemente grande di punti al suolo e in quota (dati rappresentati dai detti coefficienti), consente, mediante complessi programmi di elaborazione elettronica, di determinare, anche con presentazione grafica, lo stato dell'atmosfera a un istante futuro e di disporre delle informazioni essenziali sui fenomeni meteorici futuri (nebbie, piogge, grandinate, uragani ecc., nonché elementi del vento e valori di pressione, temperatura e umidità dell'aria al suolo e in quota nei vari siti).

Apparve subito chiaro che il 'termine di previsione', cioè l'intervallo di tempo tra l'istante futuro cui riferire una previsione attendibile e l'istante attuale, era fortemente condizionato, a parità di altre condizioni, dall'ampiezza della zona di interesse e di quella, assai più estesa, della zona che deve essere coperta dai dati osservativi, estendentisi, questi ultimi, fino alla massima quota controllabile con radiosonde, cioè fino a circa 30 km. Così, per es., per attendibili previsioni a 12 ore relative all'Italia occorrono i dati rilevati nell'intera Europa, mentre già per le previsioni a medio termine di 2÷4 giorni la regione di osservazione deve estendersi all'intero emisfero boreale, e per una durata superiore va considerata l'intera superficie terrestre, oceani e calotte polari inclusi (comunque, un limite unanimemente ammesso per il medio termine è ora di 7÷10 giorni e deriva dallo stato attuale delle nostre conoscenze sulla dinamica dell'atmosfera); altre limitazioni di termine e di accuratezza derivano poi dall'aumento rapidamente crescente della complessità del modello matematico e dei programmi di elaborazione al crescere del termine, il che implica un parallelo aumento della potenza di calcolo occorrente.

Il miglioramento della qualità delle previsioni sembrava presentarsi pertanto come una questione legata essenzialmente all'ampliamento delle osservazioni e alla disponibilità di elaboratori di potenza crescente. In effetti, il constatato miglioramento delle previsioni in relazione all'introduzione dei rilevamenti meteorologici mediante satelliti, che consentì la copertura delle vaste zone altrimenti inaccessibili, e all'uso di elaboratori ad architettura parallela, di grande potenza di calcolo (a partire dal 1976, con i supercalcolatori Cray) sembrò convalidare questa opinione.

Tuttavia, un più attento esame portò a riconoscere che tale miglioramento non era dell'entità che si sarebbe dovuta avere in rapporto ai progressi delle osservazioni e dei mezzi di calcolo. Molti esperti del settore si sono pertanto formata un'opinione sensibilmente diversa, e cioè che il modello matematico di base abbia delle limitazioni intrinseche, legate all'uso in esso di rappresentazioni troppo semplificate di una realtà molto complessa.

In effetti, nello studio dei fenomeni meteorologici si sta superando la fase di prima approssimazione ed è allora ragionevole nutrire un certo scetticismo sul fatto che un modello matematico di atmosfera relativamente semplice come quelli in uso sia capace di rappresentare, a un grado di approssimazione superiore al primo, una realtà complessa come quella dei fenomeni dinamici dell'atmosfera interessati dalla previsione. Alla microscala, i protagonisti di tali fenomeni sono le singole molecole dei gas atmosferici, che si aggregano poi nei sistemi caratteristici della macroscala (masse d'aria, corpi nuvolosi, vortici ciclonici e anticiclonici ecc.); la trattazione tradizionale ha considerato e considera appunto i sistemi della macroscala, con evidente inadeguatezza se si pensa ai problemi atmosferici nella loro reale natura microscopica e caotica; d'altra parte, i metodi e gli algoritmi offerti attualmente dalla matematica, primi fra tutti quelli della meccanica statistica, appaiono inadeguati per affrontare questioni del genere. Un'efficace rappresentazione della natura caotica e probabilmente anche casuale dei fenomeni atmosferici, da attribuire all'americano E.N. Lorenz, uno specialista delle applicazioni di equazioni differenziali non lineari nel campo della dinamica meteorologica, è costituita dall'enunciazione (1993) del cosiddetto effetto farfalla, secondo il quale se una farfalla battesse le ali, poniamo, a Shanghai, potrebbe verificarsi in conseguenza, entro un certo tempo e con probabilità presumibilmente piccola ma di certo non nulla, l'abbattersi di un tornado sulle coste, poniamo, della Florida.

Non siamo in grado attualmente di matematizzare ciò e, pertanto, per un ulteriore salto di qualità delle previsioni meteorologiche a medio termine occorre presumibilmente attendere qualche consistente sviluppo sia della fluidodinamica non lineare sia della matematica dei sistemi caotici, alla cui recentissima nascita la tecnica delle previsioni medesime ha dato un non piccolo contributo.

Le conclusioni alle quali le considerazioni sui due esempi precedenti ci hanno condotto costituiscono, ancorché sviluppate in ambienti fisici e filosofici sensibilmente diversi, un ulteriore argomento, se ve ne fosse bisogno, per promuovere, in questa nostra epoca in cui problemi di seconda approssimazione appaiono sempre più frequentemente nell'orizzonte delle scienze della Terra, la globalizzazione di queste scienze, per arrivare a metodi di descrizione matematica dei fenomeni terrestri decisamente migliori di quelli di cui ora disponiamo.

bibliografia

J. Pedlosky, Geophysical fluid dynamics, New York 1979, 1987².

D.L. Anderson, Theory of the Earth, Boston 1989.

M.H. Rees, Physics and chemistry of the upper atmosphere, Cambridge 1989.

J.-P. Poirier, Introduction to the physics of the Earth's interior, Cambridge 1991.

J.P. Peixoto, A.H. Oort, Physics of climate, New York 1992.