Spazio, esplorazione dello

SPAZIO, ESPLORAZIONE DELLO

di Paolo Santini e Rolando Quadri, Benedetto Conforti

La conquista dello spazio di Paolo Santini

sommario: 1. Introduzione. 2. Storia delle conquiste spaziali. a) I precursori. b) I razzi. c) I satelliti artificiali. 3. I veicoli di lancio. a) Principi fondamentali. Configurazioni classiche. b) Produzione della spinta. c) Dinamica del missile. 4. La tecnica orbitale. a) Principali fenomeni orbitali. b) Previsioni orbitali. c)Manovre orbitali; cambiamento di orbita. d) Restituzione orbitale. e) I sistemi dei satelliti artificiali. f) Strutture e materiali. g) Applicazioni dei satelliti artificiali. 5. L'esplorazione dello spazio. a) Dinamica dei voli interplanetari. b) I sistemi dei veicoli spaziali. c) L'esplorazione del sistema solare. 6. Il volo umano nello spazio. a) lI pre-Apollo. b) Il progetto Apollo. c) Il post-Apollo. d) Lo Shuttle. e) iI futuro. □ Bibliografia.

1. Introduzione

L'attività spaziale ha meno di venticinque anni di vita, eppure i progressi fatti in questo campo non hanno riscontro, probabilmente, in nessun altro settore tecnico-scientifico. Il tasso di innovazione della tecnologia dello spazio è decisamente più elevato di quello di ogni altra tecnologia moderna di avanguardia, al punto che le cose dette o scritte oggi al riguardo potranno sembrare sorpassate tra pochi anni, o addirittura tra pochi mesi.

L'attività spaziale, i piani ad essa connessi, le realizzazioni concrete hanno colpito e colpiscono ancora così profondamente l'opinione pubblica di un mondo, come quello moderno, dedito alla ricerca insaziabile di nuove conquiste e di nuove frontiere, che ne è derivata una serie di iniziative editoriali e culturali; così si è sviluppata una letteratura fantascientifica, un giornalismo spaziale (o aerospaziale), una serie di convegni, di relazioni, di proposte, che aumentano anch'essi a un ritmo vertiginoso.

L'attività spaziale comprende la missilistica e l'esplorazione spaziale, due campi abbastanza nettamente separati sul piano culturale, metodologico e tecnologico, tenuti insieme dalla circostanza che la possibilità del secondo è nettamente subordinata alla disponibilità del primo. La stessa esplorazione spaziale, poi, assume caratteristiche e contorni nettamente diversi, a seconda che si tratti di ‛esplorare' mediante satelliti artificiali, o mediante sonde spaziali. Sono diversi, nei due casi, l'ambiente di lavoro, le tecnologie, gli apparati scientifici. Queste circostanze fanno sì che le trattazioni dei singoli campi vadano tenute separate, anche se, invece, lo sviluppo storico delle conquiste spaziali si svolge con una sostanziale continuità di eventi.

2. Storia delle conquiste spaziali

a) I precursori

Si può far risalire l'origine della storia delle imprese spaziali all'inizio del XX secolo. Fra coloro che posero le basi scientifiche del volo spaziale i più famosi sono il russo Ciolkovskij, l'americano Goddard e il tedesco romeno Oberth (v. Buedeler, 1979).

K. E. Ciolkovskij, giunto con notevole ritardo all'insegnamento medio, si occupò di molti problemi connessi con l'aeronautica in generale e, in particolare, fin dal 1893, del tema del movimento per reazione dei veicoli aerospaziali. Nel 1903, nel celebre lavoro Ricerche sugli spazi cosmici per mezzo di apparati a reazione, egli formulò la teoria dinamica del razzo a massa variabile e dimostrò anche la possibilità di raggiungere gli spazi interplanetari per mezzo di tali apparati; in questo lavoro, e in altri successivi, vengono calcolati scientificamente i consumi, le accelerazioni, le traiettorie dei veicoli di lancio e di quelli orbitali, le temperature, le condizioni ambientali. Una notevole parte del lavoro è dedicata allo studio degli effetti della microgravità, o assenza di peso, sull'organismo umano: è questa, si può dire, la prima opera di medicina aerospaziale, tema su cui Ciolkowskij aveva meditato e fatto esperienze in gioventù. Tra le altre opere di Ciolkowskij va ricordata Al di fuori della Terra, in cui è descritto nei particolari un possibile viaggio spaziale fino alla Luna e a Marte, e in cui viene, per la prima volta, lanciata l'idea delle colonie spaziali. Per i mezzi di propulsione, Ciolkowskij accenna alle possibilità di uso del cluster di razzi (molti razzi disposti in parallelo), configurazione poi effettivamente realizzata nei più grossi vettori moderni.

L'americano R. H. Goddard può, bene a diritto, essere considerato il padre della missilistica. Passato dai sogni dell'infanzia alla cattedra universitaria, prima alla Clark University, poi a Princeton, Goddard formulò per primo le leggi che regolano la termodinamica della propulsione a razzo, la relazione tra temperatura di combustione e spinta, la distribuzione delle pressioni in camera di combustione, e discusse scientificamente la possibilità di raggiungere corpi celesti. Nel 1926, dopo vari tentativi, Goddard riuscì finalmente a sperimentare con successo tre razzi, ciascuno del peso di 2,7 kg, con 2 kg di propellente. I razzi volavano a velocità dell'ordine di 100 km/h su una distanza di 50 metri, raggiungendo una altezza massima di 12,5 m. Seguirono successivi perfezionamenti (compreso anche un primo esemplare di sistema di controllo), che portarono a traiettorie sempre più ambiziose e sofisticate. Goddard va ricordato anche come realizzatore del bazooka, celebre razzo tattico in dotazione all'esercito degli Stati Uniti.

Ma è forse H. Oberth quello cui spetta il titolo di padre dell'astronautica. Nato nel 1894 - e tuttora vivente - egli pubblicò nel 1923 il suo lavoro più celebre: Die Rakete zu den Planetenräumen. Nella prima parte del lavoro vengono descritti, con assoluto rigore scientifico, i principi del volo spaziale e le grandezze relative: fondamentale, tra l'altro, la chiara esposizione del principio della suddivisione in stadi, rintracciabile peraltro anche nelle opere di Ciolkowskij, al punto che non è possibile risolvere le questioni di priorità. Stupefacenti sono la previsione dei tipi di combustibile e la discussione dei fenomeni di microgravità connessi con il volo spaziale. La seconda parte ha carattere più spiccatamente pratico e ha lo scopo di mostrare le effettive possibilità di realizzazione del principio esposto da Oberth. Nella terza parte vengono infine discusse le possibili applicazioni del volo spaziale, ed è sorprendente la previsione di Oberth dei satelliti per telecomunicazioni (almeno per il principio di funzionamento) e delle grandi stazioni spaziali. Oberth va anche ricordato come consulente tecnico del primissimo film di fantascienza realizzato dall'UFA nel 1929: Una donna sulla Luna.

b) I razzi

La storia dei razzi comincia nell'XI secolo, in Cina, nazione che ha, anche recentemente, rivendicato questa paternità. Un antico documento ricorda infatti un tipo di razzo lanciato a mano per scopi essenzialmente militari. Veri e propri razzi sembrano, invece, quelli contenuti nella descrizione del combattimento sotto le mura della città di Kaifung-hu, che si difendeva dall'assalto dei Mongoli per mezzo di ‛lance di fuoco volanti': la descrizione dell'arma non lascia dubbi in proposito. Resta piuttosto aperta la questione, invece, se il razzo sia stato proprio inventato in Cina, o, come qualche storico sostiene, sia invece stato importato dall'Europa e poi ivi riesportato. Sta di fatto che in Europa il razzo era usato, per scopi bellici, nei secoli XIII-XV; poi, per un paio di secoli, esso cadde in disuso, per riapparire, sempre in ambito militare, nei secoli XVIII-XIX. Ma solo dopo la prima guerra mondiale il razzo cominciò a essere intensamente studiato. F. von Opel, nel 1928, pensò di applicare la propulsione a razzo alle automobili; ebbe come collaboratore (poi rivale) M. Valier, che aveva invece progettato un aeroplano con propulsione a razzo (v. Buedeler, 1979). I tentativi di von Opel furono coronati da successo tecnico, ma l'idea venne presto abbandonata, a causa del proibitivo consumo del razzo, alle velocità tipiche del traffico terrestre, consumo legato a sua volta al bassissimo rendimento propulsivo a quelle velocità.

Ma il più grande impulso alla missilistica tedesca doveva provenire dall'ambiente militare. I razzi non figuravano tra le armi vietate dal trattato di pace e questo indusse lo Stato Maggiore a costituire un primo nucleo di tecnici incaricati del loro sviluppo, che ebbe la sede a Kummersdorf, vicino a Berlino, nel 1929. Tra i componenti va ricordato il capitano ingegnere W. Domberger, che, nel 1931, assunse il non ancora ventenne e non ancora laureato W. von Braun. Questi ebbe l'incarico di studiare i razzi ‛a flusso continuo', ossia a liquido, contrapposti a quelli ‛a polvere', ossia a solido. Gli esperimenti iniziarono a Kummersdorf col piccolo razzo Ofen, da 20 t di spinta, da portare a 350. Iniziò così la serie di razzi designata dalla sigla A (Aggregat): l'A1 e l'A2, piuttosto piccoli, i cui lanci furono coronati da successo, raggiunsero quote dell'ordine dei 200 m. Il successivo razzo, l'A3, fu il precursore della V2 e segnò il trapasso all'effettivo impiego dei razzi di grosse dimensioni.

Intanto Kummersdorf era divenuta inadeguata: era necessaria una sede di maggiore estensione, lontana per quanto possibile dai centri abitati, con vie di accesso sufficienti. Si dice che la località sia stata suggerita a von Braun dalla madre: l'isoletta di Peenemünde, sul Baltico, dove il padre dello stesso von Braun si era spesso recato a caccia di folaghe.

Da quel momento nasce il mito di Peenemünde, con von Braun e Domberger strettamente legati e protagonisti dell'impresa. Nel frattempo erano state effettuate le prime quattro prove dell'A3, che costituirono altrettanti insuccessi; allora a Peenemünde si decise di puntare su una versione dello stesso razzo più adatta a scopi pratici (l'A3 era essenzialmente sperimentale). Impossibile seguire passo passo lo sviluppo del razzo, da cui doveva derivare la V2 e che effettuò il primo volo il 3 ottobre 1942, volo coronato da successo e con le seguenti caratteristiche: velocità massima 1.500 m/s, distanza di lancio 200 km, altezza 90 km. Contemporaneamente, a Peenemünde, veniva sviluppato un sistema di bomba volante, l'F 103, che sarebbe poi divenuta la V1 (Vergeltungswaffe 1 = arma di rappresaglia 1). Il debutto militare della V1 (che applicava il principio della pulsoreazione, in cui la combustione avviene a spese dell'aria atmosferica, e che non poteva, quindi, raggiungere quote troppo elevate) avvenne il 13 giugno 1 944. Le V1 ebbero un forte impatto psicologico sull'opinione pubblica in Inghilterra, la nazione su cui le bombe erano dirette. I bombardamenti con le V1 durarono fino al settembre 1944; dopo pochi giorni di interruzione, l'offensiva tedesca riprese, stavolta con le V2, o A4, di cui furono lanciate su Londra circa 11 .000 esemplari: l'ultima il 27 marzo 1945.

Nel frattempo a Peenemünde, sull'ondata dell'entusiasmo provocato dal successo delle V2, si sviluppavano progetti sempre più ambiziosi, come quello dell'A10, il razzo che sarebbe stato ribattezzato Amerika e che non volò mai, come non volarono mai tutti gli altri A.

Comunque, poche settimane prima della resa della Germania, la maggior parte degli impianti di Peenemünde fu trasportata in tutta fretta a Nordhausen. I sovietici, entrati a Peenemünde nel maggio 1945, non trovarono che poche attrezzature e circa un quarto dei tecnici, che costituirono, peraltro, il ‛nucleo tedesco' della missilistica sovietica.

Ben più numeroso fu il gruppo di von Braun, che, invece, si recò negli Stati Uniti, e ivi continuò l'opera iniziata.

Negli Stati Uniti la missilistica aveva avuto, come si è già visto, un grande pioniere in Goddard, ma uno sviluppo pratico assai modesto, nemmeno lontanamente paragonabile a quello tedesco. Il primo esemplare di razzo praticamente utilizzabile fu il Corporal, nel 1947, seguito ben presto da un altro esemplare, l'Aerobee, destinato a scopi essenzialmente scientifici e usato come razzo sonda per ottenere dati sempre più attendibili sulle grandezze fisiche dell'alta atmosfera. L'Aerobee fu un notevole successo ed ebbe anche applicazioni militari. A questo punto, l'entrata in scena di von Braun e degli altri tecnici tedeschi dette grande impulso alla missilistica americana. Al centro di Huntsville, in Alabama, fu realizzato per l'esercito il missile Redstone, caratterizzato da una estrema affidabilità, al punto da meritare, alcuni anni più tardi, il nomignolo di Old Reliable, ‛vecchio di fiducia'. Sebbene concepito per scopi militari, il Redstone, sotto l'incalzare dei successi sovietici, fu usato per il lancio dei due voli suborbitali che inaugurarono il programma statunitense di volo spaziale umano. Le caratteristiche del Redstone erano: peso al decollo 30 t, spinta al decollo 35 t, velocità a fine combustione 7.000 km/h; queste caratteristiche furono ottenute attraverso una serie di modifiche apportate alle prime versioni. Inimmaginabili, per il non esperto, le difficoltà che si dovettero superare per aumentare la lunghezza dei serbatoi di propellente di 1,80 m, allo scopo di allungare di 20 s il tempo di combustione. Nel frattempo si era sviluppata negli Stati Uniti una forte polemica tra le varie forze armate, la NACA (National Advisory Committee for Aeronautics), successivamente trasformata in NASA (National Aeronautics and Space Administration) e altri enti governativi, per la priorità delle scelte nel programma spaziale.

Il lancio dello Sputnik (v. tav. I), il 4 ottobre 1957, colse di sorpresa l'opinione pubblica mondiale, in particolare quella statunitense, e mise in luce il grave ritardo dell'attività spaziale americana rispetto a quella sovietica, mostrando soprattutto l'inadeguatezza del programma basato sul progetto Vanguard. Il razzo Vanguard (v. tav. I), derivato dai razzi sonda della marina americana, era stato prescelto nel 1955 come lanciatore del primo satellite statunitense; si trattò di una scelta assai infelice, come gli eventi poi dimostrarono. La questione principale era se convenisse adottare, per lanci orbitali, razzi derivati dai razzi sonda per ricerche di aeronomia (come appunto il Vanguard), oppure missili militari opportunamente modificati.

Il primo razzo Vanguard, il TV2, fu lanciato con successo in volo suborbitale nel 1957; il secondo esemplare, il TV3, esplose sulla rampa di lancio; due mesi più tardi il veicolo di riserva andò fuori traiettoria e fu distrutto alla quota di 5,8 km. Si andò avanti così per vari anni finché, nel 1962, il programma fu definitivamente cancellato. Il 2° e il 3° stadio, che avevano raggiunto un notevole grado di affidabilità, furono trasferiti al Thor e all'Atlas e il 3° stadio anche allo Scout.

Comunque, dopo lo Sputnik, Washington decise di rivolgersi a von Braun, che aveva da tempo proposto, inutilmente, di mettere in orbita piccoli carichi paganti (dell'ordine delle decine di kg). A quell'epoca il gruppo di Huntsville aveva sviluppato il razzo Juno I, un derivato a 4 stadi del tristadio Jupiter C, a sua volta derivato dal Redstone, che permise la realizzazione delle prime fasi del programma Explorer.

Dopo questi inizi così incerti, la missilistica statunitense ha proceduto con passo sempre più spedito verso realizzazioni sempre più prestigiose. Il largo spettro dei veicoli approntati negli Stati Uniti ha consentito alla NASA e al Dipartimento della Difesa di mettere in orbita carichi utili che vanno dai 9 kg alle 136 t del Saturno. Tra i più prestigiosi razzi americani vi è l'Atlas, capace di una spinta al decollo di 170 t. Fu impiegato un Atlas nella missione di John Glenn (20 febbraio 1962), il primo astronauta americano (v. Turnill, Spaceflight..., 1978). Vi furono dieci voli Atlas D nel progetto Mercury, il programma pionieristico statunitense di volo umano. L'Atlas è stato usato più di 400 volte in 25 programmi spaziali. L'Atlas 2E (un solo stadio) ha un'altezza complessiva di 20 metri dalla base alla sezione di attacco del carico utile ed è stato ottimizzato dal punto di vista strutturale, con un alleggerimento così pronunciato che il suo trasporto dai magazzini alla base di lancio comporta alcuni problemi legati alla sua integrità. L'Atlas è combinato con altri razzi, allo scopo di formare dei polistadi: in particolare l'Atlas-Agena e l'Atlas-Centaur, razzo bistadio ad alto potenziale, capace di porre fino a 1.800 kg in orbita geostazionaria. Così l'Agena D, lanciato come secondo stadio di un Atlas, fu usato come bersaglio di aggancio (docking) in alcuni voli del programma Gemini.

Uno dei ‛veterani' tra i missili statunitensi è il Thor, concepito inizialmente come IRBM (Intermediate Range Ballistic Missile, ‛missile balistico a medio raggio'); le sue più recenti versioni forniscono ora i veicoli di lancio più frequentemente usati, con spinte alla partenza dell'ordine delle 150 t.

Il Titan, sviluppato fin dagli anni sessanta, è attualmente il più potente veicolo di lancio americano. Il Titan 3E riesce a mettere in orbita sincrona fino a 3.500 kg. Il primo volo di prova avvenne nel 1974; col secondo volo, sempre nel 1974, il Titan mise in orbita con successo l'Helios, sonda solare della RFT; coi due voli successivi le sonde Viking verso Marte. La produzione e lo sviluppo di nuovi missili per usi spaziali (escluse quindi le applicazioni militari) ha subito un certo rallentamento con l'avvento dei boosters recuperabili (Shuttle).

Relativamente alla storia parallela della missilistica negli altri paesi, a guerra finita, mentre i tecnici di Peenemünde venivano dispersi, parte negli Stati Uniti, parte in Unione Sovietica, alcune nazioni europee svilupparono dei missili per scopi eminentemente militari. Tra queste, la Gran Bretagna, con il suo Blue Streak, che si rivelò ben presto un fallimento, soprattutto a causa delle enormi spese che esso richiedeva per una messa a punto completa. Si giunse così all'ottobre 1961, quando in una conferenza Europea a Londra fu proposta la fondazione dell'organizzazione ELDO (European Launcher Development Organization), che si sarebbe affiancata alla consorella ESRO (European Space Research Organization), destinata a realizzare il lanciatore europeo, basato appunto sul Blue Streak come primo stadio. La costituzione ufficiale dell'ELDO si ebbe nel 1964; i paesi membri erano Belgio, Francia, Germania, Gran Bretagna, Italia, Olanda, Australia. La presenza di quest'ultima era giustificata dalla prevista utilizzazione del poligono di lancio di Woomera, nella parte settentrionale dello Stato di Adelaide. L'accordo prevedeva, sul piano finanziario, una partecipazione delle varie nazioni a percentuale non uniforme e in cambio di questa partecipazione un certo numero di commesse di lavoro a industrie dei singoli Stati con percentuali più o meno equivalenti a quelle di spesa. In realtà furono effettuate notevoli discriminazioni; egoismi e rivalità non solo nazionali aggravarono il quadro politico, organizzativo ed esecutivo. Fu dapprima progettato il razzo Europa 1 (2° stadio Coralis, Francia; 3° stadio Astris, Germania; satellite di prova, Italia). Il primo lancio, effettuato nel 1970, fu un completo insuccesso, per la mancata espulsione dei fairings e la perdita di spinta nel 3° stadio. In seguito a tale insuccesso, la Gran Bretagna (che pure aveva promosso l'impresa) si ritirò; le altre nazioni, su impulso soprattutto della Francia, decisero di continuare il programma e anzi di potenziarlo; infatti il progetto Europa 2 prevedeva anche un 4° stadio (essenzialmente un motore di apogeo), con una capacità complessiva di 200 kg utili in orbita geostazionaria. L'obiettivo era di lanciare due satelliti Symphonie franco-tedeschi nel biennio 1973-1974. Tuttavia, anche il secondo lancio (dal poligono equatoriale francese della Guyana) finì in un disastro. Il razzo Europa 3 era già in viaggio verso il poligono (a bordo di una nave) quando, nel 1973, il progetto fu abbandonato e fu costituita l'ESA (Furopean Space Agency). Uno dei primi progetti approvati dall'ESA fu lo sviluppo di un veicolo di lancio europeo capace di 800 kg geostazionari, da rendere operativo per gli anni ottanta. Fu in particolare la Francia a insistere per l'accettazione del programma Ariane (dal nome del lanciatore europeo), sostenendo la necessità che l'Europa possedesse propri vettori per lanciare satelliti applicativi, senza dover dipendere dagli Stati Uniti.

L'Ariane (v. tav. II) è un veicolo a tre stadi, con un peso di 200 t, lunghezza 48 m e diametro di 3,8 m. Il primo stadio, derivante direttamente dal primo stadio dell'Europa 3, con propellente liquido convenzionale (perossido di azoto + dimetilidrazina asimmetrica), ha quattro razzi Viking, per una spinta totale di 240 t, della durata di 140 s; il secondo stadio sviluppa 70 t di spinta per 131 5, mentre il terzo stadio (H2 + O2 liquidi) sviluppa 7 t di spinta per 10 s.

Il primo volo di prova dell'Ariane, nel dicembre 1979, fu coronato da successo, mentre il secondo (maggio 1980) fallì, a causa di problemi derivanti da instabilità di combustione del secondo stadio, che causarono vibrazioni ad altissima frequenza e conseguenti elevati sovraccarichi dinamici. Il terzo volo (20 giugno 1981) fu un completo successo: l'Ariane riuscì a porre in orbita tre satelliti di prova (due europei e uno indiano). Sembrava a questo punto che l'Ariane potesse considerarsi del tutto operativo; ma un ulteriore lancio, effettuato nel settembre 1982, si risolse in un insuccesso, legato alla cattiva accensione del terzo stadio. Andarono distrutti, tra l'altro, due satelliti di prova, uno dei quali, il Sino II, italiano. Tutto quindi veniva rimesso in discussione.

Si hanno scarsissime informazioni sulle realizzazioni sovietiche in campo missilistico; realizzazioni che debbono peraltro essere imponenti, a giudicare dai risultati raggiunti. Gli esperti occidentali hanno identificato alcuni veicoli base, di cui particolarmente interessante appare quello destinato al lancio delle Soyuz. Non è possibile fornire dati precisi al riguardo: si ritiene che il lanciatore Soyuz possa porre in orbita bassa fino a 7.500 kg e 1.100 kg in orbita geostazionaria. Il più grande missile sovietico è probabilmente quello destinato al lancio dello Zonda; questo missile ha la stessa configurazione del lanciatore Soyuz, ma è assai più potente (22.000 e 1.600 kg).

c) I satelliti artificiali.

Il 30 settembre 1957 scienziati di sette nazioni erano riuniti a Washington, per preparare i lavori dell'anno geofisico internazionale. A un certo punto, il delegato sovietico, S. Poloskow, parlando, pronunciò la parola sputnik (‛compagno di viaggio'), ma quasi nessuno ci fece caso. Dopo quattro giorni, il 4 ottobre, durante un ricevimento all'ambasciata sovietica, il giornalista del New York Times, W. Sullivan, fu chiamato al telefono dalla sua redazione, che gli comunicò la messa in orbita della prima sonda sovietica: lo Sputnik.

La notizia destò grande sensazione, ed ebbe ripercussioni all'8° Congresso Internazionale di Astronautica, che si riuniva a Barcellona due giorni dopo il lancio, non tanto perché ci si aspettassero risultati scientifici eccezionali, quanto perché i sovietici dimostravano così di essere avanti a tutti gli altri, Stati Uniti compresi, nella corsa allo spazio, con le inevitabili implicazioni di carattere politico e militare (v. Buedeler, 1979). Lo Sputnik era stato lanciato probabilmente con un vettore standard da circa 500 t di spinta al decollo; la sua orbita era ellittica, con perigeo di 228 km e apogeo di 947; l'inclinazione, di 65°, andava messa in relazione alla latitudine del poligono di lancio. Strutturalmente si trattava di una sfera metallica del diametro di 0,58 m provvista di quattro antenne lunghe da 1,5 a 2,9 m.

Lo Sputnik (poi denominato Sputnik 1) aveva una strumentazione capace di misurare le proprietà fisiche dell'alta atmosfera, in particolare densità, temperatura e densità di particelle, e, ovviamente, un apparato telemetrico che gli consentì di trasmettere a terra i dati per 21 giorni; la sua vita orbitale invece durò più di tre mesi.

Il lancio dello Sputnik colse di sorpresa gli americani, che tentarono di riguadagnare il terreno perduto. Ma intanto i sovietici riuscivano a compiere un'altra impresa sensazionale con il lancio dello Sputnik 2, che portava a bordo la cagnetta Laika, la prima vittima dell'attività spaziale. Lo scopo dell'esperimento era soprattutto lo studio degli effetti dell'assenza di peso sugli organismi viventi; la trasmissione dei dati durò 7 giorni, fino alla morte di Laika. La serie Sputnik dei satelliti sovietici continuò fino al n. 10, lanciato nel 1961.

Il motivo del ritardo statunitense fu individuato nell'aver puntato sul programma Vanguard, di cui si è già parlato, rifiutando le proposte del gruppo von Braun. Ma dopo lo Sputnik 2 fu dato all'ABMA (l'ente dell'esercito da cui von Braun dipendeva) il go ahead (‛procedete'), con un programma che prevedeva il lancio di due satelliti per il 30 gennaio 1958. La lotta e le rivalità tra i due gruppi, quello dell'ABMA e quello del Vanguard, continuarono anche sulla rampa di lancio. Il 29 e il 30 gennaio le condizioni del tempo sconsigliarono il lancio dell'Explorer I (il veicolo di von Braun) e al team di lancio fu concesso un solo giorno di proroga, dopo di che la rampa avrebbe dovuto essere liberata per far posto al satellite Vanguard.

Finalmente, in condizioni meterologiche migliori, fu possibile il lancio alle 22 e 48 del 31 gennaio 1958. Un'ondata di entusiasmo attraversò gli Stati Uniti alla notizia che il lancio era perfettamente riuscito e che il primo satellite americano, il terzo nel mondo, era finalmente in orbita. A differenza dello Sputnik 1, e nonostante il peso estremamente ridotto (di soli 14 kg), l'Explorer I raccolse dati di grande interesse scientifico, riguardanti i raggi cosmici, le meteoriti e la temperatura degli strati superiori dell'atmosfera. In particolare, molto interessanti si rivelarono i dati sulle micrometeoriti, che erano state sempre considerate un grosso pericolo per l'integrità strutturale dei veicoli spaziali e sulle quali erano state avanzate le più svariate congetture. Ma la più importante scoperta dell'Explorer 1, che percorreva un'orbita di 360 × 2.532 km, con un'indinazione di 65°, fu la conferma sperimentale dell'esistenza delle cosiddette ‛fasce di Van Allen', formate da particelle cariche emesse dal Sole e intrappolate dal campo magnetico terrestre, così da formare delle vere e proprie cinture attorno alla Terra. Queste fasce erano state predette teoricamente appunto da Van Allen, ma solo con l'avvento della tecnica spaziale si ebbe la certezza della loro presenza a una quota valutata di circa 10.000 km al di sopra della superficie terrestre. L'Explorer 1 ebbe vita attiva assai breve (circa 4 mesi) e vita orbitale, invece, assai lunga (circa 12 anni).

La storia degli altri tipi di satelliti artificiali è strettamente connessa con la loro tecnologia, perciò viene rinviata al cap. 5, che tratta dell'evoluzione, anche tecnica, dei programmi di esplorazione spaziale.

3. I veicoli di lancio

a) Principi fondamentali. Configurazioni classiche

Come si è detto, e come è ovvio, qualunque forma di attività spaziale è possibile solo a patto di possedere degli efficienti veicoli di lancio. È questo un fattore di vitale importanza sia dal punto di vista tecnico che da quello politico-economico, in quanto solo chi è indipendente sul piano del vettore di lancio può poi utilizzare i proventi - sotto qualunque forma - dello spazio, in misura altrettanto indipendente.

I veicoli di lancio, o missili, hanno lo scopo di imprimere a un ‛carico pagante', che si trova inizialmente a riposo sulla superficie terrestre in un punto A, una spinta tale da fargli raggiungere una velocità v (da valutare in intensità e in direzione) in un punto assegnato H (v. fig. 1). Si tratta quindi di un problema di meccanica, che peraltro differisce notevolmente da quelli classici, in quanto sono assegnati i valori iniziali e finali della velocità e della posizione e si tratta di effettuare una scelta, ossia di dosare le forze che debbono portare il carico utile dallo stato A allo stato B. Per questo motivo, un missile deve possedere organi di ‛propulsione' e organi di ‛guida e controllo'.

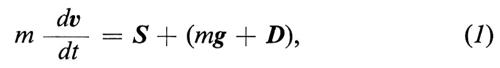

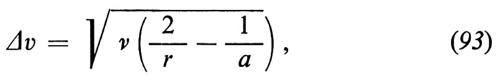

Come è noto, i moderni sistemi di propulsione utilizzano il principio di reazione. In base ad esso (v. fig. 2), se la massa del corpo è m(t) e se la velocità del gas di scarico relativa al corpo (nella fattispecie il missile) è vr l'equazione del moto si scrive

dove, detta a la massa del gas espulso,

S = μ• vr (2)

è la spinta prodotta dall'effiusso del gas e

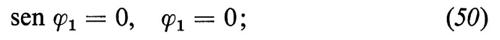

D= D(v, t) (3)

è la risultante delle forze esterne (peso escluso) che agiscono sul missile, per esempio la resistenza aerodinamica.

Consideriamo, come caso particolare, la salita di un missile lungo la verticale e trascuriamo per il momento le forze mg e D. Indicando con v e vr i valori scalari di v e di vr, che hanno direzione opposta, e tenendo presente che è μ• = − í, la (1) si scrive

mv• − ívr, (4)

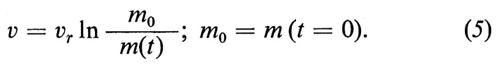

Separando le variabili e integrando dall'istante t = 0 (inizio del volo) all'istante generico t, si ha

Particolare interesse riveste la ‛velocità di fine combustione', vf, ossia quella acquisita quando tutto il propellente disponibile è consumato. Si ha, dalla (5),

vf = vr ln ρ, (6)

dove

ρ = m0/mf (7)

è il ‛rapporto di massa'. Velocità di efflusso dei prodotti della combustione e rapporto di massa sono, quindi, i due parametri fondamentali che regolano la velocità finale (6) acquisita dal missile.

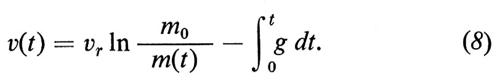

Se si suppone ora di trascurare D, ma non mg, si ottiene, al posto della (5), la seguente:

L'integrale che figura nella (8) prende il nome di ‛perdita gravitazionale'. Per la sua valutazione corretta, occorre riflettere che, poiché l'accelerazione di gravità è variabile con le coordinate geografiche, in particolare con la quota, sarebbe necessario conoscere già la legge del moto. Scriviamo comunque

dt = dm/í = − dm/μ•. (9)

La portata dei gas effluenti, ossia μ•, è un indice della potenzialità del missile. Possiamo dare una maggiore evidenza al ragionamento introducendo il parametro adimensionale

ν = (μ• vr)/gm0, (10)

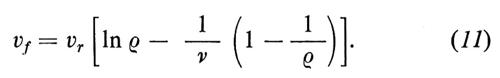

che definisce (in multipli di g) l'accelerazione che il motore è capace di imprimere a una massa pari a quella del razzo alla partenza. Trascurando le variazioni del rapporto μ•/g, anche in vista del valore generalmente piccolo delle perdite gravitazionali, si ha dunque finalmente dalla (8), per t = tf,

Dalle formule precedenti appare evidente il ruolo fondamentale del rapporto di massa al fine di raggiungere elevate velocità di fine combustione. In particolare si nota che, per ρ → ∞, si avrebbe un aumento di velocità infinito. Questo risultato, sebbene basato su una situazione del tutto irrealizzabile (massa finale nulla), indica la via da seguire per ottenere, ceteris paribus, prestazioni quanto più elevate possibili.

A tal fine, affrontiamo il problema più generale pensando, in modo assai schematico, che il missile sia costituito da tre parti: il carico utile, di massa U, il propellente, di massa P, la struttura, di massa S. Si ha allora la massa iniziale m0 = U + P + S e la massa finale U + S; quindi il rapporto ρ vale

ρ = 1 + P/(U + S). (12)

È quindi evidente che si ha tutto l'interesse a ridurre al minimo il peso della struttura in confronto al peso del propellente, per un carico utile assegnato. Ora è intuitivo che ogni chilogrammo di propellente esige un certo numero di chilogrammi di struttura per essere sostenuto e poter così esplicare la sua funzione. Alla luce di queste considerazioni, si capisce come un missile monostadio rappresenti una soluzione poco soddisfacente, in quanto il peso strutturale è lo stesso al principio della combustione (quando cioè è tutto necessario) e alla fine (quando cioè è quasi tutto superfluo: ‛quasi' tutto, perché va ancora sostenuto il carico utile).

Per esaminare meglio la questione, consideriamo un caso ancora del tutto teorico e irrealizzabile, ma estremamente illuminante. Supponiamo che, per il corretto funzionamento del missile, siano necessari β kg di struttura eliminabile per ogni chilogrammo di propellente (β potrà essere calcolato o stimato su base empirica) e supponiamo che a ogni istante venga abbandonata la frazione di struttura che non è più necessaria; si realizza così il missile ad ‛alleggerimento continuo'. In un tale caso, pensando di poter ancora trascurare mg e D nella (1) e ponendo correttamente í = − (1 + β) μ• , si avrà, in luogo della (4), la

mv• = − ívr/(1 + β). (13)

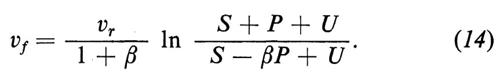

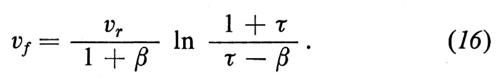

Integrando si ha, analogamente, al posto della (6),

Nella (14) S è la massa strutturale all'inizio della fase propulsa, alla fine della quale essa è ridotta al valore S − βP.

Posto ancora

τ = (S + U)/P, (15)

con τ > β, la (14) fornisce

La (16) è rappresentata nel diagramma della fig. 3, dal quale appare evidente il vantaggio che si ha con l'aumento di β.

Come si è detto, il caso ora trattato è estremamente teorico. Si cerca di avvicinarsi, per quanto possibile, a questo schema, procedendo anziché a un alleggerimento continuo - a una suddivisione in stadi, ciò che corrisponde ad approssimare il diagramma continuo con la spezzata della fig. 4: a ogni ‛stadio' si espelle la struttura dello stadio esaurito. La determinazione, ossia l'‛ottimizzazione', del missile è uno dei compiti più importanti dell'ingegnere missilista, e la sua trattazione esula largamente dai nostri scopi. Quanto detto giustifica peraltro la classica configurazione dei veicoli di lancio in stadi.

La fig. 5 mostra schematicamente un missile tristadio a propellente liquido. Vi si notano: il primo stadio, con i serbatoi e gli ugelli di propulsione; l'elemento di separazione tra il primo e il secondo stadio; il secondo stadio, che ripete, in dimensioni generalmente minori, lo schema del primo; l'interstadio 2-3; il terzo stadio, pure simile ai primi due; l'alloggiamento del carico utile - il satellite artificiale o la sonda spaziale - con gli scudi termici, di forma e dimensioni variabili a seconda del carico utile. E necessario ricordare che uno stesso tipo di veicolo di lancio serve a mettere in orbita, o comunque a lanciare, carichi utili assai diversi per forma e dimensioni; quindi il vano relativo e gli scudi termici vanno di volta in volta progettati e adattati al missile. Nel caso di propellente solido, i serbatoi di propellente sono sostituiti dal ‛grano', di varia forma e sezione. Gli scudi termici servono a proteggere dal forte riscaldamento cinetico, che si ha durante l'attraversamento degli strati atmosferici, le delicate apparecchiature elettroniche del carico e l'eventuale equipaggio. Poiché il flusso termico prodotto è circa proporzionale a ρmV3 (dove ρ è la densità atmosferica, V la velocità, m ≃ 0,5), il massimo flusso non si ha negli strati dove è massima ρ (cioè al suolo), ma molto più alto (dove prevale l'effetto della velocità). Pertanto gli scudi termici vengono abbandonati, di solito, verso la fine della combustione del secondo stadio. La forma degli scudi è generalmente ‛a bulbo' (con spessore adeguato per assorbire il calore entrante senza un eccessivo aumento di temperatura), aperto lungo due o più generatrici, per permetterne lo sganciamento, In un missile della classe Atlas o Titan, di circa 200 t di peso al decollo, con carico utile di 1.600 kg, il peso degli scudi termici è di circa 800 kg.

b) Produzione della spinta

Nelle formule precedenti figura, come parametro di importanza fondamentale, la velocità di efflusso vr dei prodotti della combustione. Vediamo ora a quali altre grandezze essa a sua volta risulta collegata.

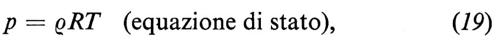

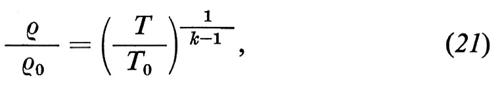

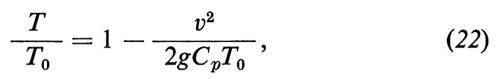

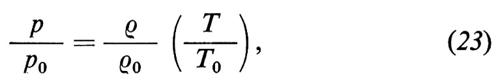

La fig. 6 mostra un condotto a sezione variabile A = A(x) sufficientemente piccola perché il moto del fluido al suo interno possa ritenersi praticamente unidimensionale. Nella sezione 0 (camera di combustione) il fluido ha velocità praticamente nulla, temperatura T0 e pressione p0; esso effiuisce poi lungo il condotto e le sue variabili di Stato (velocità v, pressione p, densità ρ, temperatura T) subiscono un'evoluzione; data la grande rapidità del fenomeno, si può ritenere che la trasformazione sia praticamente adiabatica. Le leggi del fenomeno sono le seguenti:

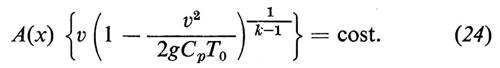

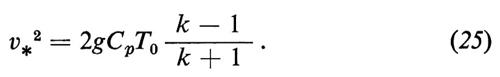

dove Cp è il calore specifico a pressione costante, k è il rapporto Cp/Cv, con Cv calore specifico a volume costante, ed R è la costante dei gas, legata alla costante universale R′ e al peso molecolare M dalla R = R′/M. Combinando opportunamente le equazioni precedenti, si può scrivere

Il fattore entro parentesi graffa nella (24) è composto di due termini, uno crescente e l'altro decrescente con v; fisicamente ciò significa che l'aumento di velocità da una parte favorisce una portata elevata e dall'altra, per effetto della forte espansione ad esso associata, dà luogo a una notevole riduzione della densità. Come sempre avviene quando agiscono due fattori contrastanti, si ha un massimo per un determinato valore di v che si trova derivando il termine rispetto a v e annullando la derivata. Si ottiene così il valore della velocità corrispondente:

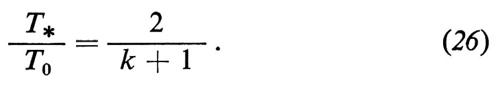

Pertanto dalla (22) si ricava

Combinando la (25) e la (26) si ha

v²* = gCpT*(k − 1) = gkRT* (R = Cp − Cv). (27)

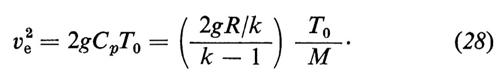

Questa espressione fornisce il classico valore della velocità del suono. Si ha così l'importantissimo risultato che il massimo del fattore in parola, e, quindi, il minimo di A(x) (sezione contratta), si ha in corrispondenza della velocità del suono. Successivamente continua l'espansione nella zona divergente del condotto, fino alla sezione terminale dell'ugello, dove la pressione pe è quella dell'ambiente esterno e dove quindi tutte le quantità risultano facilmente calcolabili. In particolare, poiché la pressione pe è assai bassa, è possibile trascurare, nella (22), il termine Te/T0 (dove Te è la temperatura nella sezione di uscita) e ottenere quindi la velocità di effiusso dalla

La velocità di efflusso al quadrato risulta quindi proporzionale al rapporto T0/M: si avrebbe quindi tutto l'interesse ad aumentare al massimo la temperatura di combustione, se non ostassero gravi problemi connessi con il raffreddamento e le sollecitazioni termiche e strutturali delle pareti dell'ugello, il quale ha la forma tipica mostrata nella fig. 6 (convergente-divergente).

Come si è già detto, la propulsione del missile è un esempio di propulsione a reazione. Il motore del missile prende il nome di ‛endoreattore', in quanto i prodotti della combustione provengono da una reazione che si manifesta all'interno del missile stesso. Invece, ad esempio, i reattori utilizzati nel velivolo a getto appartengono alla classe degli ‛esoreattori', in quanto uno dei reagenti (nella fattispecie l'aria) è esterno al sistema.

I razzi vengono classificati a seconda dei mezzi con cui viene generato il getto gassoso. Si hanno così razzi chimici, razzi nucleari e razzi con sistemi di propulsione elettrica. Questi ultimi due tipi sono usati prevalentemente per le applicazioni spaziali.

Nei razzi chimici, che sono di tipo tradizionale, il getto viene prodotto da una reazione chimica ad elevata temperatura T0; come si è visto, se il peso molecolare è M, l'energia cinetica ve2/2g dell'unità di massa espulsa è proporzionale a T0/M e la quantità ve, corretta mediante opportuni fattori, è la velocità caratteristica della reazione. In condizioni ideali, se si bruciano gí kg/s, l'impulso prodotto vale íve e pertanto si ha un impulso specifico ve/g, corrispondente a quello prodotto da 1 kg/s.

L'impulso specifico di un sistema di propellente è quindi determinato esclusivamente dalla temperatura della reazione.

I razzi chimici si dividono in due grandi categorie a seconda che il propellente sia liquido o solido; la differenza è radicale non solo per ciò che riguarda il sistema di propulsione, ma anche per l'architettura generale del veicolo e per i problemi dinamici relativi.

I propellenti liquidi possono essere monopropellenti e bipropellenti. Mla prima classe appartengono propellenti contenenti un agente ossidante e una materia combustibile, in una sostanza unica, che può essere una miscela di parecchi composti, oppure un materiale omogeneo (nitrometano e idrazina). L'inconveniente principale è la loro instabilità a temperatura elevata, il che porta alla decomposizione; è evidente peraltro la maggiore semplicità delle linee dei circuiti di alimentazione. I monopropellenti trovano impiego pratico solo nei piccoli razzi di controllo.

I bipropellenti sono costituiti da due diverse sostanze, contenute in serbatoi separati, che sono mescolate solo in camera di combustione. Ai propellenti liquidi veri e propri si aggiungono speciali sostanze catalizzatrici e acqua di raffreddamento.

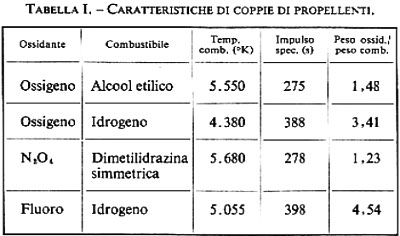

Nella tab. I sono riportate le temperature di combustione e gli impulsi specifici di alcune coppie tipiche. Si vede come gli impulsi specifici siano centrati sul valore di 280 s, con cifre nettamente superiori per i propellenti ‛criogenici', come O2 liquido e H2 liquido, che presentano peraltro gravi inconvenienti di stabilità e vanno soggetti a perdite per vaporizzazione.

I propellenti liquidi si confrontano sulla base delle caratteristiche di efficienza, che si esprimono con i valori numerici dell'impulso specifico (e/o della velocità caratteristica); è evidente la convenienza di avere un basso peso molecolare. Proprietà fisiche indesiderabili sono la facilità di corrosione dei serbatoi e dei condotti, la facilità di esplosione, l'incendiabilità e la tossicità; proprietà fisiche desiderabili sono, invece, il basso punto di congelamento, che consente di operare a basse temperature, l'alto peso specifico, che permette di ridurre il volume dei serbatoi, la stabilità, la facilità di pompaggio (bassa tensione di vapore e viscosità), ecc.

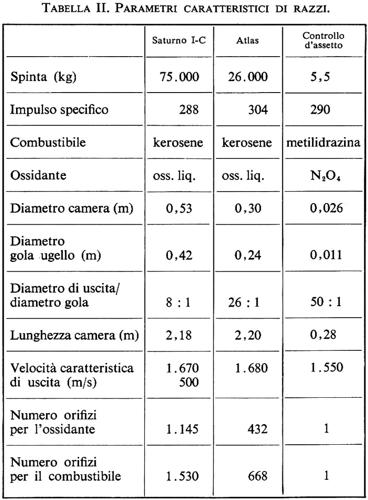

La tab. II mostra, a titolo di confronto, alcuni parametri caratteristici del primo stadio del razzo Saturno, impiegato per il progetto Apollo, del secondo stadio dell'Atlas e di un piccolo razzo per il controllo d'assetto.

Assai importanti sono i sistemi di controllo della variazione della direzione di spinta.

In un motore a solido, il propellente viene inserito direttamente nella camera di combustione con un anticipo anche di alcuni anni rispetto al momento d'impiego. Lo schema di un motore del genere è indicato nella fig. 7. Elementi fondamentali sono l'involucro, il sistema di isolamento termico interno, la protezione termica esterna, il ‛grano' di propellente, il diaframma di arresto della combustione, l'accenditore.

Il motore a solido è quindi assai più semplice di quello a liquido, per l'assenza di serbatoi, pompe, condotti; d'altra parte, presenta minore flessibilità riguardo alla spinta, difficoltà di riaccensione e spegnimento e formidabili problemi tecnologici e costruttivi, derivanti dalle condizioni termiche del motore.

I propellenti solidi si classificano essenzialmente in propellenti a doppia base, costituiti da un grano omogeneo, in cui un unica sostanza contiene, intimamente associati, combustibile e ossidante (le proprietà esplosive della miscela rendono questi propellenti assai pericolosi) e propellenti compositi, in cui i cristalli di ossidante e il combustibile sono mescolati e tenuti assieme da un legante (binder) formato da una matrice plastica sintetica.

Di importanza fondamentale, per i propellenti solidi, è la velocità di combustione, dipendente naturalmente dal propellente e influenzata da vari fattori (v. Sutton e Ross, 1976).

La configurazione del grano regola la variazione temporale di spinta. Talvolta, a causa della variazione della superficie di combustione che regredisce secondo la propria normale, il prodotto della superficie per la velocità caratteristica può andare soggetto ad aumenti o diminuzioni non desiderati. Combinando alcuni tipi fondamentali di profili, si giunge a sezioni di varia forma, alcune delle quali sono indicate nella fig. 8. Vi è anche la possibilità di combustione in senso assiale (‛a sigaretta') e di combustione radiale combinata con combustione assiale.

L'involucro del motore è soggetto a elevate sollecitazioni, derivanti sia dai fenomeni di combustione che avvengono all'interno, sia dalle stesse accelerazioni cui è soggetto il veicolo. Si hanno quindi sforzi di compressione, flessione, taglio, ecc., accompagnati da riscaldamento (sia cinetico che derivante dal calore di combustione), oltre a fenomeni di corrosione e a quelli dovuti alle speciali condizioni operative dell'ambiente aerospaziale. Queste circostanze hanno condotto alla ricerca di tipi strutturali più avanzati. Tra questi vanno citati i moderni tipi di strutture filamentari costituiti da una matrice plastica contenente all'interno dei filamenti di vetro, che hanno una resistenza alla trazione dell'ordine di grandezza dei migliori materiali metallici. Si stanno ora sviluppando materiali compositi filamentari a fibre metalliche.

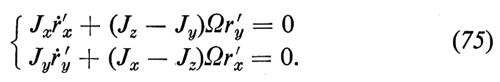

c) Dinamica del missile

Interesse fondamentale, come è ovvio, riveste lo studio della dinamica propria del razzo. Nella salita verso l'orbita da acquisire vanno distinte le fasi propulse (powered flight) da quelle - di solito assài più brevi - non propulse (coasting flight), che intercorrono tra lo spegnimento di uno stadio e l'accensione del successivo. La scelta della durata e dell'inizio dei periodi di accensione dei singoli stadi dipende dalla soluzione del problema dell'ottimizzazione della traiettoria, che è di estrema importanza per mettere in orbita, a parità di lanciatore, il massimo carico utile. Così pure è di grande importanza il programma di assetto, che corrisponde a stabilire la legge temporale di variazione dei tre angoli di Eulero (o di altri parametri di riferimento) rispetto a una terna inerziale. Tali programmi vanno poi realizzati per mezzo dei sistemi di guida e controllo.

Lo studio analitico della traiettoria del razzo si istituisce tenendo conto del fatto che la massa è fortemente variabile nel tempo (a causa della eiezione dei gas combusti) e che nel novero delle forze esterne vanno incluse la spinta, le forze aerodinamiche (per la parte atmosferica del volo) e il peso. Della prima ha interesse conoscere la variazione nel tempo per i vari stadi; per le seconde vanno forniti i valori dei coefficienti aerodinamici in funzione degli angoli di assetto del missile rispetto al vento relativo (e la situazione può essere tale da richiedere la conoscenza ditali coefficienti anche per incidenze dell'ordine di 90°, come avviene per gli effetti del vento trasversale) e, per il peso e altre forze (di scarsa importanza nelle fasi di volo propulso), bisogna stabilire l'inclinazione dell'asse, fornita appunto dal programma di volo. Inoltre è necessario tener conto di fattori ambientali, come la variazione della densità atmosferica con la quota (e, per gli strati più alti, anche con la stagione, l'ora di lancio, la latitudine) e la variazione del campo gravitazionale terrestre, anch'essa con la quota, oltre che con la latitudine e la longitudine. Tutti questi dati ambientali sono quindi oggetto di continue revisioni e aggiornamenti, conseguenti a misure sempre più raffinate.

Il problema principale della dinamica del missile non è però, come già si è detto, quello di determinare il moto del missile soggetto a forze note, ma quello di determinare il programma di guida e di propulsione, applicando le accennate tecniche di ottimizzazione al quadro analitico e meccanico sopra descritto. Nonostante la complessità del problema, appositi programmi di calcolo da tempo collaudati consentono una soluzione sicura. Comunque, rispetto alla traiettoria ‛nominale' determinata, è necessario valutare le conseguenze delle dispersioni, ossia l'effetto che possono avere, sulla traiettoria ‛effettiva', cause accidentali, come ad esempio funzionamenti non corretti dei propulsori, percentuale di incombusti nei propellenti solidi, cattivo funzionamento dei controlli, ecc. Tali dispersioni sono di importanza fondamentale non solo per il successo della missione, ma anche per motivi di sicurezza, essendo in ogni caso necessaria una valutazione dei cerchi di ricaduta dei singoli stadi. La fig. 9 mostra schematicamente la traiettoria di un missile tristadio, con l'indicazione delle curve di ricaduta degli stadi combusti e degli scudi termici. I tondini al piede di ognuna di tali curve corrispondono ai cerchi di dispersione sopra citati.

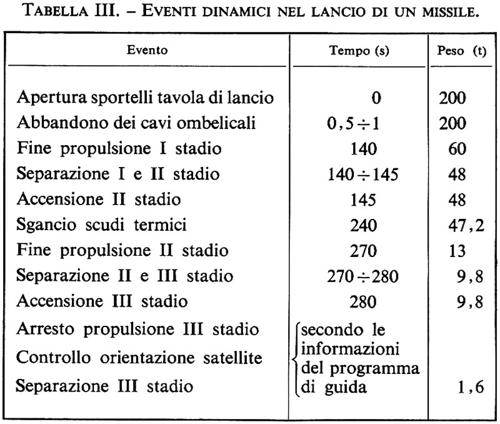

La tab. III riporta, a titolo indicativo, la sequenza dei singoli eventi dinamici e i tempi in cui tali eventi si verificano; nell'ultima colonna si forniscono, sempre in forma estremamente indicativa, i pesi residui dopo la combustione e lo sganciamento dei singoli stadi. Si rileva così la forte variabilità della massa nel tempo.

I risultati dello studio della dinamica di un missile sono di solito riassunti in un grafico del tipo di quello indicato nella fig. 10, che fornisce i valori del carico utile, U, da porre in orbita, in funzione dell'altezza, A, dell'apogeo: ciascuna curva corrisponde ovviamente a un valore dell'altezza del perigeo (curve P1, P2, P3). Le curve si arrestano naturalmente sulla curva, Γ, luogo dei punti in cui le due quote coincidono (a sinistra di essa, perigeo e apogeo scambierebbero i loro ruoli). Esiste in realtà, per ogni missile, un'infinità di diagrammi del tipo di quello della fig. 10, ciascuno corrispondente a una direzione di lancio e quindi a un'utilizzazione diversa della componente della velocità di rotazione terrestre. Tale componente è massima nei lanci verso est, ciò che ne spiega la grande diffusione; per lanci verso nord la riduzione del carico utile è dell'ordine del 15%.

L'attuale tendenza a inviare satelliti applicativi (per telecomunicazioni, previsioni meteorologiche, rilevazioni di risorse terrestri; v. cap. 4, È g) su orbita equatoriale rende necessaria una correzione di rotta in senso azimutale, per mezzo di una complessa manovra che prende il nome di doglegging, ossia ‛a zampa di cane', dalla forma della proiezione della traiettoria del missile (v. fig. 11); questa manovra complicata, difficile e dispendiosa si evita effettuando il lancio da un poligono equatoriale, che deve, per motivi di sicurezza, avere un ampio spazio libero (di mare o di deserto) verso est. L'Italia è stata in questo campo all'avanguardia, avendo realizzato il primo poligono equatoriale (base su piattaforma al largo delle coste del Kenya) nel corso del programma spaziale S. Marco, sin dal 1963. Altri poligoni equatoriali, come quello francese della Guyana, sono stati costruiti in seguito. In ogni caso è necessaria un'opportuna opera di sorveglianza, così come è necessario avvisare gli abitanti, ed eventualmente i mezzi navali, delle zone interessate dalla ricaduta degli stadi. Ciò fa comprendere l'importanza della suddetta analisi delle dispersioni e, insieme, l'impossibilità di utilizzare poligoni che a prima vista sembrerebbero adatti.

Il sistema di guida e controllo ha lo scopo di assicurare in volo l'effettiva rispondenza dell'assetto del missile alla legge precalcolata, nei limiti di scarto tollerabili. Il sistema di guida riceve informazioni relative all'assetto, le elabora e fornisce agli organi di controllo gli ordini necessari per ottenere le correzioni desiderate. (Il termine ‛controllo' va qui inteso nel senso anglosassone di ‛comando' e non in quello italiano di ‛verifica').

Altro sistema fondamentale è quello della logica di accensione e di spegnimento degli stadi e di sganciamento degli stadi combusti e degli scudi termici.

In generale, i missili di una certa importanza sono dotati di antenna radar destinata alla localizzazione da terra della posizione effettiva, la cui individuazione serve a verificare la traiettoria e a inviare il comando di distruzione da terra nel caso di deviazione intollerabile e, quindi, di missione fallita e pericolosa per la sicurezza nella regione del poligono. Si ha anche un circuito di distruzione automatico (in caso di funzionamento normale tale circuito riceve dal calcolatore di bordo un segnale di inibizione di distruzione, che viene interrotto, per esempio, nel caso di separazione intempestiva di due stadi). La distruzione si provoca, per esempio, facendo esplodere un proiettile lanciato da un cannoncino all'interno dei serbatoi di propellente (v. Sutton e Ross, 1976).

Si hanno infine circuiti di telemisura destinati a inviare a terra informazioni riguardanti le grandezze meccaniche (accelerazioni) relative al missile e i dati ‛ambientali' (temperatura in camera di combustione, pressione delle pompe di alimentazione, ecc.). Tali informazioni sono di vitale importanza nei voli di prova, ossia nelle fasi di qualificazione del prototipo.

La fig. 12 mostra lo schema strutturale di uno stadio. La parte anteriore, che serve per il collegamento con l'elemento interstadio (o con l'alloggiamento del carico utile, nel caso dell'ultimo stadio), è realizzata di solito in lega leggera con profilati longitudinali di rinforzo, secondo una classica concezione aeronautica (salvo l'assenza delle ordinate trasversali; v. fig. 13). Una struttura analoga separa le strutture dei due serbatoi, in lamiera d'acciaio con rivestimento protettivo interno in alluminio; il serbatoio comprende una parte cilindrica e due fondi ellittici; un elemento a briglia assicura il collegamento dei fondi col corpo cilindrico (a mezzo saldatura) e del serbatoio coi rivestimenti in lamiera rinforzata.

Speciale attenzione va riservata al castello motore, costituito da travi di forza unite al fondo del castello stesso, alle cui estremità sono applicati gli sforzi imponenti trasmessi dai razzi di propulsione. Tali sforzi, indicati con S nella fig. 14, vengono ripartiti sulla lamiera del castello, che è talvolta divisa in due pezzi sovrapposti per facilitare la distribuzione uniforme degli sforzi stessi.

Per un missile hanno grande importanza gli effetti di vibrazione e i conseguenti problemi di stabilità, derivanti dall'accoppiamento delle varie parti del sistema.

Il primo problema da prendere in esame è la ricerca dei modi fondamentali e delle frequenze strutturali proprie. La moderna tecnica degli elementi finiti consente oggi una valutazione assai precisa di tali grandezze; è necessario comunque tener conto, oltre che della flessibilità e della massa strutturale, anche della massa dei propellenti. Tale massa, nel caso di propellenti liquidi, provoca il fenomeno indicato come ‛sciacquio' (sloshing), che introduce modi aggiuntivi e, spesso, pericolosi, perché verificantisi a frequenze piuttosto basse.

Su gran parte dei razzi a liquido sono stati osservati fenomeni di instabilità longitudinale (l'effetto è simile a quello dei cavallini a sussulto delle giostre, o pogo). Si tratta di un classico processo di instabilità che riguarda gli accoppiamenti tra struttura, alimentazione, camera di combustione. Il ciclo si produce quando, per una causa qualunque, si generano vibrazioni longitudinali della struttura, che provocano di conseguenza fluttuazione di pressione nei condotti di alimentazione dei propellenti, con conseguenti fluttuazioni di spinta, che agiscono a loro volta sulla struttura, chiudendo cosi il loop indicato. L'unica causa dissipativa è lo smorzamento strutturale: se questo è insufficiente, nasce il processo instabile. Per controbilanciare questo effetto si usano sistemi a forte capacità che smorzano le oscillazioni nella linea di alimentazione (poga correction devices).

4. La tecnica orbitale

a) Principali fenomeni orbitali

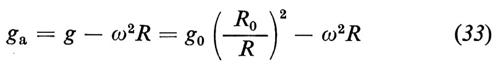

Consideriamo anzitutto il caso di un'orbita circolare: un satellite S di massa m, che si muove intorno al corpo principale T, di massa assai maggiore, su un'orbita circolare di raggio R. L'accelerazione di gravità del campo di T, nel caso di distribuzione simmetrica delle masse di T, vale

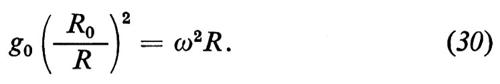

dove g0 è la gravità alla quota di riferimento, R0 (per esempio sulla superficie di T). L'orbita di S è di equilibrio se l'accelerazione centripeta uguaglia la forza d'attrazione divisa per la massa, cioè se

Dalla (30) si ottiene la ben nota legge

ω = (g0/R0)1/2 (R0/R)3/2. (31)

Più esattamente, se in un certo istante S si trova in un punto a distanza R dal centro di T ed è dotato di velocità

v = ωR = (g0R0)1/2 (R0/R)1/2 (32)

puramente normale al raggio TS, allora, in assenza di altre perturbazioni, S continua a muoversi indefinitamente di moto circ'olare uniforme intorno a T con velocità angolare ω data dalla (31). La (31) mette bene in evidenza come a ogni distanza o quota sia associata una velocità angolare, che decresce all'aumentare della quota stessa. Particolare interesse ha, tra le altre, la ‛quota geostazionaria' Rg, ossia quella alla quale ω risulta uguale alla velocità Ω di rotazione di T attorno al proprio asse.

Quando T è la Terra si ha: g0 = 9,79807 ms-2, R0 = 6.378 km e Ω = 2π/86.400 s-1. Si ha perciò

ω = 1,2394 × 10-3 (R0/R)3/2 s-1

v = 7,905 (R0/R)1/2 kms-1

Rg = 42.239 km = 6,622 raggi terrestri.

L'importanza del concetto di quota geostazionaria risiede nel fatto che un satellite ruotante su un'orbita equatoriale, a quella quota, percorre un'orbita ‛geosincrona', ossia tale che il satellite stesso è immobile rispetto alla Terra e sovrasta sempre lo stesso punto dell'equatore. È questa la posizione ideale per i satelliti applicativi, quali, ad esempio, quelli per telecomunicazioni.

Esaminando le cose un po' più in dettaglio, si osservano alcune differenze significative rispetto alla situazione descritta dallo schema semplicissimo fin qui considerato. Anzitutto, poiché il satellite ha dimensioni finite, e non infinitesime, la gravità apparente

risulta nulla solo per un particolare valore R* di R, ossia per quello che soddisfa la (30). In altre parole, poiché ciascun elemento del corpo ha dal centro di T una diversa distanza R, su ciascun elemento agisce un diverso valore della gravità apparente: per gli elementi che soddisfano la (30) la gravità apparente è nulla, mentre per tutti gli altri ga è piccolissima, ma non nulla.

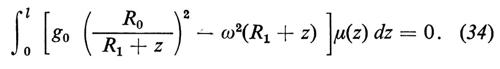

Esaminiamo ancora le cose seguendo uno schema semplice, ossia considerando un'asta diretta secondo una direzione radiale uscente da T, a distanza R1, di lunghezza l ≪ R1 e di cui μ(z) sia la massa per unità di lunghezza (v. fig. 15). All'equilibrio deve essere nulla la risultante della gravità apparente:

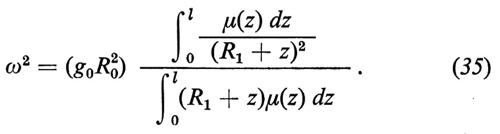

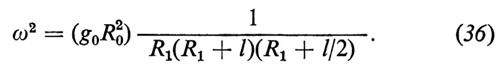

Questa condizione fissa il valore di ω all'equilibrio:

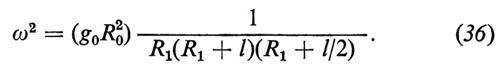

Quando sia l → 0, l'equazione precedente tende alla (30). Considerando, in particolare, il caso μ(z) = cost., ossia il caso di un'asta uniforme, si ha

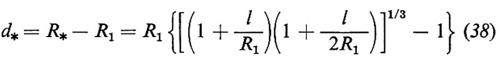

Quindi, il punto P*, in cui la gravità apparente è effettivamente nulla, è quello posto a distanza

dal centro di T e a distanza

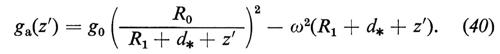

dalla base dell'asta. In ogni altro punto della stessa asta, posto

z′ = z − d* (39)

si ha la gravità apparente

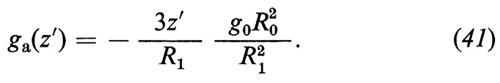

Sviluppando in serie di potenze del rapporto (d* + z′)/R1 e fermandosi al primo ordine, data la piccolezza del rapporto stesso, poiché ga(0) = 0, si ottiene il risultato finale

Non si ha quindi un completo annullamento della gravità apparente, salvo che per z′ = 0, ma una sua fortissima riduzione (microgravità), legata soprattutto al fattore z′/R1, in quanto l'altro fattore (R0/R1)2 tiene conto della naturale riduzione della gravità con la quota e non è legato al movimento orbitale.

Di grande interesse sono le implicazioni della microgravità, in particolare nell'ambito della scienza dei materiali.

A. Sintesi cristallina. È nota da tempo la grande influenza che la gravità esercita sulla formazione dei cristalli in vicinanza del punto critico, a causa della presenza di fasi diverse e dei fenomeni chimico-fisici che ne conseguono. Si possono ottenere campioni di materiale di estrema purezza, insieme a cristalli di grandi dimensioni, operando in ambiente a microgravità, in cui i fenomeni di contaminazione vengono rallentati. Un esempio è rappresentato dalla produzione di ioduro di mercurio.

B. In certi processi di fusione di materiali ceramici, avvengono fenomeni di reazione con le pareti del crogiuolo, il che rende praticamente impossibile la fusione stessa. Nello spazio, a causa dell'assenza di gravità, si può far fondere il materiale senza ricorrere al crogiuolo, situandolo, per esempio, al centro del veicolo spaziale (v. fig. 16).

C. In condizioni di microgravità è pure possibile la costituzione di leghe formate da coppie, o terne, di sostanze non miscibili sulla Terra a causa della gravità che ne provoca la separazione in strati di peso specifico crescente dall'alto verso il basso.

D. Un aspetto particolarmente interessante dei fenomeni di microgravità si ha in connessione con la presenza di liquidi a bordo del veicolo spaziale. Si consideri un serbatoio, di sezione piccolissima, il cui ‛pelo libero' sia posto a distanza h0 dal punto P* di gravità apparente nulla, di cui abbiamo già indicato con R* la distanza dal centro della Terra (v. fig. 17). Per un elemento di lunghezza dz′, indicando con p la pressione del liquido e con ρ la densità, la ben nota equazione dell'idrostatica si scrive:

Tenendo conto che, nel caso attuale, al posto di g bisogna introdurre ga (v. la 41), si ha, integrando e imponendo la condizione di pelo libero:

Quindi, dovendo essere in ogni caso p > 0, si ha ∣ z′ ∣ > ∣ h0 ∣ ; in altre parole, come indica la fig. 17, se il serbatoio si trova al disotto della quota R*, il ‛fondo' è in basso, altrimenti è in alto. È facile quindi immaginare la grande influenza che fenomeni di questo genere possono avere sugli organismi viventi e sui liquidi in essi contenuti, con importanti riflessi sulle loro funzioni biologiche. Il fenomeno è estremamente complesso e il pelo libero non è, in generale, una superficie piana.

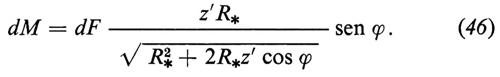

Torniamo ora all'esempio della fig. 15 per esaminare un altro importante effetto che si ha in orbita: la cosiddetta ‛coppia gravitazionale'. Nella fig. 18, l'asta già considerata nella fig. 15 si trova deviata, rispetto alla verticale, di un angolo ϕ, per cui un suo punto generico, posto a distanza z′ dal baricentro, ha, rispetto a un sistema solidale con la Terra, le coordinate

Pertanto, trascurando quantità dell'ordine di (z′/R*)2, la forza gravitazionale (vera e non apparente) agente sull'elemento di massa dμ che si trova nella posizione z′, ha il valore

Calcolandone il momento rispetto al centro di massa, si trova facilmente

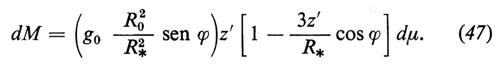

Sviluppando in serie il denominatore dell'espressione precedente e trascurando ancora i termini dell'ordine di (z′/R)2, otteniamo

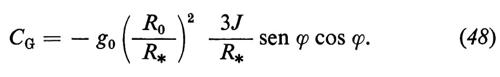

Integriamo rispetto a tutta l'asta, tenendo conto che, avendo contato le z′ a partire dal baricentro, si ha ∫ z′dμ = 0, mentre ∫ z′2dμ è il momento d'inerzia J dell'asta rispetto al suo asse di rotazione; si ha quindi l'espressione finale della coppia gravitazionale:

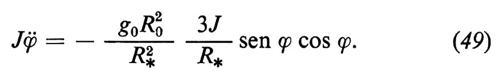

Per ciò che riguarda il contributo dell'altro termine della gravità apparente (ossia la forza centrifuga dovuta al moto dei vari punti dell'asta), è possibile vedere (analiticamente o anche sinteticamente) che esso si compone di due termini, uno derivante dall'accelerazione di trascinamento, l'altro dall'accelerazione di Coriolis. Il momento risultante del primo è evidentemente zero, per motivi di simmetria, mentre, per il secondo, è zero il momento delle singole forze d'inerzia, in quanto la velocità di rotazione è normale al piano, la velocità relativa è normale all'asta e quindi la forza di Coriolis è diretta secondo l'asta. Quindi, nel caso bidimensionale fin qui considerato, il contributo delle forze centrifughe è zero, e l'equazione del moto di rotazione per l'asta si scrive:

Nel caso tridimensionale la situazione è più complicata e si ha anche un contributo delle forze centrifughe. Comunque, osservando l'espressione della CG e ripensando al modo in cui essa è stata ottenuta, se ne capisce l'origine, legata non tanto alla gravità, quanto alla sua variazione spaziale, ossia al suo gradiente. Difatti, dei due termini che figurano nella (47), uno rappresenta la gravità uniforme e non dà quindi evidentemente alcun momento; invece la coppia gravitazionale è legata al secondo termine, che rappresenta appunto il gradiente di gravità. La coppia gravitazionale è generalmente assai piccola: infatti, poiché J è dell'ordine della massa del corpo per il quadrato della dimensione trasversale, la coppia stessa è dell'ordine della dimensione trasversale divisa per R*, ossia dell'ordine di una quantità che abbiamo ripetutamente trascurato in confronto all'unità, ma che nel caso attuale non è più trascurabile, in quanto la coppia del gradiente di gravità è l'unica presente; in altre parole, pur essendo piccolissima, la coppia gravitazionale è l'unica responsabile del movimento di rotazione dell'asta.

Le condizioni di stabilità del sistema soggetto alla coppia gravitazionale si studiano a partire dalla (49). Vi sono due posizioni di equilibrio (corrispondenti all'annullamento della coppia gravitazionale):

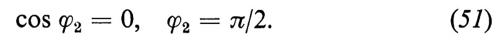

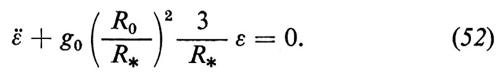

Per esaminare la stabilità, operando alla Lyapunov in vicinanza della prima soluzione, indicato con ε lo scostamento dalla posizione di equilibrio, si ha sen ϕ ≃ ε e cos ϕ ≃ 1 e quindi

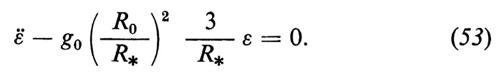

Nel secondo caso si avrebbe cos ϕ ≃ − ε e sen ϕ ≃ 1 e quindi

Pertanto, nella prima posizione il sistema risulta stabile e il movimento è del tipo

ε = A cos ωt + B sen ωt, (54)

con

e A e B costanti da determinare in base alle condizioni iniziali. Nella seconda posizione si ha instabilità.

Al solito, queste conclusioni sono esatte solo nel caso semplificato da noi esaminato, ma servono per mettere in evidenza il ruolo (stabilizzante o destabilizzante) che il gradiente di gravità svolge in condizioni di dinamica orbitale. Questa capacità di stabilizzazione, in opportune condizioni, è utilizzata per certi satelliti speciali.

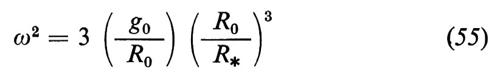

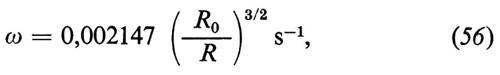

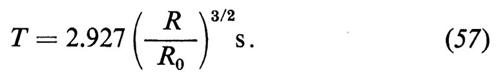

Il valore numerico della costante ω che compare nella (55) è, per la Terra,

cui corrisponde il periodo

b) Previsioni orbitali

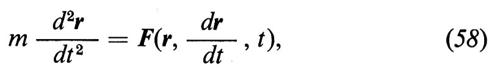

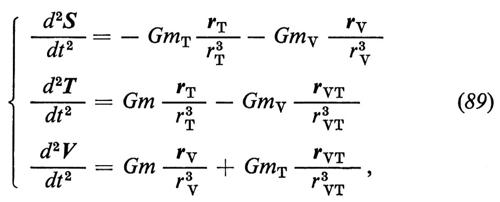

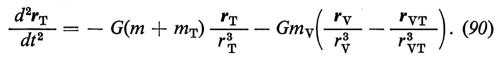

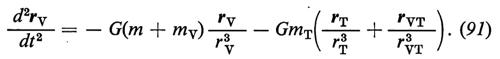

Lo studio della dinamica di un satellite artificiale è semplificato dal fatto che, essendo la massa del satellite S estremamente piccola rispetto a quella della Terra, il moto di quest'ultima non ne è influenzato (problema ristretto dei due corpi). Si indichi allora con r(t) la posizione di 5 rispetto a una terna inerziale ???OUT-t??? con origine nel centro O della Terra T. L'equazione del moto del satellite è

dove m è la massa di 5 ed F è la forza esterna cui esso è soggetto. La (58) va completata con i valori iniziali di r e di dr/dt. Una forma alternativa della (58) si ha considerando il vettore a sei componenti

e l'altro y (pure a sei componenti), che ha le prime tre componenti pari alle componenti della velocità sui tre assi coordinati, uscenti da un punto generico, e le altre tre pari a quelle di F/m. Con tali notazioni la (58) si scrive

La (58a) va completata mediante il valore iniziale di s. La (58a) è la versione della (58) scritta in forma normale, ossia ridotta a equazioni del primo ordine.

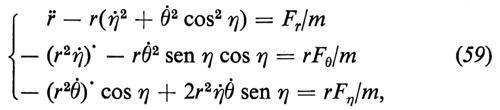

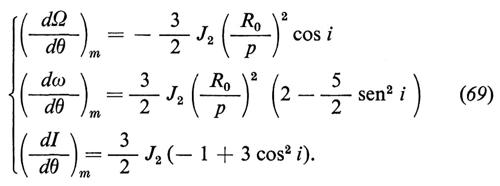

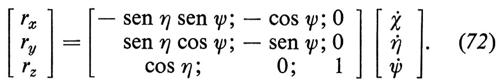

La (58) fornisce tre equazioni scalari del secondo ordine, quando venga proiettata sul sistema inerziale di riferimento. Ad esempio, se il sistema è quello geocentrico (v. fig. 19), si hanno le

cui vanno associati, naturalmente, i valori iniziali di r, η, θ e delle rispettive derivate temporali.

Considerazioni analoghe Possono svolgersi per il caso di un sistema trirettangolo cartesiano.

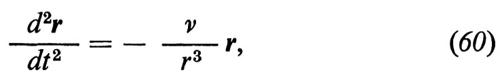

Il caso kepleriano si ha quando la forza F è puramente radiale e ha valore −mν/r2, per cui la (58) si scrive:

dove ν è la costante gravitazionale. Nel caso della Terra, si ha ν = g0R²0 = 3,986 × 105 km3 s-2. Questa condizione corrisponde, come è ben noto, al caso in cui la forza d'attrazione sia esercitata da un corpo a simmetria sferica, anche se non uniforme.

La soluzione del problema del moto in questo caso è ben nota (v. cap. 5, § a). L'orbita risulta essere una conica, che, in questa sede, supporremo essere senz'altro una ellisse ξ. Essa è individuata da sei parametri, equivalenti alle sei condizioni iniziali da associare alla (60).

Due parametri definiscono il piano orbitale π0: l'inclinazione i di π0 rispetto al piano equatoriale terrestre πe e l'angolo Ω che la retta ON, intersezione di π0 con πe (orientata verso il punto in cui il satellite artificiale è ascendente), o ‛retta dei nodi', forma con una direzione fissa di riferimento (per es., l'equinozio vernale medio E) (v. fig. 20).

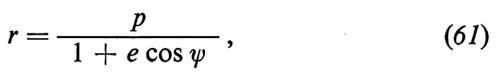

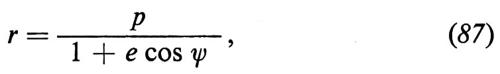

Tre altri parametri definiscono ξ nel suo piano. L'equazione della conica è

dove e è l'eccentricità di ξ, p il semilatus rectum (v. fig. 21) e ψ è contata nel piano della conica a partire dal perigeo P. P è il punto in cui la distanza r assume il valore minimo

mentre il valore massimo si ha all'apogeo A:

Infine il semiasse maggiore dell'ellisse vale a = (rP + rA)/2, cioè

Per fissare poi la conica nel suo piano è necessario anche fornire la posizione angolare ω del perigeo (argomento del perigeo) rispetto a una direzione assegnata, per esempio la linea nodale. I parametri p, e, ω, 0 equivalenti, definiscono la conica nel suo piano. Il sesto parametro è temporale e definisce l'istante di passaggio del satellite artificiale al suo perigeo.

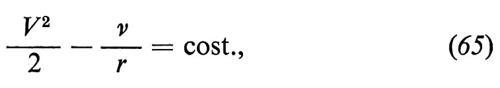

Nell'ottica kepleriana si hanno anche importanti relazioni di carattere generale. Si ha anzitutto l'integrale delle forze vive

che è ottenibile dalla (60) moltiplicando ambedue i membri scalarmente per dr; d'altronde, l'integrale delle forze vive sussiste, come è ben noto, per ogni sistema (o punto) materiale meccanico soggetto a forze conservative, come è appunto la forza newtoniana gravitazionale, alla quale corrisponde il potenziale ν/r.

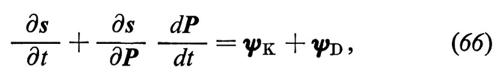

Lo schema kepleriano viene notevolmente complicato dalla presenza di forze diverse dalla semplice forza newtoniana che interviene nella (60); lo studio delle perturbazioni relative è di solito condotto descrivendo ciascuna ditali forze mediante un apposito modello matematico, introducendo tale modello nella (58) e procedendo all'integrazione numerica del sistema differenziale così ottenuto. È questo il modo effettivamente seguito nella costruzione delle ‛effemeridi' del satellite, che sono di grande importanza per la previsione dell'orbita. Assai seguito è il metodo dei parametri, ben noto da tempo agli studiosi di meccanica celeste e rielaborato negli ultimi anni per tener conto di perturbazioni speciali, come la resistenza aerodinamica. Dal punto di vista analitico, la traiettoria effettiva è concepita come una successione di archi infinitesimi di ellissi kepleriane, a parametri variabili istante per istante. Detto quindi P(t) il vettore dei sei parametri suddetti, le relazioni della conica istantanea si scrivono s = s(P(t), t), e sono di carattere puramente geometrico e cinematico. Inoltre il vettore y può decomporsi nel termine kepleriano (che sarebbe più esatto definire newtoniano) yK e in quello di disturbo yD. Sostituendo nella (58a), si ha

dove ∂s/∂P è una matrice il cui elemento ij vale ∂si/∂Pj. Nell'equazione precedente il termine ∂s/∂t è formalmente quello che si ha nel caso kepleriano, ossia quando il vettore P è costante. Pertanto il termine in parola è identico a ψK e si ha

In questo modo le incognite del problema non sono più le coordinate s(t), ma i parametri istantanei della conica P(t). Rispetto all'impostazione col metodo delle coordinate, il sistema differenziale (67) ha il vantaggio di operare con quantità assai più lentamente variabili: basti pensare che nel caso kepleriano la (67) assume l'aspetto semplicissimo P• = 0.

Le forze perturbatrici sono in genere assai piccole in confronto alla forza newtoniana; tuttavia esse hanno grande importanza, poiché sono le uniche responsabili, come si è visto, delle variazioni dei parametri e, quindi, del tipo di orbita. Pertanto la ricerca di metodi numerici destinati a studiarne gli effetti è stata ed è tuttora in pieno sviluppo.

In sede preliminare, in luogo dell'integrazione diretta della (58) o delle (66), si preferisce ricorrere a formulette semplici, che danno valori approssimati, e, in generale, sufficienti ai fini pratici, degli effetti in questione.

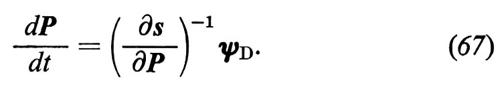

Campo gravitazionale. - Il potenziale del campo gravitazionale terrestre si scrive:

Nella (68), il primo termine è quello newtoniano, gli altri sono le armoniche superiori. In essi R0 è il raggio equatoriale terrestre, η è la latitudine, θ la longitudine, Pk(j) la funzione associata di Legendre di prima specie, di ordine j e di grado k, Pk è il k-esimo polinomio di Legendre. Far partire la prima sommatoria da 2 corrisponde a prendere come origine il baricentro terrestre; la seconda sommatoria tiene conto della ‛ellitticità' dell'equatore. I coefficienti Jk, Ck(j) Sk(j) sono stati dedotti dall'analisi delle anomalie delle orbite dei satelliti artificiali, fino a circa una quarantina di valori.

Il coefficiente J2 = 1,087 × 10-3 è noto con buona approssimazione: il termine ad esso relativo corrisponde all'effetto dello schiacciamento (oblateness) della Terra.

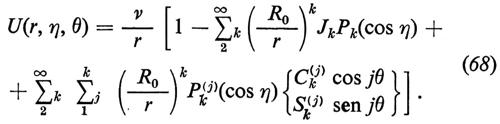

Si hanno variazioni nell'argomento del perigeo, nella longitudine del nodo ascendente, nel tempo di passaggio al perigeo, che è conveniente scrivere sotto forma di medie durante un'orbita:

Per esempio, con i = 0 e con un'orbita circolare di 500 km di quota, si avrebbe (dΩ/dθ)m = − 0,00138, corrispondente a circa 0,5° per orbita; poiché si avrebbero circa 15,2 orbite al giorno, il movimento retrogrado del nodo sarebbe di circa 7,6°, un valore, come si vede, assai importante. Per ω lo spostamento, questa volta in avanti, sarebbe doppio e la somma algebrica dei due (valida, naturalmente, solo nel caso di un'orbita equatoriale) corrisponderebbe a un movimento complessivo in avanti del perigeo pari a ≃ 7,6°. Si noti che dω/dθ è negativo per i compreso tra −63,4° e 63,4° (naturalmente per i 〈 0 l'orbita è retrograda). Analogo effetto si ha su dI/dθ per i ≤ 54,7°.

Alle perturbazioni secolari si sovrappongono anche perturbazioni a carattere periodico da tempo note e studiate: le più importanti sono quelle derivanti dagli effetti a lungo periodo, dell'ordine di grandezza della precessione del perigeo o di suoi multipli; tuttavia, nei satelliti stazionari, che debbono assolutamente mantenere invariata la posizione sul punto scelto dell'equatore, anche gli effetti a corto periodo possono essere importanti.

A queste perturbazioni contribuiscono anche le armoniche superiori del campo gravitazionale: tale è, per esempio, il caso della terza armonica, J3 = (− 2,3 ± 0,2) × 10-6, che deriva dall'asimmetria delle masse terrestri rispetto all'equatore (pear-shape effect o ‛effetto della forma a pera'); essa non contribuisce al moto secolare del nodo ascendente e del perigeo, ma induce movimenti periodici che hanno il periodo del moto del perigeo. La quarta armonica, J4, produce lo stesso effetto, oltre a fornire un contributo di natura secolare, che però è piccolo in confronto a quello prodotto da J2. Per le altre armoniche il discorso diventa assai difficile in termini di effetti parziali; peraltro la considerazione completa delle armoniche gravitazionali fa parte dei comuni softwares applicativi.

Attrazione dei corpi celesti. - Un tipo di perturbazione nasce dalla circostanza che il satellite è sottoposto, da parte dei corpi celesti, a forze di attrazione diverse da quelle cui sarebbe sottoposto se fosse situato al centro della Terra: non è tanto quindi la forza in se stessa quello che conta, quanto la differenza tra quella cui è sottoposto il satellite e quella cui è sottoposta la Terra. Questo fatto, collegato con il fatto che, come indica la (68), l'effetto delle armoniche superiori diminuisce con l'altezza orbitale (legata al raggio r), fa sì che l'attrazione dei corpi celesti sia una delle maggiori fonti di perturbazione per i satelliti alti (per es. per un satellite sincrono), mentre risulta trascurabile per quelli su orbita bassa.

Resistenza aerodinamica. - Il modello atmosferico a quote superiori ai 200 km è estremamente incerto e dominato da fattori casuali. Vi hanno luogo fenomeni pressoché sconosciuti, che producono variazioni della densità a carattere giornaliero, mensile, semiannuale, annuale, casuale. Un fondamentale contributo alla comprensione di questi fenomeni hanno portato gli esperimenti del satellite italiano San Marco. Comunque non si può parlare con sicurezza di quota alla quale l'effetto della resistenza aerodinamica viene a mancare, ma, piuttosto, di decremento continuo dell'effetto stesso.

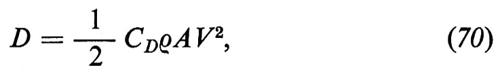

La resistenza aerodinamica è espressa, come sempre, dalla

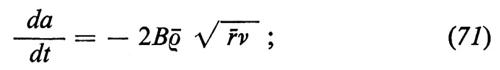

in cui A è l'area di una superficie di riferimento del satellite, V la sua velocità e ρ la densità del mezzo. Il coefficiente di resistenza, CD, dipende fortemente dall'assetto del satellite. L'effetto principale è comunque la contrazione dell'asse maggiore dell'orbita

ρ- è la densità media lungo l'orbita, ò è la media dei raggi orbitali lungo l'orbita stessa e B = CDA/2m è il parametro fondamentale (area/massa) da cui dipende il fenomeno. La contrazione dell'asse maggiore si accompagna a una crescente diminuzione dell'eccentricità (circolarizzazione) dell'orbita, legata alla circostanza che la massima resistenza aerodinamica si ha al perigeo, che è il punto più basso dell'orbita; perciò il satellite, quando lascia la zona intorno al perigeo (v. fig. 22), ha perduto una parte della sua energia cinetica e non può quindi più risalire all'apogeo precedente. All'apogeo, invece, questi fenomeni avvengono con assai minore intensità e, quindi, l'abbassamento del perigeo per orbita è di regola assai inferiore a quello dell'apogeo; naturalmente, l'entità della differenza (o, meglio, del rapporto) dei due abbassamenti dipende dall'eccentricità della conica kepleriana. Comunque, a un certo punto, si giunge al rientro del satellite.

La resistenza aerodinamica provoca una tipica perturbazione ‛secolare', ossia tale che i suoi effetti si sommano nel tempo: quindi, anche se estremamente piccola, essa è responsabile del valore finito del tempo di permanenza in orbita (‛vita orbitale'). Peraltro anche altre perturbazioni possono contribuire a questo effetto; il campo gravitazionale terrestre, per esempio, può spostare il perigeo in zone di maggiore densità e così accelerare, o ritardare, il rientro. Le incertezze su ρ, su CD e sull'assetto rendono assai poco sicura in generale un'analisi di lifetime, che può risultare errata per uno o due ordini di grandezza. Per avere un'idea dell'importanza dell'effetto della resistenza, basti pensare che, nel caso di un'orbita con perigeo a 200 km e apogeo a 500 km, per un satellite di forma sferica di 1 m di diametro e del peso di 200 kg, si avrebbe inizialmente un abbassamento del perigeo di 10 m e dell'apogeo di circa 150 m per orbita; l'abbassamento del perigeo porterebbe rapidamente il satellite in zone a più elevata densità e in circa un mese la velocità di discesa risulterebbe raddoppiata e così via.